大模型带来了人工智能(AI)能力的突破,同时也对算力提出了前所未有的需求。尽管业界长期聚焦于GPU芯片的性能提升,但即便是拥有庞大GPU计算资源的组织,也常面临难以达到算力峰值利用率的挑战。而这其中的关键在于存储系统。

9月25日,MLCommons发布了最新的MLPerf™ Storage v1.0 AI存储基准测试结果,再次表明了:存储系统在 AI 模型训练中发挥着至关重要的作用。

MLPerf Storage 全球首个且唯一的 AI/ML 存储基准测试

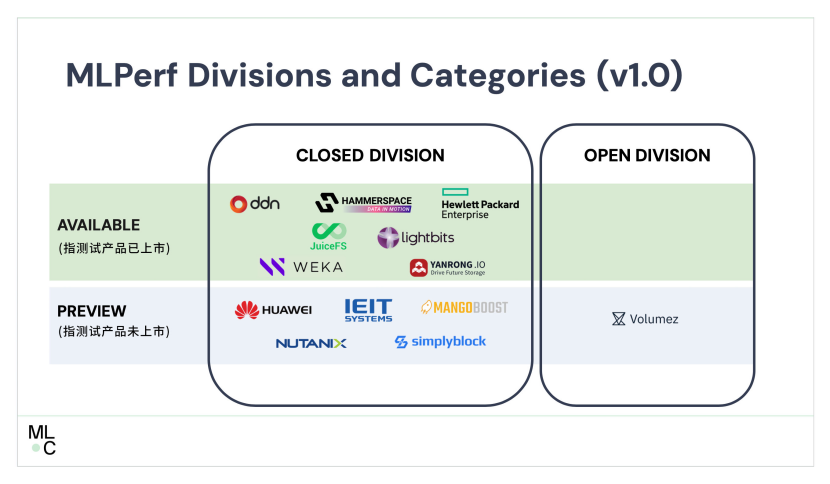

MLPerf™ 是业内影响力最广泛的国际AI性能基准评测,由图灵奖得主大卫·帕特森(David Patterson)联合谷歌、斯坦福大学、哈佛大学等顶尖学术机构共同发起,被誉为全球 AI 领域的“奥运会”。MLCommons 在 2023 年首次推出了 MLPerf 存储基准测试(MLPerf Storage Benchmark)。这是首个也是目前唯一一个开源、公开透明的 AI/ML 基准测试,为 ML/AI 模型开发者选择存储解决方案提供了权威的参考依据,帮助他们评估合适的存储产品。

最新MLPerf Storage v1.0 基准测试的结果表明,存储系统在 AI 模型训练中发挥着至关重要的作用。对于高性能AI训练,尤其是大规模语言模型(LLMs)的训练而言,存储系统不仅需具备高度可扩展性,还必须拥有高速数据传输能力。一旦数据访问成为瓶颈,整个系统的性能都将受到限制。一项研究表明,在扩展AI模型的过程中,数据管理(35%)所带来的技术挑战相较于计算能力(26%)更为突出。这通常源于组织内部陈旧的数据架构及I/O能力的不足。

随着GPU等加速器技术的快速发展,以及数据集规模的持续增长,存储解决方案必须紧跟计算需求的步伐,同步进化。确保GPU的最佳利用率,至为关键的一项因素在于最大化数据吞吐量,这不仅能加速模型训练进程,还能提升模型精度,并降低运营成本。

MLPerf Storage v1.0基准测试正是针对AI领域设计的,旨在评估AI/ML复杂工作负载下的存储系统性能。它提供了一种有效的手段,用于比较不同供应商在向GPU提供学习数据并保持其利用率维持在一定水平之上的能力。

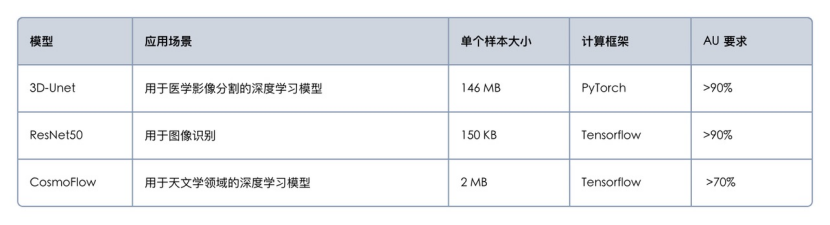

MLPerf Storage 基准测试目前有两个版本:v0.5 和 v1.0。2023 年发布的 v0.5 版本初步包含了 Unet-3D 和 BERT 两个模型,并仅支持模拟 NVIDIA v100 GPU。而今年最新发布的 v1.0 版本进行了重大更新,引入了更具代表性的测试模型,这些模型在业界具有广泛的应用,能够更好地代表实际工作负载。

中国AI存储厂商焱融科技刷新MLPerf Storage记录 斩获多项性能榜首

本次MLPerf Storage测评吸引了全球13家领先存储厂商参与。其中,一家中国存储厂商的表现尤为亮眼。MLPerf测试结果显示,专注于AI和高性能计算场景的存储厂商——焱融科技在带宽、模拟 GPU 数量以及 GPU 利用率等关键性能指标上,获得了多项世界第一。这也展现了中国存储厂商在AI领域的潜力和实力。

据了解,本次焱融科技参与 MLPerf 测试使用了其最新发布的 F9000X 全闪分布式一体机产品。F9000X 每个存储节点搭载最新的英特尔® 至强® 第 5 代可扩展处理器,存储介质采用 10 块 Memblaze PCIE 5.0 NVMe 闪存 ,同时配备 2 块 NVIDIA ConnectX-7 400Gb NDR 网卡。

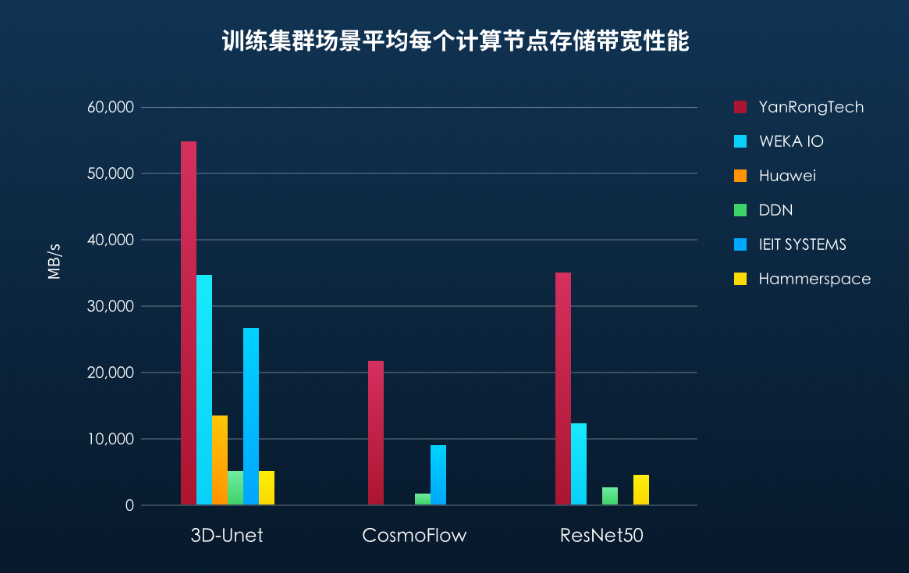

在分布式训练集群场景,平均每个计算节点 ACC 数量最多,存储带宽最高

在本次MLPerf Storage基准测试中,焱融科技是国内唯一一家参与了全部模型测试的存储厂商,包括 3D-Unet、CosmoFlow 和 ResNet 50。测试结果显示,在分布式训练集群场景,焱融存储在所有三个模型的测试中,能够支撑的每个计算节点平均 ACC 数量和存储带宽性能均排名第一。

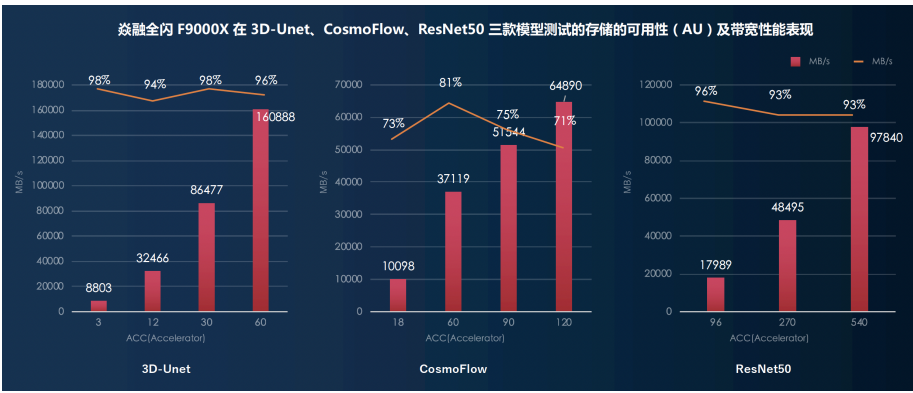

存储性能随计算规模同步线性增长

随着计算规模的扩大,存储性能应实现线性增长以满足 AI 训练的需求。以 3D-Unet 三维图像分割模型为例,其单个图像样本大小约为 146MB,而在多节点集群环境中,每秒处理的训练样本数可超过 1100 个,这导致训练数据的读取带宽需求超过 160GB/s。

在针对三个模型的测试结果显示:随着并发计算节点(ACC)数量的增加,焱融全闪存储一体机 F9000X的带宽性能保持明显的线性增长能力。此外,存储的可用性(AU)也始终保持在测试基准要求的范围内,确保了训练过程的高效和稳定。

[1] MLPerf Storage Benchmark Suite Results:

[2] MLPerf Storage rules:

https://github.com/mlcommons/storage/blob/main/Submission_guidelines.md