芝能智芯出品

芝能智芯出品

人工智能(AI)正在推动数据中心基础设施的转型,以满足日益增长的AI工作负载需求。

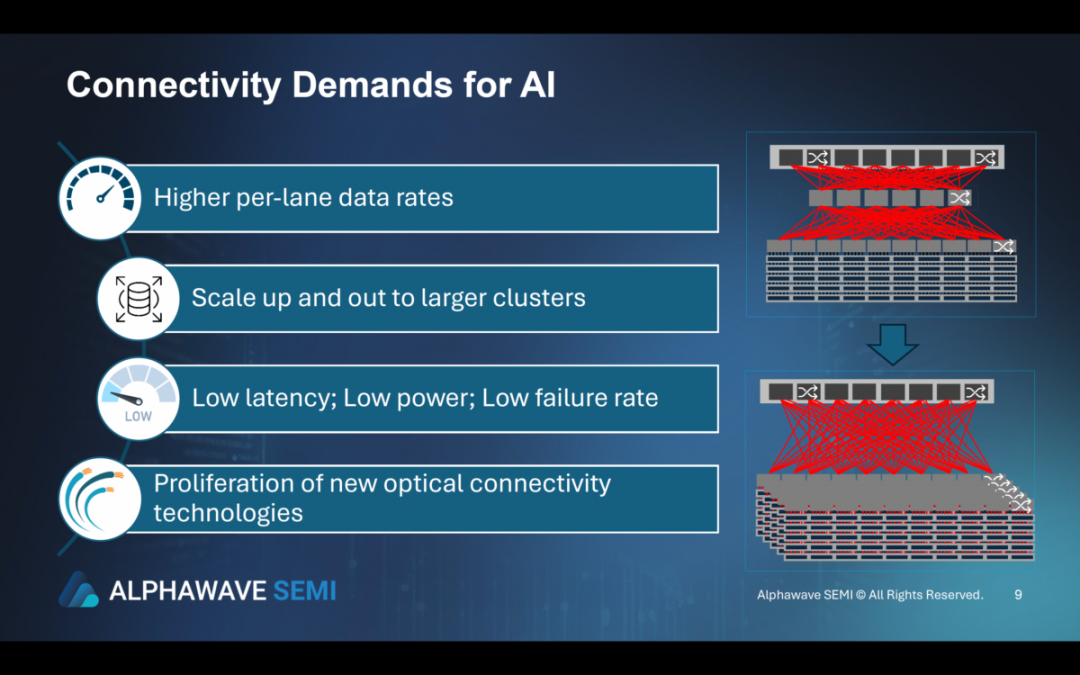

随着AI系统的规模不断扩大,下一代计算服务器、交换机、光电链路以及灵活、冗余的网络解决方案变得至关重要。关键创新,如先进的连接技术、通过Chiplet实现的定制硅片解决方案以及光学连接的普及,正在重新定义AI集群的部署和运营方式。

无论是位于单个数据中心还是分布在多个位置,扩展AI集群都依赖于高性能连接技术。

AI的前端网络(处理数据流)和后端ML网络(处理大规模AI计算)需要低延迟、高速通信。光电链路和灵活、冗余的网络越来越多地支持这一点,确保即使需求增长也能平稳运行。一项关键创新是从基于铜的系统转向先进的光学连接解决方案,如可插拔光学模块和共封装光学器件(CPO)。

这些技术通过减少延迟和增加带宽来提高性能,这对于需要快速数据交换的AI任务至关重要。

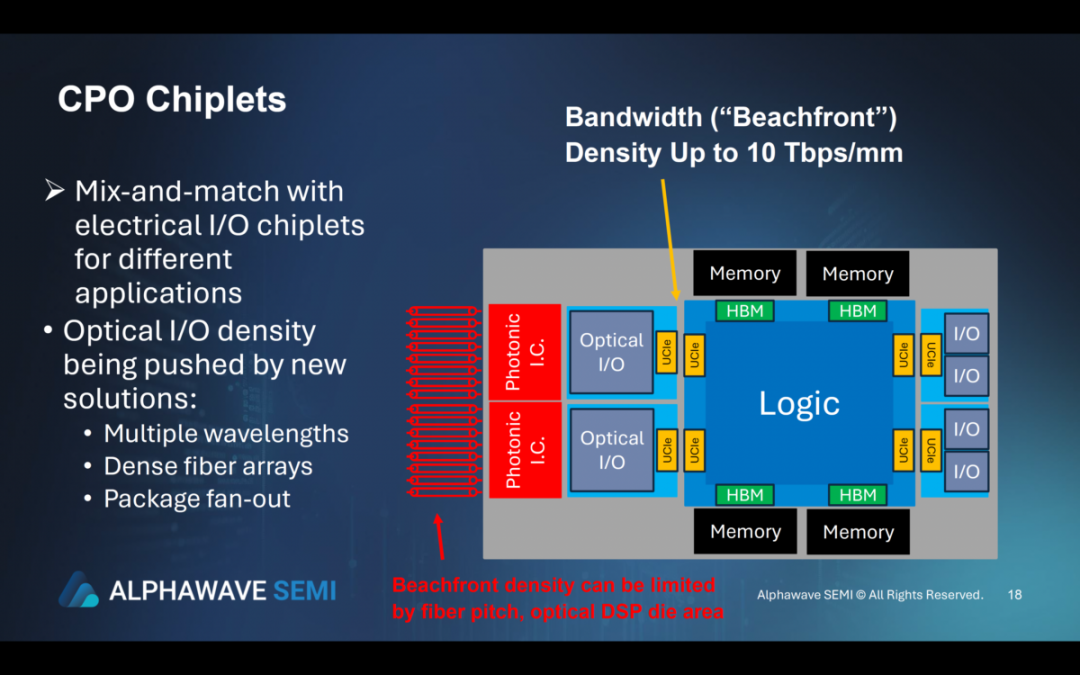

将微型光学引擎直接集成到芯片封装中,用光纤取代电气互连。结合电气I/O芯片,CPO芯片可提供针对不同应用优化的混合搭配解决方案,从而提高AI处理速度和效率。

AI工作负载变得越来越复杂,定制硅片解决方案变得至关重要。Chiplet可实现针对特定AI任务量身定制的专用硬件。

Chiplet基于低成本基板构建,在不牺牲性能的情况下提高了价格承受能力。其灵活的配置可帮助数据中心满足各种计算需求。

芯片生态系统以通用芯片互连(UCIe)等芯片到芯片接口为基础,可实现I/O、计算和内存芯片之间的无缝通信。例如:

● I/O芯片:可能采用多标准SerDes,并配备PCIe Gen6、CXL 3.0或112Gbps以太网控制器。

● 计算芯片:利用基于Arm的内核进行高性能处理。

● 内存扩展芯片:具有低延迟DDR或HBM,确保更快的数据访问,从而进一步提高AI性能。

Chiplet的模块化特性允许以较低的成本实现可扩展的性能。传统的单片芯片开发成本高昂且耗时,但Chiplet具有预先验证的可重复使用组件,可缩短开发时间和生产成本。这对于AI驱动的行业至关重要,因为效率和更快的上市时间至关重要。

Chiplet还有助于管理功耗——随着数据中心规模的扩大,这一点非常重要。芯片间接口的创新解决了与信号和电源完整性相关的挑战,例如串扰和互连损耗。电力输送和封装技术的进步以及时钟解决方案的改进也提高了密集信号布线和时钟/数据对齐的效率。

光学连接技术(尤其是在芯片生态系统中)正在改变AI数据中心格局。CPO和高密度光学I/O解决方案正在突破AI集群功能的界限。通过将光学组件直接集成到芯片设计中,AI系统可以以更低的延迟和更高的能效处理更大的数据量。

密集的光纤阵列和先进的扇出技术

● 光纤阵列:多种波长和先进的扇出技术确保光学I/O能够满足AI日益增长的数据需求。

● 性能提升:这些创新不仅提高了速度,还提高了能源效率,这在耗电巨大的AI领域至关重要。

● 模块化混合光学和电气I/O芯片:可为各种AI应用提供量身定制的解决方案,从大规模训练模型到实时推理。

通过芯片对芯片接口实现的不断扩展的芯片生态系统可实现各种定制AI系统。这包括I/O、计算和内存扩展芯片,每个芯片都针对特定任务进行了优化。

多标准SerDes I/O芯片支持PCIe Gen6和112Gbps以太网等高速协议,而基于Arm的计算芯片则为AI工作负载提供处理能力。内存扩展芯片具有低延迟DDR或HBM,可确保AI模型快速访问数据。

● UCIe:管理串扰和补偿互连损耗,实现信号完整性。

● 电源完整性和封装技术:进一步确保AI系统的可扩展性和可靠性。

连接技术、芯片架构以及光学和电气解决方案生态系统正在推动人工智能数据中心的未来。从先进的光电链路和共封装光学器件到可定制的芯片设计,人工智能基础设施正在建立在可扩展、灵活且高效的解决方案之上。

这些创新使AI集群能够在性能和地理分布方面实现扩展,从而使数据中心能够满足AI不断增长的计算需求,同时控制成本和能耗。