直播报名(今晚19:30)-国产高速时域仪器技术讲解

近期,美国麻省理工学院研究科学家、初创公司 BitEnergy AI 创始人罗鸿胤和合作者提出了一种名为线性复杂度乘法(L-Mul,linear-complexity multiplication)的算法,可以将 AI 应用的能源需求减少 95% 。

仅举一个例子,ChatGPT 现在每天需要大约 564 MWh(56.4万度),足以为 18,000 个美国家庭供电。随着科学的不断进步和此类应用变得越来越流行,批评者认为 AI 应用可能在短短几年内每年使用约 100 TWh(1亿MWh),与比特币挖矿操作相当。

在这项新工作中,BitEnergy AI 的团队声称他们已经找到了一种方法,可以大幅减少运行 AI 应用所需的计算量,而不会导致性能降低。

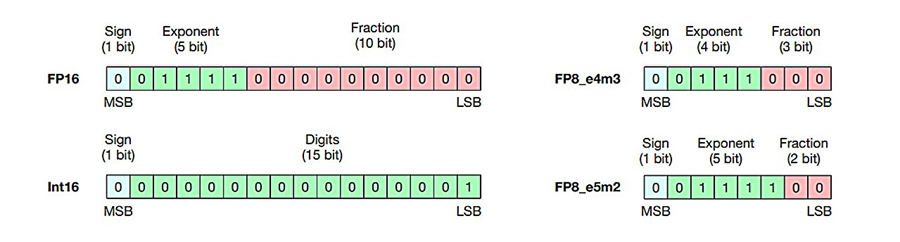

这种新技术相对简单——它不再使用复杂的浮点乘法(FPM),而是使用整数加法。应用程序通常使用 FPM 来处理非常大或非常小的数字,允许应用程序以极高的精度进行计算。然而,FPM 也是 AI 计算中最耗能的部分。

IEEE 754 中定义的 16 位、8 位浮点数以及用于张量计算的各种硬件,以及 16 位整数。

研究人员将他们的新方法称为线性复杂度乘法,它通过使用整数加法来近似 FPM。他们声称,到目前为止,测试表明,新方法减少了 95% 的电力需求。

它有一个缺点是它需要与当前使用的硬件不同的硬件。但研究团队还指出,新型硬件已经设计、构建和测试完毕。

然而,此类硬件的许可方式仍不清楚——目前,GPU 制造商 Nvidia 主导着 AI 硬件市场。Nvidia 对这项新技术的反应可能会对其推广速度产生重大影响,前提是该公司的说法得到验证。

论文作者简介:

罗鸿胤在清华大学获得学士学位,师从刘知远教授和孙茂松教授。2022 年在麻省理工学院电子工程与计算机科学系获得博士学位,研究方向为语言模型的自我训练。毕业后,他留校继续担任博士后和研究员。

此前,他构建了一个参数量仅为 3.5 亿的小模型,该模型完全使用合成数据训练,并在文本分类任务性能方面的表现超过了拥有 1750 亿参数量级的 GPT-3[2]。之后,他致力于将这种效率提升方法转移到生成模型。

图丨罗鸿胤(来源:罗鸿胤)

目前,罗鸿胤主要聚焦于提高 AI 的效率和推理能力两个方向。

在效率方面,他特别关注将大模型的建模粒度从向量深入到比特层面,通过模型架构与计算架构的协同设计提升 AI 效率;在推理能力方面,他关注模型的编程能力和容错能力。

罗鸿胤表示:“编程可以让模型通过复用推理过程提升效率,而容错能力则使得模型能够一次性输出,减少重复推理的次数,从而节省计算资源。”

在未来的阶段,他计划在可编程阵列逻辑(FPGA,Field Programmable Gate Array)平台进行仿真研究,对数值计算变化后能耗的具体降低程度进行确认,以提供准确的数据支持。

“我们的长期目标是希望通过数值计算研究,解决大模型的各种特性和目前面临的相关挑战,从而促进大模型效率的指数级提高。”罗鸿胤说道。

(适用于:高速互联、高速芯片、数据中心、高速背板、光模块、光通信)