Mobileye 可以算是中外新势力智能驾驶的启蒙老师。

特斯拉第一代智能驾驶使用Mobileye芯片和视觉算法,在 2015款Model S 车型中实现L2+级别的Autopilot;中国新势力蔚来小鹏第一代L2+ 智能驾驶NIO Pilot 和 Xpilot以及第一代L2++ 领航辅助NOP和NGP都是依赖 Mobileye 芯片和视觉算法方案。而现在,特斯拉走上了硬件和算法自研的端到端,中国新势力高阶智能驾驶都拥抱英伟达了,就连与Mobileye走的最近的吉利极氪也拥抱英伟达了,都在追逐着算力为王的端到端大模型。

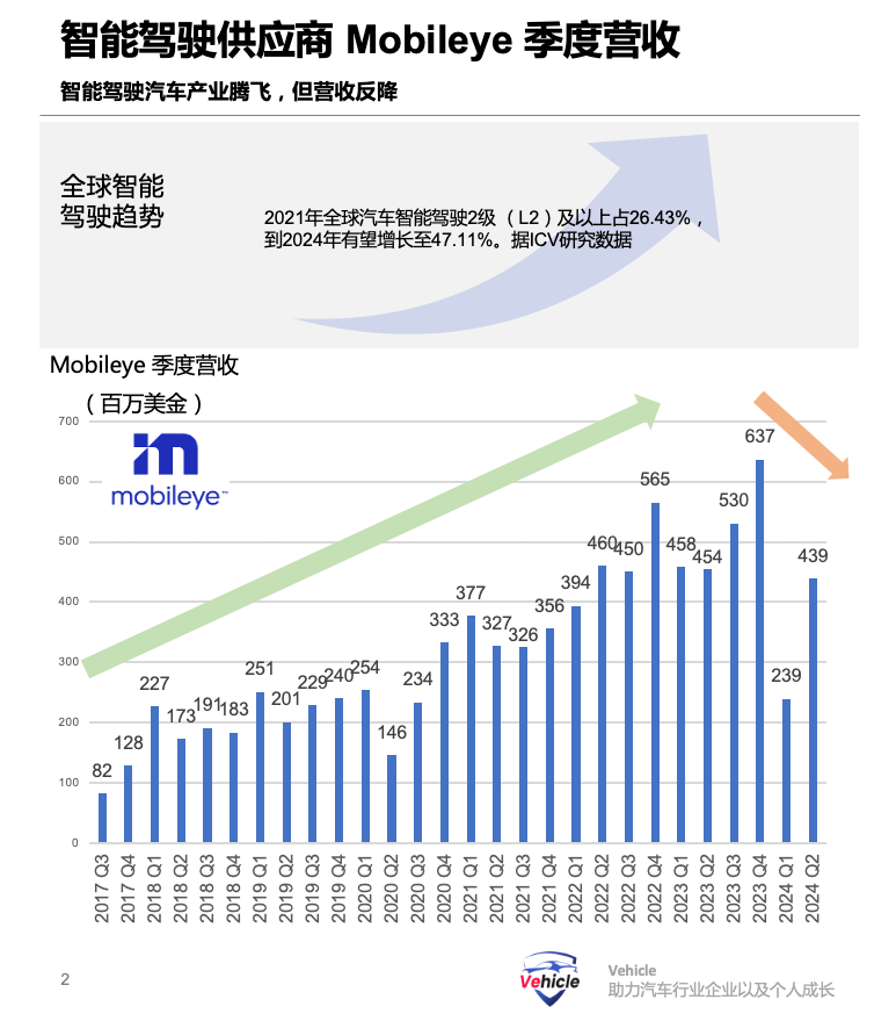

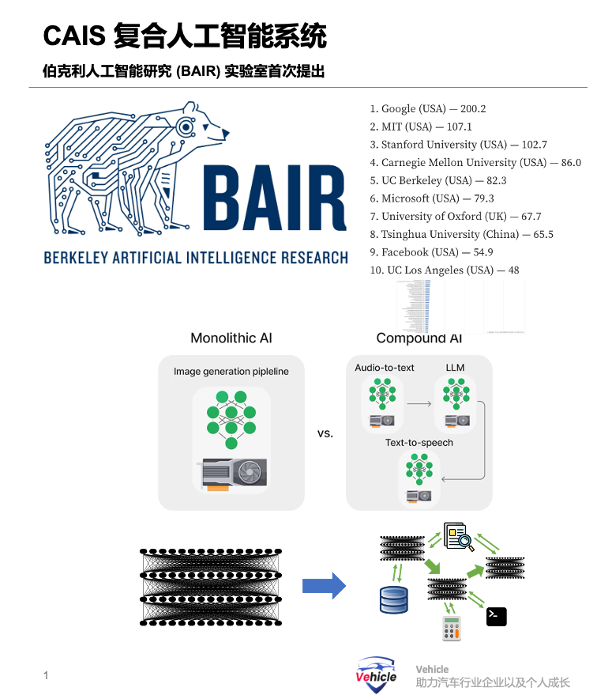

可以看到 Mobileye的季度财报,2024年已经跌回几年前的水平,但此刻的智能驾驶已成为AI人工智能落地最大的产业之一,在全球却是如火如荼的发展。最近 Mobileye 在其 Driving AI 2024发布会上祭出其Compound AI Systems(CAIS)大旗,挑战大算力下的端到端大模型智能驾驶。CAIS 是今年年初全球人工智能前五的学术研究机构 -- 伯克利人工智能研究 (BAIR) 实验室首次提出的“复合人工智能系统”这一术语,但其实CAIS在人工智能领域应用广泛,也在蓬勃发展。所以本文基于发布会信息整理,结合AI相关知识对Mobileye 的 Compound AI Systems (CAIS )复合人工智能方案进行分享。希望给大家带来一些信息,最后欢迎投票留言讨论Mobileye 这个方案是否能够奏效?对于智能驾驶应用的终极未来形态 Mobileye 表示想要打造一个真正的自动驾驶,它的指标是MTBF(Mean time between failures平均故障间隔时间,也就是多久出现一次故障 )。 Mobileye表示其与汽车制造商的合作中,MTBF 目标是 10的7次方小时的驾驶时间。对于公司来讲,需要一个可持续的商业模式,确保达到目标同时实现公司的盈利。

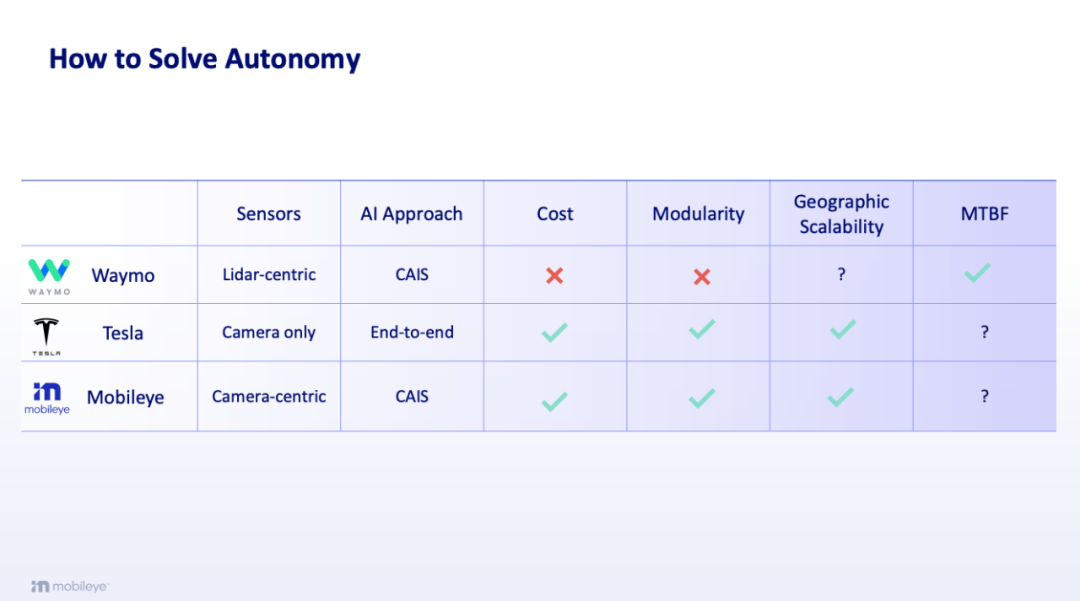

所以 Mobileye 将自己的方案和谷歌Waymo以及特斯拉放一起比较:其中谷歌和Mobileye采用CAIS方案,区别是谷歌主要依赖激光雷达,Mobileye主要依赖摄像头,Waymo已经证明了实现了满足MTBF KPI的自动驾驶,但是成本和模块化不行,地区泛化能力有待验证。

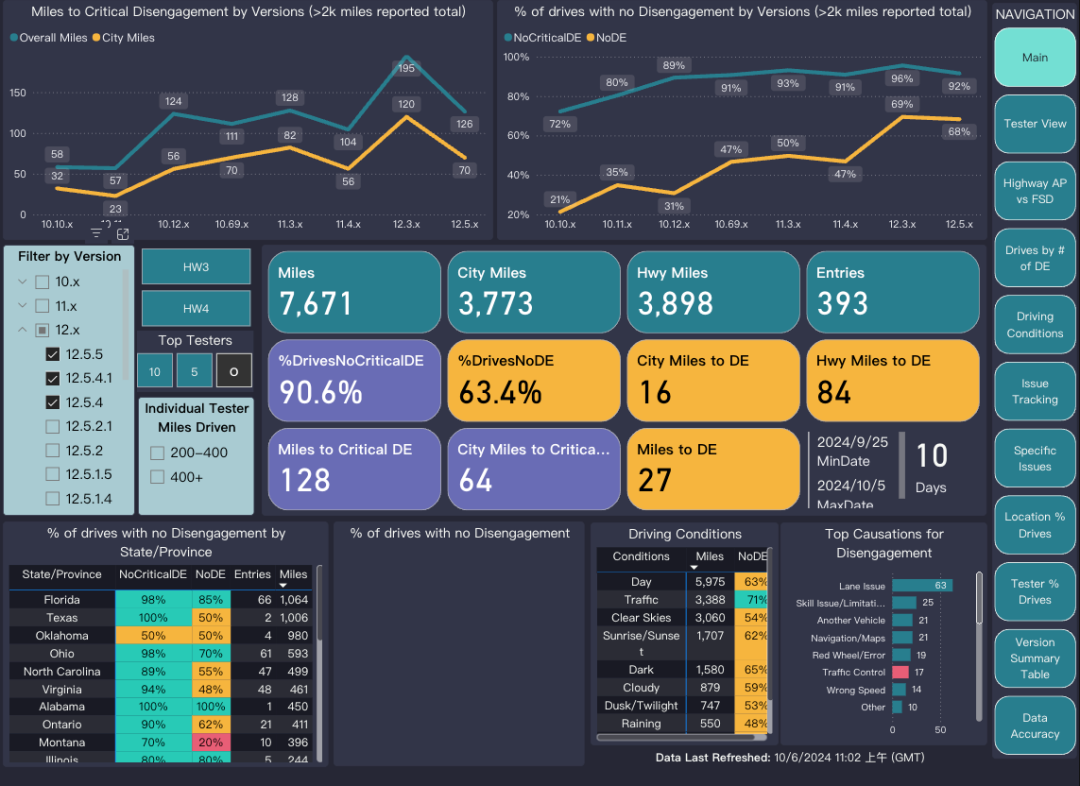

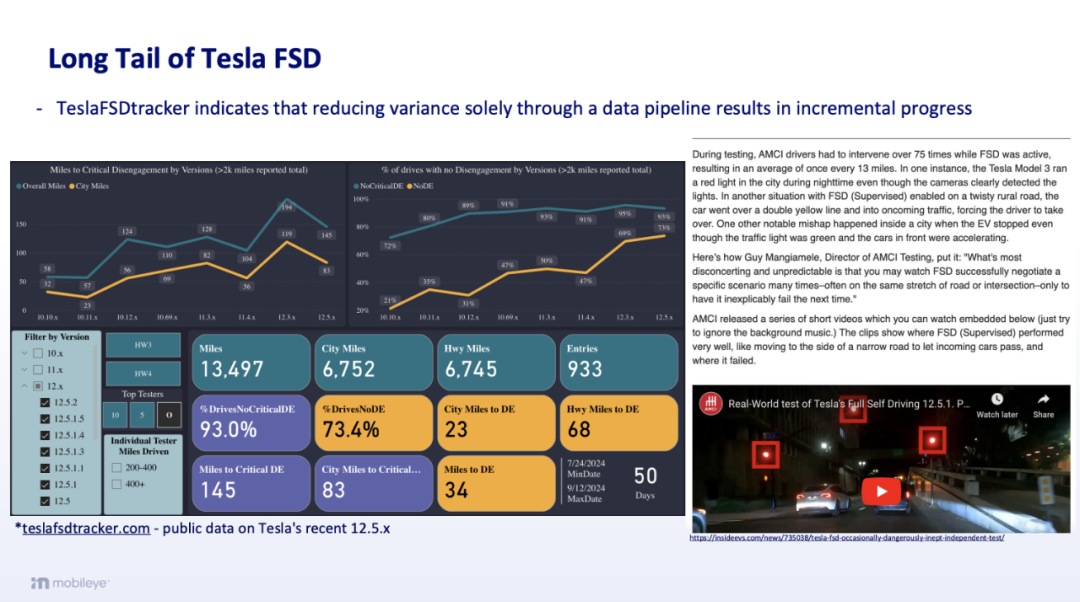

而特斯拉的端到端纯视觉方案,从成本,模块化,地区泛化能力都非常优秀。但是满足自动驾驶MTBF KPI却是一个大大的问号,特斯拉最近的 V12版 FSD 的公开数据显示每次关键干预大约行驶 300 英里,相当于 MTBF 大约为 10 小时,与目标 MTBF 相差 6 个数量级。

所以 Mobileye 表示他对于FSD以及自己方案能否实现MTBF都打上问号,当然其实Mobileye潜台词是自己的L2以及以下的系列能够实现MTBF,所以暗示其 CAIS 能够实现。其实现有L2以及以下系列它的ODD 也就是可用范围太小了,特斯拉FSD以及中国新势力的L2++范围就异常巨大,基本上等同于全部了。按照 Mobileye 的思路,他的 CAIS 现有产品与 Tesla 的端到端方案的FSD进行对比MTBF其实不公平。

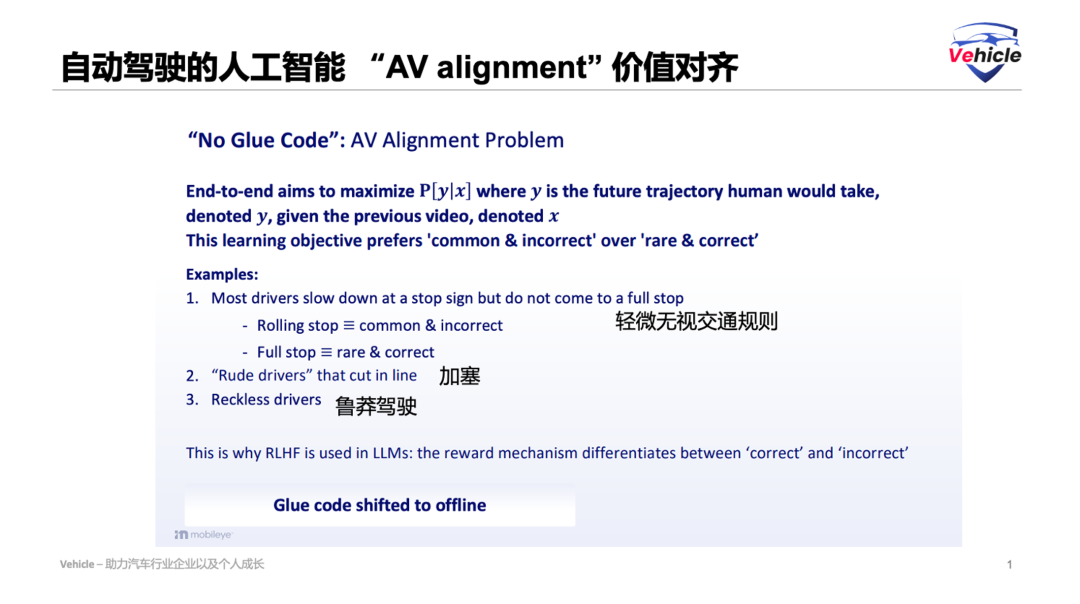

端到端大模型方案,数据的输入到一个大模型算法然后输出最终结果,对于自动驾驶基本就是从图像的光子到汽车的控制。前提是,没有任何Glue code也就是,在计算机编程中,粘合代码是一种允许组件互操作的代码,在智能驾驶中你可以理解为没有人类规则的代码来影响输入与输出。仅凭无监督,不需要标注的数据训练就可以实现足够的MTBF。现实是,端到端是将Glue code转变到线下,需要人类来挑选高质量正确的数据用于训练。如果没有的话会学习很多常见但错误的行为,却没有学习到正确但稀少的行为。更可能引发人工智能 “AV alignment” 价值对齐的问题。端到端大模型的输出结论很可能不真实,例如以下三个方面:

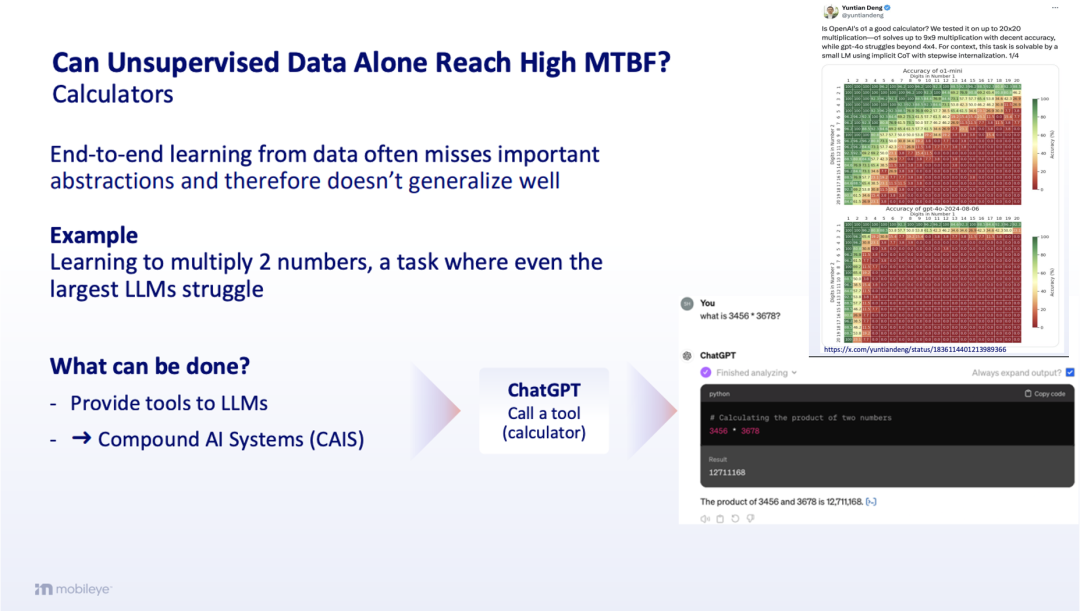

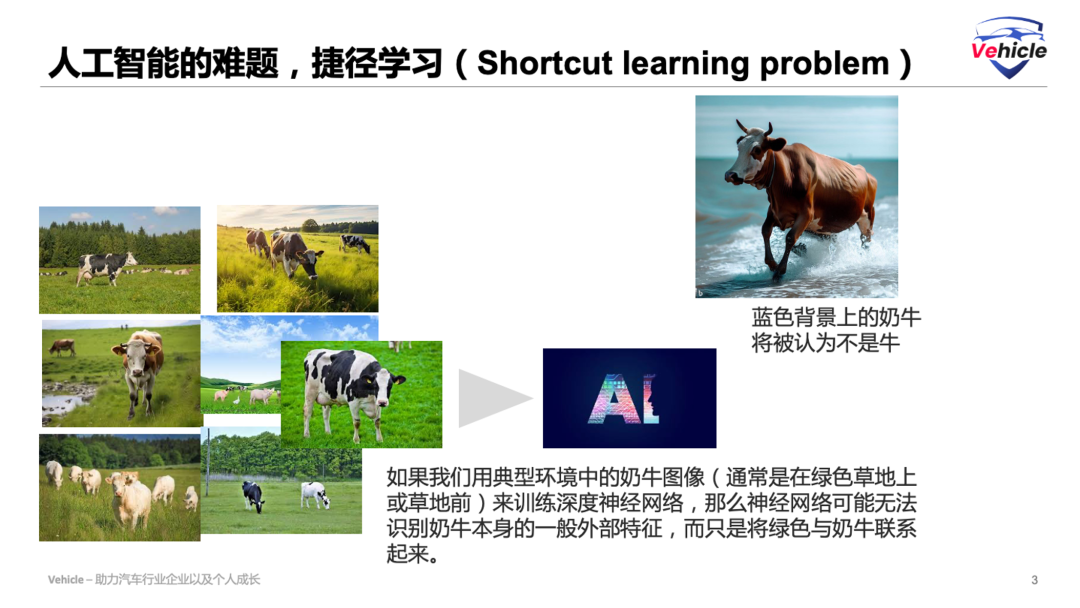

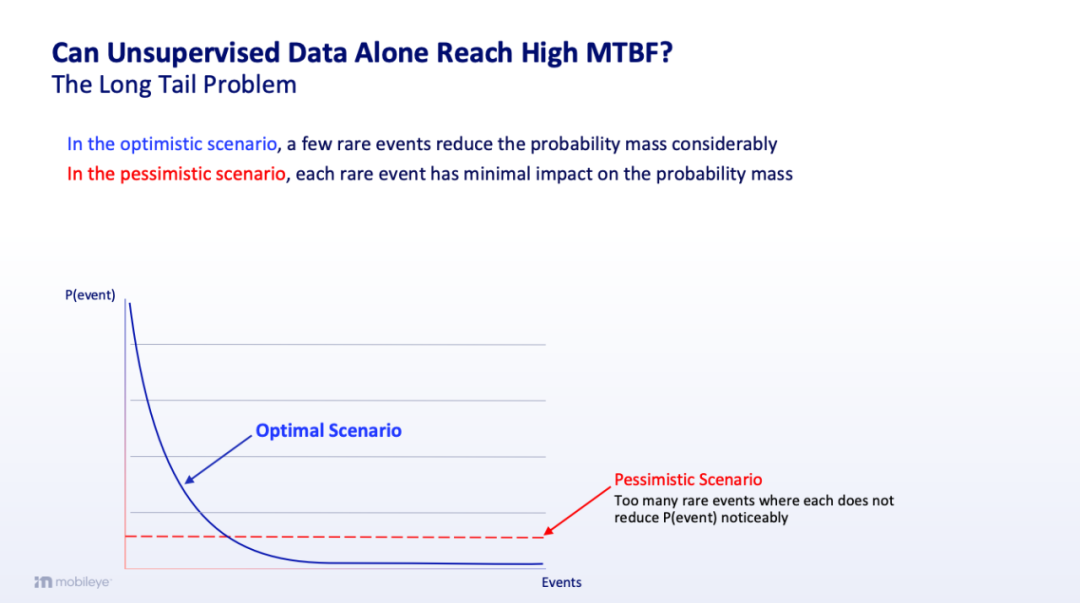

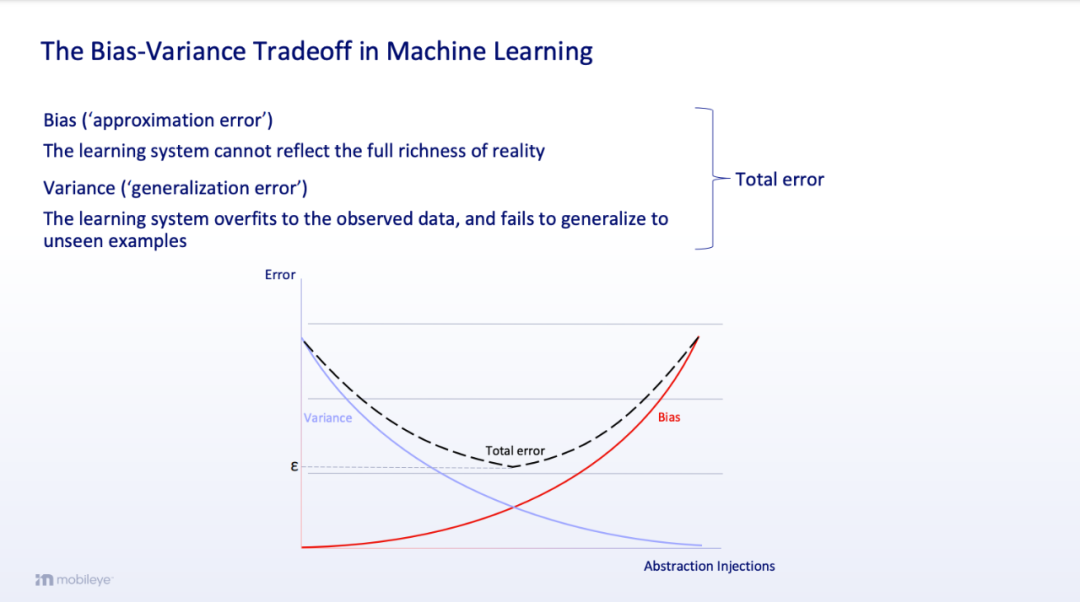

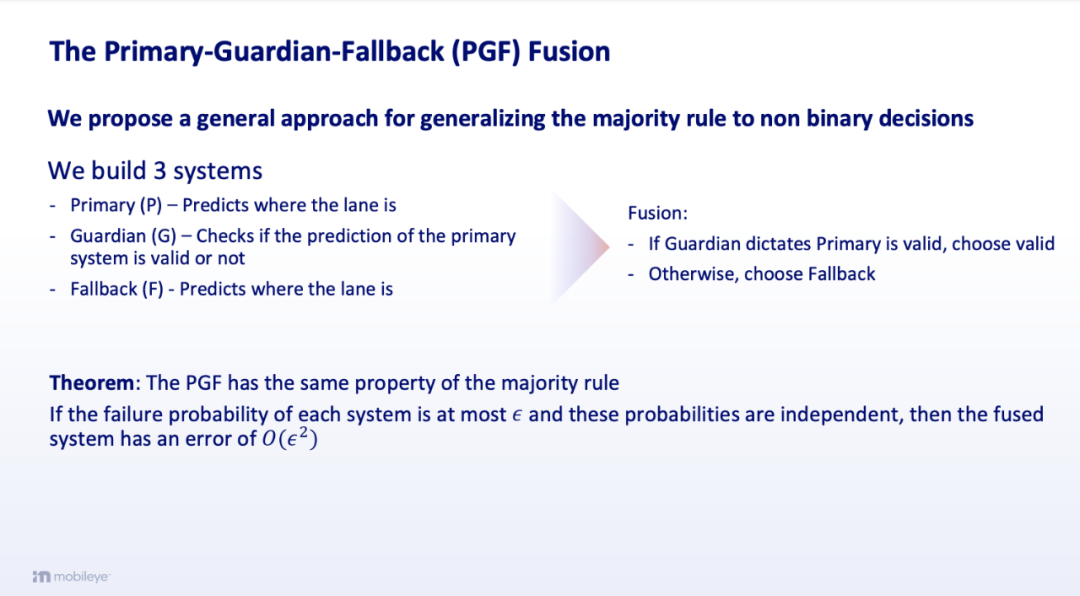

Calculator计算器 - LLM大语言模型并不是计算专家,人类通过句子学习语言和概念,大多数情况下,语义理解都可以通过这种方式很好地建立起来。但数学的运作方式并不完全相同。数学或算术在语言中并不是高度编码的。基于大语言模型的端到端,从数据中进行端到端学习往往会遗漏重要的抽象概念,因此不能很好地概括和提取结论。所以,目前大模型ChatGPT也采用CAIS进行调用计算器等专门模型和工具。那 Calculator 和自动驾驶什么关系呢?自动驾驶中所有的碰撞安全都需要计算距离,时间等来实现避障。人工智能的难题,捷径学习(Shortcut learning problem)。捷径是在标准基准上表现良好但无法转移到更具挑战性的测试条件(例如现实世界场景)的决策规则。打个比方如果我们用典型环境中的奶牛图像(通常是在绿色草地上或草地前)来训练深度神经网络,那么神经网络可能无法识别奶牛本身的一般外部特征,而只是将绿色与奶牛联系起来。如果基于这种神经网络的图像识别软件面对蓝色背景上的奶牛,那么它很可能不会将其识别为奶牛。相反,绿色壁纸前的猫可能会被错误地识别为奶牛。因此,AI 走了捷径。它没有真正开发出识别图像的能力,而只是根据训练数据中存在的相关性学习了错误的因果关系。对于自动驾驶端到端算法如何保证端到端大模型没有进行捷径学习是个难题。即使摄像头,雷达,激光雷达多传感器融合,也就是现在讲的前融合,当不同的输入模态具有不同的样本复杂度时,端到端随机梯度在利用所有模式的优势方面存在困难,会导致计算时间过长。而 CAIS 可以按每种传感器对系统进行可分解训练,然后进行高级融合,应该就是现在讲的后融合,Mobileye 分享到其 Primary-Guardian-Fallback (PGF)融合方式。长尾问题,对于长尾问题有两种假设,在乐观的情况下,就是类似于长尾有些事情概率相对较大,有些非常小,在悲观的情况下,所有罕见的长尾问题其实概率都一样非常小。其实具体怎么样谁也不知道,但这个问题会影响自动驾驶对于长尾问题解决的思路。其实,特斯拉FSD V12已经是端到端大模型,按照逻辑大模型积累数据越多那么越好,但是根据Teslafsdtracker的数据可以看到,特斯拉的V12之后的版本并没有体现这个观点。所以,端到端大模型这种,只需要喂足够的数据那么算法软件就会越来越优秀的观点缺少证据。首先,Mobileye摆出了机器学习中需要考虑 Bias 偏差和 Variance 方差的妥协。Bias 偏差(“近似误差”),由于学习到太多的约束,导致存在约束的盲区,学习系统无法反映现实的全部丰富性,这个可以理解为懂得越多其实yVariance 方差(“泛化误差”),由于学习以及训练的数据较少,就直接根据现有数据总结,学习系统对观察到的数据过度拟合,无法泛化到看不见的例子。Mobileye 想要表达的是,Mobileye 的方案将会采取合适的数据训练,而不是多多益善。

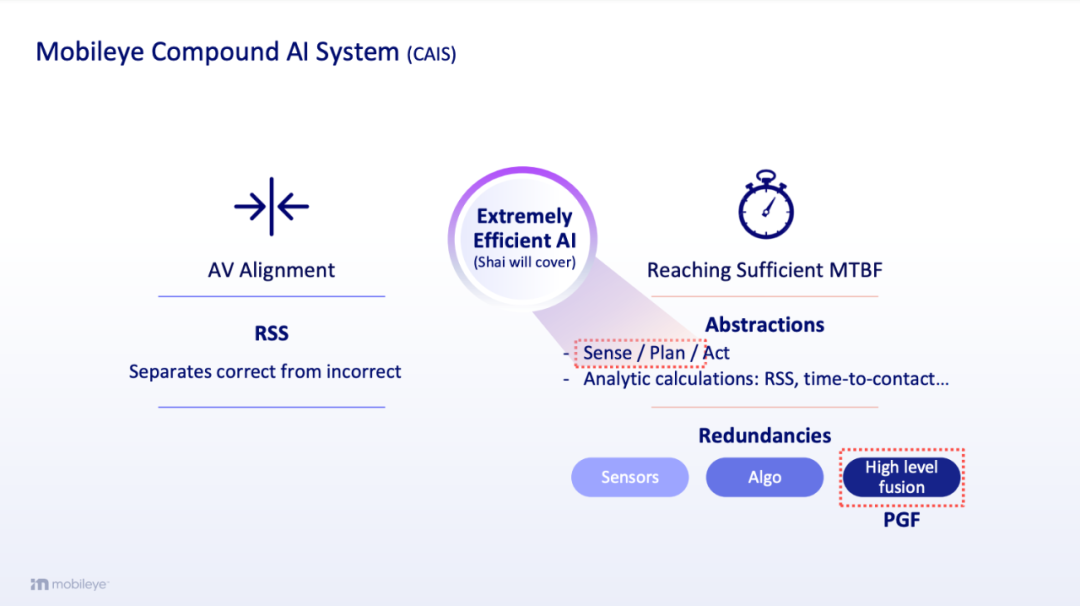

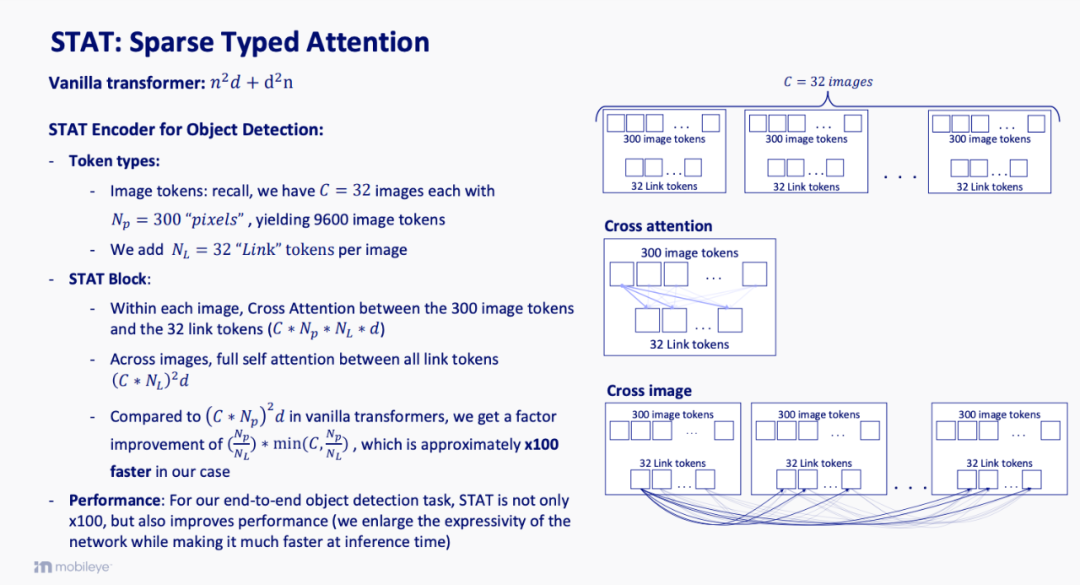

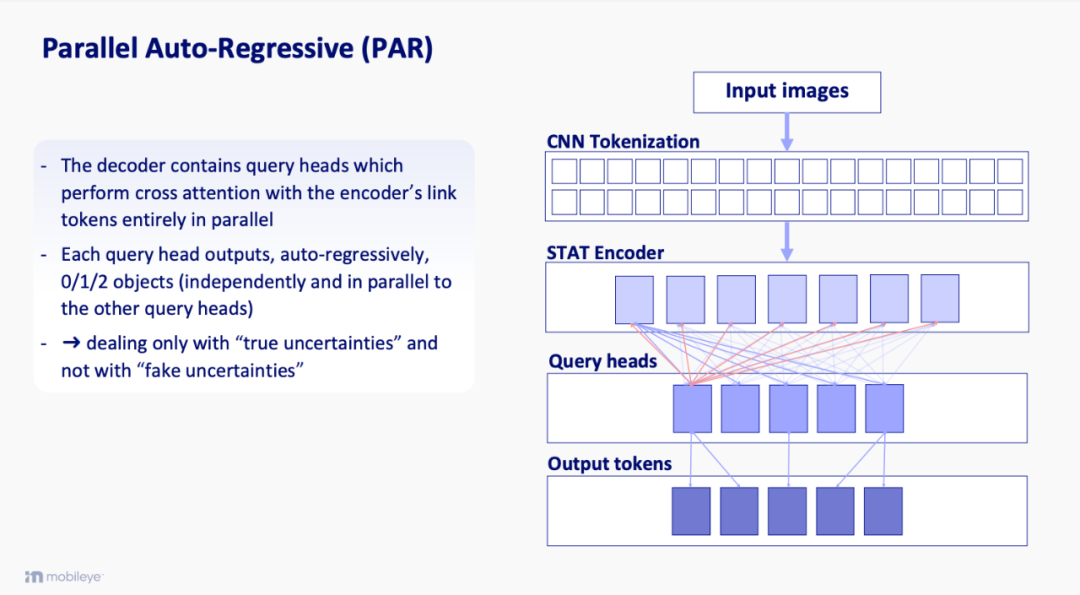

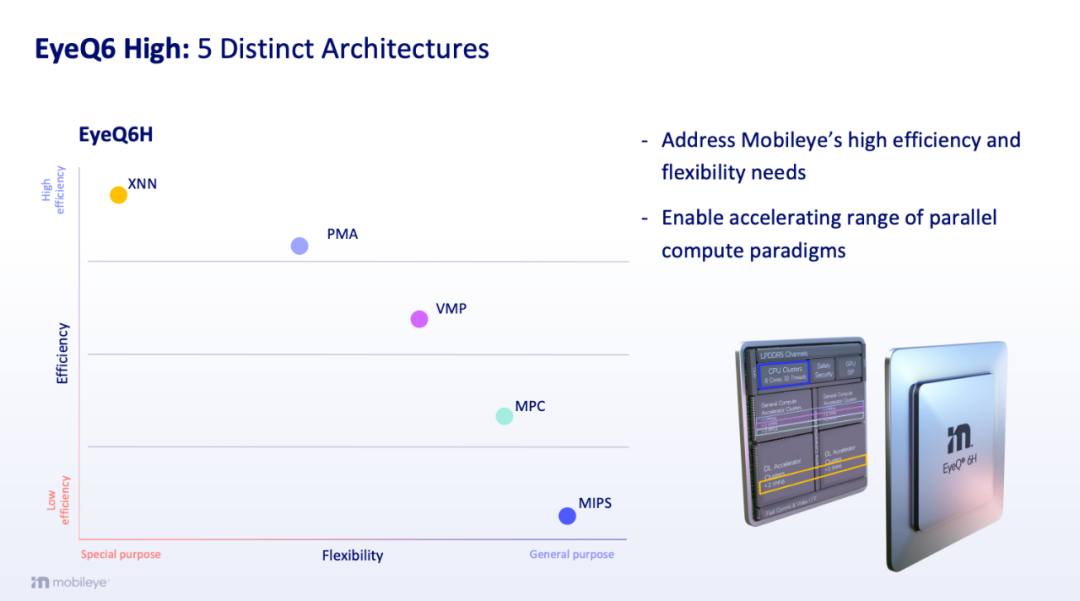

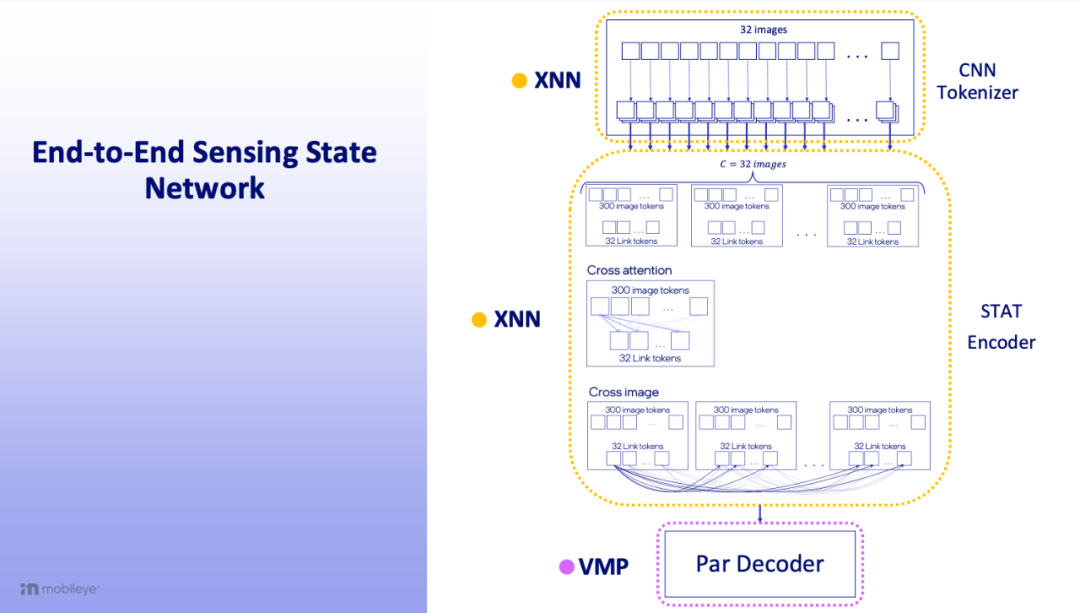

所以Mobileye 给出的 CAIS 方案主要包括:RSS 是我们之前文章《从2022 CES 看Mobileye 自动驾驶产品技术以及战略(谁说算力是唯一标准)》中讲到的“Responsibility-Sensitive Safety” (RSS) 模型,它可以通过设立人为的准则来解决人工智能“AV alignment” 价值对齐的问题。感知/规控/执行,分析计算等抽象层;从感知,算法,融合多方面冗余来确保实现MTBF。其中感知和规控将采用 Mobileye 极致高效的AI算法和硬件芯片;冗余方面将采用 Mobileye 的 PGF 高阶融合。Mobileye 的 PGF 高阶融合是一种将多数规则推广到非二元决策的一般方法,用于冗余传感器和外部输入分析之后的信息决策,传统冗余信息的决策机制是少数服从多数。对于感知和规控 Mobileye 宣称其采用极致高效的AI 算法。基于Transformer 的GPT最开始主要来自于人类语言文字的算法,它可以标记 Tokenize 所有的东西,然后利用自动回归生成新的东西,例如在语言中它标记所有的单词,采用自动回归 Auto-regressive 预测下一个单词的出现概率,再预测下一个单词出现的概率,最后生成句子或者文字内容。目前 Transformers 的类似算法已经在 AI 领域确立了王者地位,感知以及环境输入信息被Tokenized,然后Auto-regressive 生产新的数字信息用于计算和决策,甚至输出。所以端到端的方案中,只需要有足够的数据,和强大的算力,基本上都能产生贴近真实答案的token算法组合,差别只是token多与少的问题,也就决定算法复杂和需要算力的多少。在汽车AI领域里面应用广泛的语音和图视频AI,和上面讲到的语音机制一样类似,所以 Mobileye 的自动驾驶算法也一样采用,不过 Mobileye 表示其优化或者灵活的运用,对传统 Transformer 应用改良的 STAT: Sparse Typed Attention。目前行业内包括特斯拉的端到端,第一步是用CNN对每画幅的图片进行处理创立整个算法的Backbone,整个算法都基于CNN特征进行传递处理。Mobileye 发现这样的算法需要非常大的算法和算力,例如目前800万的摄像头,按照7个摄像头用作周视,另外目前通用对摄像头采样是1秒钟采样10次,然后将这些图片切割成20*15个像素进行boken编码,按照Mobileye 的算法这就需要 100Tops,配合大流量数据输入与输出。所以Mobileye 对传统 Transformer 应用改良的 STAT: Sparse Typed Attention。主要就是对token进行分类,类似于公司组织一样分部门和科室。Mobileye 采用Parallel Auto-Regressive (PAR)的方式,原来transformer下的tokend 是人人平权,大家都互相交流沟通,现在token分类,只允许同类的领导之间进行交流和沟通产生结论,所以mobileye号称实现比原来高效100倍。当然,这种算法的缺点和公司组织一样,创造了更多的层级,不同层级必须使用不同的设施和组织方法,所以 Mobileye 在其芯片上采用了5种不同功能和架构的内核分别处理算法。- VMP-超长指令宽度(VLIW)-单指令多数据(SIMD);专为定点算法的数据级并行性而设计(例如,将12位原始图像收敛为一组不同分辨率和色调图的8位图像);基本上,对整数向量执行操作

- PMA-粗粒度可重构阵列(CGRA);为数据级并行设计,包括浮点运算;基本上,对浮点数向量执行操作

- XNN-专注于深度学习的固定函数:卷积、矩阵乘法/完全连接和相关激活后处理计算:例如CNN、FCN、Transformer的优秀处理表现。

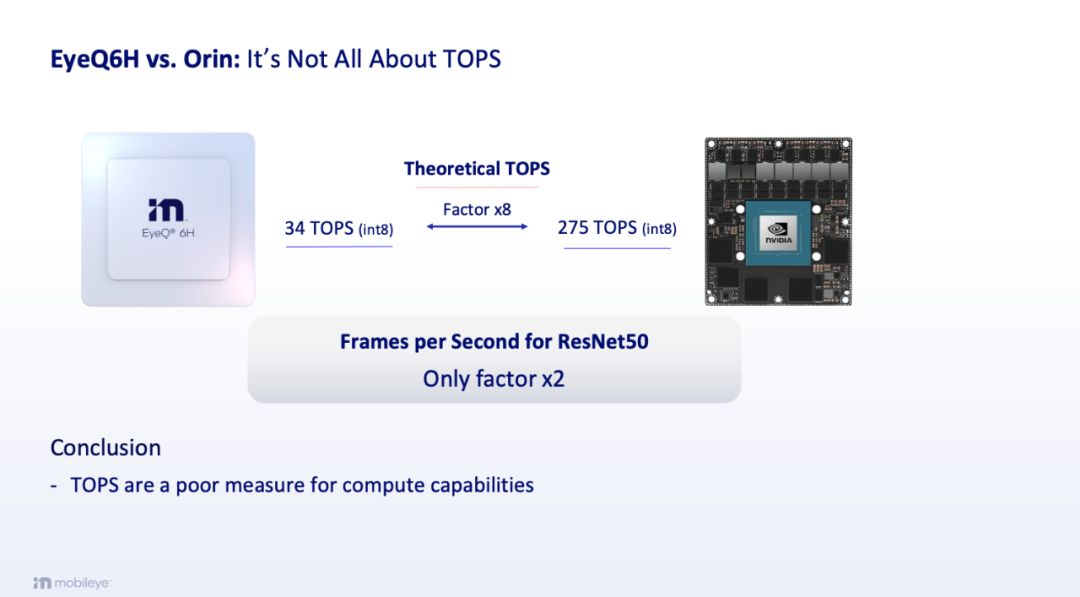

根据这些软硬算法的结合, Mobileye 表示其最新的 EyeQ6H 虽然只有34 TOPS (int8)是英伟达Orin x的 1/8 但是跑图形算法ResNet50的能力却是英伟达Orin x的 1/2 ,所以 Mobileye 表示算力并不能够很好的评价芯片的计算能力。最后 Mobileye 喊出他的 CAIS 是极致的AI 高效率来叫板大算力下的端到端。

除此之外,对于数据方面,端到端就是一个大胖子来什么吃什么,食量大,但其实这里会有问题,需要强大的数据采集和算力处理,并不高效。所以其实可以看到特斯拉去年从Luminar购买 2,000 台激光雷达,Mobileye猜测大概率是为了创建监督训练的地面实况 (GT) 数据,而 Mobileye 也在做这个事情,做这个事情的难点就是需要标注数据。Mobileye 表示其采用在大型无监督数据上训练基础模型然后监督对少量标签的微调的方法来做地面实况 (GT) 数据。最后,在商业方面,Mobileye确保其整套方案模块化,从而能满足不同自动化需求的高效开发,保证发展有保障,未来有路径。Mobileye 的 CAIS 能否挑战端到端大模型Mobileye 算是在独特的方案中坚持到底,其方案提供软硬结合的一整套方案,这种 CAIS 方案无疑是高效的,它更讲究专用性,根据行业的特点进行深入分析定制。端到端大模型的智能驾驶应该算是通用人工智能的一个应用分支,它的带领肯定是英伟达等大算力巨头,他讲究通用性和大算力。

目前国内一大通采用英伟达芯片的肯定是走端到端大模型的智能驾驶,接下来各家纷纷构建自己芯片体系的例如蔚来,理想,小鹏,momenta大概率不会摆脱这个影子,但有可能长期会分化;特殊的华为应该是走 CAIS 的方案,毕竟软硬都有,而且能力特强,在强大的背景下走出自己的一条路;比较尴尬的是地平线了,今年年初的百人会上余凯表示“十年以后连L3都不会真正实现”其实这不过是没有找到自己大算力和软硬定位的叹息。

最后,那从商务上来讲,Mobileye 的 CAIS 高阶智能驾驶在目前的中国会比较难,它太具有唯一性了,在主机厂主导的供应商体系里面唯一性太可怕了,如果 Mobileye 没有打通商务问题,可能永远留在 L2以及以下的市场,无法分享高阶智能驾驶快速发展的蛋糕。未经准许严禁转载和摘录-参考资料:

Driving AI 2024 Navigating the path to autonomous mobility - Mobileye

Learning Token-Based Representation for Image Retrieval - Hui Wu1 , Min Wang2*, Wengang Zhou1,2*, Yang Hu1 , Houqiang Li1,2

从模型到复合人工智能系统的转变 - Matei Zaharia、Omar Khattab、Lingjiao Chen、Jared Quincy Davis、Heather Miller、Chris Potts、James Zou、Michael Carbin、Jonathan Frankle、Naveen Rao、Ali Ghodsi

加入Vehicle VIP 知识星球获取智能新能源汽车以及科技海量参考资料。

特斯拉的ASS和华为远程召唤泊车哪个更强?

特斯拉的ASS和华为远程召唤泊车哪个更强?