芝能智芯出品

芝能智芯出品

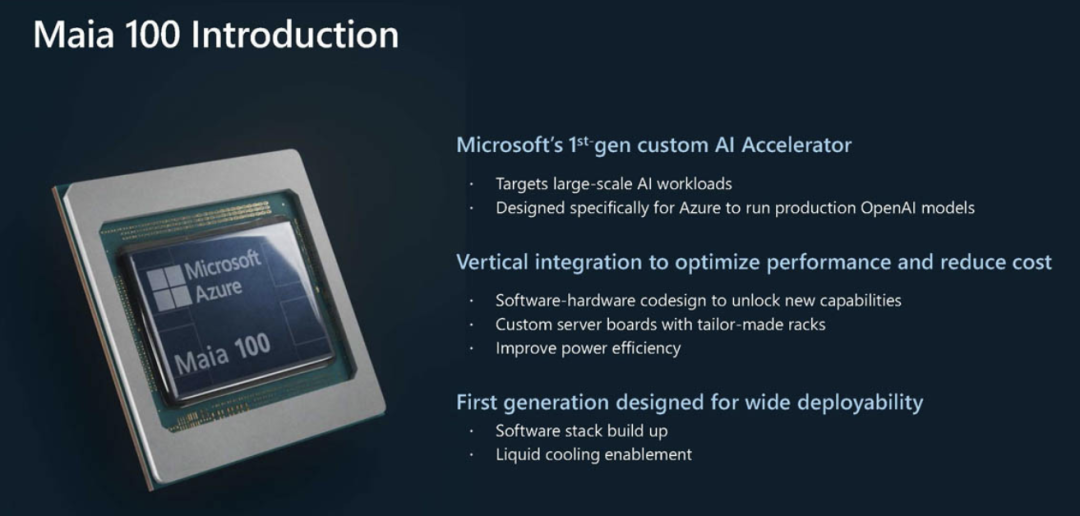

在 Hot Chips 2024 上,微软发布了其最新的定制 AI 加速器——MAIA 100,这一消息引起了业界的广泛关注。

作为微软 Azure 平台的核心硬件之一,MAIA 100 展现了微软在 AI 领域的雄心壮志,也体现了其在硬件定制化和性能优化方面的深厚积累。

MAIA 100 是微软专为 Azure 平台设计的定制 AI 加速器,专门用于运行 OpenAI 模型。

微软在硬件设计上选择了台积电的 CoWoS-S 制程工艺,并采用了5nm技术节点。

Microsoft MAIA 100

的技术规格和设计理念

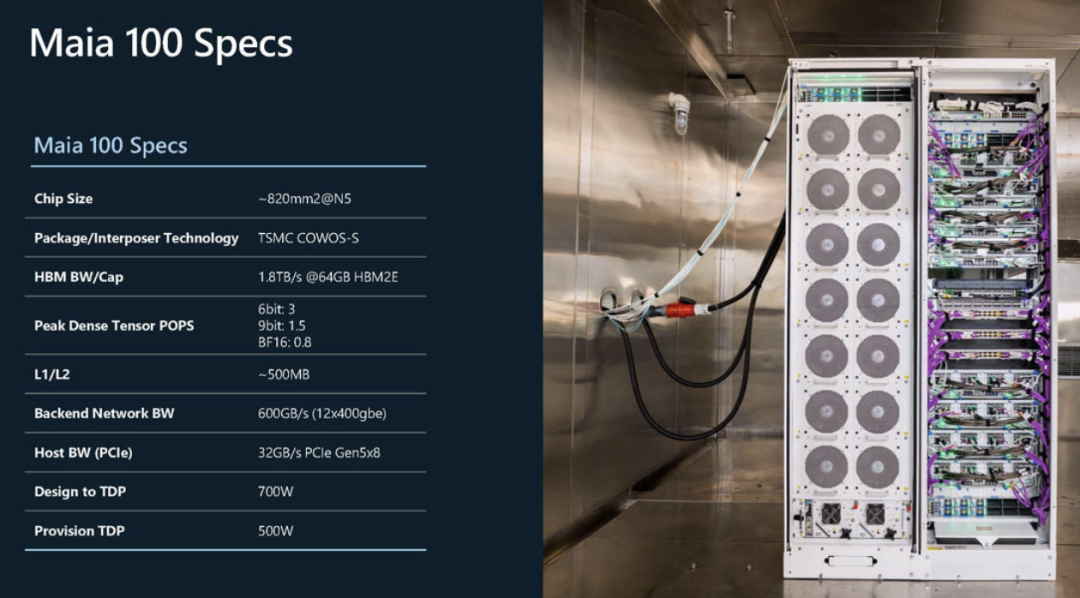

MAIA 100反映了微软在性能与功耗之间的平衡考量。

MAIA 100 配备了 64GB 的 HBM2E 存储,这一容量足以应对大型模型的内存需求,同时避免了与 NVIDIA 和 AMD 在高端 HBM 供应链上的竞争。

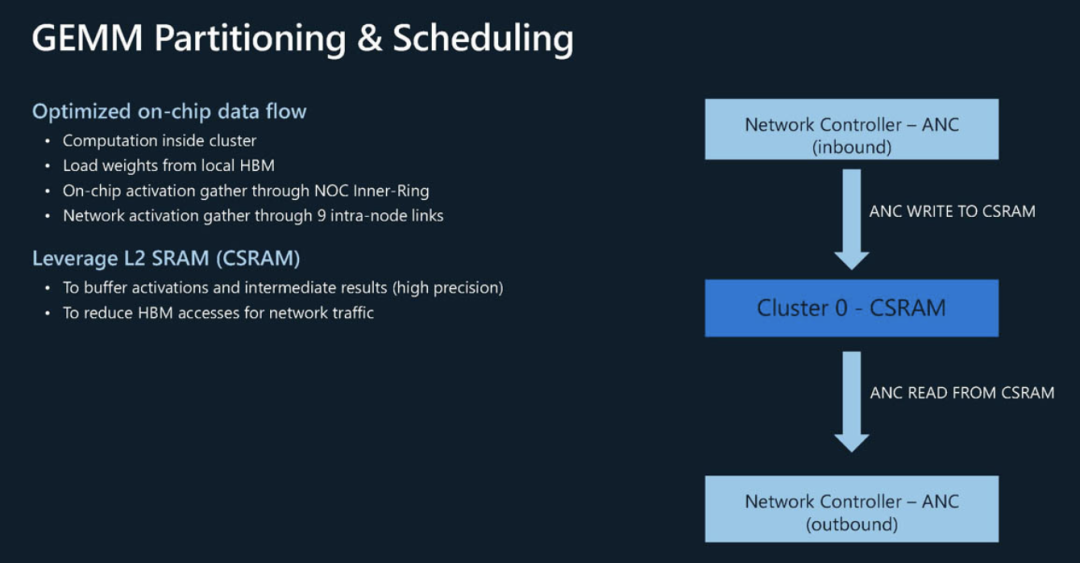

MAIA 100 拥有一个 500MB 的大 L1/L2 缓存,这在 AI 加速器中并不常见,希望通过更大的缓存来加速数据访问,提升计算效率。

在网络连接方面,MAIA 100 提供了 12x 400GbE 的网络带宽,支持高性能计算所需的大规模数据传输。

这使得它非常适合超大规模的数据中心应用,尤其是在需要大量数据传输的深度学习任务中,这款加速器的 TDP 高达 700W,而在实际生产中每个加速器消耗约 500W,这也显示出其在性能和功耗上的权衡。

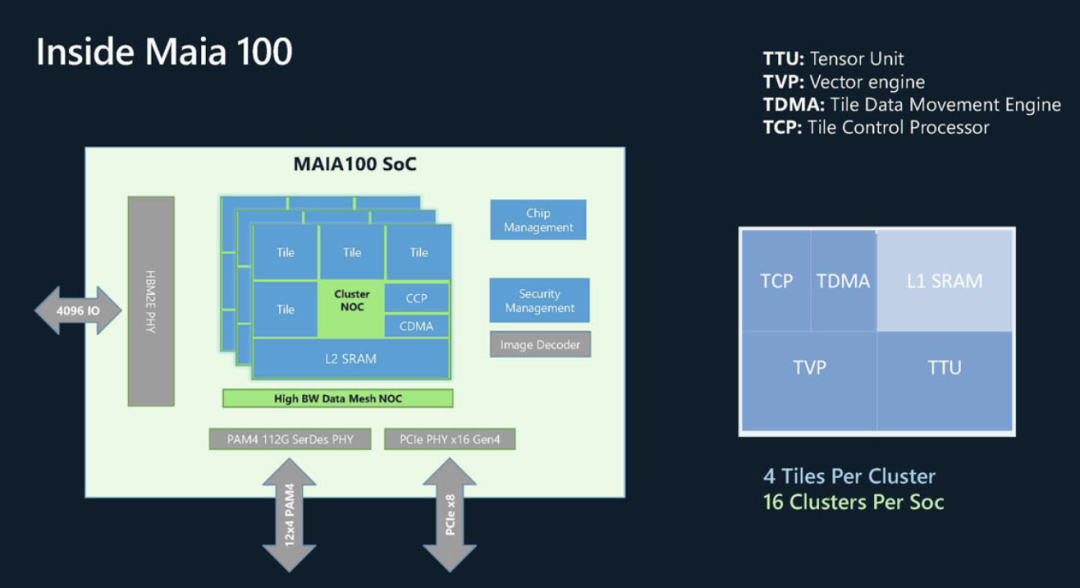

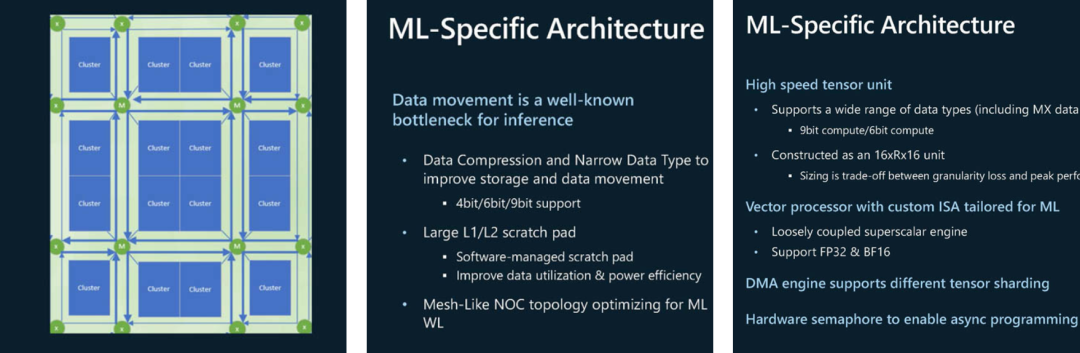

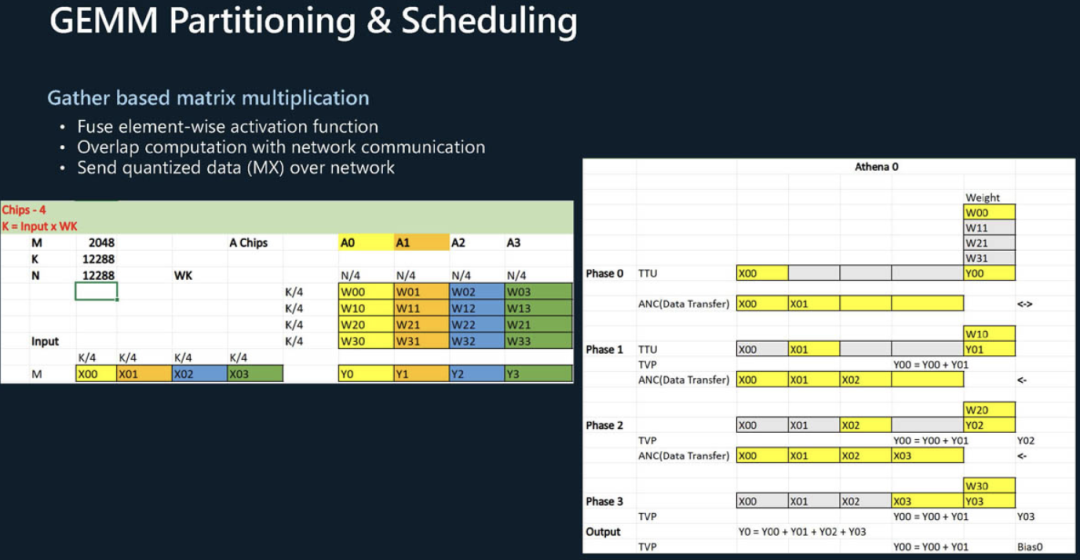

MAIA 100 的架构设计突出了其高性能和多功能特性。每个 SoC 中包含 16 个集群,每个集群内有四个图块,这样的设计能够实现高效的并行计算能力。

此外,它还包含了图像解码器和机密计算功能,进一步增强了其多任务处理能力。

MAIA 100 的数据类型支持非常广泛,可以处理 9 位和 6 位的计算。这种多样化的数据支持,使得它可以灵活应对不同的 AI 计算任务,从而提升整体的计算效率。对于高性能计算,特别是在处理图像和自然语言处理等任务时,这种灵活性尤为重要。

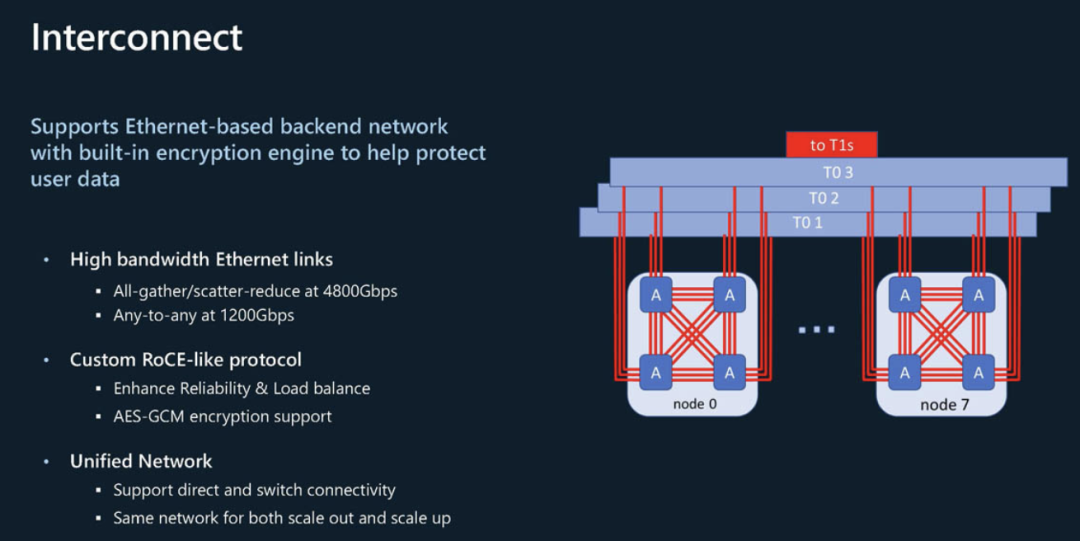

基于以太网的互连技术

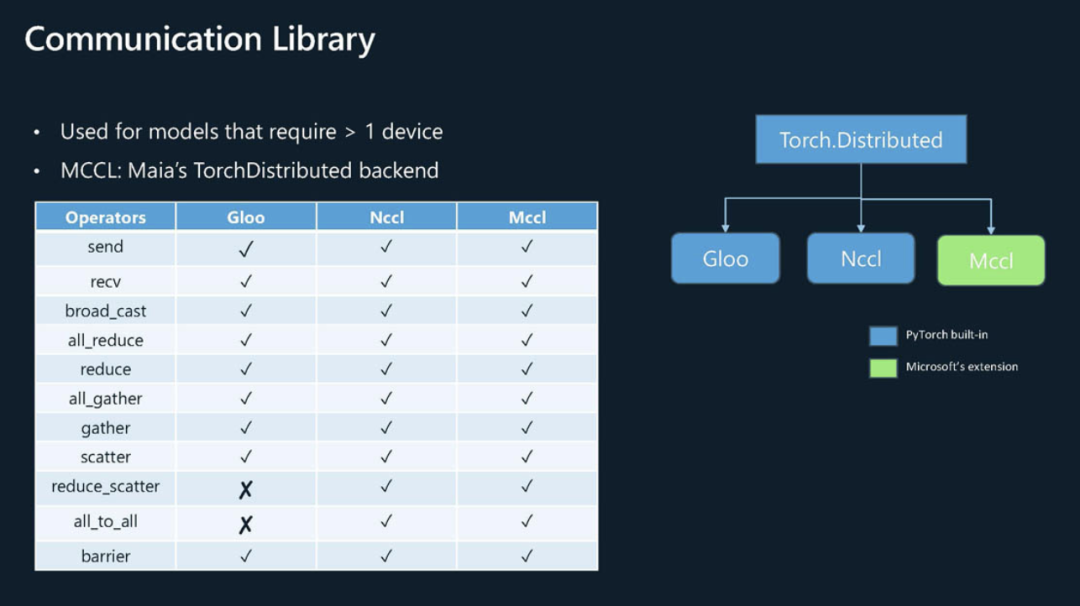

在互连技术方面,微软选择了基于以太网的解决方案,并开发了定制的 RoCE 类协议。

这一选择与传统的 InfiniBand 不同,表明了微软在互连技术上的创新性思维。基于以太网的互连技术不仅能够降低成本,还能利用现有的网络基础设施,进一步推动 Azure 平台的普及和应用。

微软作为超级以太网联盟 (UEC) 的主要推动者,选择基于以太网的互连也是一个合理的战略选择。

通过推动基于以太网的互连标准,微软可以在数据中心市场中占据更大的主动权和话语权。

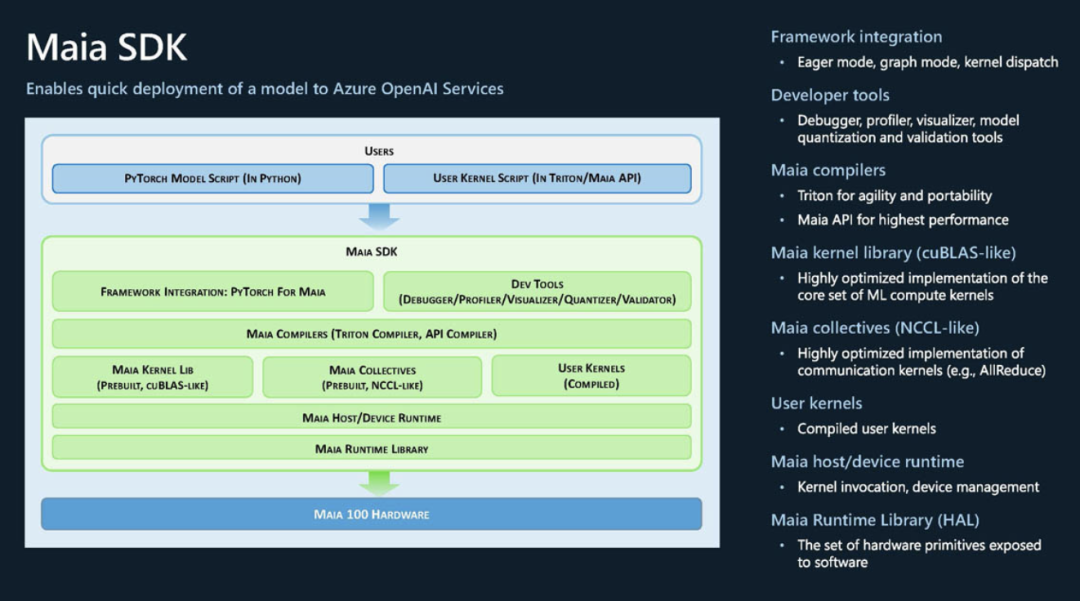

MAIA 100 不仅在硬件上具有创新性,其软件生态也是其一大亮点。

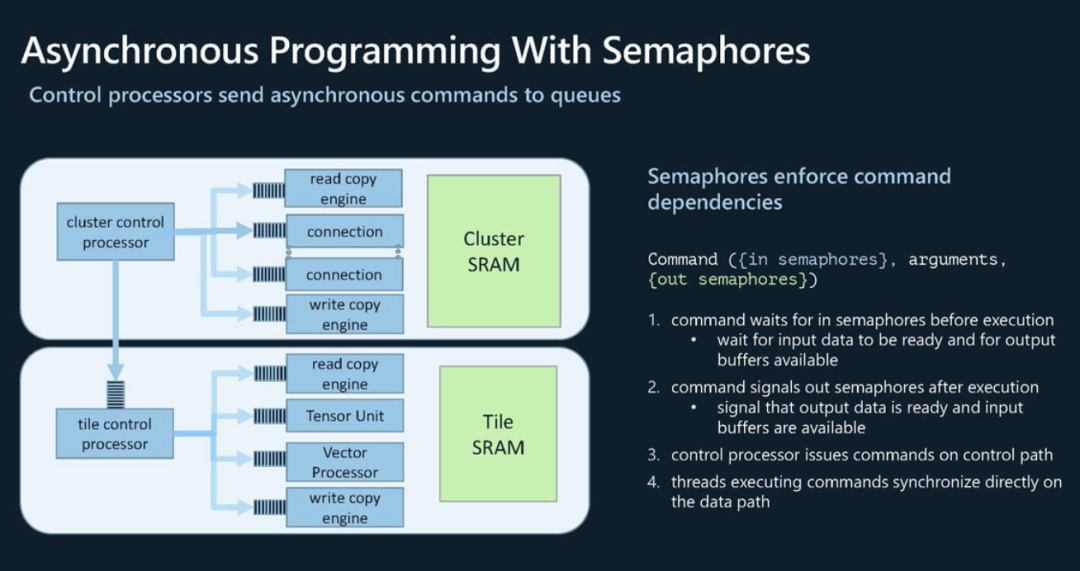

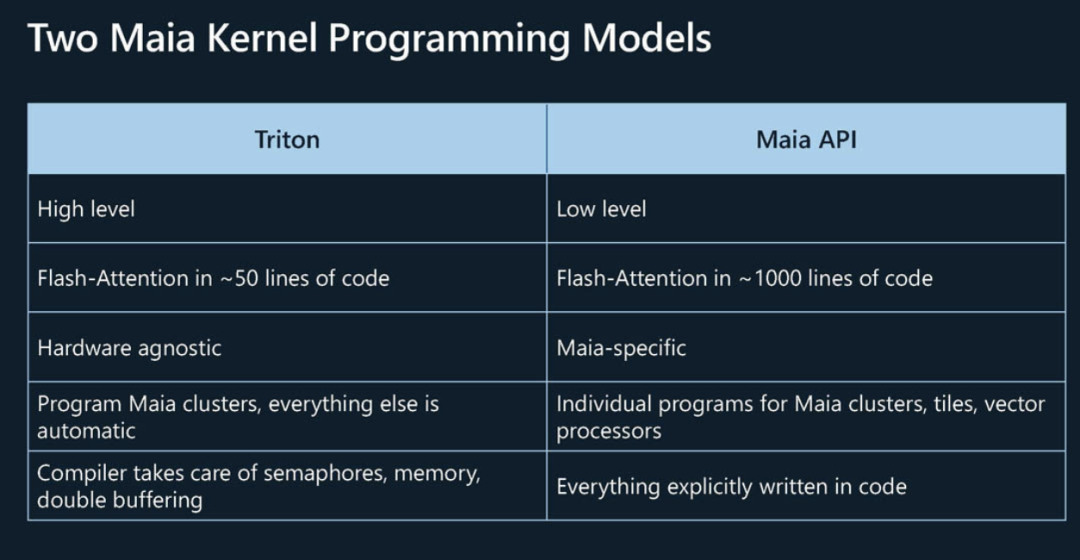

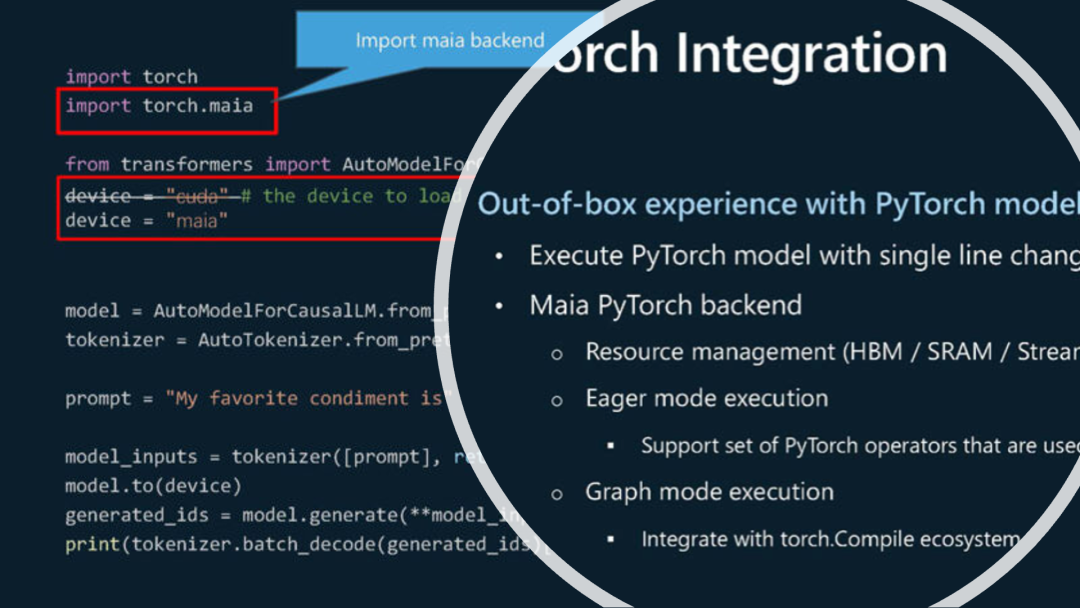

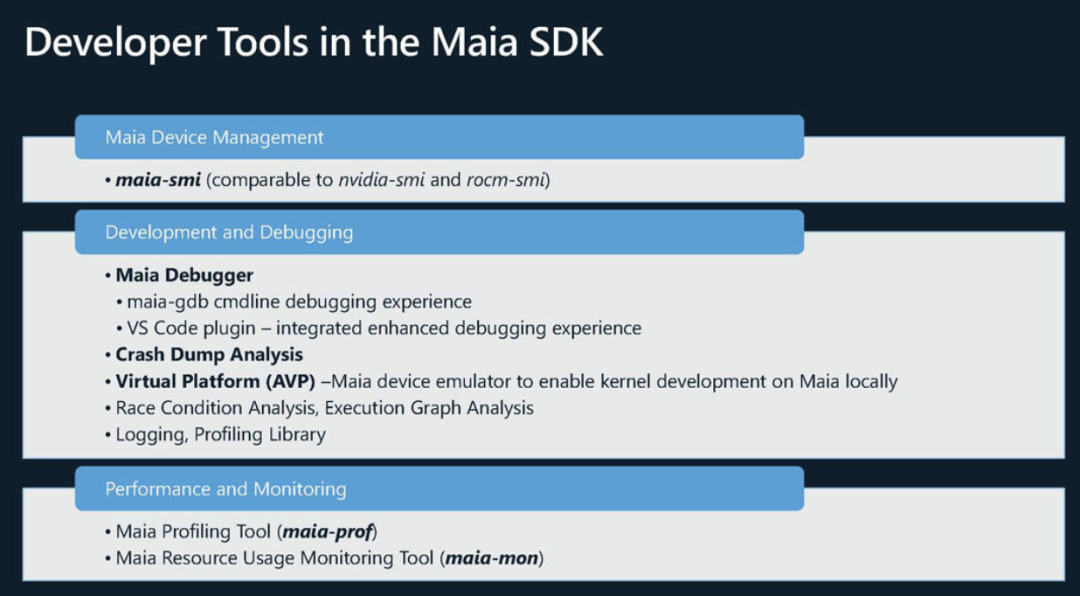

微软为 MAIA 100 提供了专门的 Maia SDK 和异步编程模型,支持通过 Triton 或 Maia API 进行编程。这种设计为开发者提供了更多的灵活性,既可以使用高层次的编程模型,也可以通过低层次的 API 进行更精细的性能优化。

Maia 100 对 PyTorch 模型具有开箱即用的支持,开发者只需将后端从 CUDA 切换到 Maia 即可,这大大降低了迁移成本和学习曲线。

同时,Maia-SDK 中提供的工具链(如 maia-smi)也借鉴了 NVIDIA 和 AMD 的经验,进一步简化了开发和调试过程。

作为 Azure 平台的定制 AI 加速器,MAIA 100 的推出表明微软正在寻求更多的硬件自主权和市场竞争力。

在 AI 计算加速领域,NVIDIA 和 AMD 一直占据主导地位,但微软通过定制化的硬件解决方案,可以更好地优化其云平台的性能和成本结构,特别是在大模型和高性能计算领域。

MAIA 100 的 HBM 容量相对较小,但其高效的缓存和互连设计,以及针对特定任务的优化,使得它在特定场景下具有明显的优势。

在当前能源紧张的全球环境下,微软的策略显然是通过提供成本更低的 GPU 来赢得更多市场份额。

小结

Microsoft MAIA 100 代表了微软在 AI 领域的又一次大胆尝试。通过在硬件和软件上的创新,微软不仅希望在性能上挑战现有的市场领导者,还希望在整体成本和能源效率上实现突破。