解锁更多企业级AI能力,包括大语言模型和生成式AI。

美通社消息,近日,IBM在 Hot Chips 2024大会上公布了即将推出的 IBM Telum® II 处理器和 IBM Spyre™ 加速器的架构细节。这些新技术旨在大幅扩展下一代 IBM Z 大型主机系统的处理能力,通过新的 AI 集成方法,加速企业对传统 AI 模型和大语言 AI 模型的协同使用。

随着基于大语言模型的 AI 项目从概念验证阶段进入生产阶段,企业对高能效、高安全性和高度可扩展解决方案的需求日益迫切。摩根士丹利最近发布的一份研究报告预测,在未来几年,生成式 AI 的电力需求将以每年 75% 的速度激增,其 2026 年的能耗或将与西班牙 2022 年的全年能耗相当。许多 IBM 客户表示,支持适当规模的基础模型和针对 AI 工作负载的混合架构越来越重要。

此次IBM发布的主要创新技术包括:

IBM Telum II 处理器:这一全新芯片将搭载于下一代 IBM Z 系列主机,与第一代 Telum 芯片相比,其频率和内存容量均有提升,高速缓存提升40%;集成 AI 加速器内核和数据处理单元 (DPU) 的性能也得到改善。IBM Telum II处理器将支持大语言模型驱动的企业计算解决方案,满足金融等行业的复杂交易需求。

IO 加速单元:Telum II 处理器芯片上的全新数据处理单元 (DPU) 旨在加速大型主机上用于联网和数据存储的复杂 IO 协议,可简化系统操作,提高关键组件性能。

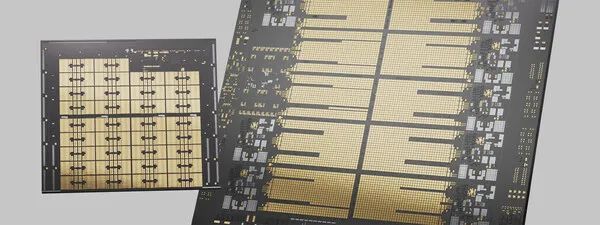

IBM Spyre加速器:可提供额外的AI计算能力,与 Telum II 处理器相得益彰。Telum II 和 Spyre 芯片共同构成了一个可扩展的架构,可支持AI集成建模方法,即将多个机器学习或深度学习的AI模型与基于编码器的大语言模型相结合。通过利用每个模型架构的优势,AI集成的方法可以生成比单个模型更准确、更稳健的结果。Spyre 加速器芯片在 Hot Chips 2024 大会期间进行了预览,并将作为Telum II 处理器的附加选件提供。每个加速器芯片均与IBM 研究院合作开发,通过一个 75 瓦 PCIe 适配器连接。与其他 PCIe 卡一样,Spyre 加速器可根据客户需求进行扩展。

Telum II 处理器和 IBM Spyre 加速器将由 IBM 的长期合作伙伴三星晶圆代工(Samsung Foundry)生产,采用其高性能、高能效的 5 纳米工艺节点。二者将共同支持企业的先进AI 用例,释放业务价值,从而创造新的竞争优势。

规格和性能指标:

Telum II 处理器:配备八个运行频率达 5.5GHz的高性能内核,每个内核配备 36MB二级高速缓存,片上高速缓存容量增加 40%(总容量达 360MB)。每个处理器抽屉的虚拟 L4 高速缓存为 2.88GB,相比上一代增加 40%。集成的 AI 加速器可实现低延迟、高吞吐量的交易中 AI 推理,例如增强金融交易期间的欺诈检测,并且每块芯片的计算能力是上一代的四倍。

Telum II 芯片中集成了最新的 I/O 加速单元 DPU。在设计上,其I/O 密度提高 50%,可大幅提高数据处理能力,进一步提高 IBM Z 的整体效率和可扩展性,使其成为处理大规模AI工作负载和数据密集型应用的不二之选。

Spyre 加速器:这是一款专为复杂 AI 模型和生成式 AI 用例提供可扩展功能的企业级加速器。它有高达 1TB 的内存,可在普通 IO 抽屉的八块卡上串联工作,以支持大型主机的整体 AI 工作负载,同时每块卡的功耗不超过 75W。每块芯片由 32 个计算内核组成,支持 int4、int8、fp8 和 fp16 数据类型,适用于低延迟和高吞吐量的 AI 应用。

产品时间表

作为 IBM 下一代 IBM Z 和 IBM LinuxONE 平台的中央处理器,Telum II 处理器预计在 2025 年向 IBM Z 和 LinuxONE 客户提供。IBM Spyre 加速器仍在技术预览阶段,预计也将于 2025 年推出。

联系美通社

+86-10-5953 9500

info@prnasia.com