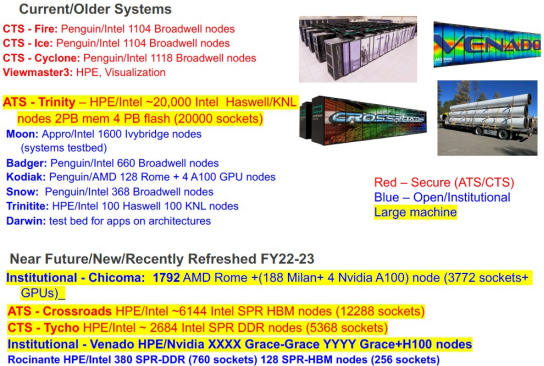

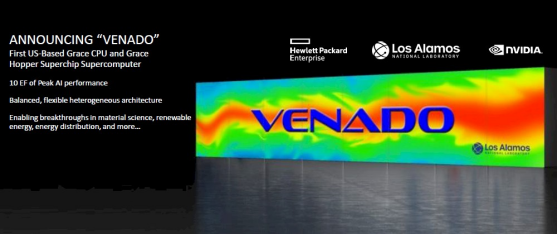

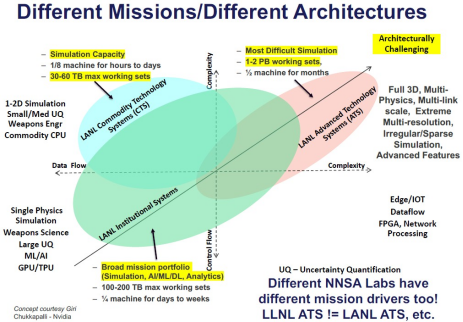

今天是“Venado”超级计算机的剪彩仪式,早在 2021 年 4 月Nvidia 宣布其首款数据中心级 Arm 服务器 CPU 的计划时就曾暗示过这一点,并进行了一些详细讨论,但还不够充分。现在我们终于可以了解有关 Venado 系统的更多详细信息,并更深入地了解Los Alamos将如何使其发挥作用,更具体地说,为什么内存带宽和依赖于它的计算之间的更好平衡对此可能更为重要与世界其他 HPC 中心相比,该实验室的规模更大。《HPC ISC24 Presentations合集(1)》1、ISC24 Presentation Market-Update(2024) 2、Hyperion Research ISC24 Presentation(2024) 3、ISC24 Presentation Navigating:HPC-AI-Quantum-and-Clouds《HPC ISC24 Presentations合集(2)》1、ISC24 Presentation Considerations for Storage and Interconnects 2、ISC24 Presentation 4th-Annual-Global-QC-Market-Robust-and-on-the-Rise 3、ISC24 Presentation Considerations-for-Sustainability《HPC ISC24 Presentations合集(3)》1、ISC24 Presentation Widespread AI Adoption Creates New Demands 2、ISC24 Presentations Forecasts and High Growth Areas 3、ISC24 Presentation Considerations for Cloud 4、ISC24 Presentation ConclusionsAI终端行业精华报告:AI进化加速端侧落地,新一轮浪潮蓄势待发(2024)AI终端行业深度:AI应用落地可期,终端有望迎全面升级Los Alamos始建于 1943 年,是制造世界上第一批核武器的曼哈顿计划的所在地。当然,我们当时没有超级计算机,但Los Alamos一直在进行大量非常复杂的计算;有时是手工操作,有时是 IBM 的制表机使用打孔卡来存储和操作数据——这是一种早期的模拟形式。Los Alamos第一台进行此类计算的数字计算机名为 MANIAC,于 1952 年安装;它每秒可以执行 10,000 次操作,并运行蒙特卡罗模拟,利用随机性来模拟实际的确定性过程。在接下来的四十年里,洛斯阿拉莫斯使用了 IBM、Control Data Corporation、Cray、Thinking Machines 和 Silicon Graphics 的一系列超级计算机,并且是IBM 使用 AMD Opteron 处理器和Cell 加速器打造的“Roadrunner”于 2008 年安装,代表了 CPU 和加速器的首次大规模集成。最近,Los Alamos于 2015 年安装了耗资1.47 亿美元的“Trinity”系统,该系统由英特尔的英特尔至强和至强融核 CPU 组成,并配有 2 PB 内存和英特尔 100 Gb/秒 Omni-Path 互连。Trinity 值得注意,因为从大量内存中卸载计算结果需要突发缓冲区,以便机器可以继续计算。Trinity 的替代品是“Crossroads”超级计算机,该超级计算机于 2023 年 8 月安装,它基于英特尔的“Sapphire Rapids”Xeon SP 处理器,配备 HBM2e 堆叠内存和 HPE 的 Slingshot 互连。Los Alamos及其邻居桑迪亚国家实验室(Sandia National Laboratories)都渴望促进可集群成超级计算机的 Arm 服务器的创建,洛斯阿拉莫斯一直在通过 Cavium 的不幸的 ThunderX4 Arm 服务器项目来推动每个内核的内存带宽(以及然后是马维尔)。“Triton”ThunderX3 或 ThunderX4 都没有问世,因此Los Alamos诱使英特尔创建了 Sapphire Rapids 的 HBM 变体,并说服 Nvidia 创建了“Grace”CG100 Arm 服务器芯片。与其当前的“Hopper”GH100 和 GH200 GPU 加速器以及未来的“Blackwell”GB100 和 GB200 加速器配对。Venado 在西班牙语中的意思是鹿或雄鹿,也是新墨西哥州 Sangre de Cristo 山脉的一座山峰的名称,这就是新机器得名的地方。正如您所预料的那样,Hewlett Packard Enterprise 是该系统的主要承包商,并且正如我们所预期的那样,该系统没有使用 Nvidia 为制造共享内存 GPU 的超级 Pod 而创建的 GPU NVLink Switch 共享内存互连。两年前,当 Venado 系统架构正式确定时,有人讨论Los Alamos可能希望在具有 Grace-Grace 和 Grace-Hopper 计算的 Cray“Shasta”XE 超级计算机系统内使用 InfiniBand,而不是 HPE 的 Slingshot 以太网变体引擎,但事实证明,Los Alamos正在部署 200 Gb/秒的 Slingshot 11 互连。我们的猜测?每个端口速度为 200 Gb/秒的 HPE Slingshot 11 比端口速度为 400 Gb/秒的 Nvidia Quantum 2 InfiniBand 便宜很多。新的 Venado 系统并不是Los Alamos舰队中的主力机器,而是一个实验性的机器,它是根据自己的预算建造的,其明确目的是进行硬件和软件研究。Los Alamos采购的大多数机器都是为负责管理美军核武器库存的国家核安全管理局提出、建造、验收并立即投入使用的。早在 2021 年 5 月,我们就通过公告正式了解了 Venado:我们还通过与 HPC 项目经理 Jim Lujan 和Los Alamos模拟与计算实验室副主任 Irene Qualters 的交谈了解到,基本想法是在两种架构之间对计算周期进行 80/20 的分割。这意味着 80% 的flops 将来自 GPU(我们假设这是在 FP64 精度下完成的,以瓜分计算量),20% 将来自 GPU。考虑到在常规 GPU 加速机器中,95% 到 98% 的flops 来自 GPU,这台 Venado 机器看起来对 CPU 的负担比您预期的要重一些。正如 Gary Grider 所说,他是Los Alamos HPC 部门的领导者,在过去的两年半里担任该部门的负责人,同时也是突发缓冲区(burst buffer)的发明者,他有充分的理由告诉The Next Platform。“我们的应用程序是极其复杂的多物理场、多链路规模、极端多分辨率、极其复杂的程序包,其中包含数百万行代码,这些代码在半台机器上运行六个月才能得到答案,”Grider 解释道。“这对我们来说很正常,但对于许多其他能源部实验室(如果有的话)来说,情况并非如此。他们可能会将其视为一件不寻常的事情,但并非通常。运行这些应用程序需要六个月的时间是因为对内存的访问非常稀疏和不规则,因为它们试图做的事情非常复杂——应用程序正在尝试运行一个比实际问题大 50 倍的问题。因此,这最终成为我们为模拟环境购买的各种机器的驱动力,因为我们有这些需求。这最终成为我们不购买太多 GPU 的原因,因为如果你能做密集线性代数,GPU 就真的很好。但如果你所做的一切都是稀疏和不规则的,并且一切都是索引查找之类的,那么它们实际上并不比 CPU 更好。实际上,更重要的是你每美元可以购买多少内存带宽,而不是你可以购买多少 flops 。”也许很方便的是,在 GPU 上运行深度学习推荐系统 (DLRM:deep learning recommendation systems ) 的超大规模开发商和云构建商还需要一种方法来为这些推荐器缓存比 GPU HBM 内存中所能容纳的更多的嵌入量,Nvidia 给出了答案随之而来的是 Grace,一款出色的计算内存控制器,可额外提供 480 GB LPDDR5。或许并非巧合的是,两个 72 核 Grace 芯片通过 NVLink 端口连接形成一个超级芯片,蚀刻到 Grace 中的 Arm“Demeter”V2 内核具有 960 GB 的内存容量和 1 TB/秒的内存带宽。由于每个 V2 内核有四个 128 位 SVE2 矢量引擎,Grace-Grace 超级芯片可以自行提供 7.1 teraflops 的聚合峰值 FP64 计算。在正常情况下,当 GPU 执行大部分计算时,您可能会认为 Nvidia 会使用 Arm 的向量较少的“Perseus”N2 核心。我们认为美国的Los Alamos和瑞士的 CSCS 拥有“Alps”系统,促使 Nvidia 使用 V2 核心。并且得益于Grace CPU中相对较少的核心、相对便宜且低功耗的LPDDR5内存以及相对肥厚的480 GB可用内存,Grace在每核心内存带宽和单位内存带宽成本之间取得了很好的平衡。我们在此详细介绍的Grace CPU具有 16 个 LPDDR5 内存控制器,每个控制器的内存带宽总计为 546 GB/秒,容量为 512 GB。Grace 的交付版本只有 480 GB 内存和 500 GB/秒带宽。详细而言,Grace-Grace 超级芯片中的两个 CPU 通过 900 GB/秒 NVLink 芯片到芯片实现(chiplet 行话中的 C2C)相互连贯地链接。同样的 NVLink C2C 互连用于将 Grace CPU 连接到具有 80 GB 或 96 GB HBM3 或 141 GB HBM3E 容量的 Hopper GPU,具体取决于您购买的型号。无论如何,根据我们在 2022 年 5 月对 Grace 和 Hopper 的了解以及在计算上进行 80/20 的分割,我们进行了一些粗略的计算,并得出您将需要 3,125 个 Grace-Hopper 节点和大约 1,500 个 Grace-Grace 节点。Grace CPU 的 FP64 性能超出了许多人的预期——同样,我们认为这是有意为之,并且是由 HPC 客户而非 AI 客户驱动的——结果是实际的 Venado 系统拥有 2,560 个 Grace-Hopper 节点和 920 个 Grace-Grace 节点。如果您计算一下,总共有 316,800 个 Grace 核心,峰值 FP64 性能总计为 15.62 petaflops。Venado 节点中的 Grace CPU 共有 2 PB 主内存。(呵呵,您认为这是巧合吗?我们不这么认为。它的内存量与 Trinity 系统相同。)LPDDR5 内存的总带宽为 2.1 PB/秒。“盒子”中有 2,560 个 Hopper GPU,矢量核心上的 FP64 性能合计为 85.76 petaflops,张量核心上的 FP64 性能为 171.52 petaflops。如果您在 H100 上使用张量核心,则 Hopper 上的 FP64 为 92%,Graces 上的 FP64 为 8%,但如果仅使用矢量核心,则 Hopper 上的 FP64 为 85%。我们假设这些 Hopper GPU 每个具有 96 GB 的 HBM3 内存,总共 240 TB 的 HBM3 内存和 9.75 PB/秒的聚合带宽。如果进一步计算,就会发现机器 81% 的内存带宽位于 Hopper GPU 上,但惊人的 19% 位于 Grace CPU 上。作为与 HPE 合同的一部分,Venado 系统将配备驻留在 Slingshot 网络上的 Lustre 并行存储集群,Grider 表示,洛斯阿拉莫斯也希望在该机器上尝试DeltaFS 文件系统以及其他文件系统。Grider 表示,Venado 现已安装并正在运行,并且应该会在接下来的两个月内被接受,“除非有时会发生一些问题”,并且到 7 月份左右应该会有大量应用程序在实验机器上运行。

下载链接:

2024年中国安防视频监控SoC芯片行业研究报告:安防SoC市场喜迎百亿爆发,众企竞逐后海思时代

迈向巅峰之路:中国成长型AI企业研究报告(2024)

2024安全大模型技术与市场研究报告

2024大模型典型示范应用案例集

HBM专题:逐鹿顶尖工艺,HBM4的三国时代

AI Agent行业词条报告:驱动智能交互变革,重塑服务生态

空间数据智能大模型研究:2024年中国空间数据智能战略发展白皮书

企业竞争图谱:2024年量子计算词条报告

2024中国服务器CPU行业概览:信创带动服务器CPU国产化

HBM专题报告:跨越带宽增长极限,HBM赋能AI新纪元

2024基于标准PCIe接口的人工智能加速卡液冷设计白皮书

《新型智算中心改造系列报告合集》

1、新型智算中心改造系列报告二:拉动全球电力消耗增长,液冷渗透率快速提升

2、新型智算中心改造系列报告一:网络成大模型训练瓶颈,节点内外多方案并存

《国产异构处理器定位优化技术合集》

1、面向申威众核处理器的规则处理优化技术

2、神威超级计算机运行时故障定位方法

2024中国半导体深度分析与展望报告

面向异构硬件架构软件支撑和优化技术

AI大模型赋能手机终端,拥抱AI手机新机遇

全球AI算力行业首次覆盖:从云到端,云端协同,AI开启科技行业超级成长周期

2024年中国大模型行业应用研究:大模型引领智能时代,助力各行业全面升级

《半导体行业系列专题合集》

1、半导体行业系列专题:刻蚀—半导体制造核心设备,国产化典范

2、半导体行业系列专题:碳化硅—衬底产能持续扩充,加速国产化机会

3、半导体行业系列专题:直写光刻篇,行业技术升级加速应用渗透

4、半导体行业系列专题:先进封装—先进封装大有可为,上下游产业链受益

“人工智能+”进入爆发临界,开启繁荣生态前景

鲲鹏处理器软件性能调优(精编版)

《算力网络:光网络技术合集(1)》

1、面向算力网络的新型全光网技术发展及关键器件探讨

2、面向算力网络的光网络智能化架构与技术白皮书

3、2023开放光网络系统验证测试规范

4、面向通感算一体化光网络的光纤传感技术白皮书

《算力网络:光网络技术合集(2)》

1、数据中心互联开放光传输系统设计

2、确定性光传输支撑广域长距算力互联

3、面向时隙光交换网络的纳秒级时间同步技术

4、数据中心光互联模块发展趋势及新技术研究

面向超万卡集群的新型智算技术白皮书

面向AI大模型的智算中心网络演进白皮书

网络系列报告之交换机概览:IB性能占优,以太网开放占优

中国分布式存储产业未来发展空间广阔(2024)

本号资料全部上传至知识星球,更多内容请登录全栈云技术知识星球下载全部资料。

‧‧‧‧‧‧‧‧‧‧‧‧‧‧‧‧ END ‧‧‧‧‧‧‧‧‧‧‧‧‧‧‧‧

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言删除,谢谢。

温馨提示:搜索关注“全栈云技术架构”微信公众号,“扫码”或点击“阅读原文”进入知识星球获取10000+份技术资料。