据麦姆斯咨询报道,近期,华南师范大学李昕明研究员课题组在多模态接触信息感知方面取得重要进展,该研究探索开发了一种基于视觉的多模态触觉感知策略,通过分析触觉的视觉表征实现接触力、接触姿态、接触位置以及接触物体类别的准确识别。研究成果以“A Vision-Based Tactile Sensing System for Multimodal Contact Information Perception via Neural Network”为题发表于仪器仪表与测量、电子与电气测量领域国际知名期刊IEEE Transactions on Instrumentation & Measurement。

传统的多模态/多任务触觉感知系统通过集成多种传感单元来达到多模态触觉信息的解耦,但其往往导致了系统结构的复杂性、加工流程的复杂度增加,以及需要应对来自不同刺激间的干扰。相对地,基于视觉的触觉传感器能够利用各种光学设计来感知多种触觉信息,但随着所需接触信息维度的增加,不得不为不同的接触刺激采用特定的光学设计和信息解耦策略。

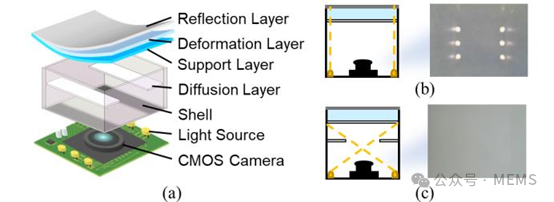

针对上述挑战,华南师范大学李昕明研究员课题组提出了一种基于单一视触觉系统的多模态触觉感知策略,通过基于反射膜式的视触觉传感器将触觉信息转换为视觉信号,进一步设计了一个能够解耦多种接触信息的深度神经网络模型。得益于视触觉图像的高密度特征,这种方法避免了为各种触觉模态定制解耦设计的需求,从而实现了更为高效的多模态触觉信息的提取。

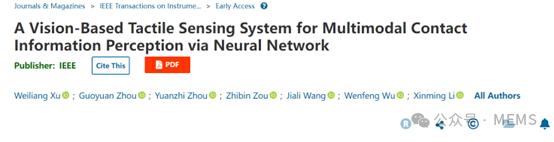

基于视觉的触觉传感器

基于视觉的触觉传感器的工作原理

在系统的实际验证中,研究人员提出了一套基于成像分辨率目标的触觉空间分辨率表征方法,可用于表征不同基于视觉的触觉传感器分辨率。基于此表征优化视触觉系统设计,实现了与人类触觉类似的微米级别空间分辨率。通过神经网络的设计引入,最终系统接触力识别精度达0.2N,姿态角度识别精度达0.41°,定位精度达0.15 mm。同时,模拟抓取实验显示该系统还可以轻松准确地识别各种类型的接触物体,具有出色的精度和召回率,展示了良好的触觉特征识别能力。

此外,该基于视觉的触觉传感系统获取的多模态触觉信息还可用于辅助机器人完成复杂的操作任务。这一系列的积极结果预示着,该系统有潜力在生物医学、生物学和机器人技术等多模态触觉感测任务中得到广泛应用。

参考文献:[1] A Vision-Based Tactile Sensing System for Multimodal Contact Information Perception via Neural Network. IEEE Transactions on Instrumentation and Measurement, 2024. DOI: 10.1109/TIM.2024.3428647.