点击蓝字 关注我们

SUBSCRIBE to US

MOOR STUDIOS/GETTY IMAGES

语音克隆——人工智能用于创建听起来真实但虚假的语音——有其好处,比如为有语音障碍的人生成合成语音(https://apnews.com/article/ai-recreating-lost-voice-illness-a6512c33481072c22182c116d2cbe419)。但这项技术也有很多恶意用途:骗子可以使用人工智能克隆声音来冒充某人,骗取个人或公司数百万美元。语音克隆还可以用于生成传播选举虚假信息的音频深度伪造。

为了应对音频深度伪造带来的日益严重的危险,美国联邦贸易委员会(FTC,Federal Trade Commission)发起了语音克隆挑战(Voice Cloning Challenge,https://www.ftc.gov/news-events/contests/ftc-voice-cloning-challenge)。来自学术界和工业界的参赛者的任务是开发防止、监测和评估用于邪恶目的的语音克隆的想法。该机构在4月宣布了这场比赛的三名获胜者(https://www.ftc.gov/news-events/news/press-releases/2024/04/ftc-announces-winners-voice-cloning-challenge)。这三支队伍都以不同的方式处理这个问题,表明需要采取多管齐下、多学科的方法来解决音频深度伪造带来的挑战和不断演变的危害。

处理音频深度伪造的3种方法

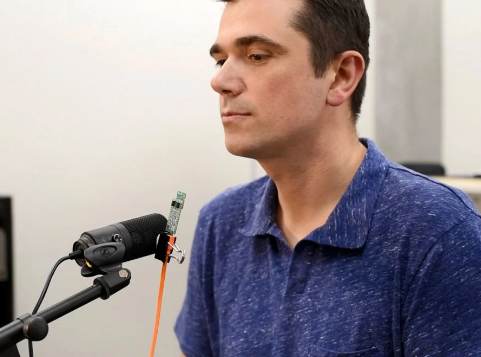

获奖作品之一OriginStory旨在验证声音的来源(https://spectrum.ieee.org/digital-forensics)。亚利桑那州立大学电气工程教授Visar Berisha与亚利桑那州立大学的同事Daniel Bliss和Julie Liss一起领导开发团队,他说:“我们开发了一种新型麦克风,可以在录音的那一刻验证录音的人性。”

VISAR BERISHA

OriginStory的定制麦克风与传统麦克风一样记录声学信号,但它也有内置传感器,用于检测和测量人说话时身体发出的生物信号,如心跳、肺部运动、声带振动以及嘴唇、下巴和舌头的运动。Berisha说:“在录音过程中,这种验证作为水印附加在音频上,并为听众提供可验证的信息,表明语音是人为生成的。”

另一个获奖项目,名为AI Detect,旨在利用人工智能捕捉人工智能。由生产人工智能语音处理软件的OmniSpeech公司提出,AI Detect将把机器学习算法嵌入手机和耳机等计算能力有限的设备中(https://spectrum.ieee.org/tag/machine-learning),以实时区分人工智能生成的语音。OmniSpeech首席执行官David Przygoda表示:“我们的目标是在你打电话或使用耳机时拥有某种标识符,例如,另一端的实体可能不是真正的声音。”

最后一个获胜的作品DeFake是另一个人工智能工具。DeFake给人类录音增加了微小的干扰,使精确克隆变得更加困难。圣路易斯华盛顿大学计算机科学与工程助理教授Ning Zhang说:“你可以把扰动想象成添加到人声记录中的微小扰频噪声,人工智能用它来了解人声的特征。因此,当人工智能试图从记录的语音样本中学习时,它会犯错误,并学到其他东西。”

Zhang说,DeFake就是所谓对抗性人工智能(adversarial AI,https://spectrum.ieee.org/adversarial-attacks-and-ai-systems)的一个例子,这是一种攻击人工智能模型正常工作能力的防御技术。他补充道:“我们正在嵌入攻击的小片段,以攻击攻击者的人工智能——那些试图窃取我们声音的人。”

实现音频深度伪造防御

AI Detect和DeFake都处于早期研发阶段。AI Detect仍然是概念性的,而DeFake需要更多的效率改善。Przygoda和Zhang也意识到了使用人工智能的弊端。

Przygoda说:“这需要持续的努力,我们正在更新我们的数据集和技术,以跟上用于创建deepfakes的模型和硬件的发展。这需要积极监控。”

Zhang回应了这一观点:“人工智能发展得很快,所以我们需要不断确保随着新功能的出现调整我们的技术。作为防御者,我们不知道攻击者在使用什么作为人工智能模型,所以我们必须能够在保持语音质量的同时,对所有攻击进行一般防御,这让事情变得更加困难。”

与此同时,OriginStory正处于测试阶段,并致力于防止该技术的欺骗。Berisha说:“我们正在进行一项验证研究,许多不同的用户试图欺骗它,让它认为麦克风后面有人,而实际上没有人。最后,我们会感觉到它有多强大。你需要非常确定地知道,另一端的人是人。”

麻省理工学院计算机科学与人工智能实验室口语系统组的博士后Nauman Dawalabad表示,人工智能检测的方法很有前景。“对于假/真音频检测模型来说,在设备上操作以保护隐私至关重要,而不是将个人数据发送到公司的服务器。”

与此同时,Dawalabad认为DeFake的预防策略(他将其比作水印)是一个很好的解决方案,可以在消费者的语音数据被泄露或截获时保护他们免受欺诈。“然而,这种方法取决于了解所有的源扬声器,需要仔细实施。例如,简单地用另一个麦克风设备重新录制带水印的语音,就可以完全或部分消除水印的影响,”他补充道。

至于OriginStory,Dawalabad表示,该技术类似的在源头盖章的预防方法“似乎比单独基于软件的水印更稳健,因为它依赖于难以复制的生物信号。”

但Dawalatabad指出,解决音频深度伪造问题的一个更有效的策略是将多种策略相结合的四管齐下的方法。他说,第一步是现在给新的录音添加水印,使其具有可追踪性。第二步是获奖作品正在着手的工作——开发更好的检测模型,这“对保护当前数据至关重要,其中大部分数据没有水印,”他说。

第三步涉及直接在设备上部署检测模型,以增强安全性和保护隐私。Dawalabad说:“这包括提出更好的模型压缩算法,以部署在资源受限的设备上。此外,我建议制造商自己在系统级别添加这些检测模型。”

最后,Dawalabad强调需要“让决策者参与进来,确保消费者保护,同时尽可能推广解决方案。”

联邦贸易委员会声音克隆挑战赛的三名获胜者将分享35000美元的现金奖励。信息安全公司Pindrop的第四个解决方案获得了表彰奖。该解决方案通过以2秒为间隔分析语音并标记那些被识别为潜在可疑的语音,实时检测音频深度伪造(https://www.pindrop.com/products/pindrop-pulse)。

微信号|IEEE电气电子工程师学会

新浪微博|IEEE中国

· IEEE电气电子工程师学会 ·

往

期

推

荐

智能家居正在变得更加智能

空间计算是什么?空间计算时代到来了吗?

如何负责任地使用人工智能

什么是通用人工智能?