芝能智芯出品

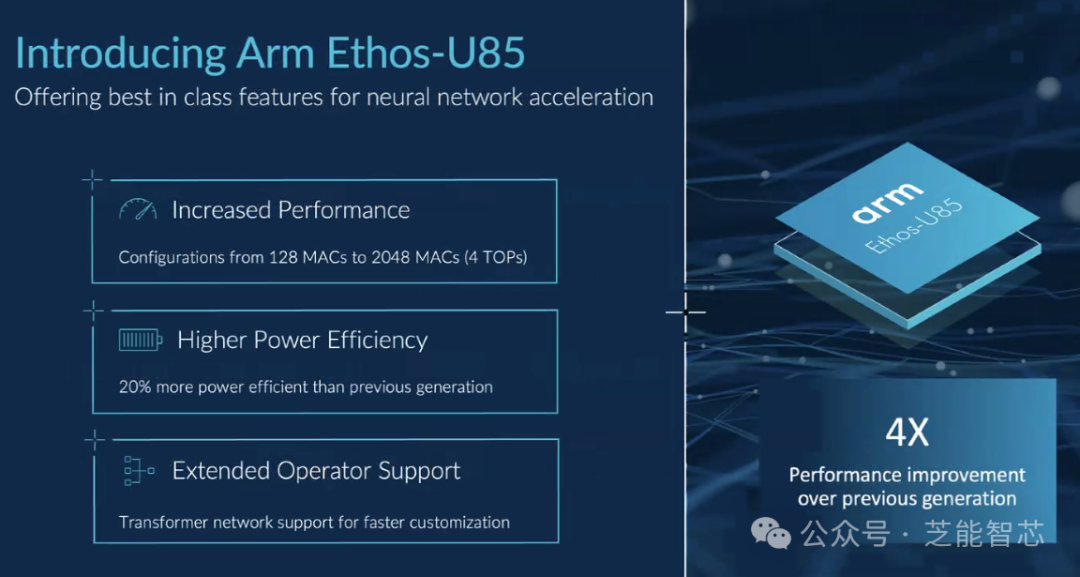

Arm架构的低功耗特性和可定制化的优势将在人工智能领域发挥重要作用。在云端和边缘推动了节能的数据中心,随着人工智能需求的增长,定制化芯片将更加受到青睐。

Arm 在数据中心的价值

十多年前,Arm 意识到数据中心的能源成本急剧上升,于是决定扩展其在移动和嵌入式市场的成功。经过多年的发展,Arm服务器处理器现在已经在数据中心站稳了脚跟,成为了Intel Xeon和AMD Epyc CPU的替代品。

Arm 首席执行官雷内·哈斯 (Rene Haas) 认为,随着人工智能 (AI) 的兴起,Arm 架构在未来将发挥重要作用,原因有以下几点:

● 能效: Arm 架构以其低功耗设计而闻名,这对于需要运行高性能 AI 工作负载的设备(例如数据中心和边缘设备)至关重要。

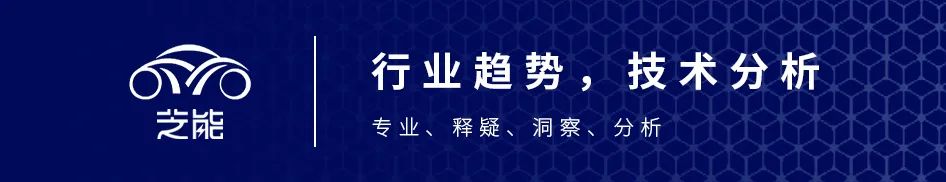

随着 AI 模型变得越来越复杂,对计算能力的需求也在不断增长,这导致了功耗的增加。Arm 架构可以帮助降低功耗和相关成本。

● 定制: Arm 提供灵活的架构,允许芯片制造商定制其设计以满足特定需求。这对于需要针对特定 AI 工作负载优化的芯片的应用程序非常有用。例如,亚马逊、谷歌和微软等公司都在使用 Arm 架构构建定制的 AI 芯片。

随着人工智能的兴起,Arm正在寻找新的发展机会。现代的人工智能模型消耗大量电力,并且随着模型变得越来越复杂,对电力的需求也在增加。为了获得更好的性能和预测能力,模型需要不断地增大,这导致了更高的能源消耗。

Arm与软银合作,参与了一项1.1亿美元的美日联合资助人工智能研究计划,致力于控制功耗和相关成本。Haas表示,Arm已经证明了其架构可以提高数据中心的能源效率,这些节能特性也可以转化为人工智能工作负载中。

Arm 在人工智能领域的布局

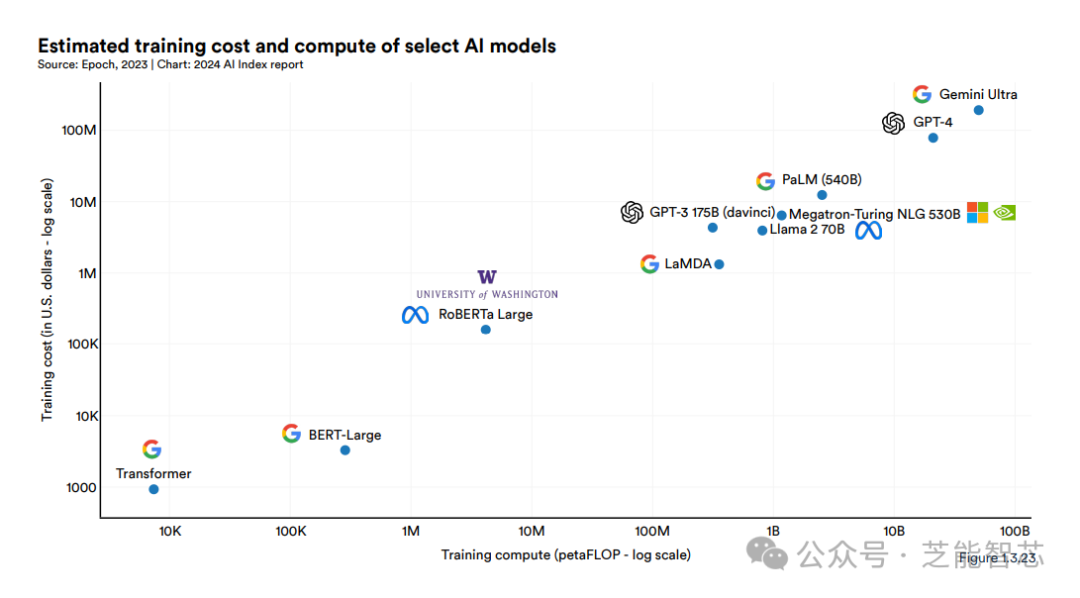

Arm 于 2024 年 2 月推出了 Ethos-U85 神经处理单元 (NPU),声称其性能比前代产品提高了四倍,能效提高了 20%。

云计算需要更高效率的数据中心,定制芯片的需求正在增加。这些定制芯片通常采用 Arm 的 Neoverse 架构构建,包括亚马逊的 Graviton 处理器、谷歌云的 Axion、微软 Azure 的 Cobalt 以及甲骨文云的 Ampere。这些芯片不仅提高了性能和效率,还可以更好地集成人工智能工作负载所需的功能。

Nvidia 上个月推出的 Grace Blackwell GB200 加速器,这是一款专注于人工智能的芯片。Grace Blackwell GB200 包括两个 Nvidia B200 Tensor Core GPU,通过 900 GB/s NVLink 互连连接到基于 Arm 的 Grace CPU。Haas 指出,这种定制芯片与之前的 H100 GPU 相比,在系统级设计上优化了功耗,性能提高了 30 倍。

小结

Arm的能效和可定制化的优势将在未来的人工智能应用中发挥关键作用。数据中心和芯片设计需要时间,但行业正在以令人难以置信的速度发展。确保芯片设计尽可能灵活,以适应创新的步伐是一个艰巨的任务,但这种灵活性正在快速发展。