随着大数据和人工智能技术的进步,对高性能计算的需求不断增长。为了满足这一需求,英伟达(NVIDIA)Quantum-2 InfiniBand平台为用户提供了卓越的分布式计算性能,实现高速和低延迟的数据传输和处理能力。InfiniBand,撼动不了以太网?

英伟达Quantum-2 Infiniband平台技术A&Q

一颗Jericho3-AI芯片,用来替代InfiniBand?

《NVIDIA InfiniBand网络技术新特性(2023)》1、NVIDIA InfiniBand-NDR Q&A2、NVIDIA Infiniband Networking Update 2023Hyperion Research:SC22 HPC Market Update(2022.11)

Hyperion Research:ISC22 Market Update(2022.5)

Intersect360全球HPC-AI市场报告(2022—2026)

Intersect360 AMD CPU和GPU调研白皮书

问:CX7 NDR200 QSFP112端口是否与HDR/EDR线缆兼容?问:如何将CX7 NDR网卡连接到Quantum-2 QM97XX系列交换机?答:CX7 NDR网卡使用英伟达(NVIDIA)的400GBASE-SR4或400GBASE-DR4光模块,而QM97XX系列交换机使用800GBASE-SR8(相当于2x400GBASE-SR4)或800GBASE-DR8(相当于2x400GBASE-DR4)光模块。这些模块使用12芯多模通用极性APC端面网线进行连接。问:CX7网卡双端口400G可以通过绑定实现800G的速率吗?为什么200G可以通过绑定实现400G?答:整体网络性能由如PCIe带宽瓶颈、网卡处理能力和物理网络端口带宽等因素决定。CX7网卡具有5.0 x16的PCIe规范,理论带宽限制为512Gbps。由于PCIe 5.0 x16的最大带宽限制,CX7网络适配器上没有可用于双端口400G的硬件。答:为了实现出色性能,分支线缆(800G到2x400G)需要连接到两台不同的服务器上。这样可以确保分支线缆不完全连接到以太网服务器网卡上,因为GPU服务器通常有多个网卡。问:在InfiniBand NDR情景中,一分二线缆是如何连接的?答:在InfiniBand NDR情景中,有两种类型的分支线缆。第一种类型使用带有分线的光模块(将400G分为2x200G),例如MMS4X00-NS400 + MFP7E20-NXXX + MMS4X00-NS400(降级为200G使用)。第二种类型使用分支高速线缆(将800G分为2x400G),例如MCP7Y00-NXXX或MCP7Y10-NXXX。问:在Superpod网络中,每台服务器上的4个NDR200卡是否可以使用1x4线缆直接连接到同一交换机,还是应该使用2个1x2线缆连接到不同的交换机?答:在Superpod网络中,不建议使用一分四线缆将每台服务器上的4个NDR200端口直接连接到同一交换机。这种连接方式不符合Superpod网络规则。为了确保NCCL/SHARP的出色性能,叶交换机应使用一对四线缆以特定的模式连接不同服务器的NDR200端口。问:关于最新的Superpod网络,根据Superpod网络白皮书的说明,在计算网络中需要单独配置2个带有UFM软件的IB交换机。然而,这样的配置会导致集群中少一个GPU节点。如果选择不设置单独的UFM交换机,而是仅在管理节点上部署UFM软件,我能否通过另一组存储网络管理集群而不影响计算网络?答:建议配置UFM设备,包括软件。在计算网络中的管理节点上部署UFM软件是一种替代方案,但它不应承担GPU计算工作负载。存储网络作为一个独立的网络层面运行,不能用于管理计算集群。问:企业UFM、SDN、遥测和Cyber-Al之间有什么区别?购买UFM是否有必要?答:可以使用OFED中包含的opensm和命令脚本工具进行简单的管理和监控,但缺少UFM友好的图形用户界面和许多功能。

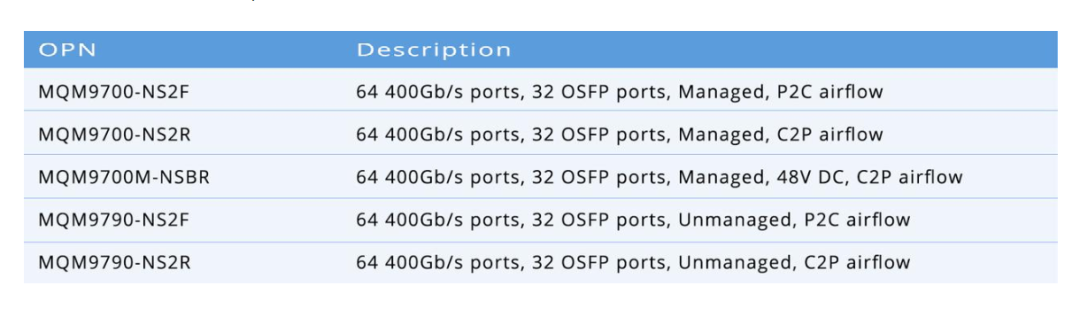

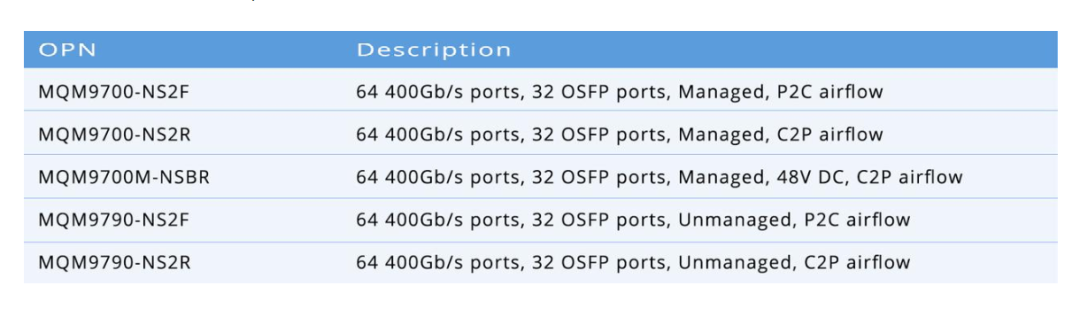

问:交换机、OFED和UFM所需的子网管理器数量有差异吗?哪个更适合客户部署?答:交换机管理适用于最多2K个节点的网络。UFM和OFED的openSM节点管理能力没有限制,但需要与管理节点的CPU和硬件处理能力协调。问:为什么一个具有64个400Gb端口的交换机只有32个OSFP端口?答:这个限制在于2U面板的尺寸和功耗限制,它只能容纳32个插槽。这个配置是为了支持两个400G端口的OSFP接口而设计的。在NDR交换机中,插槽和端口的概念是有区别的。问:是否可以使用线缆连接两个具有不同接口的模块来传输数据?例如,使用一根线缆将服务器上的OSFP端口连接到交换机上的QSFP112端口?答:模块的互连与封装是独立的。OSFP和QSFP112主要描述模块的物理尺寸。只要以太网介质类型相同(即,链路的两端都是400G-DR4或400G-FR4等),OSFP和QSFP112模块可以相互兼容。答:不可以,UFM仅支持InfiniBand网络。问:对于管理型和非管理型交换机,UFM的功能是否相同?问:IB线缆支持的最大传输距离是多少,会不会影响传输带宽和延迟?答:光模块+跳线可以达到大约500m,而无源高速线缆的范围约为3m,有源ACC线缆可达到5m。问:CX7网卡是否可以连接到其他支持以太网模式下RDMA的400G以太网交换机?答:可以建立400G以太网连接,并且RoCE可以在这种情况下工作,但性能不能保证。对于400G以太网,建议使用由BF3+Spectrum-4组成的Spectrum-X平台。问:NDR是否与HDR和EDR兼容,这些线缆和模块只有一种规格吗?答:是的,通常使用OSFP到2xQSFP56 DAC/AOC线缆以确保与HDR或EDR兼容。答:网卡配有散热器,所以可以直接使用厚模块。散热片模块主要用于液冷交换机端。答:可以启用RoCE,建议使用英伟达(NVIDIA) Spectrum-X解决方案。答:OSFP模块体积大、较重,使得光纤更容易受到损坏。一个两分支的线缆会有3个大型光模块端口,而一个四分支的线缆会有5个光模块端口。这增加了在安装过程中光纤断裂的风险,尤其是在30m的AOCs中。问:除了不同的光模块外,400G IB和400G以太网使用的线缆是否相同?答:线缆是相同的,但需要注意的是它们都是成8°角的APC类型。问:CX7网卡对延迟性能有特定要求吗?在优化的调试环境下,例如完全使用内存和绑定核心,网络延迟要求是多少?可接受的延迟值是多少,例如小于多少μs?答:延迟性能取决于测试机器的频率和配置,以及所使用的测试工具,如perftest和MPI。问:OSFP网卡端的模块应该是OSFP-平模块吗?为什么提到了OSFP-搭载散热器?答:UFM在服务器上独立运行,可以被视为一个节点。它支持使用2个服务器实现高可用性。但是,不建议在处理计算工作负载的节点上运行UFM。答:建议为所有InfiniBand网络配置UFM,因为UFM不仅提供openSM,还提供其他强大的管理和接口功能。问:PCIe 5只支持最高512G吗?PCIe 4呢?答:PCIe Gen5提供最高32G x 16通道,从而获得最大带宽512G。另一方面,PCIe Gen4提供最高16G x 16通道,提供最大带宽256G。答:IB网络卡都是双工的。单工或双工只是对当前设备的一个概念,因为发射和接收数据的物理通道已经分开。问:飞速(FS)能为建设IB网络集群提供技术支持和高质量产品吗?答:当然可以,飞速(FS)专注于提供高性能计算和数据中心解决方案。在构建IB网络集群方面,飞速(FS)拥有丰富的经验和专业知识,并提供多种连接方案,以满足不同客户的需求。3、配置 InfiniBand 和 RDMA 网络.pdf 6、面向分布式 AI智能网卡低延迟Fabric技术.pdf7、NVMe存储SPDK 加速前后端 IO.pdf8、基于RDMA多播机制的分布式持久性内存文件系统.pdf2023集成电路行业发展简析报告

“弈衡”通用大模型评测体系白皮书

2023手术机器人行业研究报告

安谋科技:2023年中国大陆集成电路产业人才供需报告

多模态大模型技术演进及研究框架

算力发展研究报告

网络大模型白皮书(2023)发布版

行业大模型标准体系及能力架构研究报告(2023)

智算中心发展创新指南(2023)

中国移动:面向AI大模型的智算中心网络演进白皮书(2023)

液冷数据中心白皮书:数据中心液冷革命,解锁未来的数字冰河

MIPS CPU处理器设计

X86、ARM和RISC-V CPU指令集架构科普

服务器CPU芯片:INTEL&AMD布局

《IDC 2023东数西算下新型算力基础设施合集》

1、东数西算下新型算力基础设施发展白皮书(2023)

2、国家“东数西算”工程下算力服务发展研究报告(2023)

云时代量子通信技术白皮书

精华:中国半导体白皮书

《英伟达H200技术合集》

1、英伟达推出全新H200,算力建设保持高景气

2、英伟达发布H200,面向生成式AI推理场景持续升级本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。