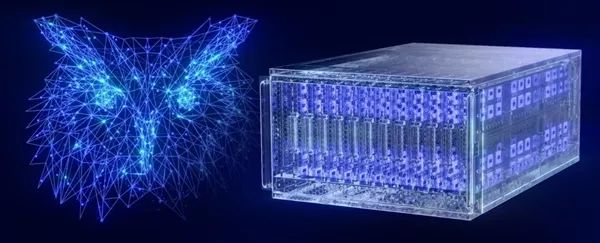

Intel正式发布了代号“Hala Point”的新一代大型神经拟态系统,用于类脑AI领域的前沿研究,提升AI的效率和可持续性。

该系统基于Intel Loihi 2神经拟态处理器,在上代大规模神经拟态研究系统“Pohoiki Springs”的基础上,进一步改进了架构,将神经元容量提高了10倍以上,达到史无前例的11.5亿个,大致相当于猫头鹰或卷尾猴的大脑皮层规模,性能也提高了多达12倍。

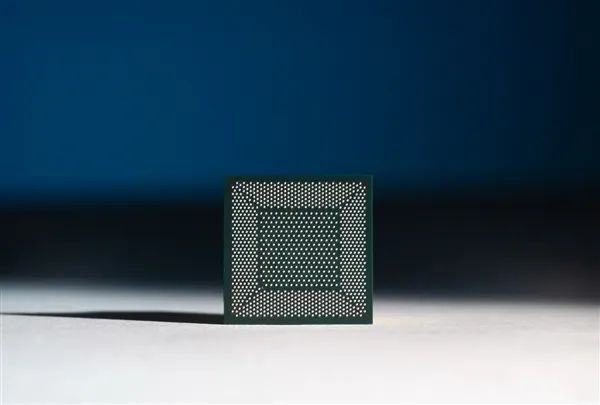

2018年1月,Intel发布了第一款能够进行自主学习的神经拟态芯片Loihi,可以像人类大脑一样,通过脉冲或尖峰传递信息,自动调节突触强度,通过环境中的各种反馈信息,进行自主学习、下达指令。

Loihi基于Intel 14nm工艺,核心面积60平方毫米,包含128个神经形态的核心(Neuromorphic Core)、三个低功耗x86核心,集成12.8万个神经元、1.28亿个触突,每个神经元有24个变量状态。

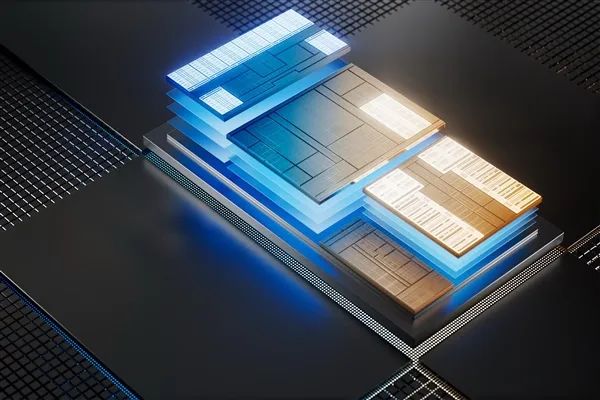

Loihi 2处理器发布于2021年10月,首发采用Intel 4工艺,集成230亿个晶体管、六个低功耗x86核心、128个神经形态核心,单颗就有100万个神经元、1.2亿个突触,是上代规模的8倍,性能也提升了10倍。

Loihi 2支持新型神经启发算法和应用,应用了众多类脑计算原理,如异步、基于事件的脉冲神经网络(SNN)、存算一体不断变化的稀疏连接,而且神经元之间能够直接通信,不需要绕过内存。

它还支持三因素学习规则、出色的突触(内部互连)压缩率,内部数据交换更快,并具备支持与内部突触相同类型压缩率的片外接口,可用于跨多个物理芯片扩展片上网状网络。

尤其是在新兴的小规模边缘工作负载上,它实现了效率、速度和适应性数量级的提升。

比如执行AI推理负载和处理优化问题时, Loihi 2的速度比常规CPU和GPU架构快多达50倍,能耗则只有百分之一。

Hala Point系统的形态是一个六机架的数据中心机箱,大小相当于一个微波炉,内置1152颗Loihi 2处理器,共有140544个神经形态处理内核、11.5亿个神经元、1280亿个突触,最大功耗仅为2600瓦。

系统内还有2300多颗嵌入式x86处理器,用于辅助计算。

内存带宽达16PB/s(16000TB/s),内核间通信带宽达3.5PB/s(3500TB/s),芯片间通信带宽达5TB/s,可以每秒处理超过380万亿次的8位突触运算、超过240万亿次的神经元运算。

Hala Point在主流AI工作负载上的计算效率非常出色,比如运行传统深度神经网络时,每秒可完成多达2万万亿次运算(20PFlops),8位运算的能效比达到了15TOPS/W(每瓦特15万亿次计算),相当于甚至超过了基于GPU、CPU的架构。

在用于仿生脉冲神经网络模型时,Hala Point能够以比人脑快20倍的实时速度,运行其全部11.5亿个神经元。

尤其是在运行神经元数量较低的情况下,它的速度甚至可比人脑快200倍!

早期研究结果表明,通过利用稀疏性高达10比1的稀疏连接和事件驱动的活动,Hala Point运行深度神经网络的能效比可高达15TOPS/W,同时无需对输入数据进行批处理。

Hala Point系统有望推动多领域AI应用的实时持续学习,比如科学研究、工程、物流、智能城市基础设施管理、大语言模型、AI助手等等。

另外,Intel已经在用AI辅助设计芯片了,效果还挺好。

Intel内部研发了一种新的AI增强工具,可以让系统级芯片设计师原本需要耗费6个星期才能完成的热敏传感器设计,缩短到区区几分钟。

在芯片电路设计中,工程师需要确定热感应器在CPU处理器中的安放位置,并判断热点容易出现的区域。

这是一个复杂的流程,需要进行各种测试,包括模拟工作负载、传感器位置优化等等,经常需要重新开始整个步骤,而且一次只能研究一两个工作负载。

Intel客户端计算事业部高级首席工程师、人工智能解决方案架构师Olena Zhu博士领衔增强智能团队开发的这款AI工具,可以帮助系统架构师将数千个变量纳入未来的芯片设计中,包括精确分析激活CPU核心、I/O和其他系统功能的复杂并发工作负载,从而精准地确定热点的位置,并放置对应的热敏传感器。

这款工具解决了这些需要靠推测进行的工作。工程师只需输入边界条件,它就可以处理数千个变量,几分钟内就返回理想的设计建议。

酷睿Ultra Meteor Lake处理器的设计工作就使用了该工具,未来的客户端处理器,比如将在今年晚些时候发布的Lunar Lake,以及后续产品,都会继续用它。

Intel客户端计算事业部高级首席工程师、人工智能解决方案架构师Olena Zhu博士

Intel客户端计算事业部增强智能团队的在AI方面的其他进展还有:

● 一个能快速识别关键热工作负荷的配套工具,通过大模型训练,可以预测尚未进行模拟或测量的其他工作负载。

● 对于高速I/O的快速准确信号完整性分析工具,设计时长从几个月缩短至1个小时。Intel是业界首个采用此技术的公司,已经为多代芯片的设计提供支持。

● 基于AI的自动故障分析工具,用于高速I/O设计,2020年就已部署,设计效率已提升60%。

● 增强型智能工具AI Assist,能够使用AI模型自动确定不同平台的定制超频值,将超频所需的准备时间从几天减少到1分钟。14代酷睿已提供该工具。

● 基于AI的自动化硅片版图设计优化器,已纳入Intel SoC设计流程。

● 一种智能采样工具,可以帮助动力和性能工程师处理智能设计实验,测试用例数量减少40%。

● 一种用户交互工具构建的AI模型,可以预测架构方案的性能,并帮助解决CPU设计的平衡问题。

● 一种自动放置微型电路板组件的新方式,将循环时间从几天缩短至几个小时。

Intel工程团队还利用内部开发的AI算法,成功将单个处理器的测试时间减少了50%。

Intel强调,尽管这些工具都非常有用,不会或者很少出现任何错误,但是增强智能在短期内并不会取代真正的工程师。

Intel增强智能团队成员Mark Gallina、Olena Zhu、Michael Frederick在俄勒冈州希尔斯伯勒的Intel客户端计算事业部实验室