在当前人工智能技术飞速发展的背景下,其在包括自然语言处理、计算机视觉、自动驾驶系统、虚拟助手服务、推荐算法以及医疗诊断在内的众多前沿应用中发挥着至关重要的作用。随着AI应用的不断深化与升级,数据中心基础设施必须应对日益严苛的要求,特别是对于低延迟、高吞吐量网络的需求愈发迫切,以确保能够高效处理复杂且数据密集型的工作负载。相关阅读:

InfiniBand,撼动不了以太网?

英伟达Quantum-2 Infiniband平台技术A&Q

一颗Jericho3-AI芯片,用来替代InfiniBand?

RoCE技术在HPC中的应用分析

3、配置 InfiniBand 和 RDMA 网络.pdf 6、面向分布式 AI智能网卡低延迟Fabric技术.pdf7、NVMe存储SPDK 加速前后端 IO.pdf8、基于RDMA多播机制的分布式持久性内存文件系统.pdfInfiniBand网络简介

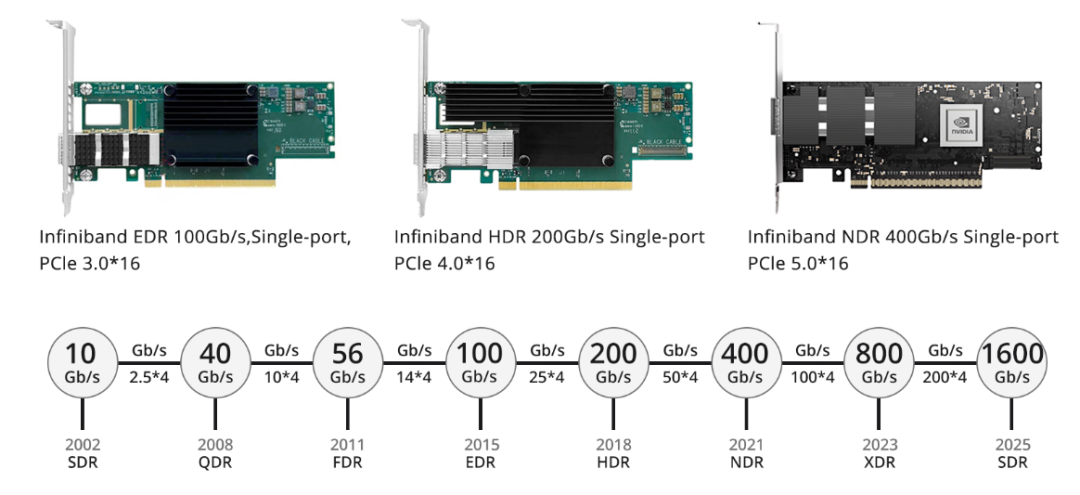

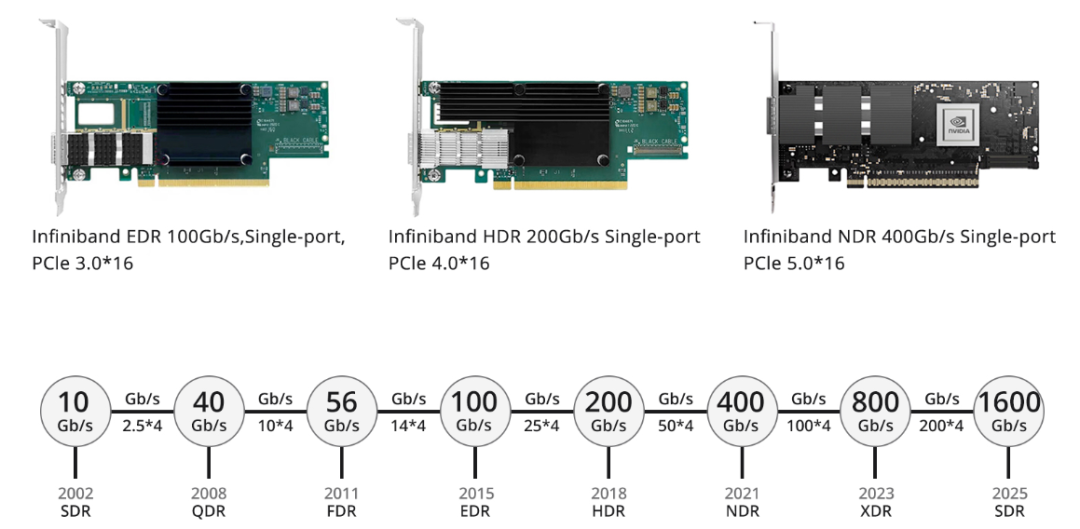

在AI数据中心中,InfiniBand网络凭借其卓越的性能和可靠性备受瞩目。该网络通过专门设计的InfiniBand适配器或交换机实现高效的数据传输,并由多个核心组件构成:子网管理器(SM)、InfiniBand网卡、InfiniBand交换设备以及专用的InfiniBand线缆与光模块。全球知名芯片制造商NVIDIA,在推动高性能计算和AI领域发展的同时,也成为了提供一系列InfiniBand网卡解决方案的主要力量。其中包括正在快速演进的200Gbps HDR技术及已大规模商业部署的400Gbps NDR网卡产品。此处展示的图表即为目前广泛应用的InfiniBand网络接口卡类型。.值得一提的是,InfiniBand交换机不运行传统路由协议,而是采用集中式管理机制,由子网管理器负责整个网络转发表的计算与分发工作,同时承担着配置InfiniBand子网内部特性的重要任务,例如分区策略和服务质量(QoS)。构建InfiniBand网络时,必须使用专为InfiniBand设计的电缆和光模块来确保交换机之间以及交换机与网卡之间的无缝连接。InfiniBand网络解决方案特性

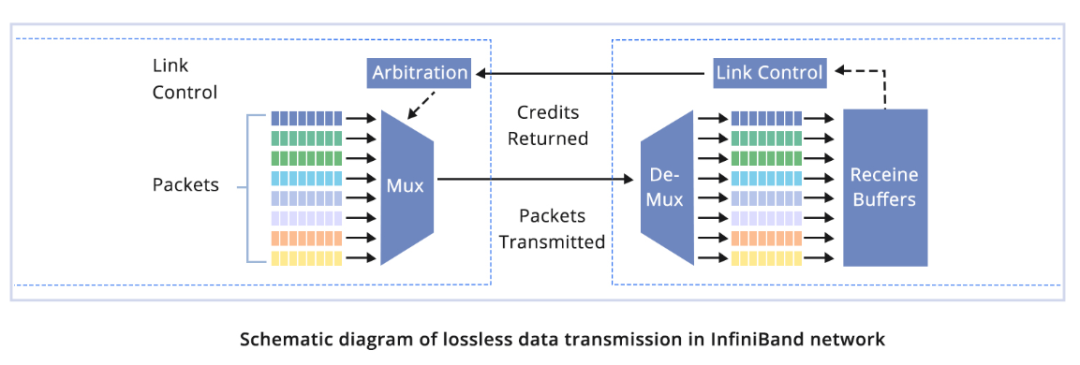

本征无损传输机制

InfiniBand网络创新性地采用了基于信用的信号控制策略,从底层设计上有效防止了缓冲区溢出和数据包丢失的问题。在数据发送前,发送端会确保接收端拥有充足的信用额度来处理相应数量的数据包。每条链路在InfiniBand架构中均预设了缓冲区,数据传输量严格受限于接收端当前可用的缓冲区容量。一旦接收端完成转发任务,即释放缓冲区,并实时更新并反馈当前剩余的缓冲区大小。这种链路级别的流量控制技术确保了发送端不会向网络中过度填充数据,从而有效地避免了因缓冲区满载而导致的数据包丢失。网卡扩展及自适应路由能力

InfiniBand网络还采用了先进的自适应路由技术,支持针对每个数据包进行动态路径选择,这使得在网络大规模部署时能充分利用资源,实现最优性能表现。例如,在百度AI云、微软Azure等大型云计算环境中,采用InfiniBand互联的GPU集群得到了广泛应用。市场主要供应商及其产品优势

目前市场上有多家主流供应商提供具备竞争力的InfiniBand网络解决方案及相关硬件设备,其中NVIDIA凭借超过70%的市场份额成为市场领导者。此外,其他重要的行业参与者包括:这些顶级供应商的产品与解决方案均根据不同的用户需求进行了精细化定制,并能够满足各种规模和应用场景下对InfiniBand网络的部署要求。RoCE v2网络技术概述

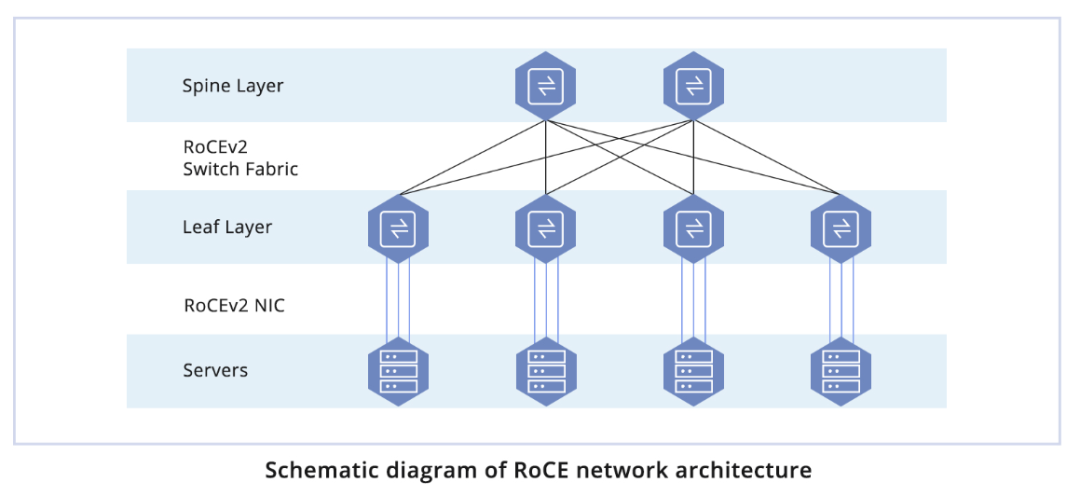

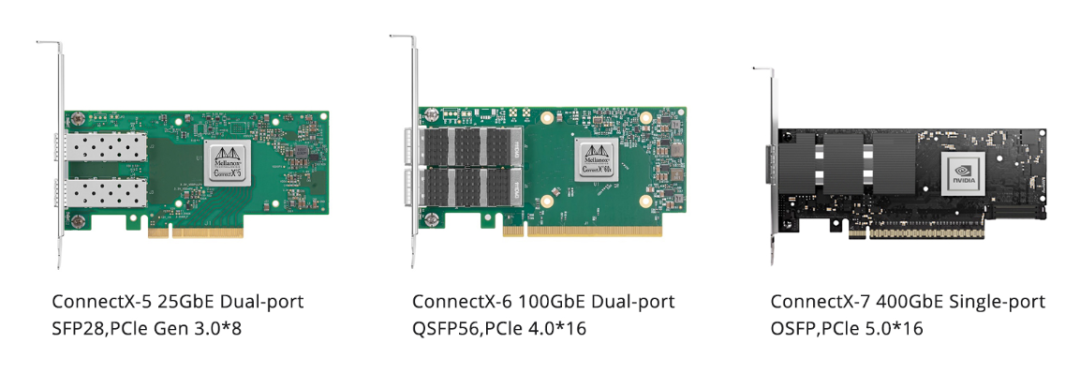

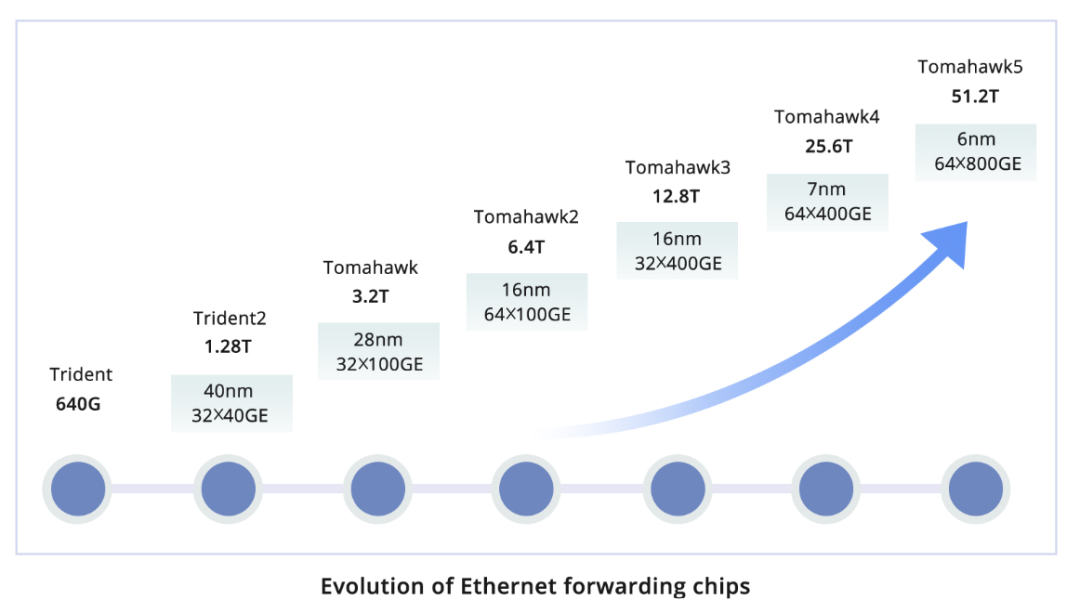

不同于依赖于集中式管理架构(如子网管理器SM)的InfiniBand网络,RoCE v2网络采用全分布式架构设计,并由具备RoCEv2功能的NIC(网络接口卡)和交换机共同构建,通常以两层架构部署在数据中心环境中。多家主流制造商已提供支持RoCE技术的网络适配器产品,其中NVIDIA、Intel和Broadcom是主要供应商。作为数据中心服务器网络适配器的主要形态,PCIe卡广泛应用其中。RDMA卡普遍配置有50Gbps起步的端口PHY速率,目前市面上可购买到的商用单端口网络适配器最高速度已达400Gbps级别。当前大部分数据中心交换机均已集成RDMA流控技术,在与RoCE网络适配器协同工作时,能够实现从发送端到接收端的高效RDMA通信。全球顶尖的数据中心交换机厂商,如Cisco、Hewlett Packard Enterprise(HPE)以及Arista等,均提供了高性能且稳定的数据中心解决方案,以满足大规模数据中心对带宽和性能的需求。这些公司在网络技术创新、性能优化及扩展性方面积累了深厚的专业经验,并在全球范围内赢得了广泛的市场认可和应用实践。高性能交换机的核心竞争力在于其采用的转发芯片。在当前市场中,Broadcom公司的Tomahawk系列芯片被广泛应用于商业交换机的转发层面。其中,Tomahawk3系列芯片在现役交换机市场上占据主导地位,而随着技术迭代升级,越来越多的新型交换机开始支持更先进的Tomahawk4系列芯片。RoCE v2基于以太网协议运行,因此可以充分利用传统的以太网光纤和光模块资源进行部署。ROCE v2网络技术特性解析

相比于InfiniBand,RoCE v2网络解决方案在灵活性和成本效益上展现出更多优势。该技术不仅能够构建高性能的RDMA(远程直接内存访问)网络环境,同时还能无缝融入传统以太网架构中。然而,在实际部署过程中,需要对交换机进行诸如Headroom预留、PFC(优先级流量控制)以及ECN(显式拥塞通知)等参数的精细配置,这可能会增加一定的实施复杂度。尤其是在大规模部署场景下,尤其是当涉及大量网络接口卡时,相较于InfiniBand网络,RoCE v2网络的整体吞吐性能可能略逊一筹。当前市场上,多家主流交换机供应商均支持RoCE协议,并提供了相应的解决方案。其中,NVIDIA推出的ConnectX系列网络适配器在与RoCE v2兼容性方面表现卓越,已在市场占有率上占据了显著地位。这意味着选择RoCE v2方案的企业能够在保持较高性价比的同时,享受到来自全球领先厂商的技术支持和服务保障。InfiniBand vs. RoCE v2

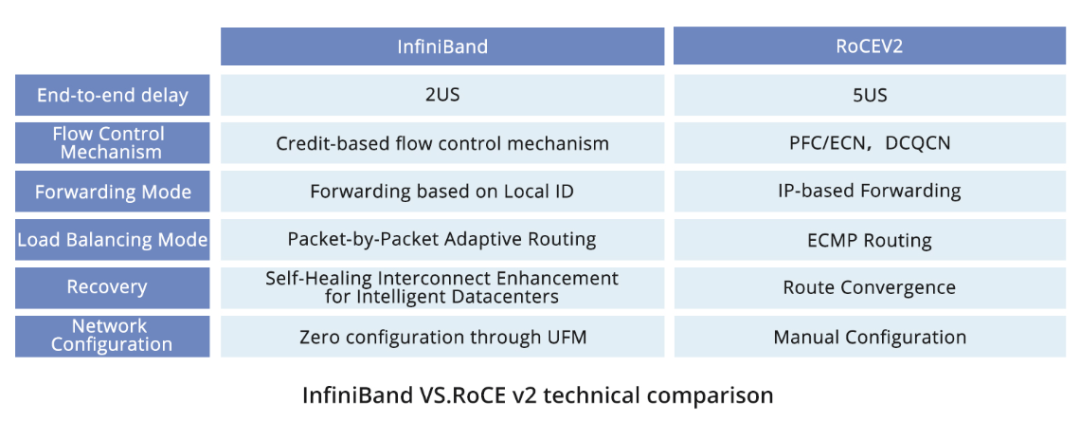

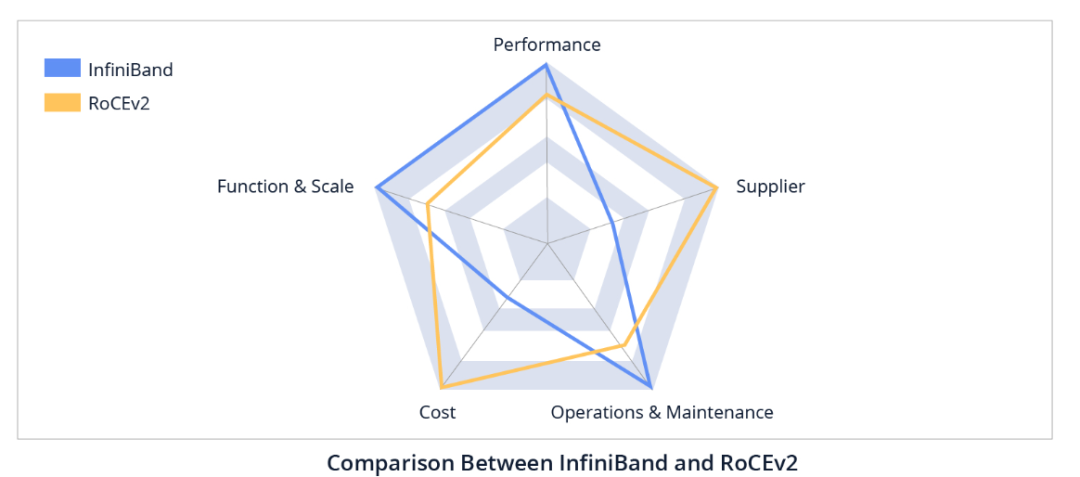

从技术层面剖析,InfiniBand通过整合多种创新技术手段,有效提升了网络数据转发效率、缩短了故障恢复时间、增强了网络扩展性,并简化了运维管理的复杂度。在实际应用中,RoCE v2作为一项高效解决方案,在满足大多数智能计算场景需求的同时,InfiniBand则凭借其在特定领域的卓越性能表现而备受瞩目。业务性能:InfiniBand因其较低的端到端延迟特性,在应用层面上能提供更优的业务性能体验。尽管如此,RoCE v2同样能够在大部分智能计算场景下达到用户所需的业务处理效能标准。业务规模:InfiniBand具备强大的扩展能力,能够支持数万个GPU卡构建集群,且在大规模部署下仍可保持性能稳定无损,已在业界拥有大量成功商业应用案例。而RoCE v2网络也不甘示弱,它能够支撑数千张卡构成的集群,并且整体网络性能并无显著下滑。业务运维:InfiniBand相较于RoCE v2更加成熟,提供了诸如多租户隔离及运维诊断等高级功能,为数据中心的运维管理带来了更高的便捷性和可控性。成本考量:InfiniBand的成本相对较高,主要原因在于其交换机设备的价格高于以太网交换机。关于供应商:NVIDIA作为InfiniBand的主要供应商,持续为市场提供优质的产品与服务;而在RoCE v2领域,则有多家供应商共同参与并提供支持,为用户提供了更多元化的选择空间。总结

近年来,数据中心网络技术发展的一个重要方向是简化网络架构设计、加快部署进程以及优化运维管理。通过采用如无编号BGP等创新技术方案,能够有效减少对复杂IP地址规划的依赖性,从而避免配置错误的发生,提升整体工作效率。与此同时,诸如WJH这类实时故障检测工具为网络运维带来了深度洞察力,极大地助力于快速定位和解决网络问题。随着数据中心基础设施向分布式和多数据中心互联模式演进,对于更高速率及更高品质网络连接的需求日益增长。为了满足不断提升的整体服务质量要求,市场呼唤更为高效且可靠的网络解决方案。文章来源:https://community.fs.com/cn/article/infiniband-vs-roce-how-to-choose-a-network-for-ai-data-center.html国产AI算力行业报告:浪潮汹涌,势不可挡(2024)2024中国“百模大战”竞争格局分析报告(2024)AI算力研究:英伟达B200再创算力奇迹,液冷、光模块持续革新

英伟达官宣新一代Blackwell架构,华为算力GPU需求破百万片GPU深度报告:英伟达GB200 NVL72全互联技术,铜缆方案或将成为未来趋势?英伟达发布新一代GPU架构,NVLink连接技术迭代升级

大模型语言模型:从理论到实践

技术展望2024:AI拐点,重塑人类潜力

大视研究:中国人工智能(AI)2024各行业应用研究报告英伟达GTC专题:新一代GPU、具身智能和AI应用

2024年策略:AI鼎新,与时偕行

《半导体行业深度报告合集(2024)》

《AI应用专题系列合集》

《70+篇半导体行业“研究框架”合集》

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。