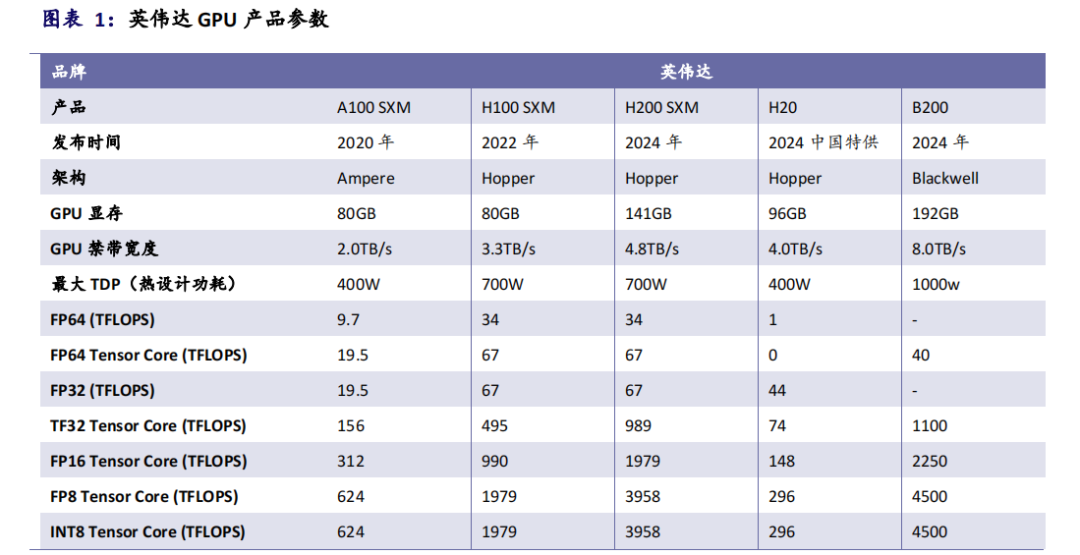

本文来自“《英伟达GTC 2024技术汇总》”。英伟达发布了新一代 Blackwell平台的 GPU(Graphics Processing Unit,图形处理器),包括 B200 和 GB200等产品系列。

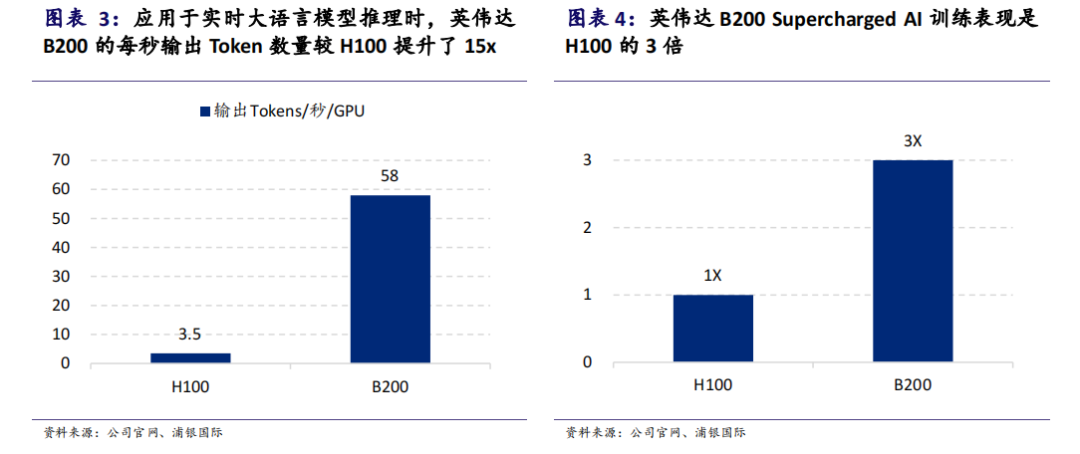

B200 由两个超大型裸片封装组合而成,内含超过 2080 个晶体管。这颗芯片还封装了 192GB 的高速 HBM3e 的显存。与前一代 H100相比,B200 的每秒输出 token 数量提升 15 倍,Supercharged AI 训练表现提升 3 倍。

下载链接:

《英伟达GTC 2024技术汇总》

1、英伟达GTC 2024主题演讲:见证AI的变革时刻 2、展望GTC变革,共享AI盛宴 3、英伟达GTC专题:新一代GPU、具身智能和AI应用

2024年策略:AI鼎新,与时偕行

人工智能生成图像的危害分析与网络真实性保护(2024)

《半导体行业深度报告合集(2024)》

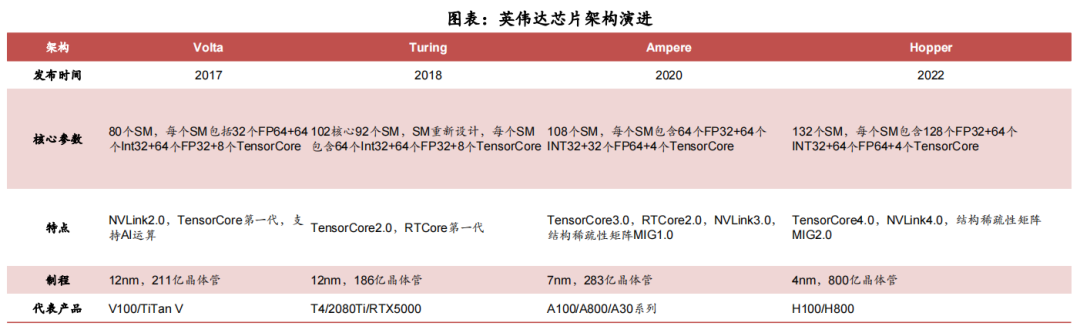

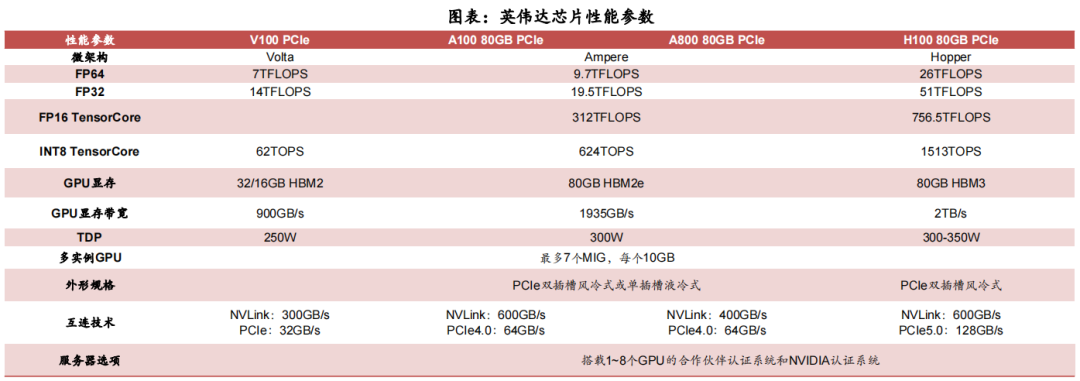

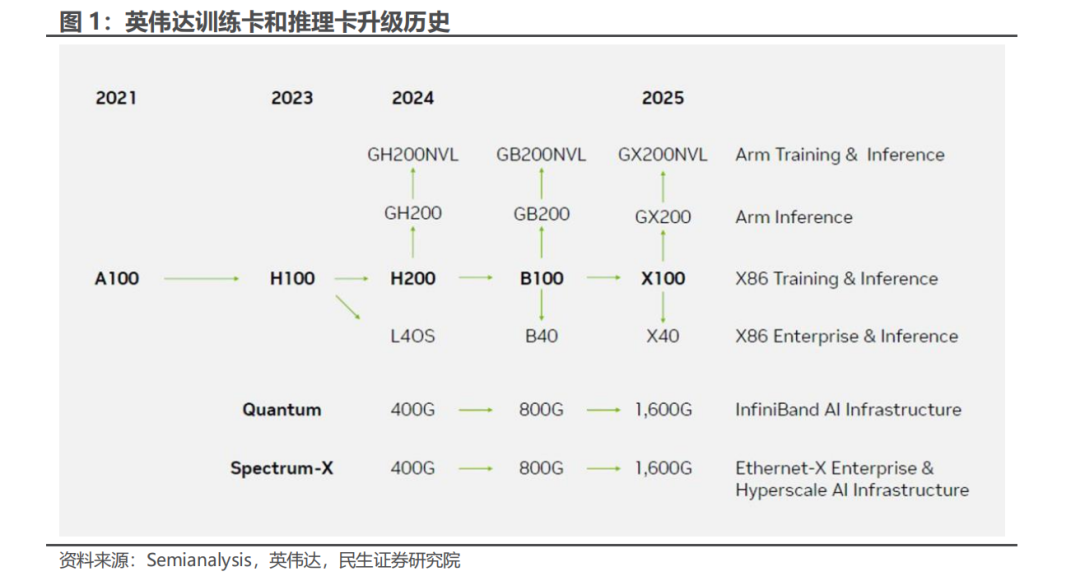

2017年提出Volta架构,专注深度学习和AI应用,并引入Tensor Core,2020年Ampere架构在计算能力、能效和深度学习性能方面大幅提升,采用多个SM和更大的总线宽度,提供更多CUDA Core及更高频率,引入第三代Tensor Core,具有更高的内存容量和带宽,适用于大规模数据处理和机器学习任务。2022年发布Hopper架构,支持第四代TensorCore,采用新型流式处理器,每个SM能力更强。

Blackwell或为英伟达首次采用多chiplet设计的架构,一方面可能简化基于Blackwell架构的GPU硅片层面生产,最大限度提高小型芯片产量,另一方面,多芯片封装将更加复杂。预计SM和CUDA将采用新结构,光线追踪性能等将进一步优化和加强,RT单元有可能被PT单元所取代,以实现对Ada Lovelace架构的性能翻倍。

Blackwell架构GPU很可能会支持GDDR7内存,相比GDDR6X效率更高,鉴于第一代 GDDR7 SGRAM IC将具有32GT/s 的传输数据速率,采用这些芯片的384位内存子系统将提供约1536 GB/s 的带宽。与Hopper/Ada架构不同,Blackwell或将扩展到数据中心和消费级GPU,但消费级场景或将延续单芯片设计,以实现时间可控及低风险。

英伟达作为基石算力硬件和工具提供商不断扩张其合作伙伴阵容,以巩固和扩大自身产品潜在空间的容量上限。在本次演讲中,英伟达宣布与多家重磅级公司合作,将新一代 Blackwell 的产品部署下去,包括美国的互联网巨头亚马逊的 AWS(Amazon Web Services)、谷歌的 GCP(Google Cloud Platform)、微软的Azure、甲骨文的自主数据库等。工业巨头西门子将其产品生命周期管理软件与英伟达的 Omniverse 相集成。

GB200是将CPU和GPU组合的超级芯片,GB200NVL是超级计算使用的互连平台。根据产业链信息,预计芯片包括1个Grace CPU和2个B100 GPU,内存为192GB HBM3e,CPU和GPU之间使用NVLink C2C连接,采用NVLink5.0,NVSwitch或将突破寻址限制,支持NVLink连接2500张GPU集群。

芯片功耗或达1200w,采用混合冷却,预计其中GPU/CPU/网卡/NVLink Switch ASICs使用液冷,其他组件使用风冷。

根据Bloomberg,英伟达可能在2026年推出下一代数据中心GPU N100,N100的GPU芯片数量可能由B100的2个增加到4个,每个芯片的尺寸相似,尽管GPU芯片总面积可能翻倍,性能跃进将更加显著。

N100预计采用台积电N3E工艺,晶体管密度或增加50%,芯片内存可能升级到全新一代HBM4。封装设计将同步升级以扩大芯片尺寸,可能加速热压缩键合(TCB)和混合键合技术应用。

《70+篇半导体行业“研究框架”合集》

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。