空间计算平台通过人、环境、空间计算设备的耦合实现更智能化的控制。空间计算平台以环境信息和用户意图为输入,以呈现给用户的虚拟信息和作用在真实空间物体的操作指令为输出,实现直接、复杂的反馈回路,人、环境、空间计算设备形成相互耦合的有机系统,提升智能化程度。

1.3.2. 计算机如何理解人?

1.1. 空间计算是什么?

如何理解空间:①人和计算机所处的物理空间;②计算机拥有的信息层面对应的虚拟空间

如何理解计算:①决定虚拟空间信息的呈现;②控制真实物理空间的物体

狭义的空间计算平台是一种虚拟现实(VR)、增强现实(AR)、混合现实(MR)以及更自然的人机交互界面,机器保留并处理真实空间和真实空间的物体。空间计算平台可以实现:①允许创建虚拟信息并且把他们投射到真实空间中(Virtual Space -->Real Space,AR );②允许用户把真实空间或者真实空间的物体数字化放进机器(Real Space -->Virtual Space,VR/MR )。空间计算将人所处的真实空间和计算机拥有的虚拟空间更好地融合,定义了一种人机交互新范式。

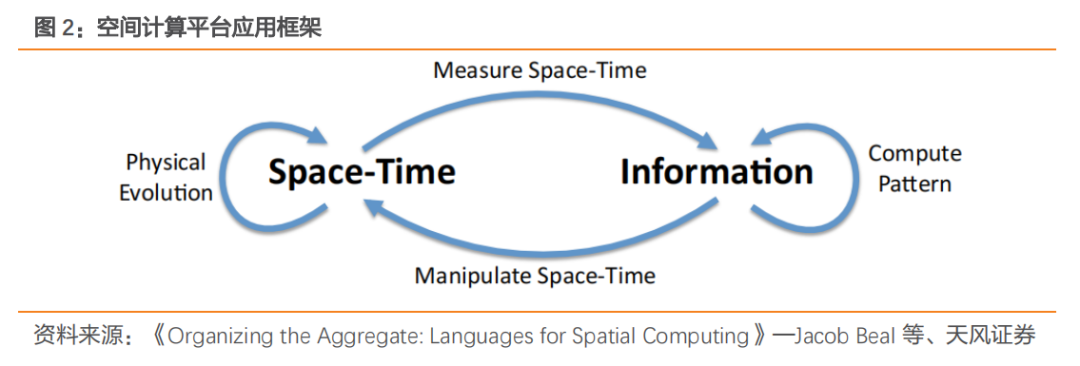

广义的空间计算平台是信息—环境耦合系统,通过所在环境与信息之间的耦合实现对于真实环境时空属性的控制。空间计算平台可以测量真实时空属性并将其转化为信息,对于获取到的时空信息进行信息层面的操作,根据计算机的指令对真实空间的物体进行操作控制改变时空属性。

空间计算平台可以实现的操作包括:

①测量时空属性(Measuring Space-time):获取时空属性并将其转换为信息,如测量距离、角度、持续时间、面积,密度和曲率等;

②操纵时空属性(Manipulating Space-time):获取信息并且改变时空属性,和时空属性测量互为逆过程,例如移动设备、改变曲率、局部扩展或收缩空间或改变局部物理特性;

③计算模式(Computing Pattern):在时间和空间上进行抽象的、信息层面上的操作,包括纯计算机计算方面的内容、不和物体直接接触的传感器(如声光传感器或 LED 元件)间的信息传递等环节;

④物理演化(Physical Evolution):真实空间物理系统的时空属性变化遵循客观规律,空间计算平台对于时空属性的程序控制需要考虑客观物理规律前提。

1.2. 为什么需要空间计算?

1.2.1. 空间计算,定义人机交互新范式

空间计算定义人机交互新范式,将机器中的空间(虚拟空间)和空间中的机器(物理空间)更好地联系在一起,让机器成为人生活工作中更全面的伙伴,我们认为:

1)解决计算设备物理空间和虚拟空间体积的冲突:将计算设备呈现的虚拟空间无限延伸;

2)提供更直观的显示和更自然的交互:

①显示:计算设备信息呈现,整体朝着更接近直观更贴近真实的方向演绎(文字→2D 图像的 2D 显示→3D 图像的 2D 显示),空间计算设备具有的 3D 图像的 3D 显示摆脱了原先 2D 平板屏幕的限制,提供更贴近真实更直观的信息呈现;

②交互:计算设备的人机交互方式整体朝着更自然的方式演绎(PC:键盘→鼠标→触控,手机:按键→触控),空间计算手动交互替代原先操作手柄控制可类比手机从按键到触控交互方式的转变,实现空间维度的人和虚拟信息零距离,眼动交互引领交互再升级,眼睛不仅可以被动接受信息的显示同时可以主动地控制信息的呈现,实现更为自然直接的人机交互;

3)实现虚拟空间和真实物理空间的融合:

①以二维平板屏幕作为主要呈现方式的传统计算设备(PC、智能手机等),受限于屏幕的二维显示,人和计算设备拥有的虚拟空间是分立的;

②以 Quest Pro 为代表的 VR 设备尽管拥有 Pass-through 功能,可以通过两个红外摄像头+1 个高分辨率的彩色摄像头合成三维视图,但是整体三维重建效果一般,视图扭曲且分辨率低,人和真实物理空间是分立的;

③以 Vision Pro 为代表的空间计算机通过三维显示实现虚拟空间的无限延伸,以及通过多传感器+摄像头+低延迟计算+高分辨率显示实现真实环境的实时重建,实现了虚拟空间和真实空间的融合;

4)创建更深层次的连接:

①通过将计算设备的使用者带到相同的虚拟空间创造和非同一物理空间的人的连接,实现跨越空间的紧密连接;

②空间计算平台可以拍摄 3D 立体的照片和视频,真实地重现回忆,还原感受,实现跨越时间的紧密连接。

1.2.2. 空间计算,开启万物智能新世界

空间计算广义范畴上是一种信息—环境耦合系统,以环境信息和用户意图为输入,以呈现给用户的虚拟信息和作用在真实空间物体的操作指令为输出,实现直接、复杂的反馈回路,人、环境、空间计算设备形成相互耦合的有机系统。

1.3. 空间计算关键要素—理解环境信息和用户意图

1.3.1. 计算机如何理解环境?

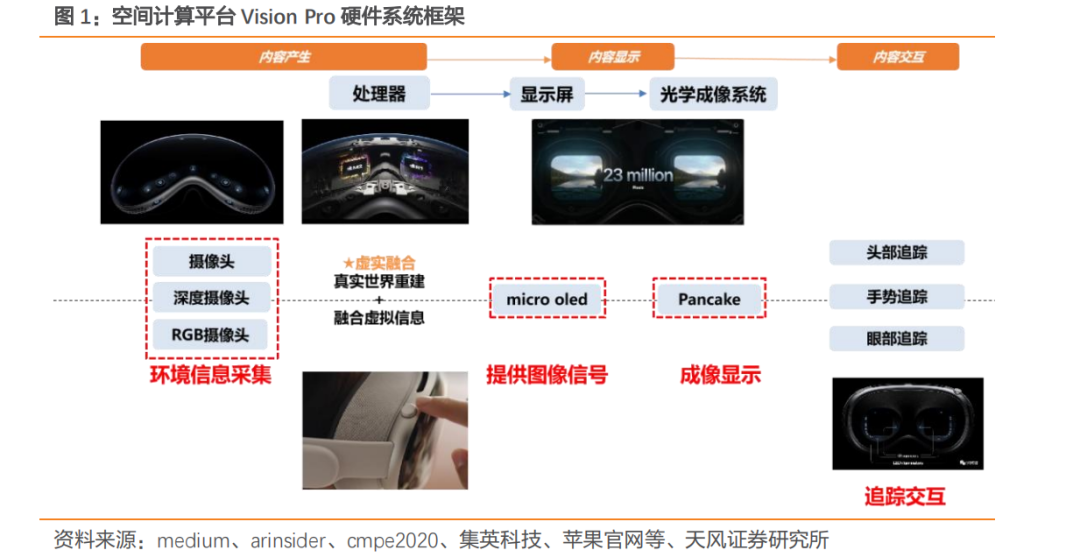

Vision Pro 通过大量摄像头传感器、专属 R1 芯片的应用实现低延时、高质量的环境信息感知和三维重建。感知:苹果通过 12 颗摄像头(2 颗注射 RGB 摄像头、4 颗下侧视角摄像头、2 颗外侧视角摄像头、4 颗内侧红外摄像头)+5 颗传感器(含 1 颗 dToF 传感器)对于真实环境信息感知充分,激光雷达传感器主要采用 ToF 原理,ToF 传感器三维重建技术具有数据采集频率高、垂直视场角大、可以直接提供几何信息等优点,可以提升真实环境重建效果;计算:Vision Pro 采用 M2+R1 双芯片设计,R1 芯片处理来自摄像头、传感器和麦克风的输入信息,可以在 12ms 内完成信息处理,比眨眼时间还要快 8 倍,低延时可以保证实时真实的环境重建,同时降低用户的晕动症。

真实环境的三维重建主要通过传感器获得环境信息,然后通过信息处理实现三维重建。

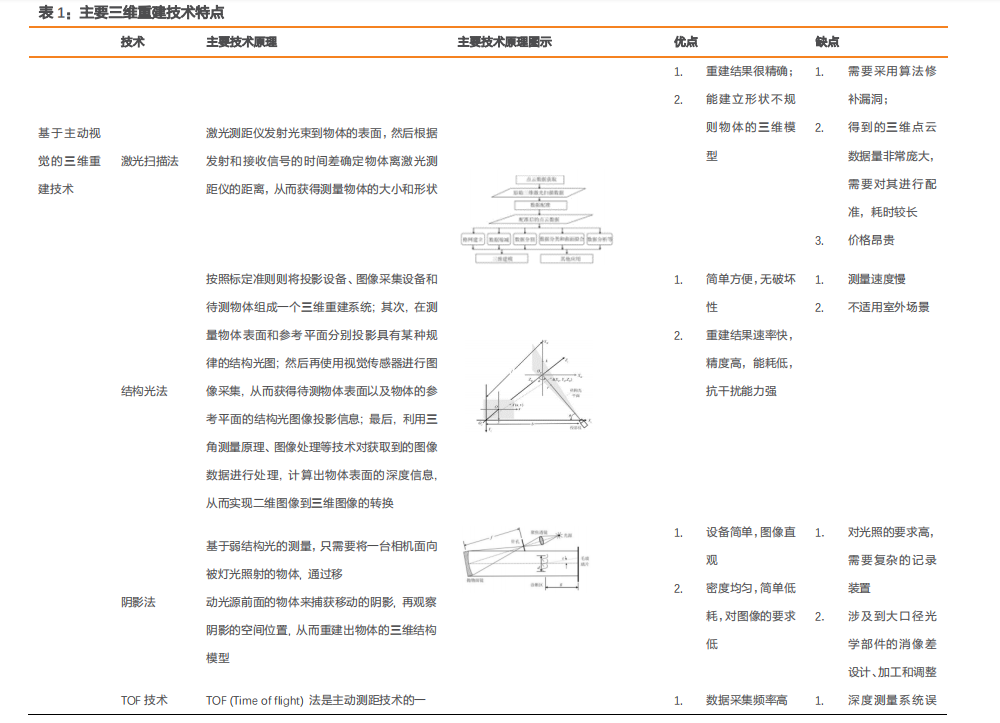

从环境信息的获取方式来看,三维重建技术分接触式和非接触式两种。接触式环境信息获取主要利用仪器触头直接碰触待测目标,如机械式的三坐标测量仪就是此类三维重建技术,非接触式环境信息获取通常被分为主动视觉和被动视觉两个类型,主动视觉主要通过特殊用特殊的光学仪器向视觉场景中投射特殊的结构光,然后通过检测这些投射光在目标表面的图像,或者计算回收反射信号的时间来进行深度信息获取的三维重建技术,被动视觉直接利用视觉传感器从客观外界获取相关信息,然后在相关约束条件下,通过信息处理算法计算出目标的三维坐标信息。

从三维重建算法来看,三维重建算法主要分为基于传统多视图几何和基于深度学习的三维重建算法:

①多视图几何法是描述同一场景从不同视角下获取的多幅图像与物体之间投影关系的几何模型, 多视图几何理论把在数学中的推导引入到计算机视觉中, 主要包括射影变换、小孔成像以及捆绑调整等的推导, 为图像的三维重建提供了理论依据。通常, 多视图几何法研究内容主要包括不同层次的射影变换(两层摄影变换、三层射影变换等)、摄像机模型中的内外参数的求取、三维坐标计算等, 该方法还涉及一些三维重建中基本的数学公式表达, 例如, 基础矩阵、本质矩阵和 N 视点关系等;

②基于深度学习的三维重建算法,14 年开始 Eigen 团队第一次使用卷积神经网络(CNN)用于三维重建,三维重建领域的深度学习应用迅速发展,在数据处理、几何推断、结构推理、语义理解等多个层次为三维重建带来深刻变革。

1.3.2. 计算机如何理解人?

Vision Pro 眼动交互可以通过目光瞄准和手势确认的方式控制远处物体,也可以通过目光瞄准的方式实现输入交互。

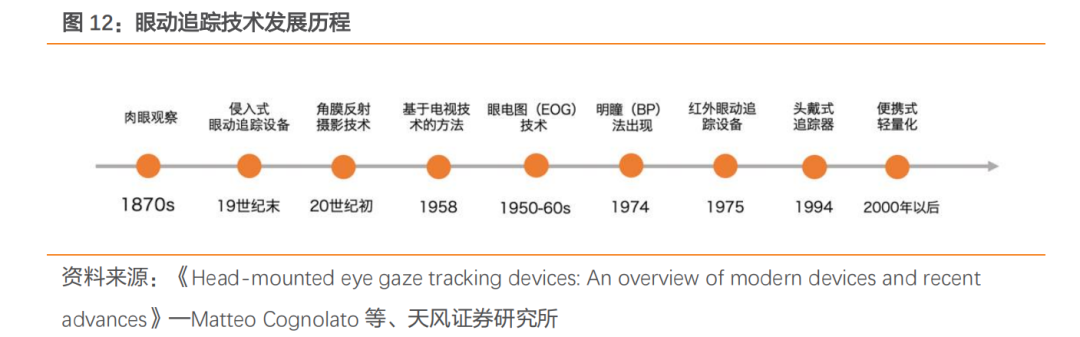

眼球追踪技术目前有多种技术路线,包括基于 IR 的瞳孔角膜反射法、基于 MEMS 的扫描方案、基于 DVS 的瞳孔角膜反射法、直接图像处理方案等。

瞳孔角膜发射法的基本原理是:①使用红外线照射眼睛;②使用摄像机采集从角膜和视网膜上反射的红外光线;③由于眼球的生理结构和物理性质,在光源和头部相对位置不变的前提下,角膜反射形成的光斑不会移动而视网膜上反射的光线方向标示了瞳孔的朝向;④根据角膜与瞳孔反射光线之间的角度可以计算出眼动的方向。

苹果收购了德国眼动追踪公司 SensorMotoric Instruments(SMI)布局眼动追踪技术。SMI 是一家成立于 1991 年的企业,专注于眼动追踪这一领域产品的开发。在被苹果公司收购之前,该公司已经为多个公司提供眼动追踪系统,其中包括可集成在三星 GearVR 中的眼动追踪系统、HTC Vive 中的眼动追踪设备等。

下载链接:

电子行业研究:什么是空间计算平台?

电子行业研究框架(2023)

《人工智能大模型专题研究合集》

1、人工智能专题研究(1):大模型推动各行业AI应用渗透

2、人工智能专题研究(2):AI大模型打开AI芯片、光模块和光芯片需求

《AI专题研究报告合集》

1、AI系列专题研究报告:台股AI服务器启示录(2023)

2、AI专题研究报告:AI算力研究框架(2023)

智算中心网络架构白皮书(2023)

华为产业链深度系列研究合集(2023)

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。

温馨提示:

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。