芝能智芯出品

花旗银行发布了一份报告主要围绕AMD和Nvidia在人工智能(AI)领域的GPU产品之间的价格差异,尤其是AMD的Instinct MI300X和Nvidia的H100 GPU。

花旗银行认为Nvidia的H100 GPU的定价是AMD Instinct MI300X的四倍之多,突显了Nvidia在GPU短缺时的令人难以置信的定价能力。

AMD以每台约10,000美元的价格向微软出售其Instinct MI300X 192GB,估计其他客户购买Instinct MI300X GPU的价格约为15,000美元,AMD在人工智能领域试图以相对较低的价格吸引客户的战略。

Nvidia H100 GPU和AMD MI300X的价格差异

Nvidia的H100 GPU由于其持续的短缺问题,其定价高达40,000美元以上,是AMD Instinct MI300X的四倍之多。H100 GPU的高价主要得益于Nvidia在CUDA软件堆栈上的优化,使其成为大量人工智能应用程序和工作负载的首选选择。

AMD MI300X的预期收益

AMD已经开始出货用于人工智能(AI)和高性能计算(HPC)的Instinct MI300X计算卡,Instinct MI300X已经投入企业级大型语言模型(LLM)的运行。AMD的Instinct MI300系列产品在短时间内已达到10亿美元的销售额,成为其历史上销售最快的产品,也向英伟达在人工智能芯片领域的主导地位发起了挑战。

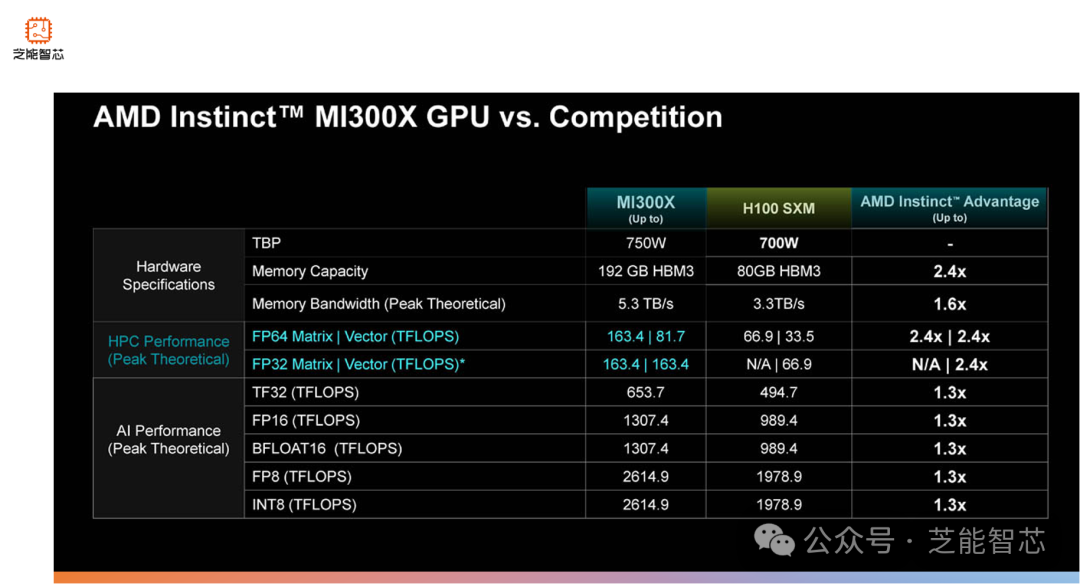

Instinct MI300X采用了小芯片设计,结合了5nm和6nm工艺,拥有1530亿个晶体管。其配备第四代Infinity Fabric解决方案,包含28个模块芯片,其中包括8个HBM(High Bandwidth Memory)和4个计算芯片。每个计算芯片有2个基于CDNA 3架构的GCD(Graphics Compute Die),共80个计算单元,合计320个计算单元和20480个流处理器。由于考虑到良品率,AMD削减了部分计算单元,实际使用数量为304个计算单元和19456个流处理器。此外,Instinct MI300X的HBM3容量为192GB,提供了5.3TB/s的内存带宽和896GB/s的Infinity Fabric带宽。另一款产品Instinct MI300A采用APU设计,拥有24个基于Zen 4架构的内核,计算单元数量减至228个,对应14592个流处理器。

两家公司在GPU市场采用了不同的定价策略。Nvidia凭借其CUDA软件堆栈的优势,以高价销售其产品,而AMD则试图通过以较低的价格提供具有竞争力的解决方案来吸引客户,市场对Nvidia的需求较大,使其能够实现巨额溢价。花旗分析师预计,AMD Instinct MI300系列GPU的销售额将超过35亿美元,而AMD表示仍有部分供应。Nvidia面临着长达52周的等待时间的传闻。花旗分析师认为AMD在数据中心GPU上的销售额被低估,估计今年可能达到50亿美元,到2025年将达到80亿美元。

● 谷歌和微软是最大的客户之一,而LaminiAI是首家确认已在使用Instinct MI300X计算卡的公司。

● 马斯克宣布计划在处理人工智能的计算硬件方面加大投入,预计将从AMD购买芯片,作为其超过5亿美元硬件支出计划的一部分,AMD的新推出的Instinct MI300系列产品可能成为其首选之一。

● META和OpenAI在一次会议上表示,将采用AMD最新的AI芯片Instinct MI300X。

这也能反映出来,科技公司正在寻找替代英伟达GPU的解决方案,尤其是对于部署类似OpenAI的ChatGPT等人工智能程序。

小结