陈巍谈芯:产业巨头已经打通存算一体技术的落地通道,存算一体技术加快应用部署。与未使用HBM-PIM(HBM-PIM GPU v.s. HBM GPU)相比,仅用20nm工艺就使7nm集群计算性能提升了2.5倍。

下载链接:

CPU技术及产业技术:分类与产业篇

GPU:AI服务器关键技术及核心

《自动驾驶芯片研究专题》

1、自动驾驶芯片研究框架(2023) 2、车载计算平台标准化需求研究报告 3、智驾芯片群雄并起,自动驾驶方兴未艾 4、智能驾驶之芯片和软件领域梳理 5、自动驾驶芯片行业研究报告

三星电子于 12 月 12 日宣布,他们开发了世界上第一个基于数字存内处理 (PIM,也可称存内计算或存算一体) 芯片(HBM-PIM)的GPU的大规模计算系统。

三星电子高等技术研究院人工智能研究中心副主任崔昌圭(Choi Chang-kyu)在由三星电子主办的2022人工智能(AI)半导体未来技术大会上通过主题演讲披露了新计算技术的发展。他们通过组合来自AMD的96个GPU(MI100)构建了一个大型计算系统,每个GPU都加载了一个HBM-PIM芯片,并成功展示了存内处理 (PIM) 芯片的性能。这是一种存算一体技术,可以显著减少数据在CPU 和 DRAM 之间移动的频度并提升性能。

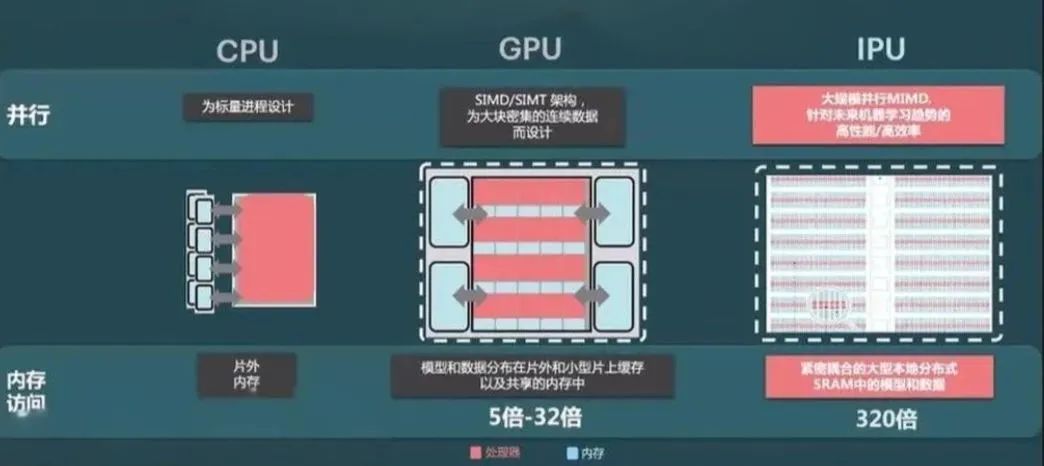

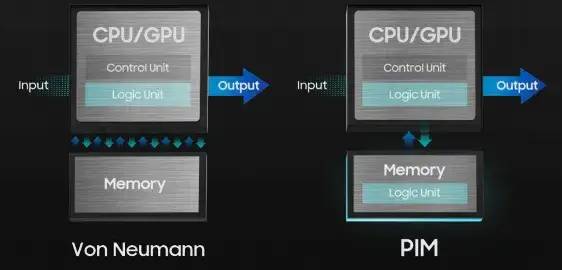

存算一体技术超越传统冯诺依曼架构

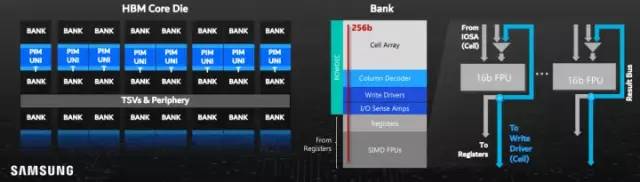

PIM 是指将计算单元与随机存取存储器 (DRAM) 集成在单个芯片上。这项技术有望有助于提高庞大的人工智能 (AI) 的性能。三星使了严格意义上的芯片内数字近存计算来提升AI计算性能。三星 HBM-PIM 芯片与其他公司 HBM 实现的不同之处在于,PIM 芯片上的每个存储块内都包含一个内部处理单元。

三星HBM-PIM阵列架构

基于存算一体技术的20nm HBM-PIM(DRAM工艺)使得7nm GPU性能增强2.5倍

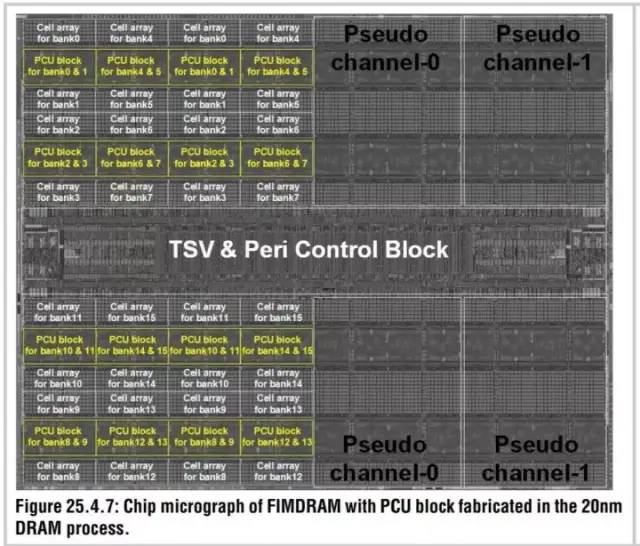

根据三星去年在ISSCC发布的学术文章信息披露,该HBM-PIM使用的是三星的20nm DRAM工艺。负责计算的PCU与DRAM 阵列在同一个晶圆平面内,显著性能提升主要来自存算一体技术而非3D 堆叠封装。仅用20nm工艺的PCU进行简单的逻辑计算(DRAM工艺做逻辑计算其实不划算,外周的逻辑晶体管的实际栅长在32nm附近),就使得7nm工艺GPU集群的性能提升到2.5倍。

三星电子使用该系统训练语言模型算法T5(Text-to-Test Transfer Transformer)时,与未使用PIM时相比,性能提升了2.5倍,功耗降低了2.67倍。与仅配备 HBM 的 GPU 加速器相比,配备 HBM-PIM 的 GPU 加速器一年的能耗下降了约 2,100 GWh。三星表示,其 PIM 技术将对能源消耗和环境具有重大影响,可将集群的年能源使用量减少,相当于减少 960,000 吨碳排放。

三星HBM-PIM架构图

三星开发的另一个方向是使用 CXL(Compute Express Link)开放标准,用于高速处理器到设备和处理器到内存的接口,从而可以更有效地使用与处理器一起使用的内存和加速器。

CXL 可以与其他技术结合使用,例如 Processing-near-Memory (PNM),以帮助促进内存容量扩展。

与 PIM 一样,它通过使用内存进行数据计算来减少 CPU 和内存之间的数据移动。在 PNM 的情况下,计算功能在更靠近内存的地方执行,以减少 CPU 和内存数据传输之间发生的瓶颈。

三星本月早些时候推出了带有 CXL 的 PNM 技术,用于高容量 AI 模型处理。在测试中,基于 CXL 接口的 PNM 系统在推荐系统或需要高内存带宽的内存数据库等应用中性能翻倍。