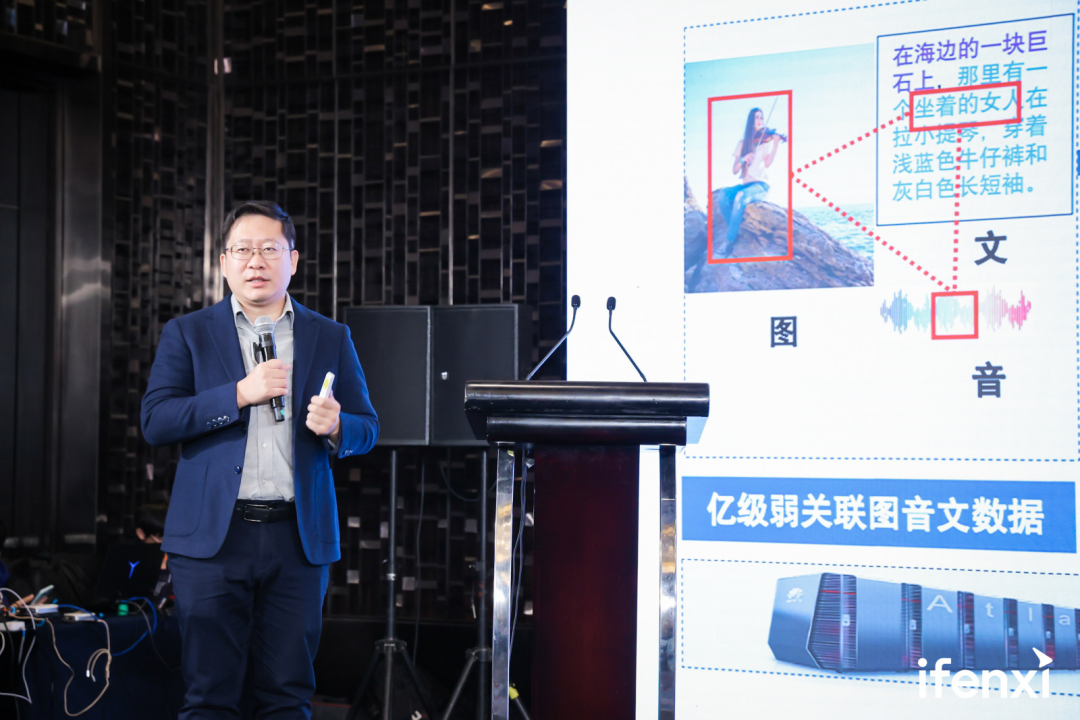

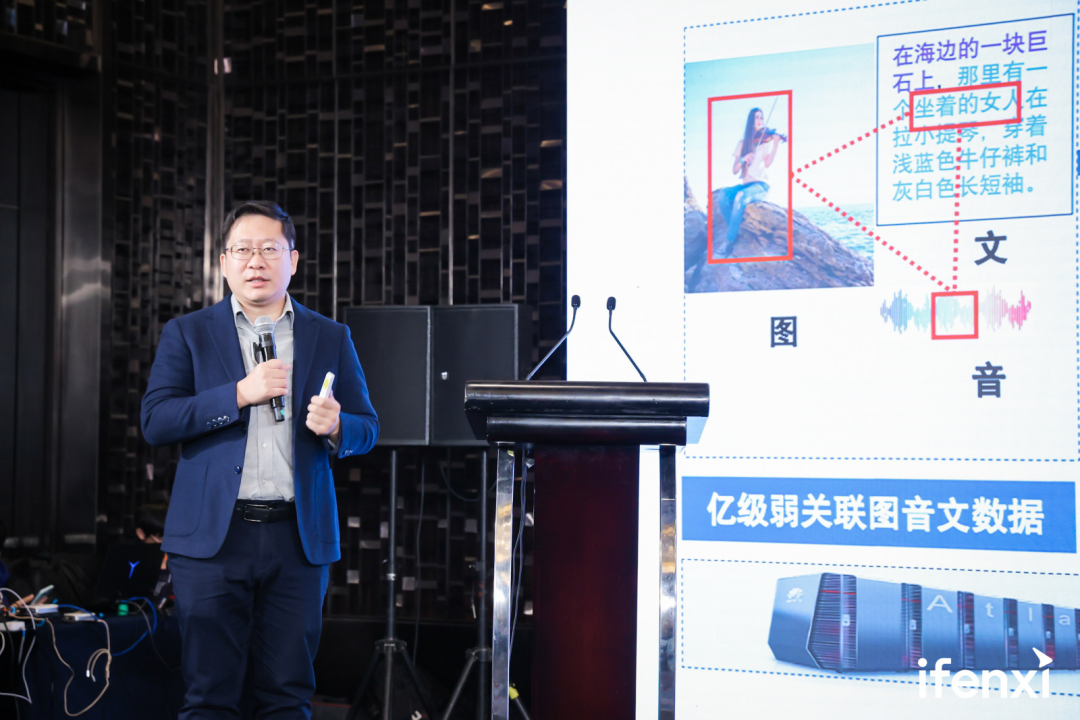

1 月 9 日,爱分析成功举办 2024 爱分析·AI与大模型高峰论坛,邀请了各领域的专家学者、企业代表、大模型厂商和实践专家,分享前沿的技术进展和领先企业内的落地场景与实践经验。分享嘉宾|王金桥 中国科学院自动化所研究所副总工程师、武汉人工智能研究院院长

内容已做精简,如需和专家交流&获取专家完整版视频实录,请扫码。

过去十年的人工智能,我们称为是专用智能,就是用大数据训练一个小模型,解决单一的任务。

专用智能有三个问题,第一是泛化能力差,这个场景能识别目标,换个场景就识别不了;第二是智能性差,只能做一些感知任务,例如识别人脸,识别语音,识别物体;第三是通用性差,一个模型只能做一个任务,导致整个人工智能的应用非常的碎片化,每个场景都要很多人采集大量的数据标注训练,在监督学习的范式下做人工智能的落地,就遇到了巨大的一个挑战:难以实现商业的闭环。所以大家都开始做“大数据+大模型+大算力”,训练类人一样通用性的模型,相当于一个模型做多个任务,无论是感知、认知、推理、决策。Open AI 在2023 年收入超过 16 亿美金, Open AI 和竞品的一些实践,也证明整个大模型是能够实现商业闭环,而且一个模型可以做多个任务。所以现在大家的各个场景都在全面的拥抱大模型,现在大模型和各个场景结合,也是整个人工智能落地的一个非常好的前景。从 2022 年的语言模型,现在逐步演进到多模态,因为多模态的思考方式才更像我们人一样感知、认知、和环境进行交互、学会使用工具。同时它的成长也是随着年龄一直到 14 岁,基本上它的智力进化相对是一个比较持续完善的过程,而且还有人看不到的一些信号理解。整个的大模型也是从大语言模型到多模态,像多模态交互以及多模态的智能体,到群体智能这是整个大模型的技术路径。当然我们也一直在这方面做了很多的工作,特别是在我们自动化所在 2020 年成立了全国第一个大模型研究中心,把视觉团队、语言团队还有语音团队合并成了一个团队。自动化所是国内在人工智能领域最早的模式识别国家重点实验室,它在人工智能的每个细分领域都有非常多的团队,所以在合并之后就专门成立了这个中心来做大模型的攻关,全面进入自监督学习加微调的新范式。 一直到 2021 年我们发布了业内第一个多模态的大模型“紫东太初”,用了大概9亿的弱相关数据,模型自监督的学习自身的知识,这是我们提出的第一个跨模态自监督学习的范式。在 2023 年的 6 月发布了 2.0 的版本。1.0 开发最早是聚焦在异构数据的图像、文本、语音的多模态自监督学习。希望图像的每个区域,能对应语言的每个词或者是每个 token 做弱的对应和对齐,在词语级别以及它模态级别的对齐后,随便的遮盖掉任何一个模态、或者任何一个字、或者任一个语音片段、图像的任何一个区域,就能实现跨模态的自监督,这就是能够实现海量的知识的学习,以及潜在关系的学习。例如我们所看到的“岩石”“海”“女人”“牛仔裤”“脚”“提琴”它们之间空间知识的关系,大模型会形成隐式知识的表示。最早期实现的跨模态生成,是不同模态之间自动的转换,这是 1.0 的版本。在 2.0 阶段进一步的把人看不到的信息,像雷达、红外、各种各样的光谱,把这些信息都融合到框架里。当然我们发现在框架里,不是所有的数据都能弱相关,特别是红外的数据和三维点云的数据,往往它对齐的是图像空间,我们叫做分组对齐,在分组对齐的过程中,将各种多模态的数据混排。我们一直探索的、最重要的大模型基石就是 Transformer 的结构。在刚才的跨模态对齐中,固定化的划分模块或者 token ,很难实现语义结构的完整性,所以更重要的是如何去更好的捕获更有表述力和特征的区域。在这里我们提出了可变形的 Transformer 模块。这个模块一定是语义敏感的区域,通过多头的注意力机制,每个模块的尺寸是不固定的,叫做可变形的。这就是类似在机器学习 HOG 特征对应一个可变形 HOG ,这样随着模块可变形的空间,就能更好的捕获语言语义、图像、视频、音频的动态区域大小,捕获更精准的语义。同时在多模态的序列对齐里,把图像看成小作文,把它展成多模态的不同大小的框,或者每个区域把它展成序列,通过图像序列和语言标签序列,把每个框的坐标也作为序列的输出,就形成序列的多任务对齐方式。这就是在解决不同模态、不同场景的数据之间,多任务自回归的序列。这样的回归机制,就可以保证自回归损失和重构的损失,收敛的速度更快一些。

一直到 2021 年我们发布了业内第一个多模态的大模型“紫东太初”,用了大概9亿的弱相关数据,模型自监督的学习自身的知识,这是我们提出的第一个跨模态自监督学习的范式。在 2023 年的 6 月发布了 2.0 的版本。1.0 开发最早是聚焦在异构数据的图像、文本、语音的多模态自监督学习。希望图像的每个区域,能对应语言的每个词或者是每个 token 做弱的对应和对齐,在词语级别以及它模态级别的对齐后,随便的遮盖掉任何一个模态、或者任何一个字、或者任一个语音片段、图像的任何一个区域,就能实现跨模态的自监督,这就是能够实现海量的知识的学习,以及潜在关系的学习。例如我们所看到的“岩石”“海”“女人”“牛仔裤”“脚”“提琴”它们之间空间知识的关系,大模型会形成隐式知识的表示。最早期实现的跨模态生成,是不同模态之间自动的转换,这是 1.0 的版本。在 2.0 阶段进一步的把人看不到的信息,像雷达、红外、各种各样的光谱,把这些信息都融合到框架里。当然我们发现在框架里,不是所有的数据都能弱相关,特别是红外的数据和三维点云的数据,往往它对齐的是图像空间,我们叫做分组对齐,在分组对齐的过程中,将各种多模态的数据混排。我们一直探索的、最重要的大模型基石就是 Transformer 的结构。在刚才的跨模态对齐中,固定化的划分模块或者 token ,很难实现语义结构的完整性,所以更重要的是如何去更好的捕获更有表述力和特征的区域。在这里我们提出了可变形的 Transformer 模块。这个模块一定是语义敏感的区域,通过多头的注意力机制,每个模块的尺寸是不固定的,叫做可变形的。这就是类似在机器学习 HOG 特征对应一个可变形 HOG ,这样随着模块可变形的空间,就能更好的捕获语言语义、图像、视频、音频的动态区域大小,捕获更精准的语义。同时在多模态的序列对齐里,把图像看成小作文,把它展成多模态的不同大小的框,或者每个区域把它展成序列,通过图像序列和语言标签序列,把每个框的坐标也作为序列的输出,就形成序列的多任务对齐方式。这就是在解决不同模态、不同场景的数据之间,多任务自回归的序列。这样的回归机制,就可以保证自回归损失和重构的损失,收敛的速度更快一些。 同时在细粒度的表示中,除了有框的表示,在视觉的任务中,多个任务都可以用一种表示,就是像素级的表示,既可以画框,也可以画轮廓,也可以给它做一些分割。另外还可以根据用户的需求,分割的力度不一样,这样就形成了基于提示的对象提取,把对标 Meta 的 SAM 模型,引入全实力分割的检测头的 Fast SAM 方法,让分割任务的性能跟 Meta 的 SAM 性能相当,同时处理的速度提高了 50 倍,全面的实现在视觉任务上,支持多尺度、多粒度的目标提取,实现了在多模态对齐里,能够支撑各种各样的任务输出。同时现在大模型的小型化也是非常主流的一个趋势。我们现在这方面做了很多的工作,第一是在大模型的高效训练上,第二是在推理上。通过通道的系数化和空间的系数化,使 token 建立共享的机制,从而保证推理的参数直接能降低 35% 。同时在训练的过程中,也用了各种各样的并行策略,以及混合精度的策略,把各种各样的算子融合、替代和加速,使效果能够实现高速的训练。最典型的一个方法,叫做基于波动性度量的高效模型剪枝。在做大模型落地的过程,比如金融的场景中,发现用一个 6B 的模型在做推理的时候,度量每个权重会发现有 50% 的权重基本上是不变的,就类似大模型做能力分区。例如在人做某一项专业任务的时候,其他的神经元很多都不激活,它的参数、权重是不怎么变的,所以就直接把参数记录下来,算过的数就不算了,这样直接使它参数量降低 50% ,推理速度提高 66% ,这是目前最简单粗暴的一个剪枝方法。只要看一下哪些权重是不变的,把它固定下来。这样的效率是可以用到任何一个模型结构里,都能达到高效的推理。特别在手机端,不同的任务可以激活不同的权重,就实现了基于多模态的任务,可以进行图文并茂的任意回答。例如你让他把这个胡萝卜框出来,他就给你框出来,你让他的画框、检测关键点、分割,都可以实现多任务的推理和高效的输出。也可以给它一个三维的点云,同样它能输出有多少个房间,现在在跟设计公司,做一些设计、装修,通过 AI 的自动化三维设计,能够使它的效果跟人做对齐。现在人工智能的感知能力、逻辑、推理、解题都取得了巨大的进步,但是仍然存在的一些问题。第一是幻觉,要外挂知识库;第二是自主进化,我们只知道 GPT 4 只到 2023 年 4 月份,后面就不知道了。如何通过搜索增强,以及让最新的数据喂进去,也不遗忘以前的数据,同时保持新的数据学习。这就是它的泛化能力和自学能力提出更高的要求。另一方面大模型能够借助工具通过 agent 能够更好的与环境进行交互,通过单源的场景,从语言场景到多模态,再到真正的融入生活中,通过各种各样 agent 的信息消化,实现认知世界到融入环境的跨越,这也是整个大模型生成归纳新概念的能力。现在AI 在各个领域都一些典型的应用,包括客服,知识库,同时更希望大模型能够提供规划任务的拆解和推理能力,所以在整个大模型的发展趋势里,从大数据智能、语言智能到多模态的具身智能、群体智能、混合智能、最后的自主智能,最终大模型还是要和人进行协同的,和价值观的对齐。整个大模型现在进入到新的阶段,原来的专用模型,到现在兼采集数据、标注、训练,然后不断的做场景适配,相当于手工作坊的模型研发时代,基本上算法工程师占据了交付的主力军。再慢慢的到工业化的开发时代,把世界知识的底座模型训好。各领域训练行业专属模型,然后再做微调,只需要输出需要的东西,大模型就变成了平台,相当于工业化的研发模式。而且可以减少对数据的依赖,可以把知识和经验有效的进行编码,最终的还可以去辅助更多的规划和决策。

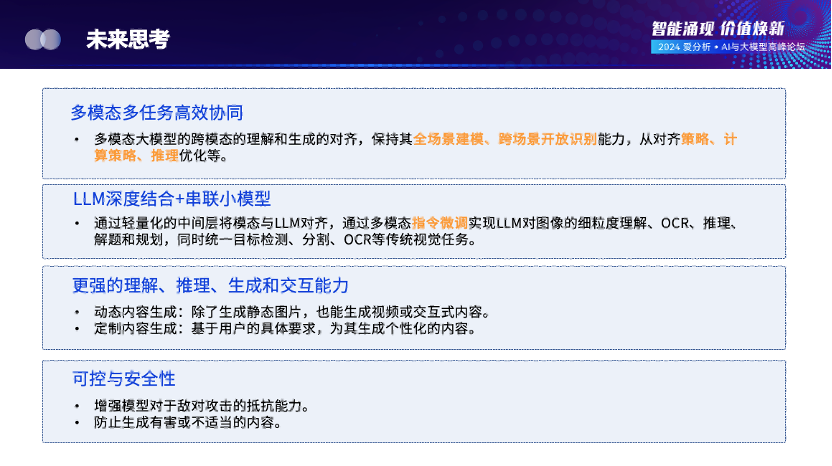

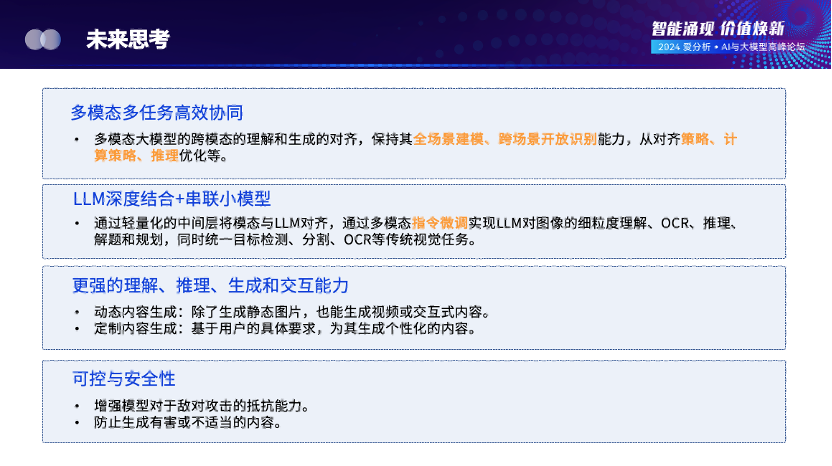

同时在细粒度的表示中,除了有框的表示,在视觉的任务中,多个任务都可以用一种表示,就是像素级的表示,既可以画框,也可以画轮廓,也可以给它做一些分割。另外还可以根据用户的需求,分割的力度不一样,这样就形成了基于提示的对象提取,把对标 Meta 的 SAM 模型,引入全实力分割的检测头的 Fast SAM 方法,让分割任务的性能跟 Meta 的 SAM 性能相当,同时处理的速度提高了 50 倍,全面的实现在视觉任务上,支持多尺度、多粒度的目标提取,实现了在多模态对齐里,能够支撑各种各样的任务输出。同时现在大模型的小型化也是非常主流的一个趋势。我们现在这方面做了很多的工作,第一是在大模型的高效训练上,第二是在推理上。通过通道的系数化和空间的系数化,使 token 建立共享的机制,从而保证推理的参数直接能降低 35% 。同时在训练的过程中,也用了各种各样的并行策略,以及混合精度的策略,把各种各样的算子融合、替代和加速,使效果能够实现高速的训练。最典型的一个方法,叫做基于波动性度量的高效模型剪枝。在做大模型落地的过程,比如金融的场景中,发现用一个 6B 的模型在做推理的时候,度量每个权重会发现有 50% 的权重基本上是不变的,就类似大模型做能力分区。例如在人做某一项专业任务的时候,其他的神经元很多都不激活,它的参数、权重是不怎么变的,所以就直接把参数记录下来,算过的数就不算了,这样直接使它参数量降低 50% ,推理速度提高 66% ,这是目前最简单粗暴的一个剪枝方法。只要看一下哪些权重是不变的,把它固定下来。这样的效率是可以用到任何一个模型结构里,都能达到高效的推理。特别在手机端,不同的任务可以激活不同的权重,就实现了基于多模态的任务,可以进行图文并茂的任意回答。例如你让他把这个胡萝卜框出来,他就给你框出来,你让他的画框、检测关键点、分割,都可以实现多任务的推理和高效的输出。也可以给它一个三维的点云,同样它能输出有多少个房间,现在在跟设计公司,做一些设计、装修,通过 AI 的自动化三维设计,能够使它的效果跟人做对齐。现在人工智能的感知能力、逻辑、推理、解题都取得了巨大的进步,但是仍然存在的一些问题。第一是幻觉,要外挂知识库;第二是自主进化,我们只知道 GPT 4 只到 2023 年 4 月份,后面就不知道了。如何通过搜索增强,以及让最新的数据喂进去,也不遗忘以前的数据,同时保持新的数据学习。这就是它的泛化能力和自学能力提出更高的要求。另一方面大模型能够借助工具通过 agent 能够更好的与环境进行交互,通过单源的场景,从语言场景到多模态,再到真正的融入生活中,通过各种各样 agent 的信息消化,实现认知世界到融入环境的跨越,这也是整个大模型生成归纳新概念的能力。现在AI 在各个领域都一些典型的应用,包括客服,知识库,同时更希望大模型能够提供规划任务的拆解和推理能力,所以在整个大模型的发展趋势里,从大数据智能、语言智能到多模态的具身智能、群体智能、混合智能、最后的自主智能,最终大模型还是要和人进行协同的,和价值观的对齐。整个大模型现在进入到新的阶段,原来的专用模型,到现在兼采集数据、标注、训练,然后不断的做场景适配,相当于手工作坊的模型研发时代,基本上算法工程师占据了交付的主力军。再慢慢的到工业化的开发时代,把世界知识的底座模型训好。各领域训练行业专属模型,然后再做微调,只需要输出需要的东西,大模型就变成了平台,相当于工业化的研发模式。而且可以减少对数据的依赖,可以把知识和经验有效的进行编码,最终的还可以去辅助更多的规划和决策。 第一,多模态、多任务的高效对齐协同,包括价值观的对齐。第二,大模型深度结合,串联小模型。不是所有的情况都由大模型解决,什么情况下需要小模型呢?像人脸识别,每人有 40 张照片,共有七八千万人的ID。训练一个两兆的模型就能实现这种亿万分之一的误识率。所以并不是大模型把小模型都替代了,而是更多开放的、泛化的场景,需要大模型串联小模型加各种工具,作为中间的桥梁把各种各样的工具和能力串联起来。第三,更强的理解、推理、生成和交互能力。真正的大模型竞争是抢占科技的制高点,推理生成和复杂的规划能力,才是真正的模型。当你发现机器人场景中,你让他做一些任务发现都不行, GPT 4 有的时候也不行,就需要更多高质量的数据,使它变得更强。第四,可控与安全性。我们要让模型不能有偏见,价值观对齐,对人没有伤害。以上四点是整个的大模型发展趋势,今天跟大家分享就是这些,谢谢。

第一,多模态、多任务的高效对齐协同,包括价值观的对齐。第二,大模型深度结合,串联小模型。不是所有的情况都由大模型解决,什么情况下需要小模型呢?像人脸识别,每人有 40 张照片,共有七八千万人的ID。训练一个两兆的模型就能实现这种亿万分之一的误识率。所以并不是大模型把小模型都替代了,而是更多开放的、泛化的场景,需要大模型串联小模型加各种工具,作为中间的桥梁把各种各样的工具和能力串联起来。第三,更强的理解、推理、生成和交互能力。真正的大模型竞争是抢占科技的制高点,推理生成和复杂的规划能力,才是真正的模型。当你发现机器人场景中,你让他做一些任务发现都不行, GPT 4 有的时候也不行,就需要更多高质量的数据,使它变得更强。第四,可控与安全性。我们要让模型不能有偏见,价值观对齐,对人没有伤害。以上四点是整个的大模型发展趋势,今天跟大家分享就是这些,谢谢。

⩓

中国科学院自动化所副总工程师,紫东太初大模型研究中心常务副主任,研究员,博导,武汉人工智能研究院院长,中国科学院大学人工智能学院岗位教授,多模态人工智能产业联盟秘书长,主要从事多模态大模型、视频分析与检索、大规模目标识别等方面的研究。共发表包括IEEE国际权威期刊和顶级会议论文300余篇,国际期刊50余篇,国际会议220余篇。完成国家标准提案3项,发明专利36项,10项国际视觉算法竞赛冠军,新时代中国经济创新人物,北京市科技进步一等奖,北京市自然科学二等奖,世界人工智能大会SAIL奖,吴文俊人工智能科技进步二等奖,中国发明创新银奖,中科院科苑名匠团队。

注:点击左下角“阅读原文”,领取专家完整版实录。