·聚焦:人工智能、芯片等行业

欢迎各位客官关注、转发

Groq是一家源于谷歌TPU团队的创业公司,其主要业务领域为云端推理市场。

2016年底,谷歌TPU核心团队的十个人中,有八人悄悄组队离职,合伙创办了新公司Groq。

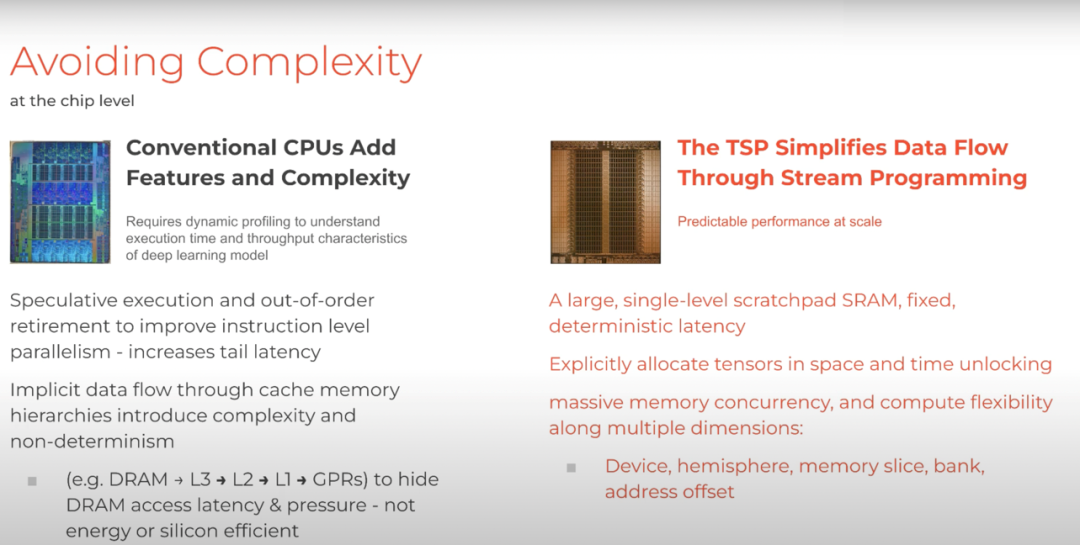

主张[软件定义硬件]核心理念,采用单一核配置计算和存储单元,所有操作均预先通过软件设定。

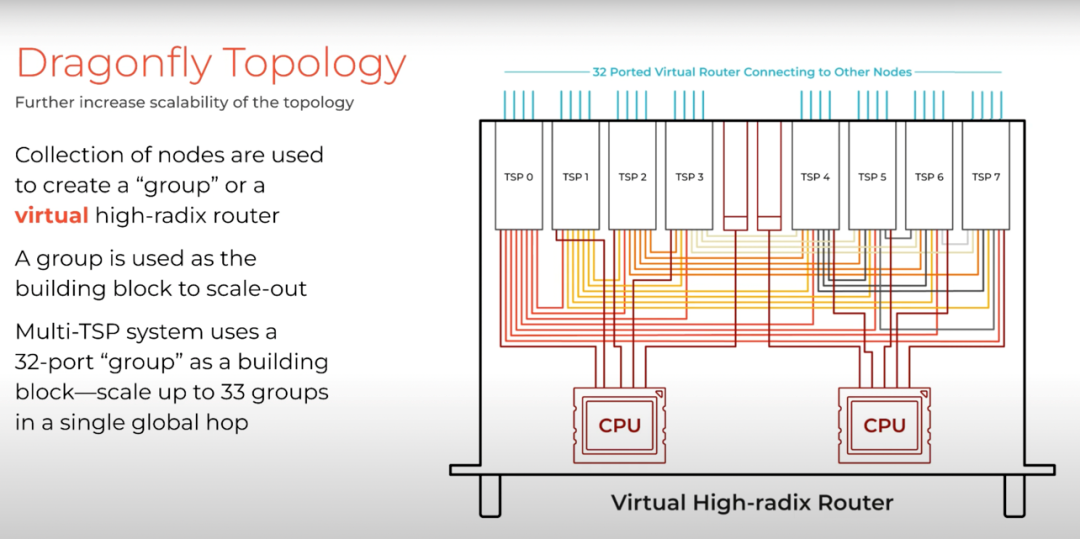

2019年Groq发布了其芯片架构,声称具备1POS/s的算力。该架构名为Tensor Stream。

从硬件层面来看,其设计相对简洁,去除了所有非必需的控制逻辑,将所有控制交由软件编译器完成,从而优化芯片面积分配,实现更高的单位面积算力。

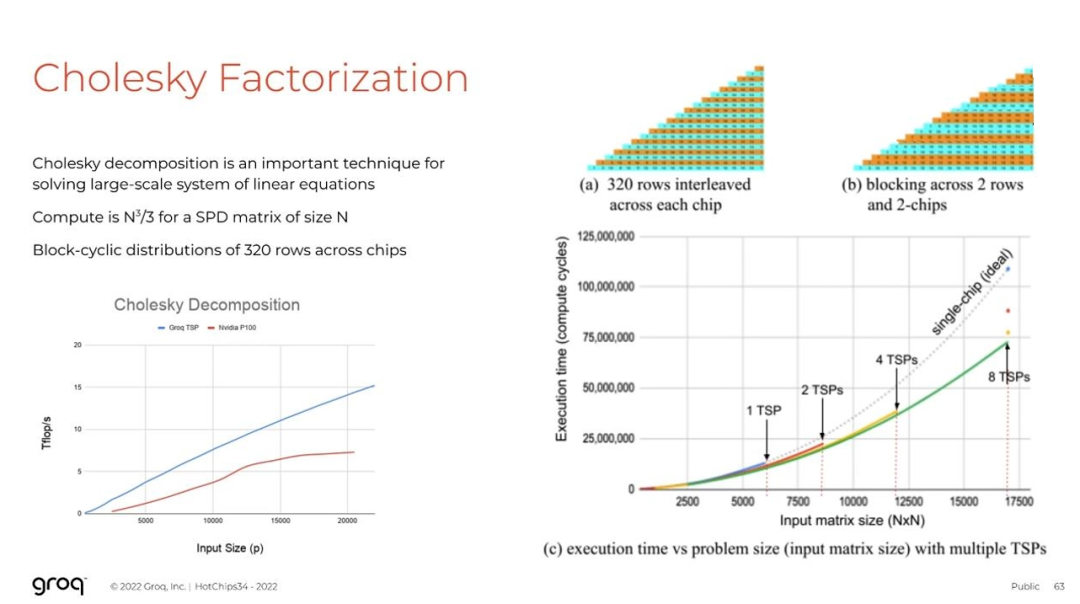

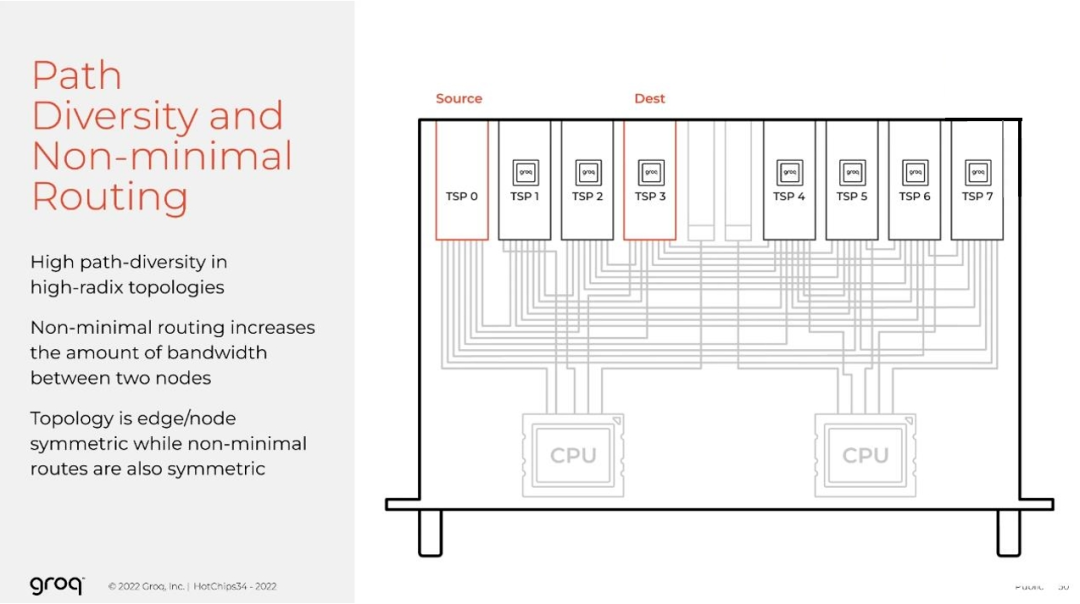

Groq革命性的TSP架构提供业界领先的性能和亚毫秒级延迟,为计算密集型应用程序提供高效的软件驱动解决方案。

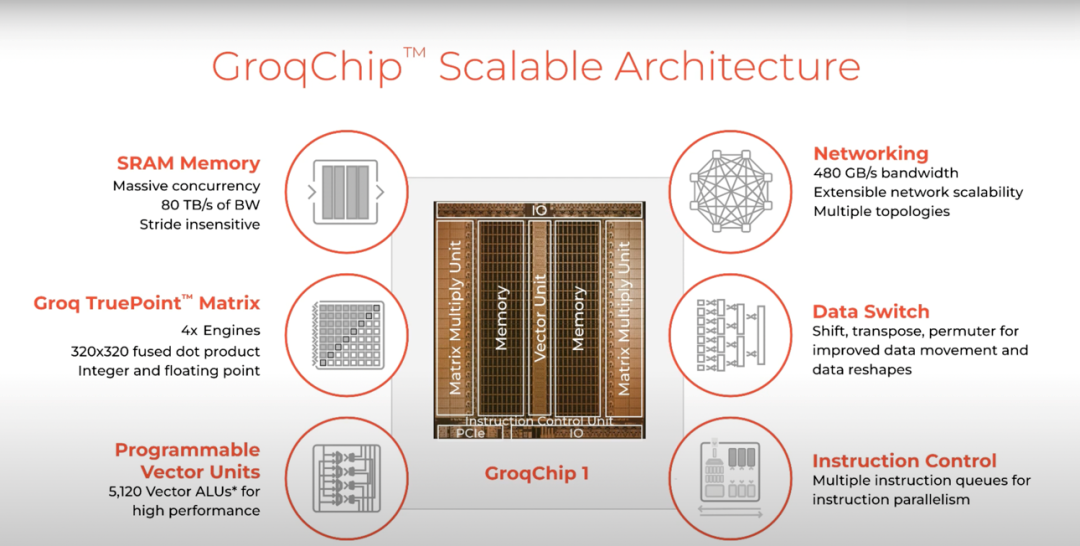

公司成立后推出首款云端推理芯片GroqChip,支持16个芯片互连,配置230 MB SRAM,算力可达750 TOPS。

该公司已与亚马逊、谷歌等云服务提供商建立合作关系,将其芯片部署在云端,为客户提供高性能AI计算服务。

与使用英伟达GPU相比,Groq LPU集群将为LLM推理提供更高的吞吐量、更低的延迟和更低的成本。

此外,Groq LPU不依赖HBM3和CoWoS封装产能,避免产能瓶颈。

英伟达和AMD对GPU的高需求和相对低的供应量为Groq及其他矩阵数学引擎供应商提供了他们一直在等待的机会。

2021年4月,Groq宣布获得3亿美元融资,由Tiger Global Management和亿万富翁Dan Sundheim投资,资金将用于自动驾驶领域和数据库的发展。

公司成立后,推出了GroqChip,该芯片能连接16个芯片,配备230MB SRAM,性能高达750 TOPS。

Groq正积极扩大语言处理单元(LPUs)的生产,预计其性能将可替代AI推理领域的英伟达GPU。

该公司计划在未来两年内交付100万个LPUs,以缓解市场对GPU的高需求和供应短缺。

随着大型语言模型推理演示的推进,Groq受到市场热捧,已有40个机架的硬件计划分配完毕,未来十二个月内计划部署相当于OpenAI每秒令牌总数的硬件。

由于工艺缩小、架构增强以及芯片结构的进步,其尺寸将进一步扩大。

Groq正加速研发下一代GroqChip,预计2025年推出,采用三星4纳米工艺,将提高功耗效率,使任务在更小空间内完成。

许多客户使用或微调已经被训练过的模型,而不是从头开始构建一个新模型。

高推理成本正对包括OpenAI在内的大模型及生成式AI公司们产生压力。

Groq芯片是一款通用深度学习推理芯片,适用于高性能、低延迟和计算密集型任务,堪称理想平台。

Groq突破传统观念,致力于研发批量仅为[1]的芯片,即一次性处理单个样本。

据Groq称,此种架构几乎可实现瞬时推理,而不牺牲性能,对时间敏感型应用如自动驾驶汽车至关重要。

2022年5月,Groq宣布其芯片实现每秒1万亿次运算速度。通过独特的单核架构,Groq重新定义计算技术,以推动人工智能和机器学习平台的发展。

这些平台在提供两倍推理性能的同时,大幅降低基础设施成本。

其高性能架构的愿景立足于三个关键技术创新领域:

①软件定义的硬件:Groq借鉴了软件优先的理念,将执行控制和数据流控制从硬件迁移至编译器。

②芯片创新:Groq的简化架构摒弃了无益于AI处理的冗余电路,从而实现更高效的芯片设计,性能每平方毫米均有提升。

③提升开发速度:Groq系统架构的简洁性消除了手工优化、配置文件以及传统硬件为中心设计方法所需的专业设备知识。

相较于AI训练,AI推理领域与消费电子等大规模应用终端的需求联系更为紧密,因此,业界发展重点有望从[训练]全面转向[推理]。

2020年,人工智能推理芯片市场份额已超过训练芯片,占比超过50%,这标志着随着算力的提升,人工智能正式步入认知时代。

在CES2024上,英特尔和AMD这两大PC端CPU芯片领导者,纷纷发布了集成AI推理模块的台式或笔记本电脑中央处理器新品。

专注于AI训练领域的英伟达也试图在AI PC市场中分得一杯羹,并在CES上推出了覆盖高画质游戏及AI应用软件的GPU新品GeForce RTX4080 SUPER。

随着2024年AI PC、AI智能手机等全新融合AI的消费电子产品的涌现,[AI+万物]的趋势已势不可挡。

在这一背景下,端侧AI大模型及AI软件大规模应用趋势将日益显现,广泛应用于PC、智能手机、智能手表等消费电子终端。

这也意味着AI推理的重要性日益凸显,成为高效运行端侧大模型及AI软件背后的核心技术。

随着消费类边缘设备在数据处理、存储和电池续航方面的显著提升,边缘AI这一细分领域将在2024年迎来更多的发展契机,AI行业的发展重心将从[训练]全面转向[推理]。

当前人工智能技术基于深度学习神经网络,首先需要大量数据进行训练,然后训练完成后,神经网络模型可根据输入数据进行推理计算。云端数据中心的训练和推理均需AI芯片加速。

然而,GPU的算力增长无法满足企业用户对神经网络算力的需求,且GPU的高功耗对云端数据中心构成挑战,因此云端数据中心一直期待新一代加速芯片的出现。

在大模型时代,AI推理芯片成为关键的应用承载载体。

传统算法开发与芯片难以满足新一代人工智能边缘计算场景的产品化需求,大模型的出现为行业提供了算法层面的解决途径。

然而,要在边缘计算场景中使大模型面向实战发挥作用,离不开AI大模型推理芯片的支持。

随着大规模地方性数据中心建设的逐步完成,云端训练芯片的增长速度逐渐放缓。

然而,随着各领域市场需求的释放,云端推理芯片及终端推理芯片市场增长速度呈现上升趋势。

下游推理端更贴近终端应用,侧重于响应时间而非吞吐量,需求更为细化。

自动驾驶领域对芯片算力要求极高,受限于时延和可靠性,相关计算无法在云端进行,因此终端推理芯片的升级至关重要。

据IDC研究发现,2020年我国数据中心用于推理的芯片市场份额已超过50%,预计到2025年,用于推理的工作负载芯片占比将提升至60.8%。

预计2023年推理芯片市场规模将达到110亿元,由于推理阶段所需算力与模型参数量、网站日访问量、每次访问问题长度及问题数量正相关。

对于AI芯片而言,大模型带来了全新的计算泛式和计算要求。为在边缘端运行巨量参数的大模型,芯片需具备更强大的算力、内存带宽和内存容量。

同时,AI边缘推理芯片肩负着[落地应用最后一公里]的使命,这意味着它不仅要支持AI计算任务如大模型等,还需具备较强的通用算力。

部分资料参考:OneFlow:《Groq:从头设计一个张量流式处理器架构》,半导体行业观察:《推理芯片市场,Groq重磅宣布》,StarryHeavensAbove:《Groq,[软件定义硬件]概念的背后》,芯潮:《撬走谷歌TPU核心团队的4/5,这家AI芯片创企在酝酿什么大招?》,摩尔芯闻:《如何正确选择AI推理芯片?》,芯东西:《AI芯片创企Groq融资3亿美元,由谷歌TPU核心团队离职创立》

推荐阅读:

商务合作请加微信勾搭:

18948782064

请务必注明:

「姓名 + 公司 + 合作需求」