随着ChatGPT的一夜火爆,人工智能(AI)技术正式踏入“面向用户,融入生活”的时代。在火爆的背后,有两项技术是支撑这一划时代变革的核心基石,其一是算法层面,人工神经网络(artificial neural networks, ANN)的快速发展为人工智能提供了理论支持,其二则是遵循摩尔定律快速发展的硅基计算芯片提供了强大的运算能力。然而,随着人工智能的进一步发展,对模型的功能复杂性和精准性提出更高的要求,有限的算力决定了目前模型训练过程往往是高能耗且极度耗时的。这种“算力不足”的直接原因是当前芯片的算力很难继续保持以摩尔定律的模式快速提升,而根本原因是在目前的冯·诺依曼体系下数据存储和数据处理单元的物理区隔导致的低效率。因此,是否能寻找一种能满足目前大模型训练需求的硬件体系是人工智能进一步发展的核心问题。

如果我们回溯上世纪八十年代,人工神经网络诞生的年代,其初衷就是想从信息处理的角度对人脑神经元网络进行抽象,建立一种类脑的模型来完成复杂计算和逻辑表达。因此,逻辑上来说,人脑才是最适合搭载人工神经网络的硬件平台。聚焦人类大脑本身,从结构上来说,是一个复杂的三维生物网络,由大约2000亿个细胞组成,这些细胞又通过数以万亿计的突触相连接。令人震惊的是,这些庞大复杂的生物网络在拥有庞大数据处理能力和学习能力的同时,仅有大约20W的功耗(硅基硬件若要达到相同性能大约需要八百万瓦)。并且,人类大脑将数据存储和处理过程混合在庞大的生物神经网络当中,这天然的使得该体系并不存在冯·诺依曼体系的瓶颈问题。然而,复杂的人脑并不能直接用于计算。这里有两个难点,1. 如何构建一个适合生物神经网络工作的训练体系;2. 如何构建一个适合用于计算的类脑器官。

据麦姆斯咨询报道,2023年12月11日,美国印第安纳大学(Indiana University)郭峰教授课题组在Nature Electronics期刊上在线发表了题为《Brain organoid reservoir computing for artificial intelligence》的研究论文,并给出了他们针对上述两个难点的答案。该文章报道了一种由电子器件和脑类器官组成的混合计算系统,通过短时间的训练其可以执行语音识别和非线性方程预测等任务。

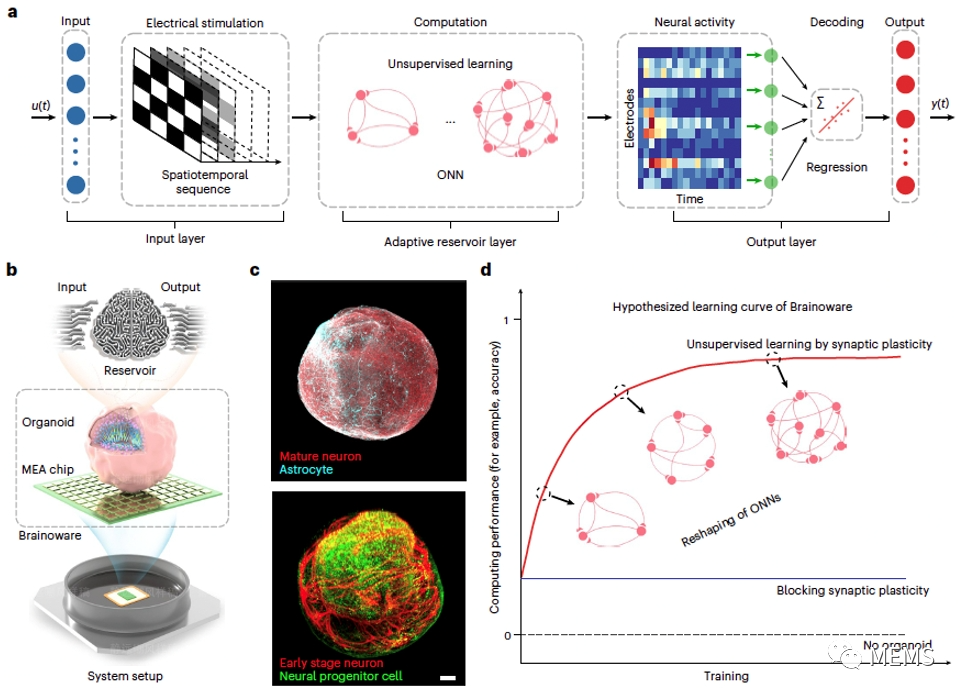

在这篇文章中,郭峰教授课题组通过将高密度多电极阵列(high-density multielectrode array, MEA)集成到一个功能化的脑类器官(Brain Organoid)表面构建了一个生物活体计算平台,命名为Brainoware。应用于该平台的脑类器官需要同时具备不同的脑细胞特征(例如,具备早期和成熟的神经元、星形胶质细胞和神经元祖细胞)和早期发育的脑类结构,以确保可以形成和维持复杂的神经网络,并且发挥其功能。该体系将外部电刺激作为输入信号,将诱发的神经互动作为输出信号,脑类器官同时作为存储单元和计算单元。作者将脑类器官整合到一种称为“储存池计算”的人工智能计算框架中,充当动态物理储存池,硅基多电极阵列输入电刺激并读取神经电信号。脑类器官具备储存池器件所需的短期记忆和非线性特性,将输入电刺激投射到高维的神经活动特征空间。输出层解码高维神经活动特征,并根据原始输入数据进行预测或分类。同时,脑类器官具备神经突触可塑性,可以成为“适应性储存池”,通过针对性的输入电刺激改变功能连接,实现无监督学习。

在通过多组独立训练确认该体系有效性和准确性的基础上,研究人员将该平台进一步的应用于真实世界的时序任务处理。通过时长两天的针对性训练和优化后,Brainoware成功应用于语音识别和非线性混沌方程的预测当中。其中,语音识别的准确率达78.0%±5.2%,而厄农映射(Hemon map)预测当中,性能介于没有长短期记忆单元(long short-term memory,LSTM)的ANN和具备LSTM的ANN之间。值得强调的是,虽然该体系性能略低于具备LSTM的ANN体系,但是训练时间却只有其十分之一。

总之,该文章将具备储存、计算和无监督学习能力的有机体神经系统(脑类器官)作为数据储存和计算单元,将电激励信号作为输入信号,神经活动作为输出信号构建了一种活体人工智能计算平台。研究人员利用脑类器官的神经可塑性实现该系统的无监督学习并应用在现实世界时空信号的处理当中。Brainoware提供了一种具备复杂性、连通性、神经可塑性的生物神经网络构建方式,这种低能耗和快速的训练方式可以为人工智能计算的硬件载体设计提供全新的思路。

原文链接:

https://doi.org/10.1038/s41928-023-01069-w

招聘信息:

郭峰课题组诚招有干细胞、类器官、人工智能背景的博士生和博士后加入并开展智能类器官系统研究,有兴趣者请联系邮件:fengguo@iu.edu。