AI 观察室是 Xilinx 在 2020 年打造的全新 AI 专栏,旨在分享产业洞见、解读前沿技术与热门应用。欢迎所有致力于 AI 研究与应用的有识之士投稿至: China_PR@xilinx.com

Hot Chips,全球高性能芯片领域最负盛名的业界盛会!虽受疫情影响,本届 Hot Chips 会议报告质量依然非常之高,涵盖范围也非常之广。在 Tutorial 部分,有来自于 Google TPU 团队、Cerebras、百度的机器学习训练专题,也有来自于 Google、IBM 等的量子计算专题。会议正式内容分为 8 个 Section,包括服务器处理器、移动处理器、边缘计算和传感、GPU 和游戏架构、FPGA 和可重构架构、网络和分布式系统、机器学习训练,以及机器学习推理。受限于文章篇幅,本文将主要讨论和机器学习相关部分的产品与趋势。

互联网公司自行开发的芯片明显增多。百度有昆仑,阿里有含光。未来自己的客户到底在哪里,公司出路在哪里?留给创业公司的空间还有多少?

百度是 Hot Chips 的常客:在主任架构师欧阳剑的带领下,其基于 FPGA 开发的 Software-Defined Accelerator(SDA,软件定义加速器)、面向于多种实际应用的 XPU 都已经在 Hot Chips 进行过报告。本次百度展示了去年在三星使用 14nm 工艺流片的昆仑芯片。

阿里巴巴在最近几年也在基础架构、芯片开发上投入巨大。去年阿里巴巴达摩院团队的张健松博士在 Hot Chips 发布了基于 FPGA 的新一代语音合成芯片 Ouroboros,今年阿里更是有两个报告入选,其中就包括由焦阳(骄旸)领导开发的含光 800 NPU。

同是互联网公司开发的 AI 芯片,百度昆仑和阿里含光 800 差异非常大,但各有优势。百度昆仑重点强调通用性,其峰值性能 256 INT8 TOPS/150W 的指标虽然不那么突出,但是能够支持搜索引擎、计算机视觉、NLP、语音识别等多种模型。含光 800 性能指标非常突出,使用台积电 12nm 工艺,实现了 825 INT8 TOPS/280W 的能效比,但是因为没有外接存储,其所能使用的模型有限,目前披露的数据基本都是针对 ResNet-50 的。

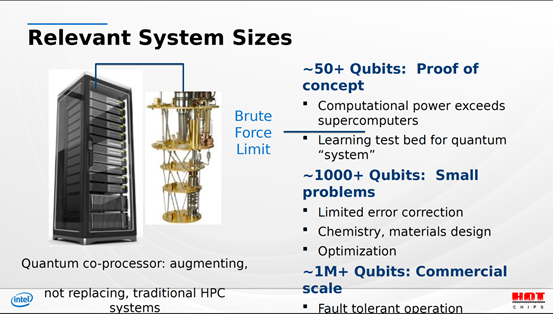

下一代计算技术得到更多关注。单纯架构上的变化,很难实现简单、便捷、低成本。模拟计算,存内计算,量子计算,光子计算, 谁将成为“破坏性创新”的源泉?

在2018年之后,基于传统数字集成电路的 AI 芯片研发进展开始变得缓慢,已经很难见到特别新鲜的想法和前所未有的微架构了。一方面,这是因为面向视觉和语音识别等领域的深度算法迭代幅度开始变小,没有那么多新的问题需要去解决。另一方面,AI 芯片也无非是一个特殊领域的 ASIC,很多解决过往问题的思路都可以迁移过来,好的金矿也率先都被挖出来了。因此,在过去两年,我们看到数字 AI 芯片的进步更多是和业务结合(如互联网公司造芯、特斯拉的自动驾驶芯片),或者利用一些新的平台型技术(如 HBM、Chiplet、Wafer-Scale Chip),微架构也在升级,但没有特别突出的大变化。

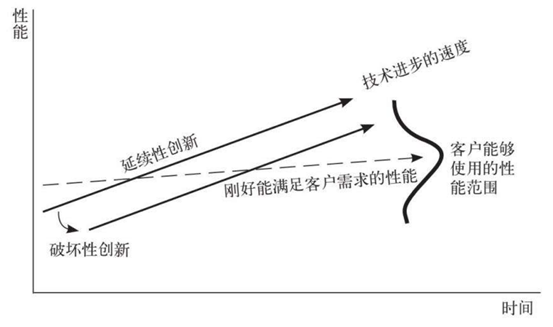

而更本质的问题在于,大家原本寄希望于 AI 芯片领域诞生“破坏性创新”或者“颠覆式创新”的机会,目前看起来很难实现。如图 1 所示,破坏性创新是指一种简单、便捷、成本低的新型技术,虽然早期达不到客户需求的性能,但其会逐步提升,直到满足客户需求、形成对传统技术的颠覆。而芯片领域,流片成本越来越高,在 7nm 节点达到了 1 亿美金以上,如果没有大量订单支撑摊薄成本一般企业根本无法承受。因此,在 AI 芯片领域变成了:公司越大,芯片卖得越多,芯片越便宜。单纯架构上的变化,很难实现简单、便捷、低成本,难以成为“破坏性创新”的源泉。

图 1. 破坏性创新模型(图源:《创新者的解答》)

孵化自 MIT 的 Lightmatter 团队介绍的光子计算方案,相比而言更加接近实用。利用一种 MEMS 工艺制造的 Mach Zehnder 干涉仪(简称 MZI),光子计算将传统的乘法转化为光路的相位调制与干涉,可以在几乎不耗能的情况下完成计算。但是,MZI 本来还是会对信号有一定的损耗,因为如果光路经过多个级联的 MZI,光路损耗的程度可能使得最终结果出错,也因此没法做到特别大的计算阵列。同时,光子计算还存在的一个问题是,仍然需要去解决 memory wall,因为 MZI 只是代替了乘法器。

值得一提的是,MIT 光子计算团队实际上孵化了两家创业企业,除了 Lightmatter,还有其中的华人团队创立的 Lightelligence(也被称为 LightAI,曦智科技)。在这里也希望 Lightelligence 能够越做越好。

Keynote 再次回到 AI 算法与应用。AI 开始进入大规模应用的下一步究竟是什么,机器人,AR,亦或是脑机接口?

Hot Chips 作为芯片行业最巅峰的盛会,其 Keynote 的选择,也代表了行业里大家当前最关注的方向。

2017 年的 Hot Chips,Google 著名的架构师,有诸多传奇和段子的“程序员之神”Jeff Dean,在大会做了“Recent Advances in Artificial Intelligence via Machine Learning and the Implications for Computer System Design (基于机器学习的人工智能最新进展及其对计算机系统设计的影响)”,足够说明 AI 真正地进入了主流应用,大家都开始关注 AI 最新的进展以及如何去针对性进行系统设计。

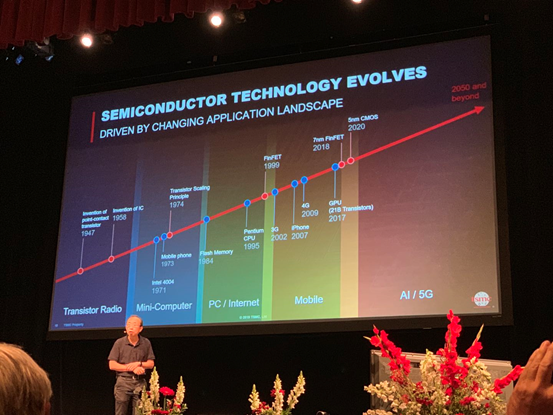

2018 到 2019 年的几个 Keynote 都和 AI 没有什么关系。2018年芯片行业重大的新闻是 Intel CPU 被发现了 Spectre 和 Meltdown 两个重大的漏洞,因此 Keynote 邀请了 John Hennessy 教授专门讲解两个漏洞以及处理器的安全性问题;同年,赛灵思新任总裁兼 CEO Victor Peng 就任,推出了 ACAP (Adaptive Computing Acceleration Platform, 自适应计算加速平台) 架构,也受到极大关注,因此也受邀到大会做 Keynote。2019 年,大家最关心的问题是摩尔定律是否还能延续,也因此邀请了 AMD CEO Lisa Su 与斯坦福大学教授、时任台积电研究 VP 的黄汉森教授分别介绍他们的观点。

图 3. 黄汉森教授在 Hot Chips 2019的 Keynote 报告 (图源:姚颂)

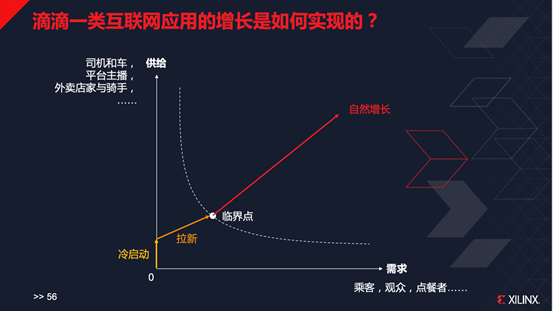

图 4. 供给和需求侧达到一定规模,互联网应用开始自然增长 (图源:姚颂)

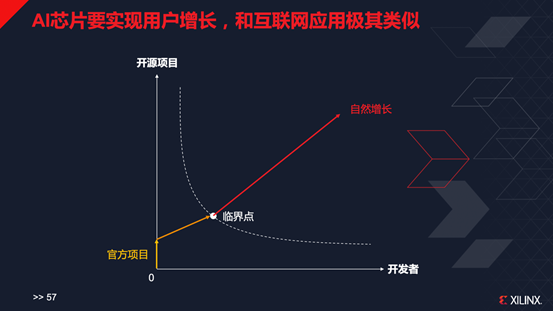

而对于 AI 芯片,大家总是讨论技术,但实际上要做的远远不止技术。从 2017年起,我在所有公众报告中就在强调软件的重要性,强调不止要让芯片性能很好,还要让用户可以极其简单的用起来新的芯片。而我也经常引述有赞创始人白鸦对于产品的金字塔模型,提到对于 AI 芯片产品来说,要让用户“离不开”,最重要的是开源生态、是社区。到现在,我越来越感觉到,AI 芯片的竞争,最根本的,就是类似于互联网平台的生态竞争,如图 5 所示,当有了足够多的开源项目,在用户初次接触 AI 芯片时,就有更高的几率使用你的芯片,而之后他又可能继续贡献更多的开源项目,实现正循环。也因为此,赛灵思越来越重视软件生态,越来越重视开发者,推出了 Vitis 这样面向所有类型开发者的软件平台,并且把开发者生态作为重点领域持续推进。

图 5.AI 芯片生态开拓与互联网平台的类似性(图源:姚颂)

目前,AI 芯片领域开发者生态的领导者是英伟达:据最新一次发布会上英伟达创始人、CEO 黄仁勋披露,已经有 180 万 AI 开发者使用英伟达 GPU;而AI的初学者,我相信 99% 以上都会选择买一块 GPU、下载开源代码进行尝试。那 AI 芯片的初创企业,其他的大型芯片企业还有机会吗?我脑海中蹦出来两个点:

第一,在钢琴推广上,听过一句话叫“一个郎朗胜过一万名钢琴老师”。第二,同是平台,不同平台的稳固程度是不一样的:如淘宝,每个商家都有自己的供应链、有自己在营销上的投入成本,因而会更为稳固;而滴滴,接入的个人司机,在切换平台上没有太多成本,因此哪里补贴高,司机就去哪个平台接单。

赛灵思也仍在 AI 开发者生态领域努力,欢迎大家加入,也欢迎大家一起讨论。

THE END

姚颂:现任赛灵思人工智能业务高级总监,负责公司在全球领域的人工智能业务拓展和生态建设。加入赛灵思之前,姚颂为深鉴科技( 2018 年 7 月并入赛灵思公司)联合创始人、首席执行官,带领团队自主研发了高效的深度学习平台,致力于为智能安防与数据中心等行业提供集算法、软件、芯片为一体的人工智能方案。