本文来源: FSM Lab

本文来源: FSM Lab

本文重点

Summary

本文介绍了香港城市大学未来智慧交通实验室的ECAI2023录用论文"Uncertainty-Encoded Multi-Modal Fusion for Robust Object Detection in Autonomous Driving"。该论文对多模态3D目标检测在各种极端场景下的不确定性进行了深入的量化和分析。根据评估结果,我们设计了一种名为UMoE的基于不确定性编码的混合专家融合模块。此模块显著提高了现有LiDAR与摄像头融合的3D目标检测模型在极端场景(如雪天、大雾、对抗攻击和光斑攻击)中的表现,并可轻松集成到任何融合后的3D目标检测模型中。

1

不确定性在极端场景下的指导意义

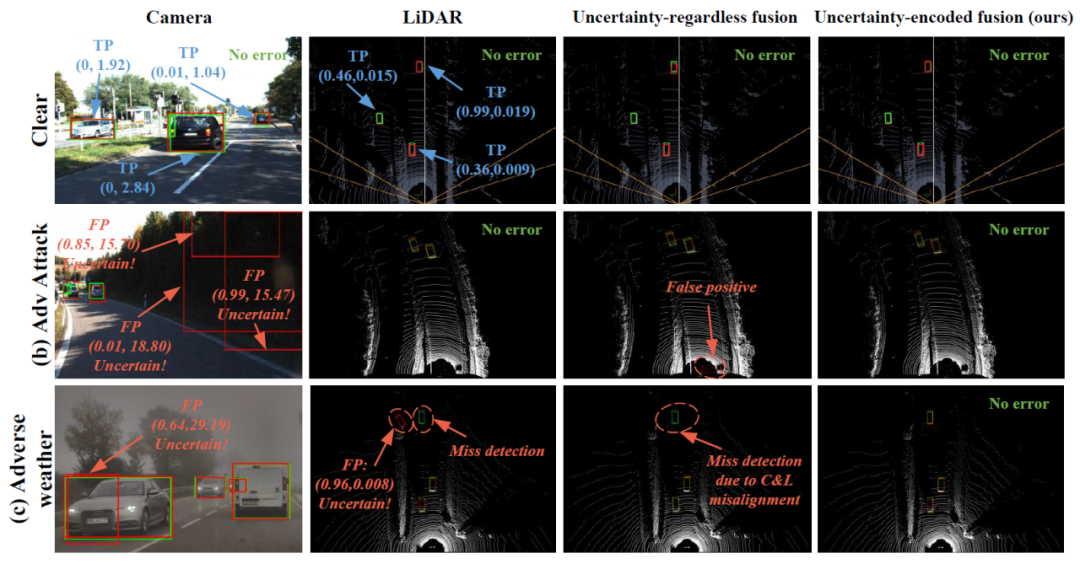

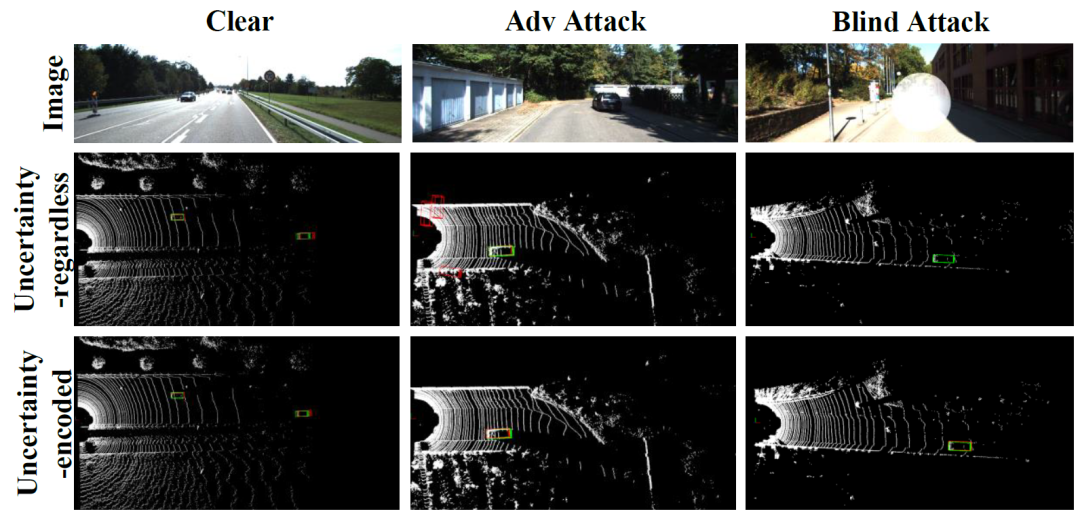

3D目标检测是自动驾驶感知的核心任务。近年来,基于LiDAR和摄像头的3D目标检测受到了广泛关注,因为它们为目标检测提供了互补的信息,如深度和视觉特征,从而实现了卓越的性能。但我们发现,许多融合策略并未充分考虑每个输入的质量,当某个传感器受到极端环境的影响时,整体的融合效果可能会受到严重影响。如图一所示,由于对抗攻击或浓雾,融合后的检测结果出现了误检(false positive)和漏检(miss detection)。

图一:摄像头、激光雷达、融合基线以及不确定性编码增强融合在晴朗、对抗攻击和恶劣天气这三种驾驶场景下的3D目标检测结果。

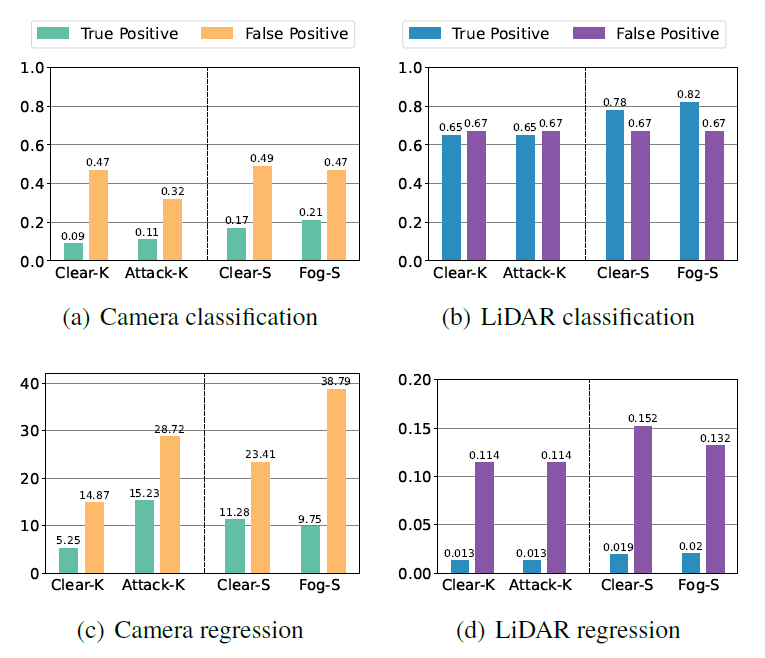

尽管不确定性已被广泛应用于描述单模态目标检测的性能,但在多模态融合中仍缺乏有效的策略。为了探索不确定性在LiDAR与摄像头融合中的潜在价值,我们对两种模态在正常和极端场景下的不确定性进行了详细的量化和分析。图二展示了在四种不同驾驶环境下,基于LiDAR和摄像头的检测模型的不确定性得分。

图二:四种驾驶场景下的平均不确定性得分。

从图一和图二的结果中,我们发现不确定性得分对于感知性能具有重要的指示作用

1. 当传感器受到极端环境的影响时,检测结果的分类和回归的不确定性得分,尤其是对于误检,通常会上升。

2. 在相同的驾驶场景中,误检产生的分类和回归不确定性得分远高于正确检测。

但我们也注意到,LiDAR和摄像头在不同的极端场景下对不确定性的敏感度不同,这为我们带来了一些挑战:

1. LiDAR和摄像头对环境变化的敏感性和认知能力有所不同,摄像头的不确定性得分比LiDAR更加波动。

2. LiDAR和摄像头的回归不确定性得分存在数量级的差异。

2

不确定性编码增强的混合专家融合模块

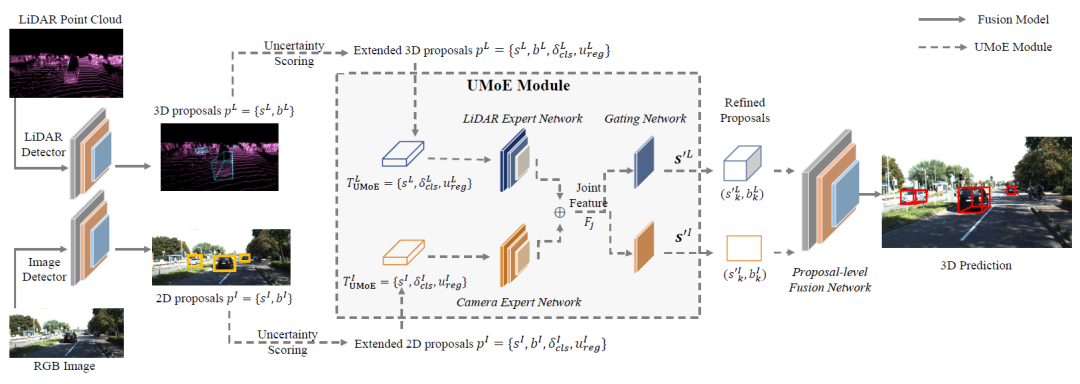

为了应对上述挑战,我们设计了一个名为“基于不确定性编码的混合专家融合模块”(UMoE)。此模块连接了激光雷达/摄像头3D目标检测器和后融合网络,通过考虑不同模态的不确定性来实现更鲁棒的融合效果。图三展示了集成UMoE模块的LiDAR-摄像头后融合架构。

图三:集成UMoE模块的LiDAR-摄像头后融合架构。虚线表示UMoE模块的数据流,实线表示后融合的数据流。

UMoE模块主要由两部分组成:

不确定性评分(Uncertainty Scoring)

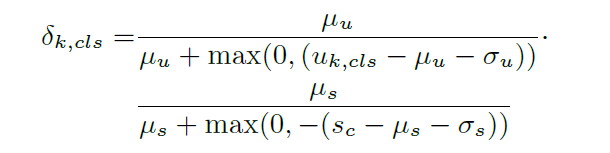

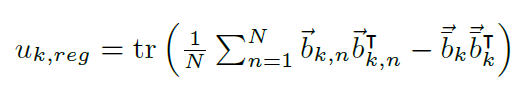

首先,我们利用基于LiDAR和摄像头的目标检测器处理传感器数据,生成检测框。结合MC-Dropout和Direct Modeling两种方法,我们为每一个3D检测框计算并赋予一个不确定性得分和,这些得分将作为UMoE模块的关键输入。具体而言,对于置信度输出的不确定性得分,我们通过计算香农熵和置信度本身,来衡量其在true positive检测框分布中的偏移程度。而对于框输出的不确定性得分u_reg,我们首先计算其total variance,然后与Direct Modeling方法计算出的数据不确定性得分进行累加。

图四:置信度输出的不确定性标量分数

图五:框输出的不确定性标量分数

2. 基于混合专家架构的融合

为了克服由不确定性的不同敏感度和表征方式带来的挑战,我们引入了优化后的混合专家架构,以更有效地融合编码的不确定性得分。在此架构中,每一种传感器模态都配备了一个专门的专家网络(expert network),该网络负责将检测框及其相应的不确定性得分映射到一个统一的特征空间,为后续的跨模态融合打下基础。随后,我们的门控网络(gating network)将所有模态的特征进行拼接,并预测出每个检测框在经过不确定性编码后的置信度得分。经过这一步骤,更新后的置信度得分将与检测框一同输入到后融合网络中,以实现更精确的目标检测。

3

实验与分析

为了验证UMoE模块的实际效果,我们选取了两种常用的后融合网络,并在以下四个不同数据集上进行了3D目标检测的平均精度评估:1)晴朗天气下的KITTI数据集;2)受到对抗攻击的KITTIAdv数据集;3)受到光斑攻击的KITTIBlind数据集;4)极端天气条件下的STF数据集。需要指出的是,KITTI和STF是公开的自动驾驶真实世界数据集,而KITTIAdv和KITTIBlind是我们基于KITTI数据集,对摄像头数据进行对抗攻击和光斑攻击后,自行合成的数据集。

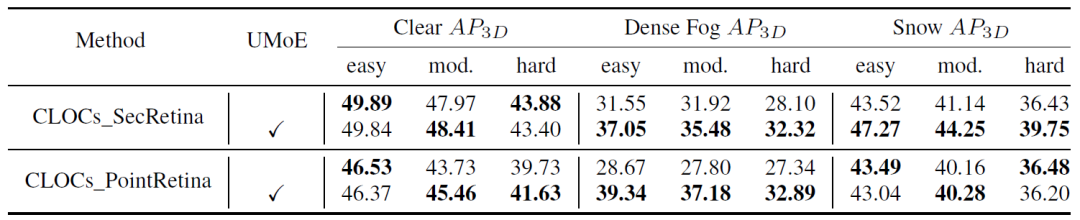

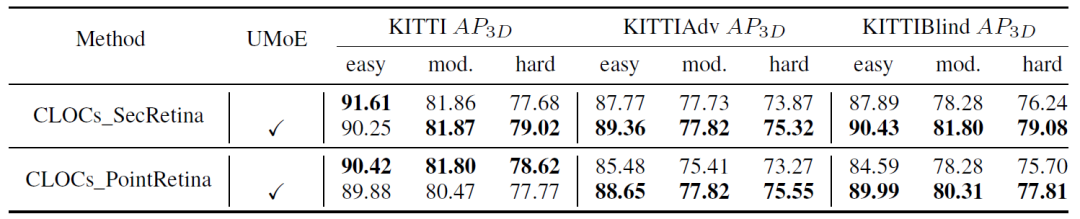

接下来,我们将UMoE模块与上述两组模型结合,进行了重新测试。通过对比表一和表二的数据,明显可以看出,当引入UMoE模块后,无论是在极端天气(如浓雾、雪天)还是在各种攻击场景下,模型的性能都得到了显著的提升。而在标准的晴朗天气场景中,其性能与未引入UMoE模块的基线模型相当。

表一:不含 UMoE 模块和集成 UMoE 模块的后融合模型在STF数据集上 Clear(晴朗)、Dense Fog (浓雾) 和Snow (雪天) 场景的 3D目标检测平均精度。

表二:不含 UMoE 模块和集成 UMoE 模块的后融合模型在KITTI (晴朗)、KITTIAdv (对抗攻击) 和 KITTIBlind (光斑攻击) 数据集上的 3D目标检测平均精度。

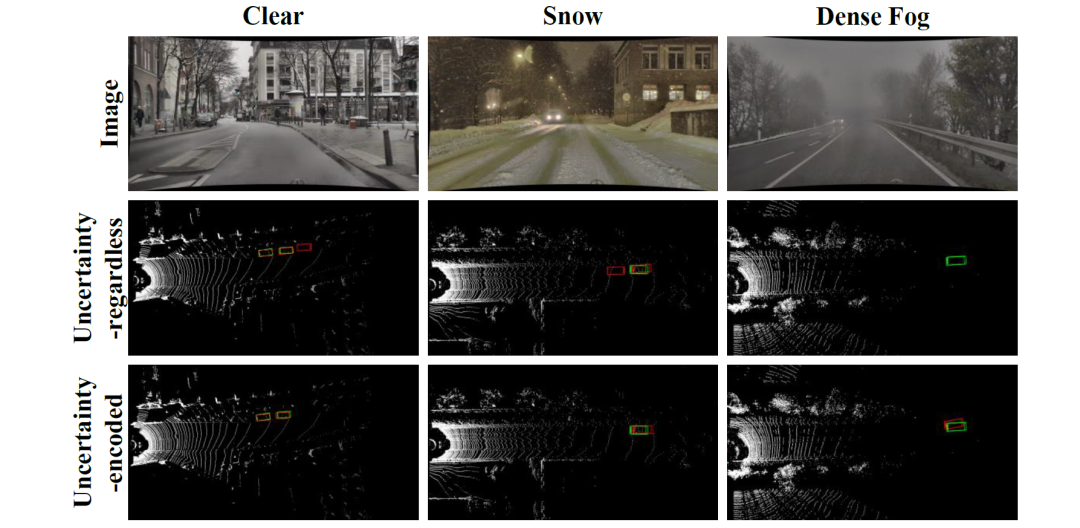

图六和图七的可视化结果进一步证明了UMoE模块的优越性,它能够有效地处理由雪天、对抗攻击引起的误检,以及由浓雾环境、光斑攻击引起的漏检。

图六:极端天气数据集STF下的3D目标检测可视化结果。

图七:KITTI (晴朗)、KITTIAdv (对抗攻击) 和 KITTIBlind (光斑攻击) 数据集上的 3D目标检测可视化结果。

END