--关注、星标、回复“智驾圈子”--

↓↓查看:「智驾最前沿」智驾圈子资料目录↓↓

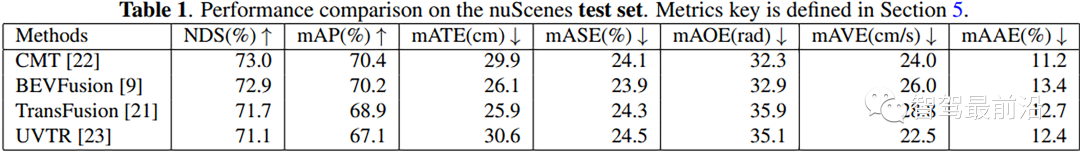

传感器融合是许多感知系统中的一个重要课题,例如自动驾驶和机器人。在许多数据集上的排行榜,基于transformer的检测头和基于CNN的特征编码器(从原始传感器数据中提取特征),已成为性能最高的3D检测多传感器融合框架之一。

本文提供了最近基于transformer的3D目标检测任务的文献综述,主要集中于传感器融合,介绍了视觉transformer(ViT)的基础知识,还简要论述了用于自动驾驶的传感器融合的几种非transformer式较少占主导地位的方法。最后总结了transformer在传感器融合领域中的作用,并提出了该领域的未来研究方向。

更多内容可以参考:https://github.com/ApoorvRoboticist/Transformers-SensorFusion

传感器融合是整合来自不同信息源的感知数据,利用不同传感器捕获的互补信息,融合有助于减少状态估计的不确定性,并使3D目标检测任务更加稳健。目标属性在不同的模式中不具有同等的可识别性,因此需要利用不同的模式并从中提取补充信息。例如,激光雷达可以更好地定位潜在物体,radar可以更好地估计场景中物体的速度,最后但并非最不重要的是,相机可以通过密集的像素信息对物体进行分类。

不同模态的传感器数据除了在每个传感器的坐标空间的差异之外,通常在数据分布上存在较大差异。例如,LiDAR在笛卡尔坐标空间中,Radar位于极坐标空间,图像位于透视空间。不同坐标系引入的空间失准使得难以将这些模态合并在一起。多模态输入的另一个问题是,当ML网络可以使用camera和LiDAR送入时,会出现异步时间线的问题。

现有的传感器融合模型的总体架构图如上所示,基于transformer的Head(绿色),基于CNN的特征提取器(蓝色),用于预测3D鸟瞰图(BEV)边界框(黄色块),每个传感器具有中间BEV特征(紫色块),该传感器融合设置为从多视图相机、激光雷达和雷达接收输入。

虽然CNNs可用于在单个模态内捕获全局上下文,但将其扩展到多个模态并精确地建模成对特征之间的交互是非常重要的。为了克服这一限制,使用transformer的注意力机制将关于2D场景的全局上下文推理直接集成到模态的特征提取层中。序列建模和视听融合的最新进展表明,基于Transformer的体系结构在序列或跨模态数据的信息交互建模方面非常有效!

融合level:最近,多传感器融合在3D检测界引起了越来越多的兴趣。现有方法可分为detection-level、proposal-level、point-level 融合方法,这取决于融合不同模态(即相机、雷达、激光雷达等)的早期或后期程度!

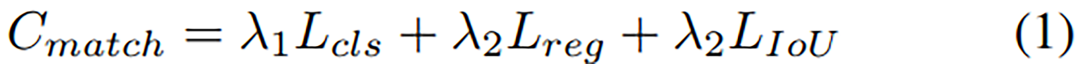

detection-level即后期融合已经成为最简单的融合形式,因为每个模态都可以单独处理自己的BEV检测,然后可以使用匈牙利匹配算法和卡尔曼滤波进行后处理,以聚合和删除重复检测。然而,这种方法不能利用这样一个事实,即每个传感器也可以对单个边界框预测中的不同属性做出贡献。CLOCS可以融合基于lidar的3D目标检测和2D检测任务的结果,它在非最大值抑制之前对两个输出候选进行操作,并使用两组预测之间的几何一致性来消除假阳性(FP),因为在不同的模式下很可能同时检测到相同的FP。

point-level又称早期融合,利用相机功能增强了LiDAR点云,在该方法中,使用变换矩阵找到LiDAR点和图像之间的硬关联。然而,由于融合质量受到点稀疏性、甚至有时当两个传感器的标定参数中存在轻微误差时,这种方法都会受到影响。

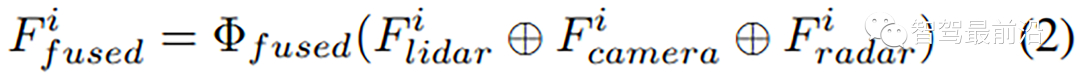

proposal-level即深度融合是目前文献中研究最多的方法,transformer[5,6,7]的进展解锁了中间特征如何交互的可能性,尽管它们来自不同的传感器。MV3D提出的代表性工作从LiDAR特征中提取初始边界框,并使用图像特征对其进行迭代优化。BEVFusion生成基于相机的BEV特征,如[10,11,12,13]中所强调的。Camera和激光雷达模态在BEV空间中连接,BEV解码器用于预测3D box作为最终输出。在TransFuser中,单视图图像和LiDAR的BEV表示由编码器中的transformer在各种中间特征图上融合。这导致编码器的512维特征向量输出,其构成局部和全局上下文的紧凑表示。此外,本文将输出反馈给GRU(门控递归单元),并使用L1回归损失预测可微自车路线点。4D网络[16]除了是多模态的,还将时间维度作为第四维度添加到问题中。首先单独提取相机和激光雷达的时间特征[17],添加图像表示的不同上下文,论文收集了三个层次的图像特征,即高分辨率图像、低分辨率图像和视频。然后,使用变换矩阵融合交叉模态信息,以获取给定3D pillar中心的2D上下文,该中心由BEV网格单元的中心点(xo,yo,zo)定义!

该方法可分为三个步骤:

1.应用基于神经网络的主干从所有模态中单独提取空间特征;

2.在transformer模块中迭代细化一小组学习嵌入(目标Query/proposal),以生成一组3D box的预测;

3.计算loss;

该架构如图1所示!

Camera:多camera图像被馈送到backbone(例如,ResNet-101)和FPN,并获得特征;

LiDAR:通常使用0.1m体素大小的voxelnet或0.2m pillar大小的PointPill对点进行编码,在3D主干和FPN之后,获得了多尺度BEV特征图;

Radar:通过MLP将location、intensity、 speed转换为特征!

在开创性工作[5]中,稀疏Query 被学习为一个网络参数,并且是整个训练数据的代表。这种类型的Query 需要更长的时间,即更多的顺序解码器层(通常为6个)来迭代收敛到场景中的实际3d目标。然而,最近依赖于输入的Query [20]被认为是一种更好的初始化策略。这种策略可以将6层转换器解码器降到甚至单层解码器层, Transfusion使用中心热图作为Query,BEVFormer引入了密集Query作为等距BEV网格!

转载自网络,文中观点仅供分享交流,不代表本公众号立场,如涉及版权等问题,请您告知,我们将及时处理。

-- END --