今年ChatGPT爆火,带动AI服务器需求激增,HBM内存芯片的价格也水涨船高。

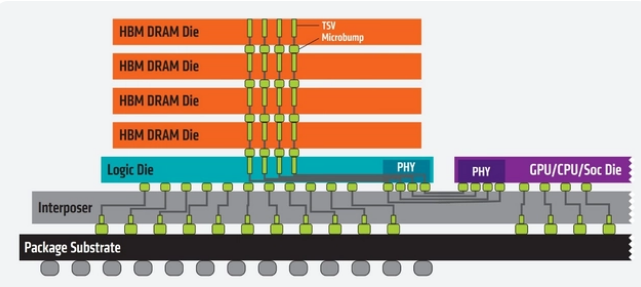

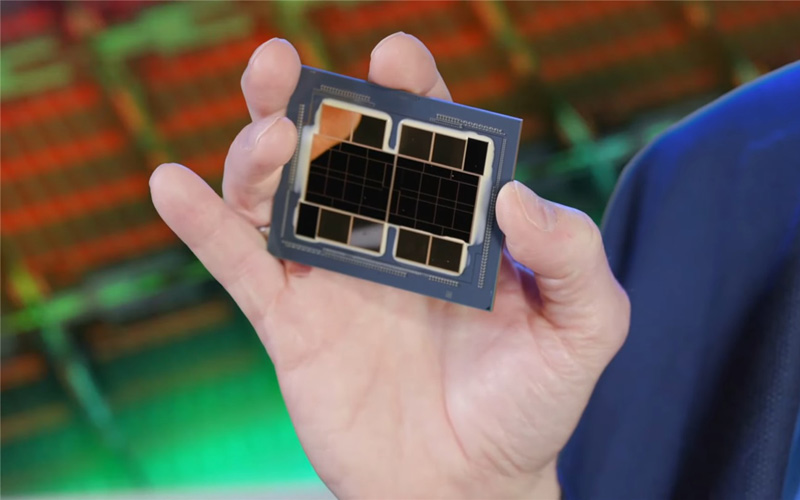

HBM是一种基于3D堆叠工艺的DRAM内存芯片,它就像摩天大厦中的楼层一样可以垂直堆叠,将多个DDR芯片堆叠在一起后和GPU封装在一起,实现更高带宽、更高位宽、更低功耗、更小尺寸。

HBM是当下数据处理速度最快的DRAM产品,NVIDIA、AMD、Intel等高端AI芯片大多选择搭载HBM。据TrendForce的研究数据,预计2023年全球HBM需求量将增近六成,达到2.9亿GB,2024年将再增长30%,2025年HBM整体市场有望达到20亿美元以上。

近期,据科技媒体报道,英伟达、AMD、微软、亚马逊等多个科技巨头都在排队抢购SK海力士的第五代高带宽内存HBM3E,已经在向SK海力士请求获取HBM3E样品。

据了解,HBM3E是HBM3的增强版,能够将数据传输速率提升25%,把数据传输率从6.40GT/s提高到8.0GT/s。SK海力士预计在今年年底前供应HBM3E样品,并在2024年开始量产。

ChatGPT出现前,HBM鲜有问津,高昂的成本让人望而却步,HBM需求占整体DRAM市场只有不到1%。但随着ChatGPT引爆AI热潮,HBM作为AI芯片的最佳搭档,几乎一夜之间芯片市场的“新宠”。

目前,全球HBM市场被为三星、SK海力士、美光三大存储芯片巨头瓜分。其中,SK海力士处于领先地位,是当前唯一实现HBM3量产的厂商,HBM市占率高达50%,而三星、美光市占率分别为38%和9%。

HBM需求爆发,三星、SK海力士、美光三大存储芯片巨头正在将更多产能转移至生产HBM,但由于调整产能需要时间,很难迅速增加HBM产量,预计未来两年HBM供张。

不过,在HBM领域,国内厂商布局不大,只有一些厂商涉及封测。比如,国芯科技正在研究规划合封多HBM内存的2.5D的芯片封装技术,积极推进Chiplet技术的研发和应用;通富微电在建先进的2.5D/3D先进封装研发及量产基地,将实现国内在HBM高性能封装技术突破;华海诚科生产的颗粒状环氧塑封料(GMC)可以用于HBM的封装,相关产品已通过客户验证,现处于送样阶段。

总的来说,国内HBM内存芯片与国际巨头的差距还是非常大。

最后,毛遂自荐一下,小猫芯城成立于2015年,一站式电子元器件采购商城,提供1000万+种电子元器件,聚惠百万品牌好货,100%原装正品,闪电发货,让元器件采购更简单!