--关注、星标、回复“大模型”--

[8] S. Kuutti, S. Fallah, K. Katsaros, M. Dianati, F. Mccullough, and A. Mouzakitis, “A survey of the state-of-the-art localization techniques and their potentials for autonomous vehicle applications,” IEEE Internet Things J., vol. 5, no. 2, pp. 829–846, Apr. 2018.

[9] A. N. Ndjeng, D. Gruyer, and S. Glaser, “New likelihood updating for the IMM approach application to outdoor vehicles localization,” in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., Oct. 2009,pp. 1223–1228.

[10] Velodyne. (2017). HDL-64E S3 Manual. [Online]. Available: https://vel odynelidar.com/hdl-64e.html

[11] Velodyne. (2018). HDL-32E Manual. [Online]. Available: https://vel odynelidar.com/hdl-32e.html

[12] E. Jose, M. Adams, J. S. Mullane, and N. M. Patrikalakis, “Predicting millimeter wave radar spectra for autonomous navigation,” IEEE Sensors J., vol. 10, no. 5, pp. 960–971, May 2010.

[13] S. Jung, J. Kim, and S. Kim, “Simultaneous localization and mapping of a wheel-based autonomous vehicle with ultrasonic sensors,” Artif. Life Robot., vol. 14, no. 2, pp. 186–190, Nov. 2009.

[14] G. Dissanayake, S. Sukkarieh, E. Nebot, and H. Durrant-Whyte,“The aiding of a low-cost strapdown inertial measurement unit using vehicle model constraints for land vehicle applications,” IEEE Trans.Robot. Autom., vol. 17, no. 5, pp. 731–747, Oct. 2001.

[15] K. Liu, H. B. Lim, E. Frazzoli, H. Ji, and V. C. S. Lee, “Improvingpositioning accuracy using GPS pseudorange measurements for cooperative vehicular localization,” IEEE Trans. Veh. Technol., vol. 63, no. 6,pp. 2544–2556, Jul. 2014.

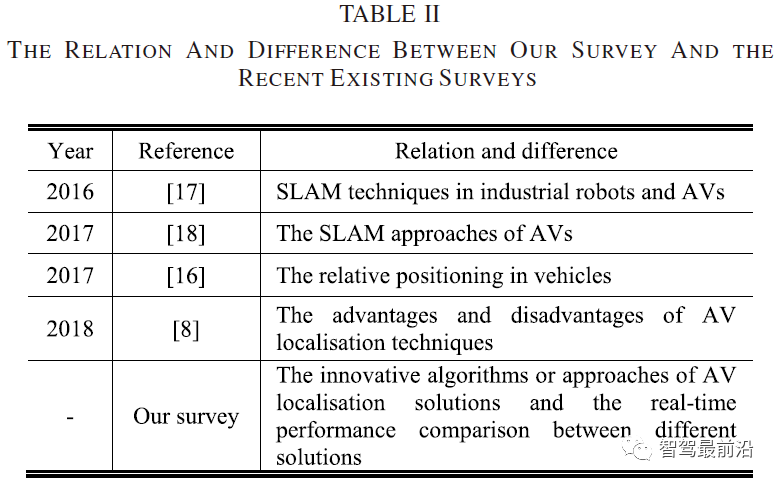

[16] F. de Ponte Müller, “Survey on ranging sensors and cooperative techniques for relative positioning of vehicles,” Sensors, vol. 17, no. 2, p. 271, Jan. 2017.

[17] C. Cadena et al., “Past, present, and future of simultaneous localization and mapping: Toward the robust-perception age,” IEEE Trans. Robot., vol. 32, no. 6, pp. 1309–1332, Dec. 2016.

[18] G. Bresson, Z. Alsayed, L. Yu, and S. Glaser, “Simultaneous localization and mapping: A survey of current trends in autonomous driving,” IEEE Trans. Intell. Vehicles, vol. 2, no. 3, pp. 194–220, Sep. 2017.

[19] J. Ku, M. Mozifian, J. Lee, A. Harakeh, and S. Waslander, “Joint 3D proposal generation and object detection from view aggregation,”in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., Oct. 2017, pp. 1–8.

[20] L. Caltagirone, M. Bellone, L. Svensson, and M. Wahde, “LIDAR–camera fusion for road detection using fully convolutional neural networks,” Robot. Auton. Syst., vol. 111, pp. 125–131, Jan. 2019.

[21] Z. Chen, J. Zhang, and D. Tao, “Progressive LiDAR adaptation for road detection,” IEEE/CAA J. Automatica Sinica, vol. 6, no. 3, pp. 693–702,May 2019.

[22] C. Urmson, “Driving beyond stopping distance constraints,” in Proc.IEEE/RSJ Int. Conf. Intell. Robots Syst., Oct. 2006, pp. 1189–1194.

[23] F. Institute. (2019). Radar Sensor Module to BringAdded Safety to Autonomous Driving. [Online]. Available:https://www.fraunhofer.de/content/dam/zv/en/press-media/2019/june/izm-radar-sensor-module-to-bring-added-safety-to-autonomousdriving.pdf

[24] Y. Zhang et al., “Toward a more complete, flexible, and safer speedplanning for autonomous driving via convex optimization,” Sensors,vol. 18, no. 7, p. 2185, Jul. 2018.

[25] H. An and J.-I. Jung, “Decision-making system for lane change using deep reinforcement learning in connected and automated driving,”Electronics, vol. 8, no. 5, p. 543, May 2019.

[26] B. Sebastian, “Dynamic decision-making in continuous partially observable domains: A novel method and its application for autonomous driving,” Ph.D. dissertation, Karlsruhe Inst. Technol.,Karlsruhe, Germany, 2015.

[27] Y. Pan, Q. Lin, H. Shah, and J. M. Dolan, “Safe planning for self-driving via adaptive constrained ILQR,” 2020, arXiv:2003.02757.[Online].Available:https://arxiv.org/abs/2003.02757

[28] X. Wang, J. Wang, J. Zhang, and X. Ban, “Driver’s behavior and decision-making optimization model in mixed traffic environment,”Adv. Mech. Eng., vol. 7, no. 2, Feb. 2015, Art. no. 759571.

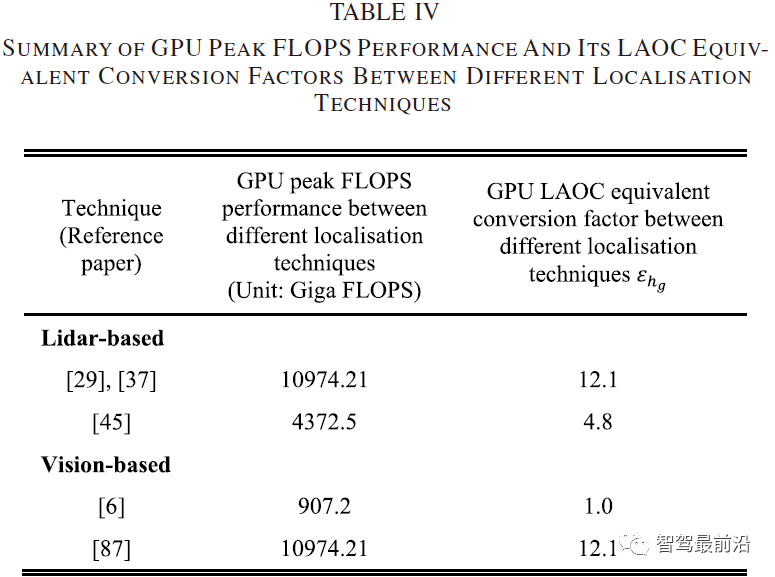

[29] R. W. Wolcott and R. M. Eustice, “Robust LIDAR localization using multiresolution Gaussian mixture maps for autonomous driving,” Int.J. Robot. Res., vol. 36, no. 3, pp. 292–319, Mar. 2017.

[30] E. Takeuchi and T. Tsubouchi, “A 3-D scan matching using improved 3-D normal distributions transform for mobile robotic mapping,”in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., Oct. 2006,pp. 3068–3073.

[31] J.-H. Im, S.-H. Im, and G.-I. Jee, “Vertical corner feature based precise vehicle localization using 3D LIDAR in urban area,” Sensors, vol. 16,no. 8, p. 1268, Aug. 2016.

[32] J.-H. Im, S.-H. Im, and G.-I. Jee, “Extended line map-based precise vehicle localization using 3D LIDAR,” Sensors, vol. 18, no. 10,p. 3179, Sep. 2018.

[33] J. Levinson and S. Thrun, “Robust vehicle localization in urban environments using probabilistic maps,” in Proc. IEEE Int. Conf. Robot. Automat., May 2010, pp. 4372–4378.

[34] G.-P. Gwon, W.-S. Hur, S.-W. Kim, and S.-W. Seo, “Generation of a precise and efficient lane-level road map for intelligent vehicle systems,” IEEE Trans. Veh. Technol., vol. 66, no. 6, pp. 4517–4533, Jun. 2017.

[35] M. Aldibaja, N. Suganuma, and K. Yoneda, “Improving localization accuracy for autonomous driving in snow-rain environments,” in Proc.IEEE/SICE Int. Symp. Syst. Integr. (SII), Dec. 2016, pp. 212–217.

[36] M. Aldibaja, N. Suganuma, and K. Yoneda, “Robust intensity-based localization method for autonomous driving on snow–wet road surface,”IEEE Trans. Ind. Informat., vol. 13, no. 5, pp. 2369–2378,Oct. 2017.

[37] R. W. Wolcott and R. M. Eustice, “Fast LIDAR localization using multiresolution Gaussian mixture maps,” in Proc. IEEE Int. Conf.Robot. Automat. (ICRA), Seattle, WA, USA, May 2015, pp. 2814–2821.

[38] Y. Hu, J. Gong, Y. Jiang, L. Liu, G. Xiong, and H. Chen, “Hybrid map-based navigation method for unmanned ground vehicle in urban scenario,” Remote Sens., vol. 5, no. 8, pp. 3662–3680, Jul. 2013.

[39] B. Wu et al., “A voxel-based method for automated identification and morphological parameters estimation of individual street trees from mobile laser scanning data,” Remote Sens., vol. 5, no. 2, pp. 584–611, Jan. 2013.

[40] A. Schlichting and C. Brenner, “Vehicle localization by lidar point correlation improved by change detection,” ISPRS Int. Arch. Photogramm.,Remote Sens. Spatial Inf. Sci., vol. 41, pp. 703–710, Jun. 2016.

[41] T.-D. Vu, J. Burlet, and O. Aycard, “Grid-based localization and local mapping with moving object detection and tracking,” Inf. Fusion,vol. 12, no. 1, pp. 58–69, Jan. 2011.

[42] R. Wang et al., “A robust registration method for autonomous driving pose estimation in urban dynamic environment using LiDAR,” Electronics, vol. 8, no. 1, p. 43, Jan. 2019.

[43] N. Akai, L. Y. Morales, E. Takeuchi, Y. Yoshihara, and Y. Ninomiya, “Robust localization using 3D NDT scan matching with experimentally determined uncertainty and road marker matching,” in Proc.IEEE Intell. Vehicles Symp. (IV), Los Angeles, CA, USA, Jun. 2017, pp. 1356–1363.

[44] C. Ulas and H. Temeltas, “A fast and robust feature-based scanmatching method in 3D SLAM and the effect of sampling strategies,” Int. J. Adv. Robotic Syst., vol. 10, no. 11, p. 396, Nov. 2013.

[45] L. Li, M. Yang, C. Wang, and B. Wang, “Hybrid filtering framework based robust localization for industrial vehicles,” IEEE Trans. Ind. Informat., vol. 14, no. 3, pp. 941–950, Mar. 2018.

[46] D. Vivet, F. Gérossier, P. Checchin, L. Trassoudaine, and R. Chapuis, “Mobile ground-based radar sensor for localization and mapping:An evaluation of two approaches,” Int. J. Adv. Robotic Syst., vol. 10,no. 8, p. 307, Aug. 2013.

[47] E. Ward and J. Folkesson, “Vehicle localization with low cost radar sensors,” in Proc. IEEE Intell. Vehicles Symp. (IV), Jun. 2016, pp. 864–870.

[48] M. Rapp, M. Hahn, M. Thom, J. Dickmann, and K. Dietmayer, “Semi-Markov process based localization using radar in dynamic environments,”in Proc. IEEE 18th Int. Conf. Intell. Transp. Syst., Sep. 2015,pp. 423–429.

[49] K. Yoneda, N. Hashimoto, R. Yanase, M. Aldibaja, and N. Suganuma,“Vehicle localization using 76 GHz omnidirectional millimeter-wave radar for winter automated driving,” in Proc. IEEE Intell. Vehicles Symp. (IV), Jun. 2018, pp. 971–977.

[50] F. Schuster, M. Worner, C. G. Keller, M. Haueis, and C. Curio, “Robust localization based on radar signal clustering,” in Proc. IEEE Intell. Vehicles Symp. (IV), Jun. 2016, pp. 839–844.

[51] M. Rapp, M. Barjenbruch, M. Hahn, J. Dickmann, and K. Dietmayer, “Probabilistic ego-motion estimation using multiple automotive radar sensors,” Robot. Auton. Syst., vol. 89, pp. 136–146, Mar. 2017.

[52] M. Rapp, M. Barjenbruch, K. Dietmayer, M. Hahn, and J. Dickmann, “A fast probabilistic ego-motion estimation framework for radar,” in Proc. Eur. Conf. Mobile Robots (ECMR), Sep. 2015, pp. 1–6.

[53] M. Cornick, J. Koechling, B. Stanley, and B. Zhang, “Localizing ground penetrating RADAR: A step toward robust autonomous ground vehicle localization,” J. Field Robot., vol. 33, no. 1, pp. 82–102, Jan. 2016.

[54] O. De Silva, G. K. I. Mann, and R. G. Gosine, “An ultrasonic and vision-based relative positioning sensor for multirobot localization,”IEEE Sensors J., vol. 15, no. 3, pp. 1716–1726, Mar. 2015.

[55] J.-I. Rejas, A. Sanchez, G. Glez-de-Rivera, M. Prieto, and J. Garrido,“Environment mapping using a 3D laser scanner for unmanned ground vehicles,” Microprocessors Microsyst., vol. 39, no. 8, pp. 939–949, Nov. 2015.

[56] M. Moussa, A. Moussa, and N. El-Sheimy, “Ultrasonic based heading estimation for aiding land vehicle navigation in GNSS denied environment,” ISPRS Int. Arch. Photogramm., Remote Sens. Spatial Inf. Sci., vol. 42, pp. 315–322, Sep. 2018.

[57] A. Y. Hata and D. F. Wolf, “Feature detection for vehicle localization in urban environments using a multilayer LIDAR,” IEEE Trans. Intell. Transp. Syst., vol. 17, no. 2, pp. 420–429, Feb. 2016.

[58] J. Breßler and M. Obst, “GNSS positioning in non-line-of-sight context—A survey for technological innovation,” Adv. Sci., Technol. Eng. Syst. J., vol. 2, no. 3, pp. 722–731, Jun. 2017.

[59] P. D. Groves, L. Wang, D. Walter, H. Martin, K. Voutsis, and Z. Jiang, “The four key challenges of advanced multisensor navigation and positioning,” in Proc. IEEE/ION Position, Location Navigat. Symp.(PLANS), Monterey, CA, USA, May 2014, pp. 773–792.

[60] M. Schreiber, H. Konigshof, A.-M. Hellmund, and C. Stiller, “Vehicle localization with tightly coupled GNSS and visual odometry,” in Proc. IEEE Intell. Vehicles Symp. (IV), Jun. 2016, pp. 858–863.

[61] S. G. Park and D. J. Cho, “Smart framework for GNSS-based navigation in urban environments,” Int. J. Satell. Commun. Netw., vol. 35, no. 2, pp. 123–137, Mar. 2017.

[62] S. Peyraud et al., “About non-line-of-sight satellite detection and exclusion in a 3D map-aided localization algorithm,” Sensors, vol. 13, no. 1, pp. 829–847, Jan. 2013.

[63] A. Amini, R. M. Vaghefi, J. M. de la Garza, and R. M. Buehrer, “Improving GPS-based vehicle positioning for intelligent transportation systems,” in Proc. IEEE Intell. Vehicles Symp., Jun. 2014, pp. 1023–1029.

[64] R. M. Vaghefi, M. R. Gholami, R. M. Buehrer, and E. G. Strom, “Cooperative received signal strength-based sensor localization with unknown transmit powers,” IEEE Trans. Signal Process., vol. 61, no. 6, pp. 1389–1403, Mar. 2013.

[65] W. Lu, S. A. Rodríguez F., E. Seignez, and R. Reynaud, “Lane markingbased vehicle localization using low-cost GPS and open source map,” Unmanned Syst., vol. 3, no. 4, pp. 239–251, Oct. 2015.

[66] M. Adjrad and P. D. Groves, “Enhancing least squares GNSS positioning with 3D mapping without accurate prior knowledge,” Navigation, vol. 64, no. 1, pp. 75–91, Mar. 2017.

[67] R. Kumar and M. G. Petovello, “A novel GNSS positioning technique for improved accuracy in urban canyon scenarios using 3D city model,” in Proc. 27th Int. Tech. Meeting Satell. Division Inst. Navigat. (ION GNSS), Sep. 2014, pp. 8–12.

[68] J. Gim and C. Ahn, “IMU-based virtual road profile sensor for vehicle localization,” Sensors, vol. 18, no. 10, p. 3344, Oct. 2018.

[69] W. M. H. W. Azree, M. A. A. Rahman, and H. Zamzuri, “Vehicle localization using wheel speed sensor (WSS) and inertial measurement unit (IMU),” J. Soc. Automot. Eng. Malaysia, vol. 2, no. 10, pp. 43–59, 2018.

[70] X. Li, R. Jiang, X. Song, and B. Li, “A tightly coupled positioning solution for land vehicles in urban canyons,” J. Sensors, vol. 2017, pp. 1–11, Mar. 2017.

[71] K.-W. Chiang, T. Duong, and J.-K. Liao, “The performance analysis of a real-time integrated INS/GPS vehicle navigation system with abnormal GPS measurement elimination,” Sensors, vol. 13, no. 8, pp. 10599–10622, Aug. 2013.

[72] S. Wang, Z. Deng, and G. Yin, “An accurate GPS-IMU/DR data fusion method for driverless car based on a set of predictive models and grid constraints,” Sensors, vol. 16, no. 3, p. 280, Feb. 2016.

[73] Z. Xiao, V. Havyarimana, T. Li, and D. Wang, “A nonlinear framework of delayed particle smoothing method for vehicle localization under non-Gaussian environment,” Sensors, vol. 16, no. 5, p. 692, May 2016.

[74] I. Belhajem, Y. B. Maissa, and A. Tamtaoui, “Improving low cost sensor based vehicle positioning with machine learning,” Control Eng. Pract., vol. 74, pp. 168–176, May 2018.

[75] B.-H. Lee, J.-H. Song, J.-H. Im, S.-H. Im, M.-B. Heo, and G.-I. Jee, “GPS/DR error estimation for autonomous vehicle localization,” Sensors, vol. 15, no. 8, pp. 20779–20798, Aug. 2015.

[76] D. Gruyer and E. Pollard, “Credibilistic IMM likelihoodupdating applied to outdoor vehicle robust ego-localization,” in Proc. 14th Int. Conf. Inf. Fusion, Jul. 2011, pp. 1–8.

[77] A. Dean, R. Martini, and S. Brennan, “Terrain-based road vehicle localisation using particle filters,” Vehicle Syst. Dyn., vol. 49, no. 8, pp. 1209–1223, Aug. 2011.

[78] E. I. Laftchiev, C. M. Lagoa, and S. N. Brennan, “Vehicle localization using in-vehicle pitch data and dynamical models,” IEEE Trans. Intell. Transp. Syst., vol. 16, no. 1, pp. 206–220, Feb. 2015.

[79] N. Piasco, D. Sidibé, C. Demonceaux, and V. Gouet-Brunet, “A survey on visual-based localization: On the benefit of heterogeneous data,” Pattern Recognit., vol. 74, pp. 90–109, Feb. 2018.

[80] S. Sivaraman and M. M. Trivedi, “Looking at vehicles on the road: A survey of vision-based vehicle detection, tracking, and behavior analysis,” IEEE Trans. Intell. Transp. Syst., vol. 14, no. 4, pp. 1773–1795, Dec. 2013.

[81] S. Houben, M. Neuhausen, M. Michael, R. Kesten, F. Mickler, and F. Schuller, “Park marking-based vehicle self-localization with a fisheye topview system,” J. Real-Time Image Process., vol. 16, no. 2, pp. 289–304, Apr. 2019.

[82] X. Du and K. K. Tan, “Vision-based approach towards lane line detection and vehicle localization,” Mach. Vis. Appl., vol. 27, no. 2, pp. 175–191, Feb. 2016.

[83] Z. Xiao, K. Jiang, S. Xie, T. Wen, C. Yu, and D. Yang, “Monocular vehicle self-localization method based on compact semantic map,” in Proc. 21st Int. Conf. Intell. Transp. Syst. (ITSC), Maui, HI, USA, Nov. 2018, pp. 3083–3090.

[84] K. Yoneda, R. Yanase, M. Aldibaja, N. Suganuma, and K. Sato, “Monocamera based localization using digital map,” in Proc. 43rd Annu. Conf. IEEE Ind. Electron. Soc. (IECON), Beijing, China, Oct. 2017, pp. 8285–8290.

[85] K. Yoneda, R. Yanase, M. Aldibaja, N. Suganuma, and K. Sato, “Mono-camera based vehicle localization using Lidar intensity map for automated driving,” Artif. Life Robot., vol. 24, no. 2, pp. 147–154, Jun. 2019.

[86] A. Viswanathan, B. R. Pires, and D. Huber, “Vision-based robot localization across seasons and in remote locations,” in Proc. IEEE Int. Conf. Robot. Automat. (ICRA), Stockholm, Sweden, May 2016, pp. 4815–4821.

[87] T. Naseer, W. Burgard, and C. Stachniss, “Robust visual localization across seasons,” IEEE Trans. Robot., vol. 34, no. 2, pp. 289–302, Apr. 2018.

[88] C. Li, Z. Hu, Z. Li, Y. Ma, and M. A. Sotelo, “Multiscale site matching for vision-only self-localization of intelligent vehicles,” IEEE Intell. Transp. Syst. Mag., vol. 10, no. 3, pp. 170–183, Jun. 2018.

[89] H.-Y. Lin, C.-W. Yao, K.-S. Cheng, and V. L. Tran, “Topological map construction and scene recognition for vehicle localization,” Auto. Robots, vol. 42, no. 1, pp. 65–81, Jan. 2018.

[90] N. Pous, D. Gingras, and D. Gruyer, “Intelligent vehicle embedded sensors fault detection and isolation using analytical redundancy and nonlinear transformations,” J. Control Sci. Eng., vol. 2017, pp. 1–10, Jan. 2017.

[91] V. Judalet, S. Glaser, D. Gruyer, and S. Mammar, “IMM-based sensor fault detection and identification for a drive-by-wire vehicle,” IFACPapersOnLine, vol. 48, no. 21, pp. 1158–1164, 2015.

[92] V. Judalet, S. Glaser, D. Gruyer, and S. Mammar, “Fault detection and isolation via the interacting multiple model approach applied to driveby- wire vehicles,” Sensors, vol. 18, no. 7, p. 2332, Jul. 2018.

[93] N. Pous, D. Gruyer, and D. Gingras, “Fault detection architecture for proprioceptive sensors based on a multi model approach and fuzzy logic decisions,” in Proc. 1st Int. Conf. Vehicle Technol. Intell. Transp. Syst., May 2015, pp. 25–32.

[94] G. Zhang, W. Wen, and L.-T. Hsu, “A novel GNSS based V2V cooperative localization to exclude multipath effect using consistency checks,” in Proc. IEEE/ION Position, Location Navigat. Symp. (PLANS), Monterey, CA, USA, Apr. 2018, pp. 1465–1472.

[95] S. Fujii et al., “Cooperative vehicle positioning via V2V communications and onboard sensors,” in Proc. IEEE Veh. Technol. Conf. (VTC Fall), Sep. 2011, pp. 1–5.

[96] M. Shen, J. Sun, and D. Zhao, “The impact of road configuration in V2V-based cooperative localization: Mathematical analysis and realworld evaluation,” IEEE Trans. Intell. Transp. Syst., vol. 19, no. 10, pp. 3220–3229, Oct. 2018.

[97] M. Rohani, D. Gingras, V. Vigneron, and D. Gruyer, “A new decentralized Bayesian approach for cooperative vehicle localization based on fusion of GPS and VANET based inter-vehicle distance measurement,” IEEE Intell. Transp. Syst. Mag., vol. 7, no. 2, pp. 85–95, Apr. 2015.

[98] K. Golestan, F. Sattar, F. Karray, M. Kamel, and S. Seifzadeh, “Localization in vehicular ad hoc networks using data fusion and V2V communication,” Comput. Commun., vol. 71, pp. 61–72, Nov. 2015.

[99] L. Altoaimy and I. Mahgoub, “Fuzzy logic based localization for vehicular ad hoc networks,” in Proc. IEEE Symp. Comput. Intell. Vehicles Transp. Syst. (CIVTS), Dec. 2014, pp. 121–128.

[100] L. Rivoirard, M. Wahl, P. Sondi, D. Gruyer, and M. Berbineau,“A cooperative vehicle ego-localization application using V2V communications with CBL clustering,” in Proc. IEEE Intell. Vehicles Symp. (IV), Jun. 2018, pp. 722–727.

[101] G. Soatti, M. Nicoli, N. Garcia, B. Denis, R. Raulefs, and H. Wymeersch, “Implicit cooperative positioning in vehicular networks,” IEEE Trans. Intell. Transp. Syst., vol. 19, no. 12, pp. 3964–3980, Dec. 2018.

[102] M. Shen, J. Sun, H. Peng, and D. Zhao, “Improving localization accuracy in connected vehicle networks using Rao–Blackwellized particle filters: Theory, simulations, and experiments,” IEEE Trans. Intell. Transp. Syst., vol. 20, no. 6, pp. 1–12, Sep. 2018.

[103] S. Nam, D. Lee, J. Lee, and S. Park, “CNVPS: Cooperative neighboring vehicle positioning system based on vehicle-to-vehicle communication,” IEEE Access, vol. 7, pp. 16847–16857, 2019.

[104] Y.-S. Byun, R.-G. Jeong, and S.-W. Kang, “Vehicle position estimation based on magnetic markers: Enhanced accuracy by compensation of time delays,” Sensors, vol. 15, no. 11, pp. 28807–28825, Nov. 2015.

[105] Y. Byun and Y. Kim, “Localization based on magnetic markers for an all-wheel steering vehicle,” Sensors, vol. 16, no. 12, p. 2015, Nov. 2016.

[106] J. Wang, D. Ni, and K. Li, “RFID-based vehicle positioning and its applications in connected vehicles,” Sensors, vol. 14, no. 3, pp. 4225–4238, Mar. 2014.

[107] H. Qin, Y. Peng, and W. Zhang, “Vehicles on RFID: Error-cognitive vehicle localization in GPS-less environments,” IEEE Trans. Veh. Technol., vol. 66, no. 11, pp. 9943–9957, Nov. 2017.

[108] X. Wang, M. Huang, C. Shen, and D. Meng, “Robust vehicle localization exploiting two based stations cooperation: A MIMO radar perspective,” IEEE Access, vol. 6, pp. 48747–48755, 2018.

[109] H. Zarza, S. Yousefi, and A. Benslimane, “RIALS: RSU/INSaided localization system for GPS-challenged road segments,” Wireless Commun. Mobile Comput., vol. 16, no. 10, pp. 1290–1305, Jul. 2016.

[110] J. Li, J. Gao, H. Zhang, and T. Z. Qiu, “RSE-assisted lanelevel positioning method for a connected vehicle environment,” IEEE Trans. Intell. Transp. Syst., vol. 20, no. 7, pp. 1–13, Oct. 2018.

[111] N. Alam, A. T. Balaei, and A. G. Dempster, “An instantaneous lanelevel positioning using DSRC carrier frequency offset,” IEEE Trans.Intell. Transp. Syst., vol. 13, no. 4, pp. 1566–1575, Dec. 2012.

[112] C.-H. Ou, “A roadside unit-based localization scheme for vehicular ad hoc networks,” Int. J. Commun. Syst., vol. 27, no. 1, pp. 135–150, Jan. 2014.

[113] J. Vales-Alonso, F. Vicente-Carrasco, and J. J. Alcaraz, “Optimal configuration of roadside beacons in V2I communications,” Comput. Netw., vol. 55, no. 14, pp. 3142–3153, Oct. 2011.

[114] K. Jo, K. Chu, and M. Sunwoo, “Interacting multiple model filterbased sensor fusion of GPS with in-vehicle sensors for real-time vehicle positioning,” IEEE Trans. Intell. Transp. Syst., vol. 13, no. 1, pp. 329–343, Mar. 2012.

[115] Q. Xu, X. Li, and C.-Y. Chan, “A cost-effective vehicle localization solution using an interacting multiple model–unscented Kalman filters (IMM-UKF) algorithm and grey neural network,” Sensors, vol. 17, no. 6, p. 1431, Jun. 2017.

[116] A. N. Ndjeng, D. Gruyer, S. Glaser, and A. Lambert, “Low cost IMU– odometer–GPS ego localization for unusual maneuvers,” Inf. Fusion, vol. 12, no. 4, pp. 264–274, Oct. 2011.

[117] R. Vivacqua, R. Vassallo, and F. Martins, “A low cost sensors approach for accurate vehicle localization and autonomous driving application,” Sensors, vol. 17, no. 10, p. 2359, Oct. 2017.

[118] R. P. D. Vivacqua, M. Bertozzi, P. Cerri, F. N. Martins, and R. F. Vassallo, “Self-localization based on visual lane marking maps: An accurate low-cost approach for autonomous driving,” IEEE Trans. Intell. Transp. Syst., vol. 19, no. 2, pp. 582–597, Feb. 2018.

[119] A. Bak, D. Gruyer, S. Bouchafa, and D. Aubert, “Multi-sensor localization-visual odometry as a low cost proprioceptive sensor,” in Proc. 15th Int. IEEE Conf. Intell. Transp. Syst., Sep. 2012, pp. 1365–1370.

[120] J. Godoy, D. Gruyer, A. Lambert, and J. Villagra, “Development of an particle swarm algorithm for vehicle localization,” in Proc. IEEE Intell. Vehicles Symp., Jun. 2012, pp. 1114–1119.

[121] N. Nedjah and L. de Macedo Mourelle, Swarm Intelligent Systems. Berlin, Germany: Springer, 2006.

[122] A. R. A. Bacha, D. Gruyer, and A. Lambert, “A robust hybrid multisource data fusion approach for vehicle localization,” Positioning, vol. 4, no. 4, pp. 271–281, 2013.

[123] A. R. A. Bacha, D. Gruyer, and A. Lambert, “A performance test fora new reactive-cooperative filter in an ego-vehicle localization application,” in Proc. IEEE Intell. Vehicles Symp., Jun. 2014, pp. 548–554.

[124] A. R. A. Bacha, D. Gruyer, and A. Lambert, “OKPS: A reactive/ cooperative multi-sensors data fusion approach designed for robust vehicle localization,” Positioning, vol. 7, no. 1, pp. 1–20, 2016.

[125] A. Lambert, D. Gruyer, B. Vincke, and E. Seignez, “Consistent outdoor vehicle localization by bounded-error state estimation,” in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., Oct. 2009, pp. 1211–1216.

[126] B. Vincke, A. Lambert, D. Gruyera, A. Elouardi, and E. Seignez, “Static and dynamic fusion for outdoor vehicle localization,” in Proc. 11th Int. Conf. Control Automat. Robot. Vis., Dec. 2010, pp. 437–442.

[127] I. K. Kueviakoe, A. Lambert, and P. Tarroux, “A real-time interval constraint propagation method for vehicle localization,” in Proc. 16thInt. IEEE Conf. Intell. Transp. Syst., Oct. 2013, pp. 1707–1712.

[128] K. Kueviakoe, Z. Wang, A. Lambert, E. Frenoux, and P. Tarroux, “Localization of a vehicle: A dynamic interval constraint satisfaction problem-based approach,” J. Sensors, vol. 2018, pp. 1–12, Apr. 2018.

[129] Z. Wang and A. Lambert, “A low-cost consistent vehicle localization based on interval constraint propagation,” J. Adv. Transp., vol. 2018, pp. 1–15, Jun. 2018.

[130] Z. Wang, A. Lambert, and X. Zhang, “Dynamic ICSP graph optimization approach for car-like robot localization in outdoor environments,” Computers, vol. 8, no. 3, p. 63, Sep. 2019.

[131] X. Li, W. Chen, C. Chan, B. Li, and X. Song, “Multi-sensor fusion methodology for enhanced land vehicle positioning,” Inf. Fusion,vol. 46, pp. 51–62, Mar. 2019.

[132] J. K. Suhr, J. Jang, D. Min, and H. G. Jung, “Sensor fusion-based low-cost vehicle localization system for complex urban environments,” IEEE Trans. Intell. Transp. Syst., vol. 18, no. 5, pp. 1078–1086, May 2017.

[133] H. Cai, Z. Hu, G. Huang, D. Zhu, and X. Su, “Integration of GPS, monocular vision, and high definition (HD) map for accurate vehicle localization,” Sensors, vol. 18, no. 10, p. 3270, Sep. 2018.

[134] D. Gruyer, R. Belaroussi, and M. Revilloud, “Map-aided localization with lateral perception,” in Proc. IEEE Intell. Vehicles Symp., Jun. 2014, pp. 674–680.

[135] D. Gruyer, R. Belaroussi, and M. Revilloud, “Accurate lateral positioning from map data and road marking detection,” Expert Syst. Appl., vol. 43, pp. 1–8, Jan. 2016.

[136] G. Bresson, M. Rahal, D. Gruyer, M. Revilloud, and Z. Alsayed “A cooperative fusion architecture for robust localization: Application to autonomous driving,” in Proc. IEEE 19th Int. Conf. Intell. Transp. Syst., Nov. 2016, pp. 859–866.

[137] G. Wan et al., “Robust and precise vehicle localization based on multisensor fusion in diverse city scenes,” in Proc. IEEE Int. Conf. Robot. Automat. (ICRA), May 2018, pp. 4670–4677.

[138] T. Zhang, K. Wu, J. Song, S. Huang, and G. Dissanayake, “Convergence and consistency analysis for a 3-D invariant-EKF SLAM,” IEEE Robot. Autom. Lett., vol. 2, no. 2, pp. 733–740, Apr. 2017.

[139] F. Bounini, D. Gingras, H. Pollart, and D. Gruyer, “From simultaneous localization and mapping to collaborative localization for intelligent vehicles,” IEEE Intell. Transp. Syst. Mag., early access, Mar. 3, 2020, doi: 10.1109/MITS.2019.2926368.

[140] Y. Zhang, T. Zhang, and S. Huang, “Comparison of EKF based SLAMand optimization based SLAM algorithms,” in Proc. 13th IEEE Conf. Ind. Electron. Appl. (ICIEA), May 2018, pp. 1308–1313.

[141] B. Mourllion, D. Gruyer, A. Lambert, and S. Glaser, “Kalman filters predictive steps comparison for vehicle localization,” in Proc. IEEE/RSJ Int. Conf. Intell. Robots Syst., Aug. 2005, pp. 565–571.

[142] D. Gruyer, A. Lambert, M. Perrollaz, and D. Gingras, “Experimentalcomparison of Bayesian positioning methods based on multi-sensor data fusion,” Int. J. Vehicle Auton. Syst., vol. 12, no. 1, pp. 24–43, 2014.

[143] J. M. Bedkowski and T. Röhling, “Online 3D LIDAR Monte Carlolocalization with GPU acceleration,” Ind. Robot, Int. J., vol. 44, no. 4, pp. 442–456, Jun. 2017.

[144] A. Ernest, E. Mensah, and A. Gilbert, “Qualitative assessment of compiled, interpreted and hybrid programming languages,” Commun.Appl. Electron., vol. 7, no. 7, pp. 8–13, Oct. 2017.

[145] T. Andrews, “Computation time comparison between MATLAB and C++ using launch windows,” California Polytech. State Univ., San Luis Obispo, CA, USA, Tech. Rep., 2012.

[146] SPEC. (2017). SPEC CPU 2006. [Online]. Available: https://www.spec.org/cpu2006/

[147] N. S. H. M. Ali and S. M. E. Babiker, “Performance evaluation of multi-core systems using SPEC CPU2006 benchmark,” J. Basic Appl. Sci., vol. 2, no. 2, Apr. 2017.

[148] SPEC. (2017). SPECfp2006. [Online]. Available: https://www.spec. org/cpu2006/results/cfp2006.html

[149] B. Charmette, E. Royer, and F. Chausse, “Efficient planar features matching for robot localization using GPU,” in Proc. IEEE Comput. Soc. Conf. Comput. Vis. Pattern Recognit. (Workshops), Jun. 2010,pp. 16–23.

[150] S. B. Aruoba and J. Fernández-Villaverde, “A comparison of programming languages in macroeconomics,” J. Econ. Dyn. Control, vol. 58, pp. 265–273, Sep. 2015.

[151] Vehicle Safety Communications Project: Task 3 Final Report: Identify Intelligent Vehicle Safety Applications Enabled by DSRC, C. V. S. C. Consortium, Nat. Highway Traffic Saf. Admin., US Dept. Transp., Washington, DC, USA, 2005.

[152] J. Fayyad, M. A. Jaradat, D. Gruyer, and H. Najjaran, “Deep learning sensor fusion for autonomous vehicle perception and localization: A review,” Sensors, vol. 20, no. 15, p. 4220, Jul. 2020.

转载自自动驾驶之心,文中观点仅供分享交流,不代表本公众号立场,如涉及版权等问题,请您告知,我们将及时处理。

-- END --