以下文章来源于英特尔物联网 ,作者杨雪锋

01

简介

《在 AI 爱克斯开发板上用 OpenVINO™ 加速 YOLOv8 目标检测模型》介绍了在 AI 爱克斯开发板上使用 OpenVINO™ 开发套件部署并测评 YOLOv8 的目标检测模型,本文将介绍在 AI 爱克斯开发板上使用 OpenVINO™ 加速 YOLOv8-seg 实例分割模型。

请先下载本文的范例代码仓,并搭建好 YOLOv8 的 OpenVINO™ 推理程序开发环境。

git clone

https://gitee.com/ppov-nuc/yolov8_openvino.git

02

导出 YOLOv8-seg 实例分割

OpenVINO™ IR 模型

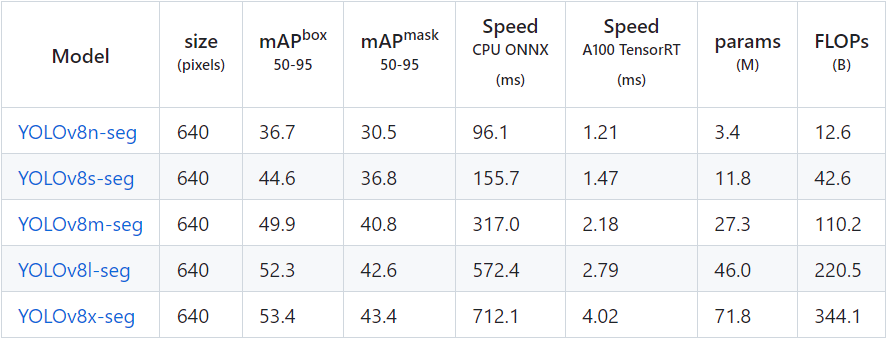

YOLOv8-seg 的实例分割模型有5种,在 COCO 数据集完成训练,如下表所示。

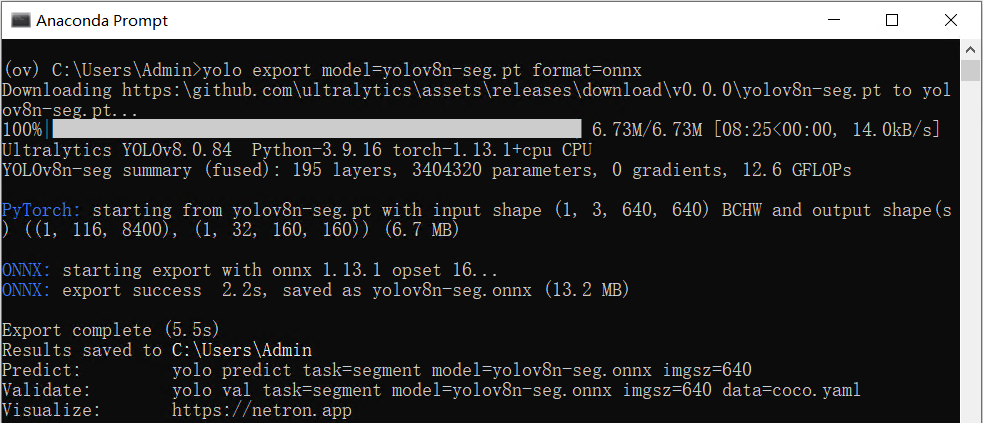

首先使用命令:

yolo export model=yolov8n-seg.pt format=onnx

完成 yolov8n-seg.onnx 模型导出,如下图所示:

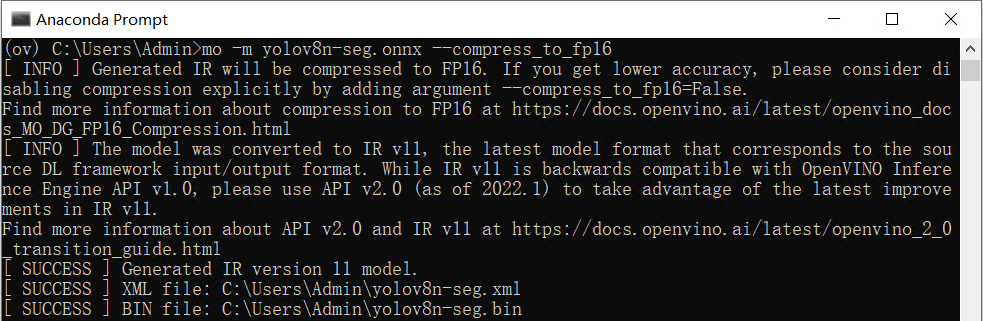

然后使用命令:

mo -m yolov8n-seg.onnx --compress_to_fp16

优化并导出 FP16 精度的 OpenVINO™ IR 格式模型,如下图所示:

03

用 benchmark_app 测试

YOLOv8-seg 实例分割模型的推理计算性能

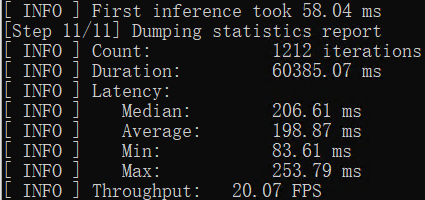

benchmark_app 是 OpenVINO™ 工具套件自带的 AI 模型推理计算性能测试工具,可以指定在不同的计算设备上,在同步或异步模式下,测试出不带前后处理的纯 AI 模型推理计算性能。

使用命令:

benchmark_app -m yolov8n-seg.xml -d GPU

获得 yolov8n-seg.xml 模型在 AI 爱克斯开发板的集成显卡上的异步推理计算性能,如下图所示:

04

使用 OpenVINO™ Python API 编写

YOLOv8-seg 实例分割模型推理程序

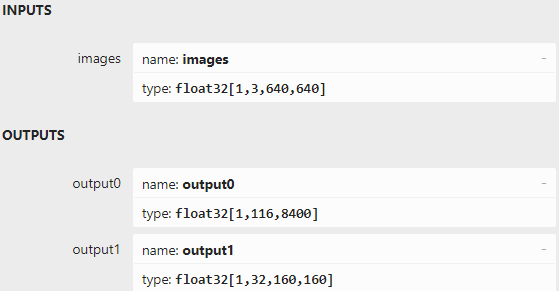

用 Netron 打开 yolov8n-seg.onnx 可以看到模型的输入和输出,跟 YOLOv5-seg 模型的输入输出定义很类似:

输入节点名字:“images”;

数据:float32[1,3,640,640]

输出节点 1 的名字:“output0”;

数据:float32[1,116,8400]。其中 116 的前 84 个字段跟 YOLOv8 目标检测模型输出定义完全一致,即cx,cy,w,h 和 80 类的分数;后 32 个字段用于计算掩膜数据。

输出节点 2 的名字:“output1”;

数据:float32[1,32,160,160]。output0 后 32 个字段与 output1 的数据做矩阵乘法后得到的结果,即为对应目标的掩膜数据。

基于 OpenVINO™ Python API 的 YOLOv8-seg 实例分割模型范例程序 yolov8_seg_ov_sync_infer_demo.py 的核心源代码,如下所示:

cap = cv2.VideoCapture("store-aisle-detection.mp4")model_path = "yolov8n-seg.xml"device_name = "GPU"yoloseg = YOLOSeg(model_path, device_name, conf_thres=0.3, iou_thres=0.3)while cap.isOpened():ret, frame = cap.read()if not ret:breakstart = time.time()boxes, scores, class_ids, masks = yoloseg(frame)combined_img = yoloseg.draw_masks(frame)end = time.time()fps = (1 / (end - start))fps_label = "Throughput: %.2f FPS" % fpscv2.putText(combined_img, fps_label, (10, 25), cv2.FONT_HERSHEY_SIMPLEX, 1, (0, 0, 255), 2)cv2.imshow("YOLOv8 Segmentation OpenVINO inference Demo", combined_img)if cv2.waitKey(1) > -1:print("finished by user")break

向右滑动查看完整代码

运行结果,如下图所示:

向右滑动查看完整图片

05

结论

AI 爱克斯开发板 借助 N5105 处理器的集成显卡(24个执行单元)和 OpenVINO™ ,可以在 YOLOv8-seg 的实例分割模型上获得相当不错的性能。

通过异步处理和 AsyncInferQueue ,还能进一步提升计算设备的利用率,提高 AI 推理程序的吞吐量。