大语言模型(LLM)和人工智能应用程序(如 ChatGPT 和 DALL-E)最近出现了快速增长。由于 GPU、CPU、DPU、高速存储和针对人工智能优化的软件创新,人工智能现在得到了广泛使用。您甚至可以在云端或内部部署人工智能。

然而,人工智能应用程序可能会对网络造成很大负担,这种增长给 CPU 和 GPU 服务器以及将这些系统连接到一起的现有底层网络基础设施带来了负担。

传统以太网虽然足以处理主流和企业应用程序,如 Web、视频或音频流,但并未针对支持新一代人工智能工作负载进行优化。在松耦合应用、低带宽数据流和高抖动的情况下,传统以太网是理想的选择。它可能足以满足异构流量(如 Web、视频或音频流、文件传输和游戏),但在发生超额订阅时并不理想。

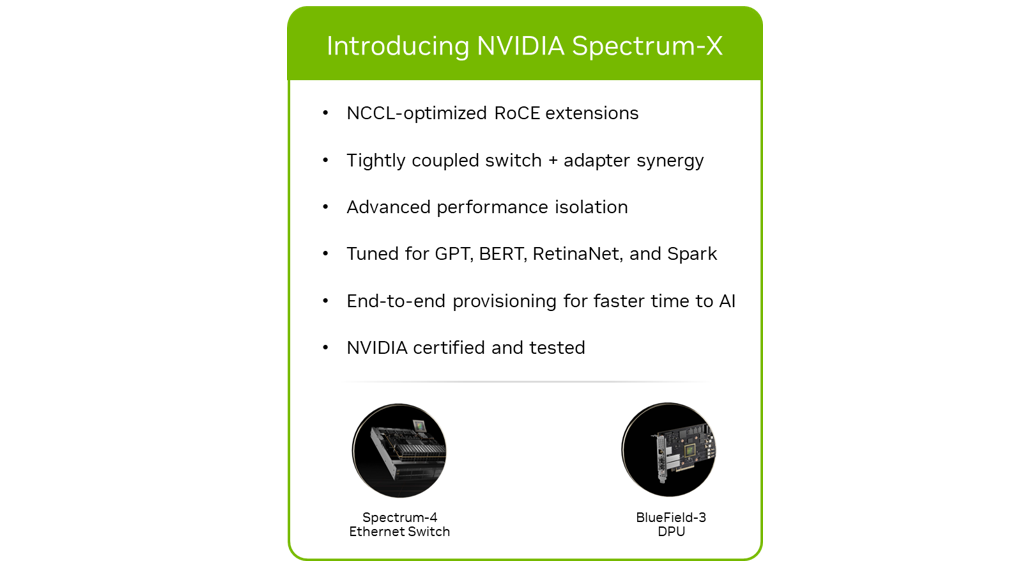

NVIDIA Spectrum-X 网络平台是一种端到端解决方案,专为满足人工智能应用程序的性能需求而全新设计,并针对高速网络性能、低延迟和规模进行了优化。

NVIDIA Spectrum-X

NVIDIA Spectrum-X 网络平台是为了解决传统以太网网络的局限性而开发的。它是一种网络架构,旨在满足要求苛刻的人工智能应用程序的需求,用于实现紧耦合的过程。

这种经过 NVIDIA 认证和测试的端到端解决方案结合了一流的人工智能优化网络硬件和软件,可提供人工智能工作负载所需的可预测的、一致的和毫不妥协的性能水平。

图 1:NVIDIA Spectrum-X 网络平台将 NVIDIA Spectrum-4 以太网交换机与 NVIDIA BlueField-3 DPU 相结合,为 AI 工作负载提供最佳性能

NVIDIA Spectrum-X 是一种高度通用的技术,可用于各种人工智能应用程序。具体而言,它可以在以下用例中显著提高 AI 集群的性能和效率:

GPT 和 BERT 大型语言模型

分布式训练和并行处理

自然语言处理(NLP)

计算机视觉

高性能模拟(NVIDIA Omniverse 和 NVIDIA OVX)

高性能数据分析(Spark)

推理应用程序

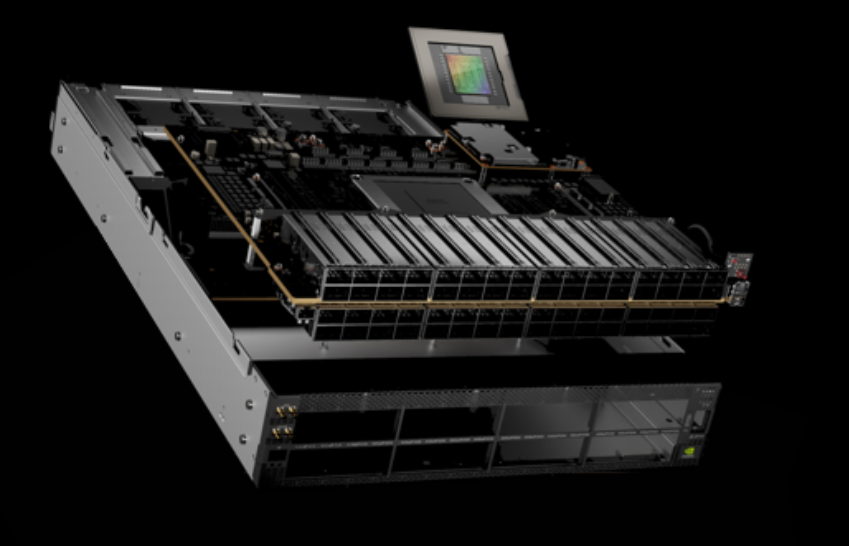

NVIDIA Spectrum-X 平台的两个关键元素是NVIDIA Spectrum-4 以太网交换机和 NVIDIA BlueField-3 DPU。

NVIDIA Spectrum-4 以太网交换机

NVIDIA Spectrum-4 以太网交换机为基于标准的以太网构建的 AI 集群提供了前所未有的应用程序性能。要充分发挥 NVIDIA Spectrum-4 的潜力,需要端到端的、专门构建的网络架构。只有 NVIDIA Spectrum-X 平台才能提供支持超大规模人工智能所需的硬件加速器和卸载。

NVIDIA Spectrum-4 以太网交换机基于 51.2Tbps 的 Spectrum-4 ASIC 而构建,带宽是上一代产品的 4 倍。它是全球首款以太网人工智能交换平台。它专为人工智能工作负载而设计,将专用的高性能架构与标准以太网连接相结合。

NVIDIA Spectrum-4 提供:

RoCE 扩展:具有独特增强功能的 RoCE

RoCE 自适应路由

RoCE 性能隔离

简化、自动化的自适应路由和 RoCE 配置

同步集合

用于 HPC 增强的其他 RoCE 功能

大规模以太网上的最高有效带宽

低延迟、低抖动和短尾

确定性性能和性能隔离

全栈和端到端优化

NVIDIA Cumulus Linux 或 SONiC

图 2 : NVIDIA Spectrum-4 将专用的高性能架构与标准以太网连接相结合

NVIDIA Spectrum-X 与 NVIDIA Spectrum-4 的主要优势包括:

将 RoCE 扩展用于 AI 和自适应路由(AR),以实现 NVIDIA 集合通信库(NCCL)的最大性能。

利用性能隔离来确保在多租户和多作业环境中,一个作业不会影响另一个作业。

确保在出现网络组件故障时,网络架构能够继续提供最高性能。

与 BlueField-3 DPU 同步,实现最佳 NCCL 和 AI 性能。

在各种人工智能工作负载下保持一致和稳定的性能,这对实现 SLA 至关重要。

端到端最佳网络性能

要构建有效的人工智能计算网络架构,需要优化人工智能网络的每一个部分,从 DPU 到交换机再到网络软件。使用 RoCE 自适应路由和高级拥塞控制机制等技术,在负载和规模需求下实现最高有效带宽。结合在 NVIDIA BlueField-3 DPU 和 Spectrum-4 交换机上同步工作的功能对于实现 AI 网络架构的最高性能和可靠性至关重要。

RoCE 自适应路由

人工智能工作负载和应用程序的特点是少量大象流负责 GPU 之间的大量数据移动,其中尾部延迟严重影响整个应用程序的性能。使用传统的网络路由机制来迎合这种流量模式可能会导致 AI 工作负载的 GPU 性能不一致且未得到充分利用。

RoCE 自适应路由是一种细粒度的负载均衡技术。它动态地重新路由 RDMA 数据以避免拥塞,并提供最佳负载均衡以实现最高的有效数据带宽。

它是一种端到端功能,包括 Spectrum-4 交换机和 BlueField-3 DPU 。Spectrum-4 交换机负责为每个数据包选择最不拥塞的端口进行数据传输。由于同一流的不同数据包通过网络的不同路径来传输,它们可能会无序到达目的地。BlueField-3 在 RoCE 传输层转换任何无序数据,透明地将有序数据传递给应用程序。

Spectrum-4 根据出口队列负载评估拥塞,确保所有端口都很好地均衡。对于每个网络数据包,交换机都会在其出口队列中选择负载最小的端口。Spectrum-4 还接收来自相邻交换机的状态通知,这会影响路由决策。所评估的队列与服务质量级别相匹配。

因此,NVIDIA Spectrum-X 能够在超大规模系统的负载和规模下实现高达 95% 的有效带宽。

图 3 :NVIDIA Spectrum-4 典型数据中心部署结构

RoCE 拥塞控制

由于网络层面的拥塞,在超大规模云系统上并发运行的应用程序可能会出现性能下降和可重复运行时间缩短的问题。这可能是由应用程序本身的网络流量或来自其他应用程序的后台网络流量引起的。这种拥塞的主要原因被称为多对一拥塞,即存在多个数据发送方和单一数据接收方。

这种拥塞不能使用自适应路由来解决,并且实际上需要对每个端点的数据流进行计量。拥塞控制是一种端到端的技术,Spectrum-4 交换机提供代表实时拥塞数据的网络遥测信息。这些遥测信息由 BlueField DPU 处理,后者管理和控制数据发送方的数据注入速率,从而实现网络共享的最大效率。

如果没有拥塞控制,多对一的场景将导致网络背压和拥塞扩散,甚至出现丢包,从而极大地降低网络和应用程序的性能。

在拥塞控制过程中,BlueField-3 DPU 执行拥塞控制算法。它们以微秒的反应延迟每秒处理数百万个拥塞控制事件,并应用细粒度的速率决策。

Spectrum-4 交换机带内遥测既包含用于准确拥塞估计的排队信息,也包含用于快速恢复的端口利用率指示。NVIDIA RoCE 拥塞控制通过使遥测数据绕过拥塞流排队延迟,同时仍然提供准确和并发的遥测,从而显著改善了拥塞发现和反应时间。

RoCE 性能隔离

人工智能超大规模和云基础设施需要支持越来越多的用户(租户)和并行应用程序或工作流。这些用户和应用程序无意中竞争基础设施的共享资源(如网络),因此可能会影响性能。

NVIDIA Spectrum-X 平台包括一些机制,当它们结合在一起时,可以提供性能隔离。它确保一个工作负载不会影响另一个工作负荷的性能。这些机制确保任何工作负载都不会造成网络拥塞,从而影响另一个工作负载的数据移动。性能隔离机制包括服务质量隔离、用于数据路径扩展的 RoCE 自适应路由和 RoCE 拥塞控制。

NVIDIA Spectrum-X 平台具有软件和硬件的紧密集成功能,能够更深入地了解人工智能工作负载和流量模式。这样的基础设施提供了使用专用以太网 AI 集群进行大型工作负载测试的能力。通过利用来自 Spectrum 以太网交换机和 BlueField-3 DPU 的遥测技术,NVIDIA NetQ 可以主动检测网络问题并更快地解决网络问题,以优化网络容量的使用。

NVIDIA NetQ 网络验证和 ASIC 监控工具集提供了对网络健康状况和行为的可见性。NetQ 流遥测分析显示了数据流在穿越网络时所采用的路径,从而提供网络延迟和性能洞察。

提高能效

由于对计算资源的需求不断增长以及控制能源成本的需要,功率封顶已成为数据中心的一种常见做法。Spectrum-4 ASIC 和光学创新可简化网络设计,提高了每瓦的性能,实现了更高效率,并提供了更快的人工智能洞察,而不会超过网络功率预算。

总结

NVIDIA Spectrum-X 网络平台专为要求苛刻的人工智能应用而设计。与传统以太网相比,NVIDIA Spectrum-X 具有更高的性能、更低的功耗、更低的 TCO、全栈软硬件集成和大规模,它是运行现有和未来人工智能工作负载的理想平台。

观看下方视频

了解更多关于 NVIDIA Spectrum-X 的信息!