OpenAI于近日在其官方 Blog中确认 ChatGPT 5 将于 23Q4 推出。据其介绍,ChatGPT 5 是 OpenAI 开发的最先进的 GPT 语言模型,能通过更复杂、更细致的方式理解和生成自然语言,突破机器学习可能性的界限。4月7日,阿里云通过官方微信公众号对旗下的超大规模语言模型“通义千问”进行官宣,并面向企业开始了邀请测试。而在此之前,知名脱口秀演员鸟鸟在其官方微博发布视频,展示了一款接入了 AI 语音助手版本的天猫精灵。4月8日,华为云 AI 首席科学家田奇在人工智能大模型技术高峰论坛上介绍了人工智能能的发展趋势,以及华为盘古大模型的架构以及应用场景,并介绍了其在矿山、铁路、气象、医药分子等细分行业的应用。下载链接:

GPT-5发布时间确认,国内大模型进展不断(2023)《ChatGPT系列报告合集(财通)》

1、ChatGPT系列之一:开启AI新纪元

2、ChatGPT系列之二:全球商业化落地加速,新一轮算力储备开启

3、ChatGPT系列之三:技术奇点已至,多模态时代开启

4、ChatGPT系列之四:国内巨头勇立潮头,大模型产业持续推进

5、ChatGPT 系列之五:算力为饷,应用为矛,安全为盾

人工智能深度报告:计算机视觉行业框架—AI之眼,初启商业飞轮

大模型算力需求驱动AI服务器行业高景气(2023)亮点一:GPT5 发布时间确认,阿里、华为大模型公布最新进展

OpenAI 确认 GPT5 将于 23Q4 发布。此前 OpenAI 于 3 月 26 日宣布 GPT 4.5 将于 9-10月期间推出,而今日其官方 Blog 确认 GPT 5 将于四季度公布。根据其官方介绍,ChatGPT 5 是 OpenAI 开发的最先进的 GPT 语言模型,能通过更复杂、更细致的方式理解和生成自然语言,突破机器学习可能性的界限。

国内方面,阿里、华为先后展示了旗下大模型的最新进展:阿里方面,4 月 7 日午后,阿里云通过官方微信公众号对旗下的超大规模语言模型进行官宣,并面向企业开始了邀请测试。而在此之前,知名脱口秀演员鸟鸟在其官方微博发布视频,展示了一款接入了 AI 语音助手版本的天猫精灵,通过“鸟鸟分鸟”演示了压缩版大模型在端侧应用的潜力。

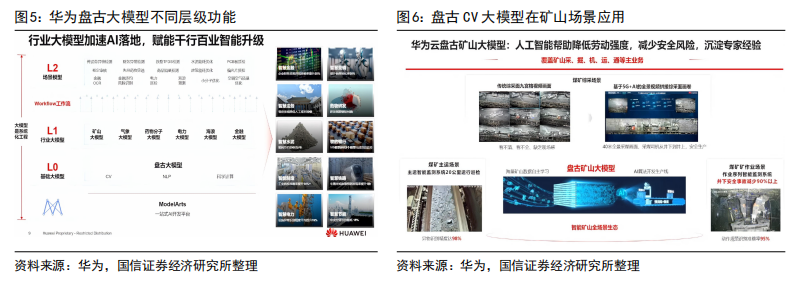

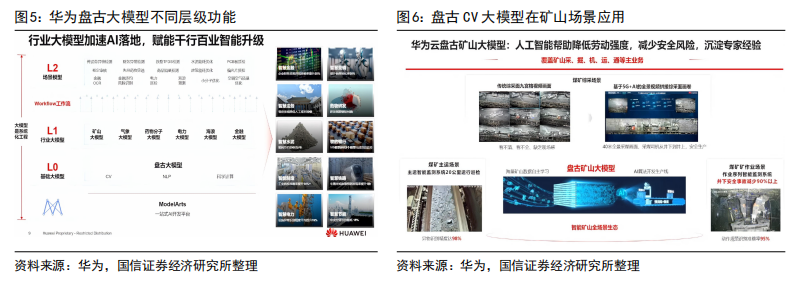

华为方面,4 月 8 日,华为云 AI 首席科学家田奇在人工智能大模型技术高峰论坛上介绍了人工智能能的发展趋势,以及华为盘古大模型的架构以及应用场景,并介绍了其在矿山、铁路、气象、医药分子等细分行业的应用。在此前发布的华为年报中,华为已宣布盘古矿山大模型在山东能源集团已正式商用。

亮点二:AI 驱动智算中心发展,底层基础设施充分受益

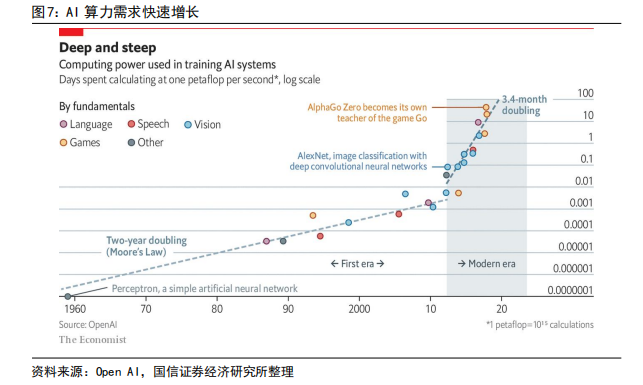

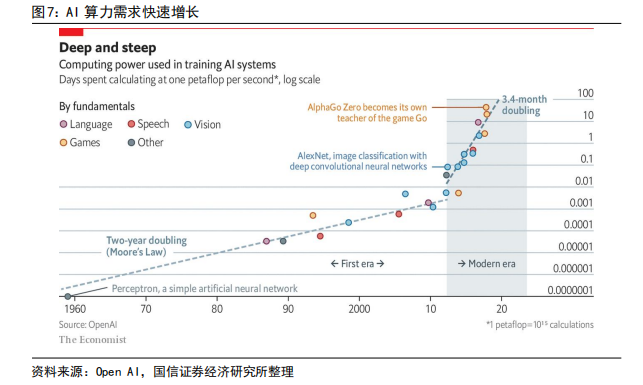

海内外巨头积极布局 AI,大模型应用离不开高算力的 AI 集群。ChatGPT 作为一种人工智能技术驱动的自然语言处理工具,通过连接大量的语料库来训练模型,做到人机交互等场景功能,背后需要大量的算力作为支撑。根据 Open AI 数据,目前 AI 训练的算力需求呈指数级增长——每 3.4 个月便可翻番。

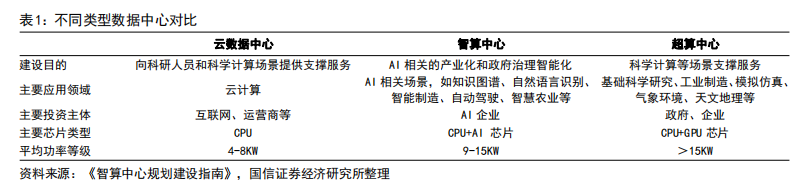

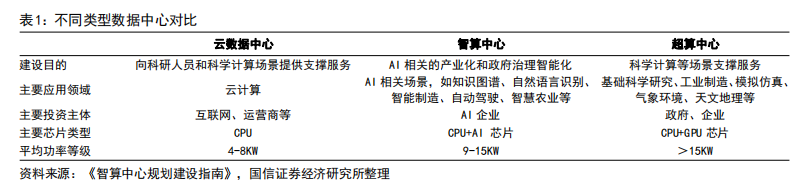

随着AI 发展,未来超算/智算中心的占比有望进一步提升:智能计算中心:服务于人工智能的数据计算中心,包括人工智能、机器学习、深度学习等需求,以 GPU 等 AI 训练芯片为主,为 AI 计算提供更大的计算规模和更快的计算速度,以提升单位时间单位能耗下的运算能力及质量为核心诉求;超算中心:为集中放置的超级计算机(由通用或专用的高性能硬件和软件组成的,为处理复杂的数据、算法和应用等提供算力的高性能计算平台提供运行环境的建筑场所)设备提供运行环境的场所。

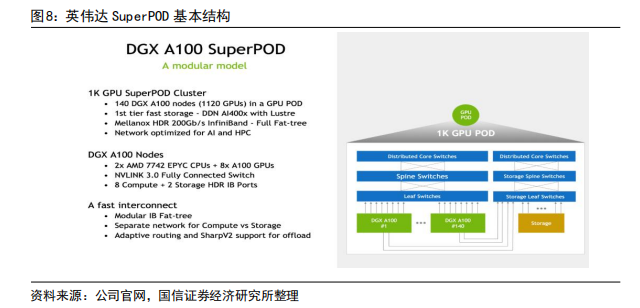

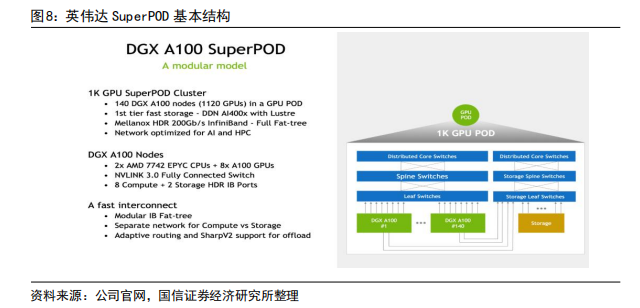

其中,核心底层基础设施包括服务器、交换机、光模块等。对于较大的 AI 数据中心集群,一般可多达几千台 AI 服务器的需求,在部署上会拆分成数个基本单元。在英伟达 AI 集群模型中,一个基本单元为 SuperPOD。而一个标准的 SuperPOD 由140 台 DGX A100 GPU 服务器、HDR InfiniBand 200G 网卡和 170 台 NVIDIA QuantumQM8790 交换机构建而成,其中交换机速率为 200G,每个端口数为 40 个。

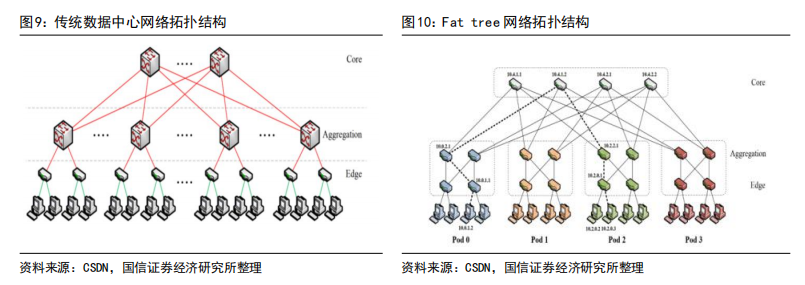

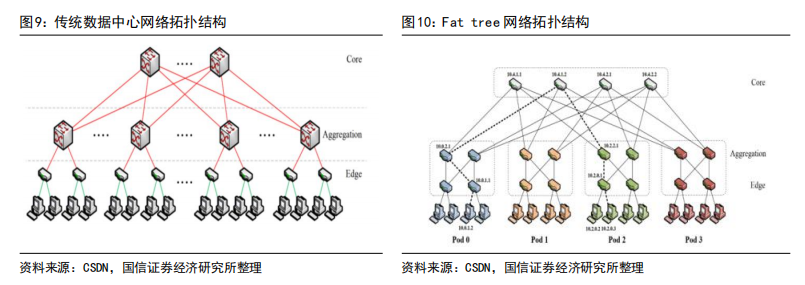

而英伟达 AI 集群的网络结构上,主要采用 Infinband 技术(“无限带宽”技术,简称 IB)和 fat tree(胖树)网络拓扑结构。和传统的数据中心的区别在于,在IB fat tree 结构下,使用的交换机数量更多,且因为每个节点上行下行的端口数完全一致,使得该网络是是无收敛带宽的,每个端口可采用同样速率的光模块。

亮点三:关注边缘智能发展

AI 处理长期来看有望向边缘侧发展。随着数字技术加速与经济、政治、文化、社会、生态文明建设的深度融合,物联网应用也持续升级,随着数据量的快速提升,边缘计算应用有望加速渗透。

芯片厂商预研技术,推动大模型端侧应用。芯片厂商积极预研前沿技术,支撑大模型在端侧的运行。例如高通通过对 AI 引擎和 AI 软件栈的更新,增强Transformer 等大模型模型的推理速度,已实现在端侧的独立运行——今年 2 月高通在 MWC 巴塞罗那演示了 Stabe Diffusion 在手机上实现 AI 绘图。更高的 AI算力能力也在逐渐从旗舰级芯片下放至主流产品,例如骁龙第二代 7+的 AI 性能大幅提升。无独有偶,华为 3 月 23 日举行的春季旗舰新品发布会,宣布华为 P60系列搭载了智慧搜图新功能,该能力是多模态大模型技术的应用,也反映了边缘智能的趋势。随着芯片厂商优化大模型在端侧芯片的运行能力,端侧的边缘 AI有望进一步发展,实现多模态大模型在边缘的应用。

下载链接:

从特斯拉、英伟达、Mobileye的视角,看智能驾驶芯片的竞争格局

Chiplet半导体行业弯道超车,先进封装、IC载板、半导体IP等多环节收益

AIGC专题:大模型+小样本,AI+传媒效力取决于适配与迭代

2023年AIGC(GPT-4)赋能通信行业应用白皮书

量子位智库AIGC产业全景图报告

物联网报告:AIoT芯片竞争赛道解析

算力网络与产业共变共创助力产业数字化变革(2023)

可扩展的AI基础架构技术白皮书

人工智能深度报告:计算机视觉行业框架—AI之眼,初启商业飞轮

173+篇ChatGPT技术干货

1、加入知识星球,获取160+篇ChatGPT技术干货,以及AI,芯片、计算等24细分技术领域独家干货,享受知识问答、每日内容更新等专属服务。

2、单独获取163+篇ChatGPT技术干货,内容持续更新(更新会自动同步至购买下载网址)链接:ChatGPT/AIGC技术合集(163+篇)本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。获取方式:点击“小程序链接”即可查看182页 PPT可编辑版本和PDF阅读版本详情。服务器基础知识全解PPT(终极版)

服务器基础知识全解PDF(终极版)

请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。