▲ 更多精彩活动 请点击上方蓝字关注我们吧!

“AI确实可能杀死人类。”

这话并非危言耸听,而是OpenAI CEO奥特曼的最新观点。

OpenAI CEO Sam Altman

而这番观点,是奥特曼在与MIT研究科学家Lex Fridman长达2小时的对话中透露。

不仅如此,奥特曼谈及了近期围绕ChatGPT产生的诸多问题,坦承就连OpenAI团队,也根本没搞懂它是如何“进化”的:

从ChatGPT开始,AI出现了推理能力。但没人能解读这种能力出现的原因。

唯一的途径是向ChatGPT提问,从它的回答中摸索它的思路。

包括特斯拉CEO马斯克、2018年图灵奖得主,“深度学习三巨头”之一Yoshua Bengio 在内的上千位产学研代表联名发表公开信“暂停巨型AI实验”,瞬间引起轩然大波。

信中强调:如果不迅速实施,那么政府应该介入强制执行。

我们熟知的一些大咖,比如Stability AI CEO、07年图灵奖得主、苹果联合创始人、多位DeepMind工程师也都赫然在列。

有网友表示:这是三体照进现实?降临派、拯救派和幸存派不是开玩笑的。

在这封联名公开信中,他们提出了三个方面的需求和建议举措:

首先、立即暂停比GPT-4更先进的AI系统训练,时间至少是6个月。

这一要求是覆盖了所有的人工智能实验室,尤其是这当中的关键参与者。

并且暂停举措必须是公开、可验证的。如果AI机构不能立即实施,那么政府应该介入强制执行。

其次,利用这段时间,开发和实施一套共享安全协议,用于高级人工智能设计和开发,并由独立外部专家进行严格审核和监督。

信中还明确指出:这并不意味着总体限制一般人工智能的发展,而是从目前危险的竞技中退后一步,避免更强大、更不可预测的黑箱模型和新兴能力出现。

人工智能的研究和发展,应该重新聚焦于朝着更准确、安全、可信可解释等的AI系统开发工作上来。

第三,开发者应同政策制定者一道,共同加速开发人工智能治理系统。这个治理系统至少包括:

- 注明出处和水印系统,帮助区分真实和合成、以及跟踪模型泄露;

在成功创造出强大的AI系统之后,我们现在享受一个“人工智能夏天”。但这个夏天希望能够漫长一点,需考虑到所有人的利益,并给社会一个适应的机会,暂停使用一些危害系统;而不是毫无准备地冲进“秋天”。这么做的原因,无非就是忌惮当前GPT-4的强大。毕竟连OpenAI老板奥特曼自己也承认:AI确实可能杀死人类。继LeCun之后,吴恩达、田渊栋等一众AI大牛也发文公开反对“千人联名”。做为人工智能和机器学习领域国际上最权威的学者之一,吴恩达表示,在GPT-4出现之后要求AI训练暂停6个月是很可怕的事情:它(GPT-4)在教育、医疗保健、食品等领域都有很多新的应用,这将帮助许多人。

在吴恩达的帖子里,除了上面提到的应用价值外,他还从竞争、风险以及AI发展的角度详细阐明了“为什么要反对暂停令”。首先是竞争方面,让第三方暂停他们不了解的新兴技术是反竞争的,树立了一个可怕的先例,是糟糕的创新政策。然后是AI风险,目前很多流媒体平台渲染的“AI公司疯狂发送不安全代码”是不正确的,绝大多数AI团队都十分注重人工智能的安全问题。最后再回到“6个月暂停令”本身,这并不是一个非常切实可行的建议,是在扼杀AI进步。要提高人工智能的安全性,应该是在安全方面进行更大的投资,有关透明度和审计的规定将更加切实可行。在吴恩达的帖子下面,Meta数据科学家林致远,英伟达AI研究科学家Jim Fan也都表示赞同。Meta FAIR研究院研究员/高级经理,CMU机器人系博士田渊栋也转发并附议,称“我不签暂停令”,并将AI的发展比作囚徒困境:

一旦开始,就没有办法停止或扭转这一趋势,这就是进化的必然。

应该换个角度继续向前看,更好地理解 LLM,适应它并利用其力量,感受热度。

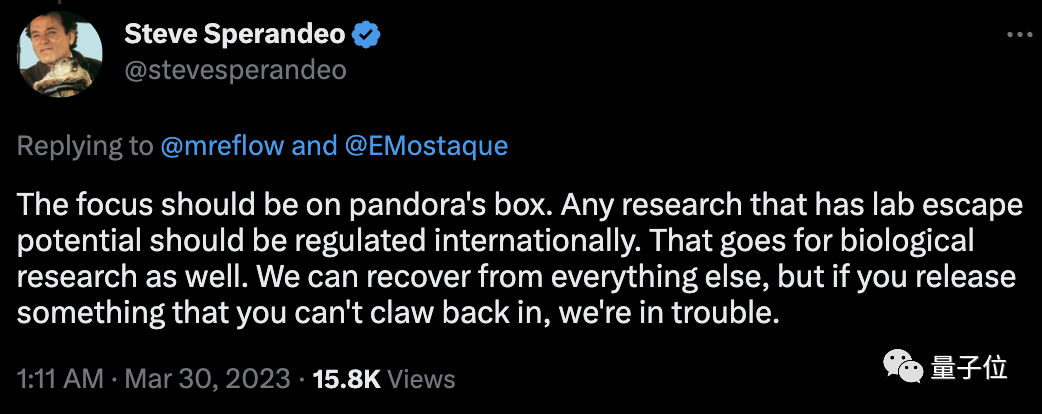

近日,人工智能领域内的 “叛逆者”、纽约大学心理学和神经科学荣誉教授 Gary Marcus 发文称,“我们需要停止担心机器人接管世界,而是更多地考虑那些坏人可能会利用 LLMs 做什么,以及我们可以做什么来阻止他们。”此前,Marcus 与马斯克等上千人联名呼吁 “所有人工智能实验室应立即暂停训练比 GPT-4 更强大的大模型,这一时间至少为 6 个月”。在 Marcus 看来,AI风险 ≠ AGI风险,尽管很多人将人工智能的风险等同于超级智能或 AGI 的风险,但并非只有超级智能才能造成严重的问题。如 Bing 和 GPT-4 等不可靠但被广泛部署的人工智能,也会对现实世界造成不可忽视的风险。虽说我们一众“看客”并不清楚“暂停令”的发起者或签署者们是不是有什么私心,但仅仅将这条呼吁归结为利益之争肯定是不全面的。那为什么他们要发起这项呼吁?为什么非得是暂停六个月呢?先是为什么要发起这项呼吁,在那封公开信“暂停巨型AI实验”已经有讲明一些原因。而为什么非要暂停六个月,或许可以从赞同的声音中窥探到一些其他答案。赞成的网友这边,有人称正是因为AI发展像“潘多拉的魔盒”,但目前还没有被打开,还有挽救的余地:任何具有实验室逃逸潜力的研究都应该受到国际监管,我们应该尽力去挽回,但如果你释放了一些无法挽回的东西,我们就有麻烦了。

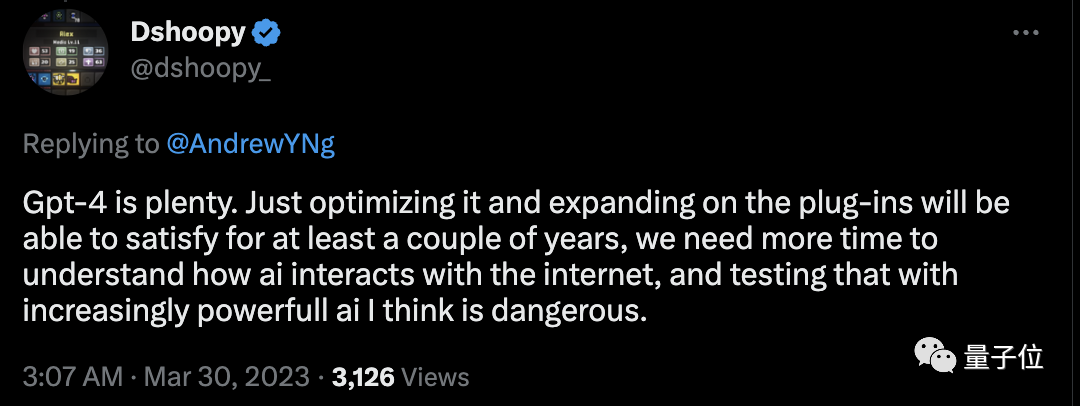

还有一种观点是,目前的AI发展成果已经足够人类使用,暂停几个月也无妨:GPT-4够用了,仅仅是优化它和扩展插件就能满足至少几年的需求,我们现在需要更多的时间来理解AI如何与互联网互动,并且我认为测试越来越强大的AI是危险的。

当然在这样一群争论中,还有一股清流,无所谓“AI安全”,他们自称降临派:对于这长达一天多的“是否暂停巨型AI实验”之争,网友一针见血地总结:但无论如何,对于“拯救派”们来说,依旧有几个问题不容忽视:为获美国芯片法案补贴,这些半导体企业需提交盈利预测

华为基本实现14nm以上EDA工具国产化,国产EDA第一股回应!

还在为玩不了ChatGPT苦恼?这十几个开源平替也能体验智能对话在公众号内回复您想搜索的任意内容,如问题关键字、技术名词、bug代码等,就能轻松获得与之相关的专业技术内容反馈。快去试试吧!如果您想经常看到我们的文章,可以进入我们的主页,点击屏幕右上角“三个小点”,点击“设为星标”。