在 ASR 自动语音识别领域,基于 CTC 的声学模型不再需要对训练的音频序列和文本序列进行强制对齐,实际上已经初步具备了端到端的声学模型建模能力。但是 CTC 模型进行声学建模存在着两个严重的瓶颈,一是缺乏语言模型建模能力,不能整合语言模型进行联合优化,二是 CTC 有一个不合理的假设:标签相互独立,这个基本假设与语音识别任务之间存在着一定程度的背离,因为在语言系统中存在语境的上下文关系。因此针对 CTC 的不足,Transducer 模型可以弥补这种不合理的假设,解决 CTC 的问题。

3 月 9 日,NVIDIA 企业开发者社区经理李奕澎将面向有 NLP 和 Speech AI 开发需求的开发者,在本次研讨会中重点讨论 Transducer 模型,并通过代码来训练和评估 Transducer 模型。

Transducer 模型在自动语音识别中的应用 – NVIDIA NeMo 代码解析

3 月 9 日,星期四,20:00 - 21:30

主要内容:

本次网络研讨会主要面向有 NLP 和 Speech AI 开发需求的开发者。通过本次网络研讨会,您可以获得以下信息:

Transducer 介绍

Transducer loss 的优势和局限

Transducer 的模型架构

ContextNet 的模型架构

Transducer 模型的训练和评估

演讲嘉宾

李奕澎 | NVIDIA 企业开发者社区经理

拥有多年数据分析建模、人工智能自然语言处理开发经验。在自动语音识别、自然语言处理、语音合成等对话式 AI 技术领域有丰富的实战经验与见解。曾开发法律、金融、保险文档中基于实体抽取的智能问答系统,曾开发基于 NLP 知识抽取,KG 知识图谱的建立的科研文档智能检索系统。

参与方式

识别二维码注册本次研讨会

相关资料

识别二维码了解 NVIDIA NeMo 更多信息

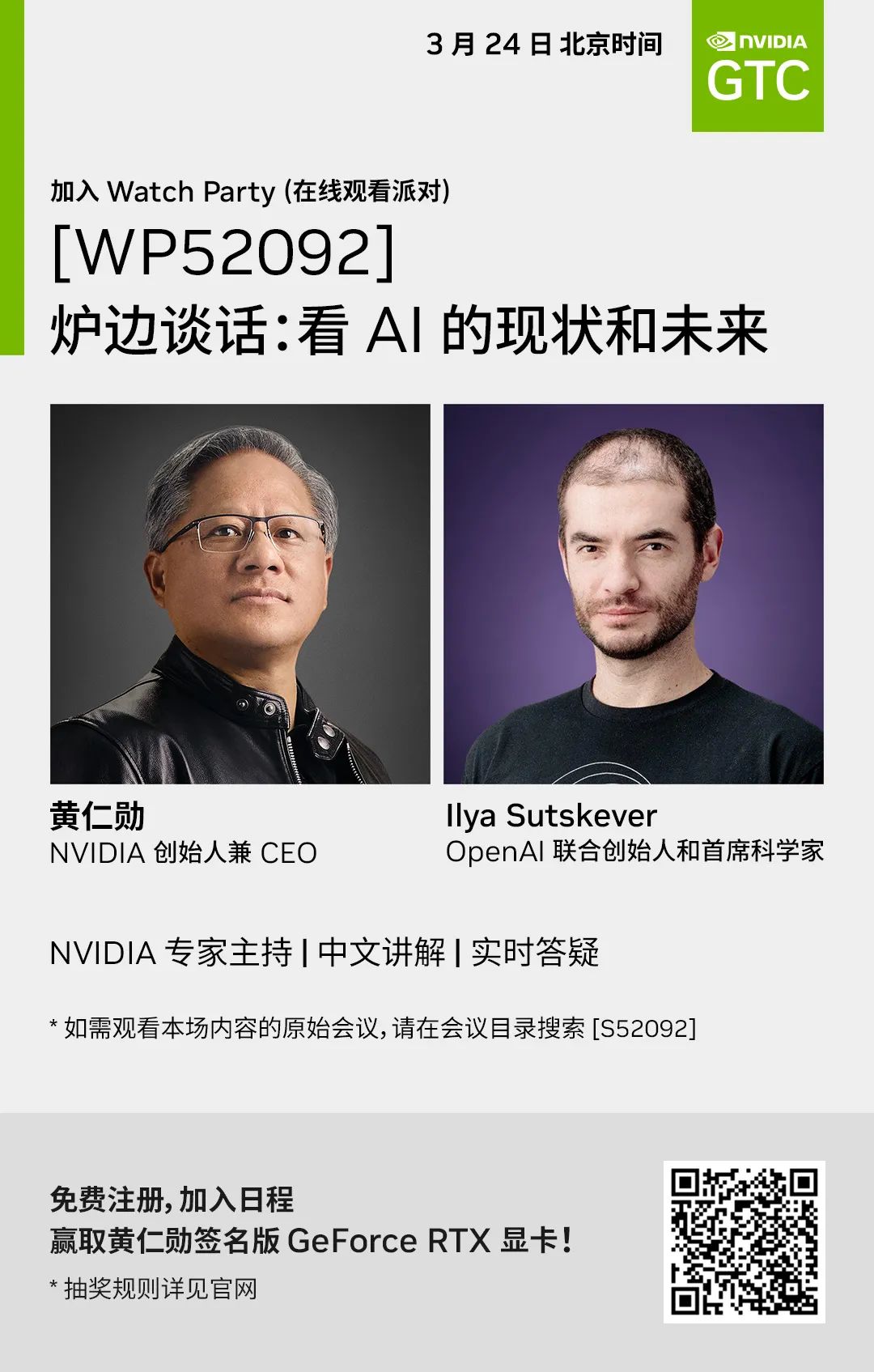

点击 “阅读原文” 或扫描下方海报二维码,即可免费注册 GTC23,在 3 月 24 日 听 OpenAI 联合创始人与 NVIDIA 创始人的炉边谈话,将由 NVIDIA 专家主持,配中文讲解和实时答疑,一起看 AI 的现状和未来!