最近,EnCharge AI宣布成功完成2170万美元A轮融资,由Anzu Partners、AlleyCorp、Scout Ventures、Silicon Catalyst Angels、Schams Ventures、E14 Fund和Alumni Ventures组成,用于推进其AI硬件加速器研发。

Encharge AI有望提升效率,其测试芯片在8-b计算下性能可达150 TOPS/W,与PyTorch和TF等流行的AI框架实现无缝软硬件集成。与同类AI加速器相比,其每瓦性能提高了20倍,每美元性能提高了14倍。

该公司最初通过DARPA的2017年电子复兴计划(ERI)获得研发资金。该计划的目标是推进美国国内的微电子设计,为国防工业和国防部安全性获得前沿电子产品的机会。

“加速人工智能硬件的创新,以更快地在边缘做出决策”是ERI投资的重点之一。

Encharge AI的领导团队包括:

普林斯顿大学电气和计算机工程教授Naveen Verma,他的研究重点是新兴技术;

Kailash Gopalakrishnan,IBM的研究员,领导全球人工智能硬件和软件的工作;

Echere Iroaga, MACOM连接业务部门前副总裁兼总经理。

内存计算

内存计算(In-memory Computing ,简称IMC)似乎是EnCharge AI实现高效率和低功耗的关键因素。该公司在其网站上列出了2019年、2020年和2021年的四份出版物,展示了他们在改善IMC用于人工智能加速方面的研究进展。

他们最早的出版物指出,机器学习计算严重依赖于矩阵向量乘法(MVM),虽然数字加速器相对于普通处理器提供了10-100倍的能效和速度改进,但这些收益主要是在计算方面,而不是在内存访问方面,即所谓的“内存墙”。在内存中来回移动数据在功耗和时间上都有很高的成本。

虽然IMC可以降低功耗和延迟,但在读取内存位时,需要权衡更差的信噪比(SNR)。信噪比问题在异构系统中对IMC的扩展提出了挑战,而异构系统是最有可能在实际应用中使用IMC的场景。

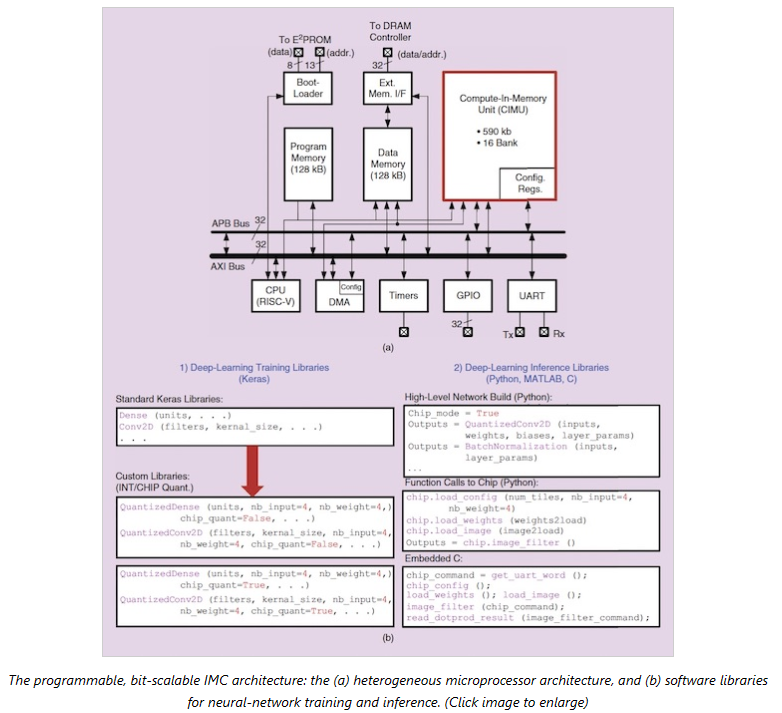

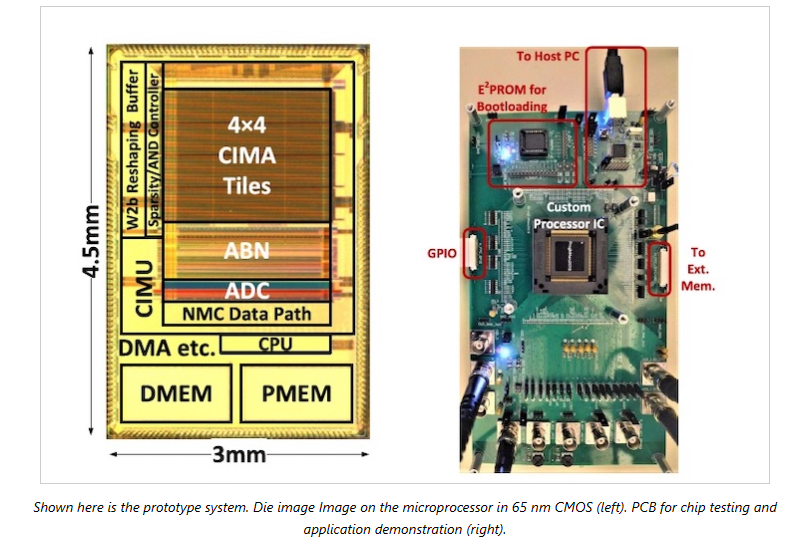

2020年,该研究团队致力于解决信噪比问题,开发了一种利用charge-domin IMC的可编程异构架构和配套的软件堆栈。原型基于65纳米CMOS实现。

2021年,该团队引入了基于电容模拟计算,以提高从二进制矢量输入到5-b矢量输入的动态范围,并在协同设计算法方面取得了进展,改善了内存映射。

未来发展

据报道,EnCharge AI虽然前景广阔,但目前还没有客户。此外,一些竞争公司在研发上也有进展,并被投资了大量资金。

一个例子是欧洲公司Alexera AI,该公司于2022年10月宣布获得2700万美元的A轮融资。像EnCharge AI一样,他们也支持内存计算和流行的AI框架。然而,与EnCharge AI不同的是,Alexera AI声称其效率为15 TOPS/W,而EnCharge AI承诺的效率为150 TOPS/W。

原文链接:

https://www.allaboutcircuits.com/news/encharge-ai-emerges-from-stealth-with-new-take-on-in-memory-compute/

高端微信群介绍 | |

创业投资群 | AI、IOT、芯片创始人、投资人、分析师、券商 |

闪存群 | 覆盖5000多位全球华人闪存、存储芯片精英 |

云计算群 | 全闪存、软件定义存储SDS、超融合等公有云和私有云讨论 |

AI芯片群 | 讨论AI芯片和GPU、FPGA、CPU异构计算 |

5G群 | 物联网、5G芯片讨论 |

第三代半导体群 | 氮化镓、碳化硅等化合物半导体讨论 |

存储芯片群 | DRAM、NAND、3D XPoint等各类存储介质和主控讨论 |

汽车电子群 | MCU、电源、传感器等汽车电子讨论 |

光电器件群 | 光通信、激光器、ToF、AR、VCSEL等光电器件讨论 |

渠道群 | 存储和芯片产品报价、行情、渠道、供应链 |

< 长按识别二维码添加好友 >

加入上述群聊

带你走进万物存储、万物智能、

万物互联信息革命新时代