图片来源:a-image/Shutterstock.com

深度学习依赖大量数据的迭代训练,进而发现数据中内在的特征(Feature),然后给出结果。这些特征中,有很多已经超越了人为定义的特征的表达能力,因此得以让深度学习在很多任务的表现上大大超越了其他机器学习算法,甚至超越了人类自己。

深度学习就是人工神经网络(Artificial Neural Network)。神经网络算法得名于其对于动物神经元传递信息方式的模拟,而深度学习这一“俗称”又来自于多层级联的神经元:众多的层让信息的传递实现了“深度”。

在动物身上,神经一端连接感受器,另一端连接大脑皮层,中间通过多层神经元传导信号。神经元之间也不是一对一连接,而是有多种连接方式(如辐射式、聚合式等),从而形成了网络结构。这一丰富的结构最终不仅实现了信息的提取,也使动物大脑产生了相应的认知。动物的学习过程则需要外界信息在大脑中的整合。外界信息进入神经系统,进而成为大脑皮层可以接收的信号;信号与脑中的已有信息进行比对,也就在脑中建立了完整的认知。

其实,模拟动物的神经活动,并非深度学习的专利。早在1957年,Frank Rosenblatt就提出了感知机(Perceptron)的概念。这是一种只能分出两类结果的单层神经网络。这种模型非常简单,输出结果与输入信息之间几乎就是一个“加权和”的关系。虽然权重会直接根据输出结果与真实值之间的差异自动调整,但是整个系统的学习能力有限,只能用于简单的数据拟合。

几乎与此同时,神经科学界出现了重大进展。神经科学家David Hubel和Torsten Wiesel对猫的视觉神经系统的研究证实,视觉特征在大脑皮层的反应是通过不同的细胞达成的。其中,简单细胞(Simple Cell)感知光照信息,复杂细胞(Complex Cell)感知运动信息。

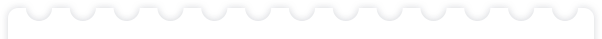

受此启发,1980年,日本学者福岛邦彦(Kunihiko Fukushima)提出了一个网络模型“神经认知机(Neocognitron)”(图1)用以识别手写数字。这种网络分成多层,每层由一种神经元组成。在网络内部,两种神经元交替出现,分别用以提取图形信息和组合图形信息。这两种神经元到后来演化成了重要的卷积层(Convolution Layer)和提取层(Pooling Layer)。但是这个网络的神经元都是由人工设计而成,其神经元也不会根据结果进行自动调整,因此也就不具有学习能力,只能限制在识别少量简单数字的初级阶段。

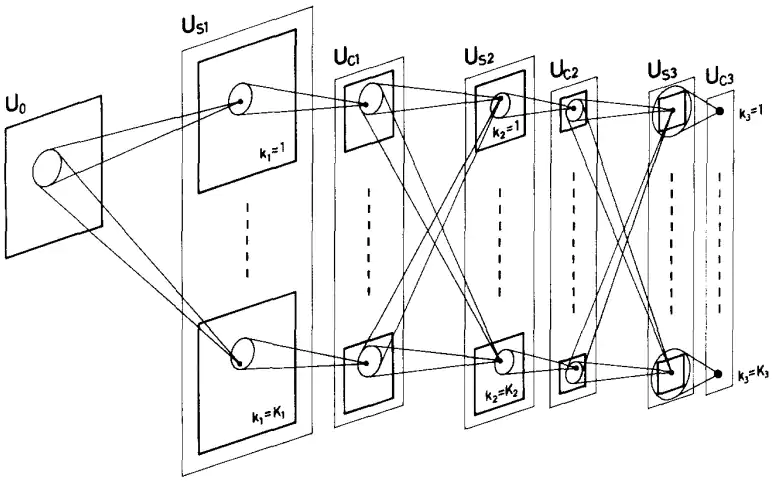

尽管如此,深度学习并没有因此而热门。原因之一,就是神经网络需要更新大量参数(仅2012年提出的AlexNet就需要65万个神经元和6000万个参数),需要强大的数据和算力的支持(图2)。而如果想通过降低网络的层数来降低数据量和训练时间,其效果也就不如其他的机器学习方法(比如2000年前后大行其道的支持向量机,Support Vector Machine)。2006年Geoffrey Hinton的另一篇论文首度使用了“深度网络”的名称(Deep Belief Nets),为整个神经网络的优化提供了途径。虽然为后面深度学习的炙手可热奠定了基础,但是之所以用“深度网络”而避开之前“神经网络”的名字,就是因为主流研究已经不认可“神经网络”,甚至到了看见相关标题就拒收论文的程度。

深度学习的转折发生在2012年。在计算机视觉领域,科学家也逐渐注意到了数据规模的重要性。2010年,斯坦福大学的计算机系副教授李飞飞(Li Fei-Fei)发布了图像数据库ImageNet,共包含上千万张经过人工标记过的图片,分属于1000个类别,涵盖动物、植物、生活等方方面面。2010—2017年,计算机视觉领域每年都会举行基于这些图片的分类竞赛,ImageNet也因此成为全世界视觉领域机器学习和深度学习算法的试金石。2012年,Geoffrey Hinton在多伦多大学的学生,Alex Krizhevsky,在ImageNet的分类竞赛中,通过在两块NVIDIA显卡(GPU)上编写神经网络算法而获得了冠军,而且其算法的识别率大幅超过第二名。这个网络随后被命名为AlexNet。这是深度学习腾飞的开始。

年份 |

2012 |

2013 |

2014 |

2014 |

2015 |

2016 |

2017 |

网络 |

AlexNet |

ZFNet |

VGGNet |

GoogLeNet |

ResNet |

ResNeXt |

SENet |

Top5错误率 |

15.32% |

13.51% |

7.32% |

6.67% |

3.57% |

3.03% |

2.25% |

层数 |

8 |

8 |

16 |

22 |

152 |

152 |

154 |

参数量 |

60M |

60M |

138M |

7M |

60M |

44M |

67M |

01

第一,从结构上看,神经网络的类型会变得更加多样。其中,可以执行卷积神经网络逆向过程的生成对抗网络(Generative Adversarial Network)从2016年被提出以来发展迅速,成为了深度学习一个重要的“增长点”。由于深度学习算法可以从原始信息(如图像)中提取特征,那么其逆过程逻辑上也是可行的,即利用一些杂乱的信号通过特定神经网络来生成相应的图像。于是,计算机科学家Ian Good fellow提出了生成对抗网络。这个网络除了能生成图像的生成器(Generator)之外,还提供了一个判别器(Discriminator)。在训练过程中,生成器趋于学习出一个让计算机难以分辨的、极度逼近真实的生成图片,判别器趋于学习出强大的判定真实图片和生成图片的能力。二者对抗学习,生成图片做得越真实,判别器就会越难分辨;判别器能力越强,也就促使生成器生成新的、更加真实的图片。生成对抗网络在人脸生成和识别、图像分辨率提升、视频帧率提升、图像风格迁移等领域中都有着广泛的应用。

02

第二,研究的问题趋于多样。一方面,一些在机器学习其他分支中的概念,如强化学习(Reinforcement Learning)、迁移学习(Transfer Learning),在深度学习中找到了新的位置。另一方面,深度学习本身的研究也从“工程试错”向“理论推导”发展。深度学习一直因其缺少理论基础而饱受诟病,在训练过程中几乎完全依赖数据科学家的经验。为了减少经验对结果的影响,以及减少选择超参数的时间,除了对最初经典网络结构的修改,研究者们也在从根本上修正深度学习的效率。一些研究者在试图联系其他机器学习的方法(比如压缩感知、贝叶斯理论等),用以使深度学习从工程的试错变为有理论指导下的实践。还有一些研究在试图解释深度学习算法的有效性,而不只是把整个网络当做一个黑盒子。与此同时,研究者也在针对超参数建立另一个机器学习的问题,即元学习(Meta Learning),以降低选择超参数过程的难度和随机性。

03

第三,随着大量研究成果的新鲜出炉,更多的算法也被应用于产品中。除了一些小规模的公司陆续开发了图像生成小程序,大公司们也在竞相抢占深度学习这一高地。互联网巨头Google、Facebook和Microsoft都先后成立了深度学习的发展中心,中国的互联网公司百度、阿里巴巴、腾讯、京东以及字节跳动等也都各自成立了自己的深度学习研究中心。一些基于深度学习技术的独角兽公司,如DeepMind、商汤、旷视等,也从大量竞争者中脱颖而出。2019年以来,产业界的深度学习研究也渐渐地从关注论文发表转变到了落地的项目。比如腾讯AI Lab对视频播放进行优化,比如依图制作的肺结节筛查已经在国内的一些医院试点。

04

第四,随着5G技术的逐渐普及,深度学习会跟云计算一起嵌入日常生活。深度学习这项技术一直难以落地的原因是计算资源的匮乏。一台配备合适显卡的超级计算机的成本可以达到50万人民币,而并不是所有公司都有充足的资金和能够充分使用这些设备的人才。而随着5G技术的普及,以及云技术的加持,公司可以通过租用的方式,低成本地从云中直接获得计算资源。公司可以将数据上传到云端,并且几乎实时地收到云端传回的计算结果。一大批新兴的创业公司正在想办法利用这些基础设施:他们召集了一批计算机科学家和数据科学家,为其他公司提供深度学习算法支持和硬件支持。这使得一些之前跟计算机技术关系不大的行业(比如制造业、服务业、娱乐业,甚至法律行业),不再需要自己定义问题、研发方案,而是通过与算法公司合作便利地享受到计算机技术行业的专业支持,也因此更容易获得深度学习的赋能。

在五十多年的历程中,深度学习经过了从雏形到成熟、从简单到复杂的发展,在学术界和业界积累了大量理论和技术。现在,深度学习的发展方向趋向于多元化。这一方面是因为大量产品正处于研发阶段,另一方面计算机科学家也在做一些关于深度学习的更加细致的研究。

当然,作为一个综合性的学科,除了以图像识别为核心的发展历程,深度学习在语音分析和自然语言处理上也有其各自的发展过程。同时,多种神经网络、多媒体形态的结合,正在成为研究的热点。比如结合图像和语言处理的自动给图片配字幕(Image Captioning)就是一个具有挑战的课题。

作者:王东昂

该发布文章为独家原创文章,转载请注明来源。对于未经许可的复制和不符合要求的转载我们将保留依法追究法律责任的权利。

贸泽电子设计圈由贸泽电子(Mouser Electronics)开发和运营,服务全球广大电子设计群体。贸泽电子原厂授权分销超过800家知名品牌,可订购500多万种在线产品,为客户提供一站式采购平台,欢迎关注我们,获取第一手的设计与产业资讯信息!