人工智能算法需要在计算机设备上实现,而芯片又是计算机设备运作的核心零件,因此AI芯片的发展主要依赖两个领域:第一个是模仿人脑建 立的数学模型与算法,第二个是半导体集成电路即芯片。优质的算法需要足够的运算能力也就是高性能芯片的支持。

本文参考自“中国人工智能芯片行业研究报告(2022)”,报告从行业发展现状、行业解读、行业挑战与机遇等多个维度进行分析。

下载链接:

中国人工智能芯片行业研究报告(2022)

2022年国产服务器CPU研究框架

2021-2022年中国人工智能产业创业与投资报告

SOC芯片研究框架(2022)

《Chiplet延续摩尔定律系列合集》

1、Chiplet延续摩尔定律:先进制程替代之路

2、Chiplet延续摩尔定律,芯片测试与封装有望获益

3、半导体Chiplet引领封测行业新机遇

4、破局后摩尔时代:Chiplet重塑半导体产业链价值

5、后摩尔时代:Chiplet与先进封装

2022年中国AI工业质检行业产业链分析

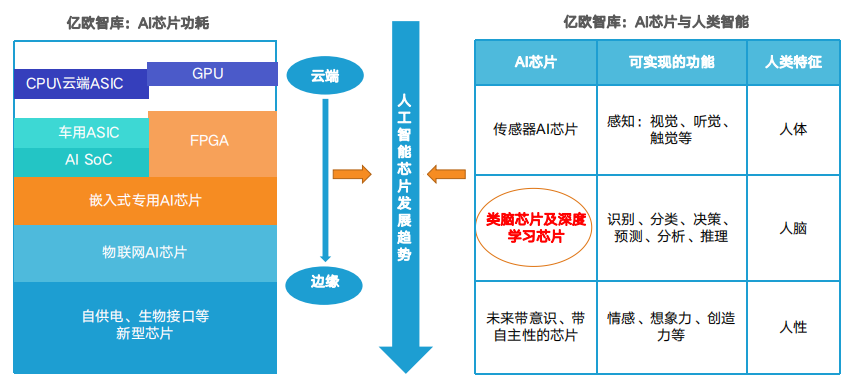

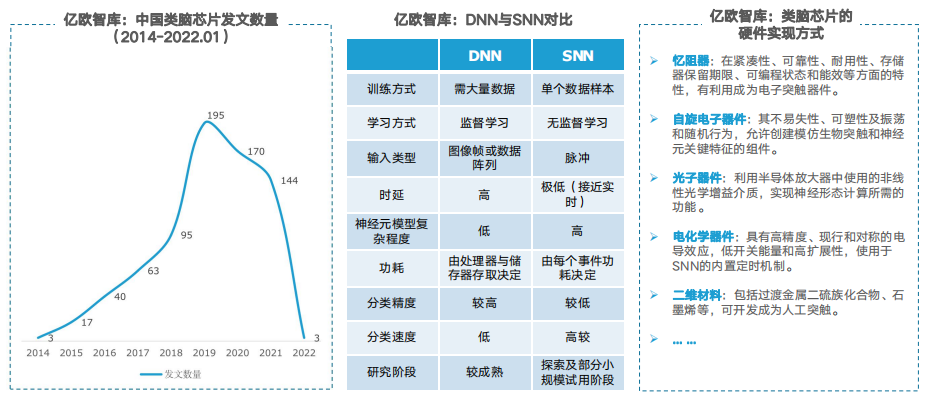

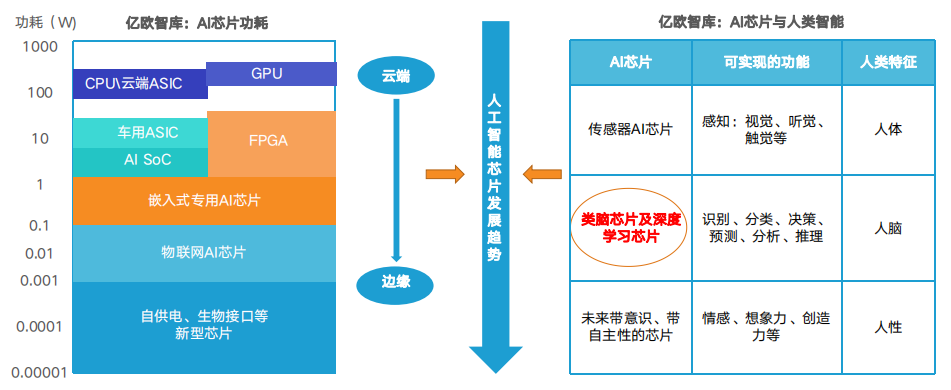

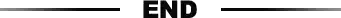

2019年发布AI芯片行业研究报告认为,人工智能于芯片的发展分为三个阶段:第一阶段由于芯片算力不足,神经网络算法未能落 地;第二阶段芯片算力提升,但仍无法满足神经网络算法需求;第三阶段,GPU和新架构的AI芯片促进了人工智能的落地。 目前,随着第三代神经网络的出现,弥合了神经科学与机器学习之间的壁垒,AI芯片正在向更接近人脑的方向发展。根据亿欧智库数据,中国人工智能企业的十大应用技术领域中,计算机视觉、机器人、自然语言处理、机器学习、生物识别占比居前五;企 业服务、机器人和通用方案以及安防、汽车是AI应用的主要方向,边缘/终端芯片需求将持续增长。

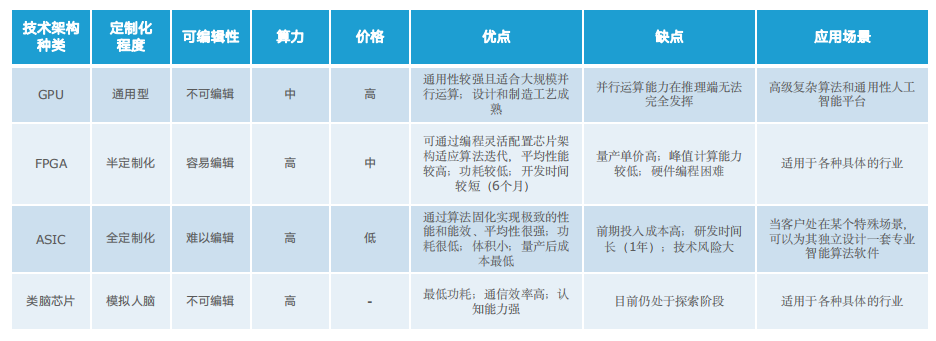

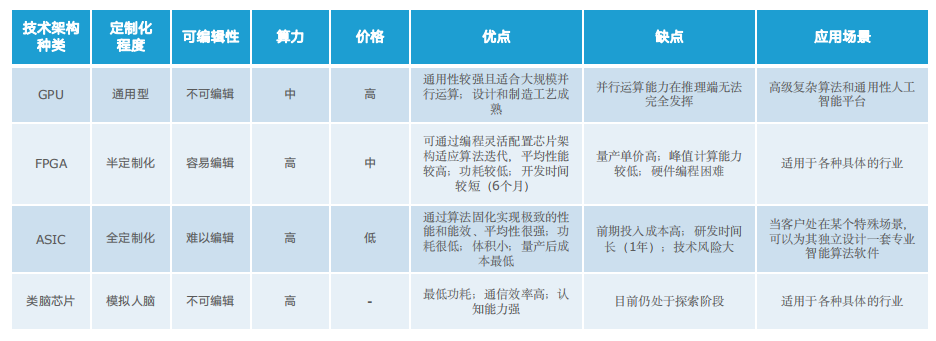

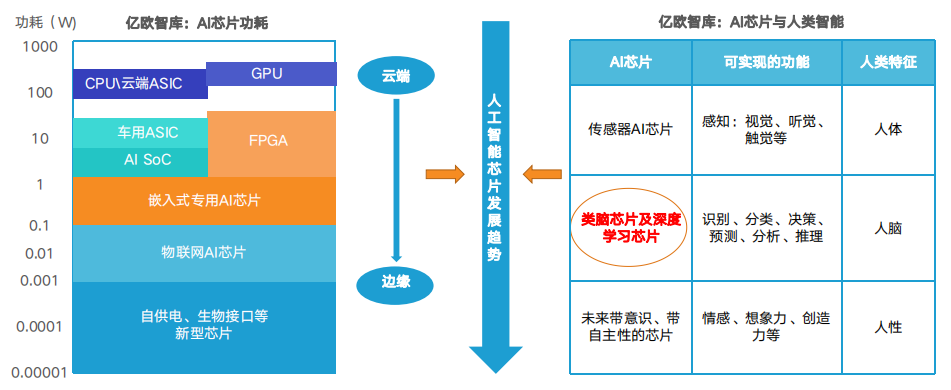

AI芯片的实现包含软件和硬件两个方面。既需研究高效率的智能算法,同时要研究如何将这些算法结合在半导体硅片上,形成最终的产品。AI芯片一般泛指所有用来加速AI应用,尤其是用在基于神经网络的深度学习中的硬件。AI芯片根据其技术架构,可分为GPU、FPGA、ASIC及类脑芯片,同时CPU可执行通用AI计算,其中类脑芯片还处于探索阶段。AI芯片根据其在网络中的位置可以分为云端AI芯片、边缘及终端AI芯片;根据其在实践中的目标,可分为训练(training)芯片和推理 (inference)芯片。

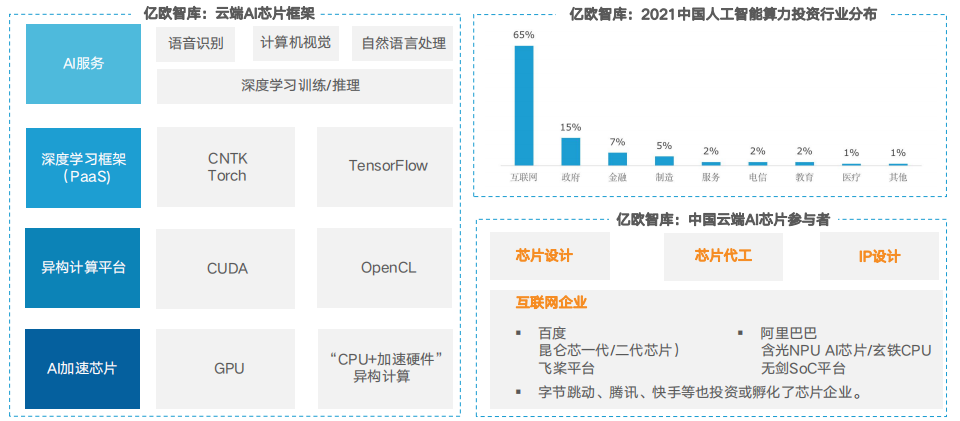

云端主要部署训练芯片和推理芯片,承担训练和推理任务,具体指智能数据分析、模型训练任务和部分对传输带宽要求比高的推理任务;边缘 和终端主要部署推理芯片,承担推理任务,需要独立完成数据收集、环境感知、人机交互及部分推理决策控制任务。

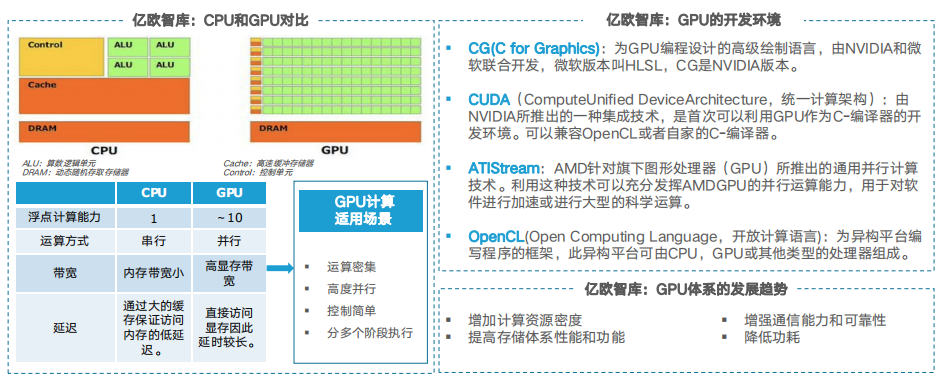

GPU:从图形处理器到通用数据并行处理器

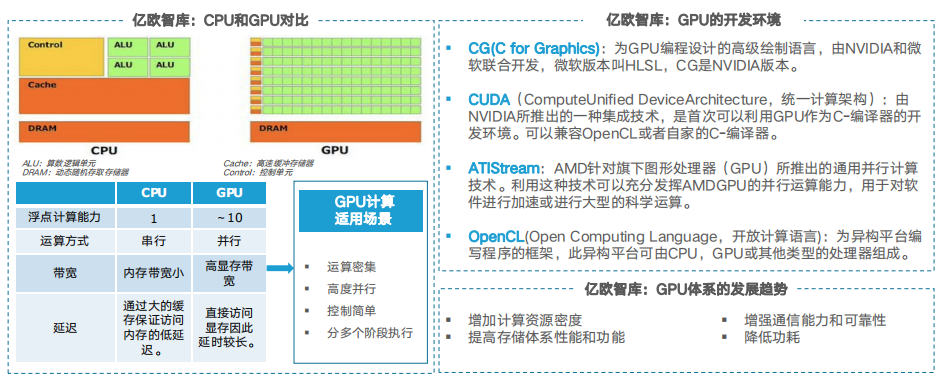

GPU(Graphics Processing Unit)图形处理器最初是一种专门用于图像处理的微处理器,随着图像处理需求的不断提升,其图像处理能力也得 到迅速提升。目前,GPU主要采用数据并行计算模式完成顶点渲染、像素渲染、几何渲染、物理计算和通用计算等任务。因其超过CPU数十倍 的计算能力,已成为通用计算机和超级计算机的主要处理器。其中通用图形处理器GPGPU(GeneralPropose Computing on GPU)常用于数据 密集的科学与工程计算中。

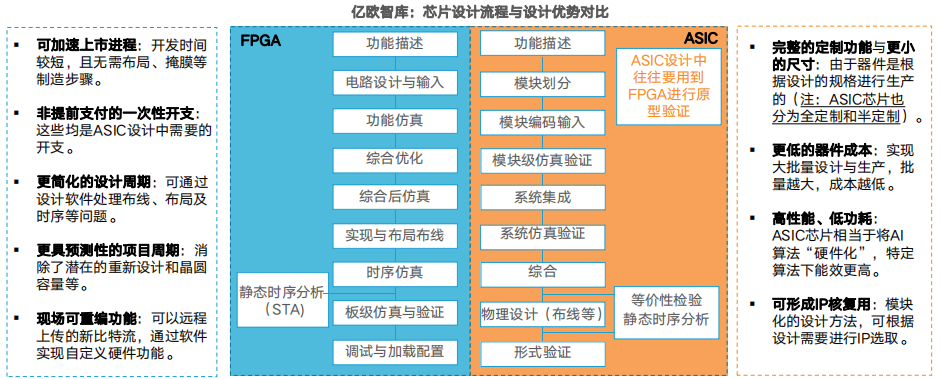

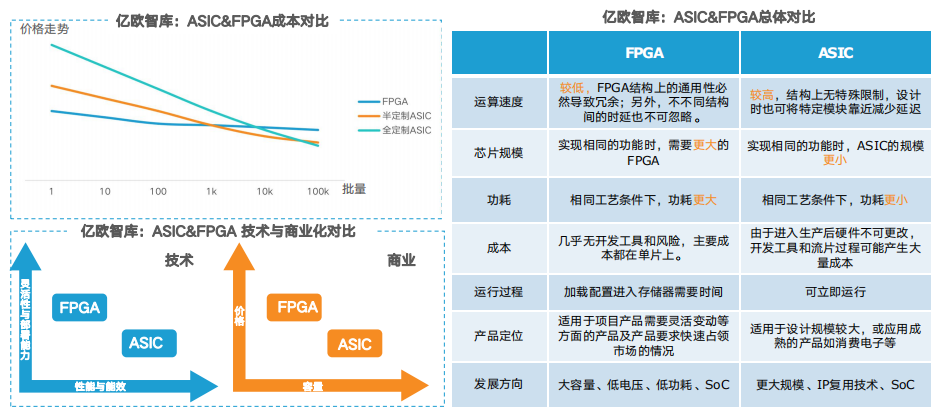

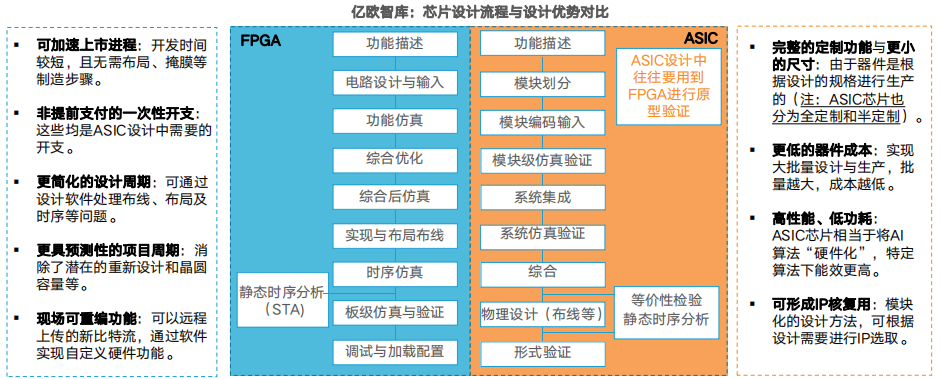

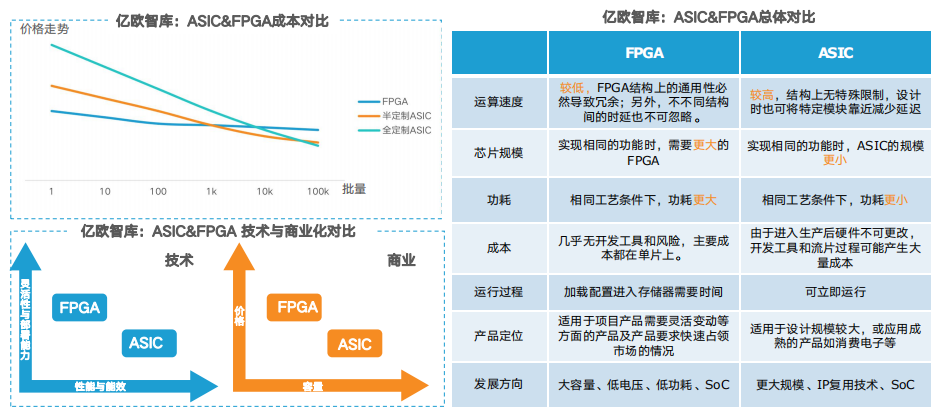

英伟达与AMD仍占据GPU霸主地位,2018年至今,国产GPU也积极发展中,已有部分产品落地。ASIC与FPGA: AI芯片领域“兵家必争之地” FPGA全称是Field Programmable Gate Array:可编程逻辑门阵列,是一种“可重构”芯片,具有模块化和规则化的架构,主要包含可编程 逻辑模块、片上储存器及用于连接逻辑模块的克重购互连层次结构。在较低的功耗下达到GFLOPS数量级的算力使之成为并行实现人工神经 网络的替代方案。

ASIC(Application-Specific Integrated Circuit)是指应特定用户要求和特定电子系统的需要而设计、制造的集成电路。ASIC从性能、能效、 成本均极大的超越了标准芯片,非常适合AI计算场景,是当前大部分AI初创公司开发的目标产品。ASIC与FPGA:功能与市场定位不同,竞争关系不明显

FPGA具有开发周期短,上市速度快,可配置性等特点,目前被大量的应用在大型企业的线上数据处理中心和军工单位。ASIC一次性成本远远 高于FPGA,但由于其量产成本低,应用上就偏向于消费电子,如移动终端等领域。 目前,处理器中开始集成FPGA,也出现了可编程的ASIC,同时,随着SoC的发展,两者也在互相融合。

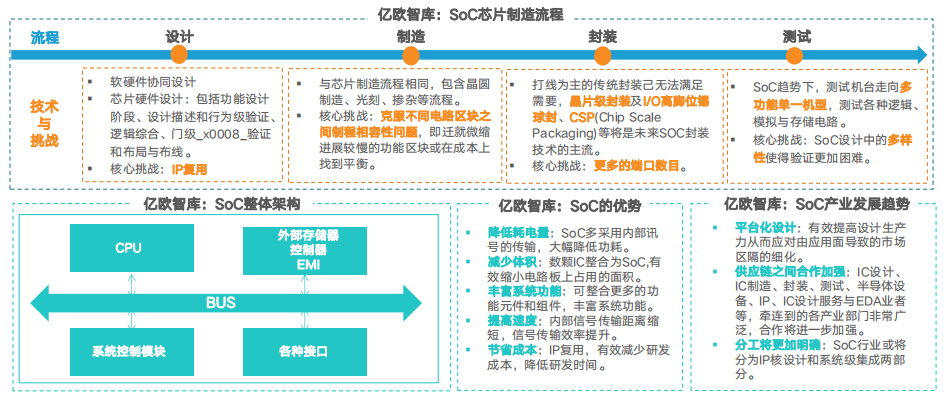

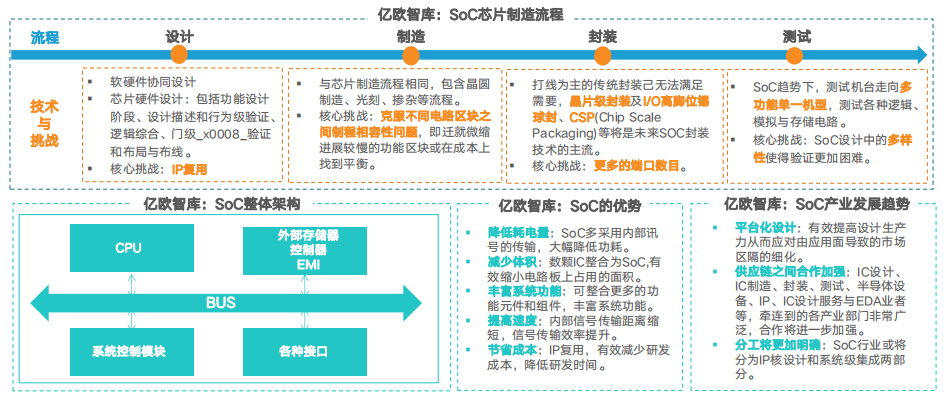

基于不同硬件实现方式的AI芯片:系统级芯片

SoC(System-on-chip,片上系统)作为ASIC设计方法学中的新技术,始于20世纪90年代中期,是以嵌入式系统为核心,以IP复用技术为基 础,集软、硬件于一体的集成芯片。在一个芯片上实现信号的传输、存储、处理和I/O等功能,包含嵌入软件及整个系统的全部内容。

由于高集成效能,SoC已经成为微电子芯片发展的必然趋势。基于不同计算范式的AI芯片:类脑芯片

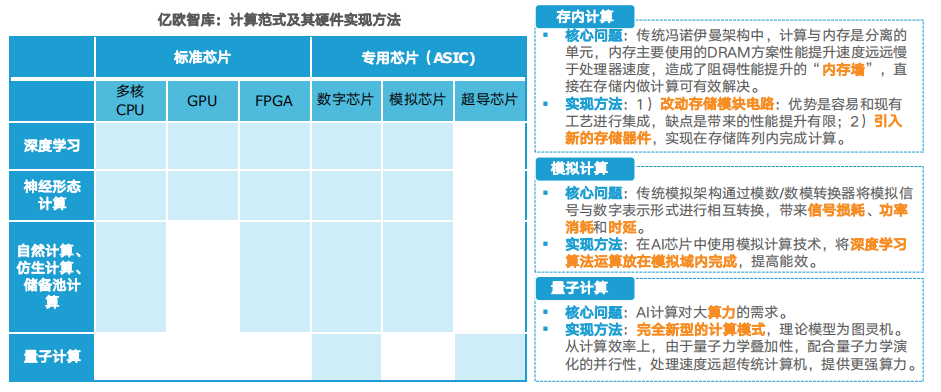

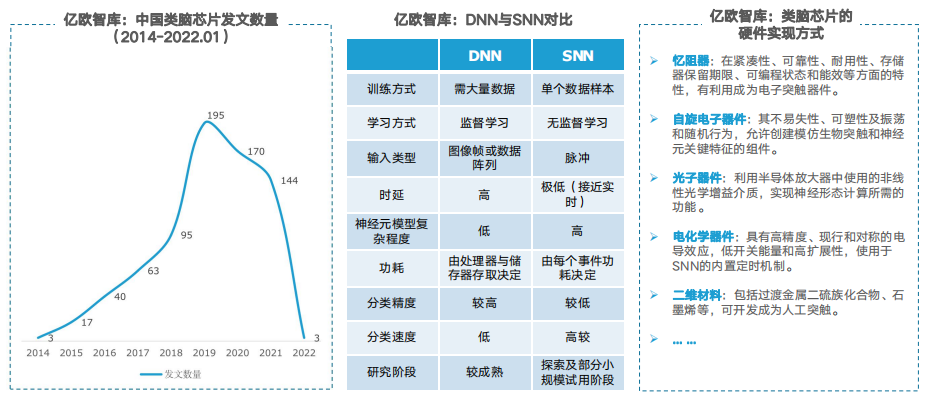

CPU/GPU/GFPGA/ASIC及SoC是目前用的较多的AI芯片,此类AI芯片大多是基于深度学习,也就是深度神经网络(DNN),以并行方式进 行计算的芯片,此类AI芯片又被称为深度学习加速器。如今,模仿大脑结构的芯片具有更高的效率和更低的功耗,这类基于神经形态计算,也就是脉冲神经网络(SNN)的芯片为类脑芯片。

目前,部分企业产品已进入小批量试用阶段 ,类脑芯片最快将于2023年成熟,能效比有望较当前芯片提高2-3个数量级。AI芯片发展:向着更低功耗、更接近人脑、更靠近边缘的方向

现在用于深度学习的AI芯片(包括CPU、GPU、FPGA、ASIC)为了实现深度学习的庞大乘积累加运算和并行计算的高性能,芯片面积越做越 大,带来了成本和散热等问题。AI芯片软件编程的成熟度、芯片的安全,神经网络的稳定性等问题也未能得到很好的解决,因此,在现有基础 上进行改进和完善此类AI芯片仍是当前主要的研究方向。

最终,AI芯片将近一步提高智能,向着更接近人脑的高度智能方向不断发展,并向着边缘逐步移动以获得更低的能耗。AI芯片发展:计算范式创新方向及其硬件实现

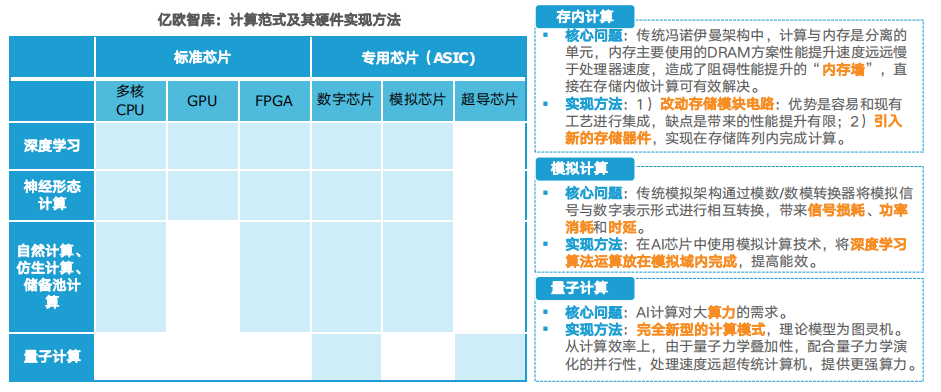

AI硬件加速技术已经逐渐走向成熟。未来可能更多的创新会来自电路和器件级技术的结合,比如存内计算,类脑计算;或者是针对特殊的计 算模式或者新模型,比如稀疏化计算和近似计算,对图网络的加速;或者是针对数据而不是模型的特征来优化架构。

同时,如果算法不发生大的变化,按照现在AI加速的主要方法和半导体技术发展的趋势,或将在不远的将来达到数字电路的极限(约1到 10TFlops/W),往后则要靠近似计算,模拟计算,甚至是材料或基础研究上的创新。

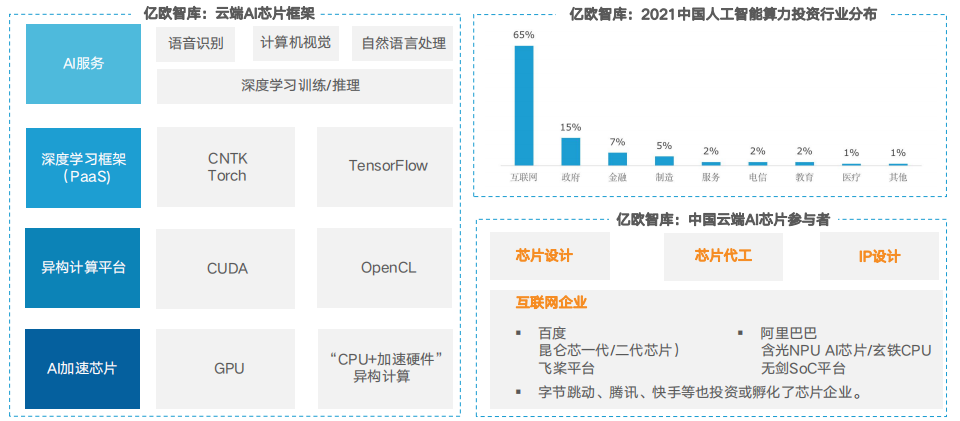

云端:当前仍是AI的中心,需更高性能计算芯片以满足市场需求

当前,大多数AI训练和推理工作负载都发生在公共云和私有云中,云仍是AI的中心。在对隐私、网络安全和低延迟的需求推动下,云端出现了 在网关、设备和传感器上执行AI训练和推理工作负载的现象,更高性能的计算芯片及新的AI学习架构将是解决这些问题的关键。

互联网是云端算力需求较旺盛产业,因此除传统芯片企业、芯片设计企业等参与者外,互联网公司纷纷入局AI芯片产业,投资或自研云端AI芯片。边缘侧:数据向边缘下沉,随着行业落地市场将有很大增量

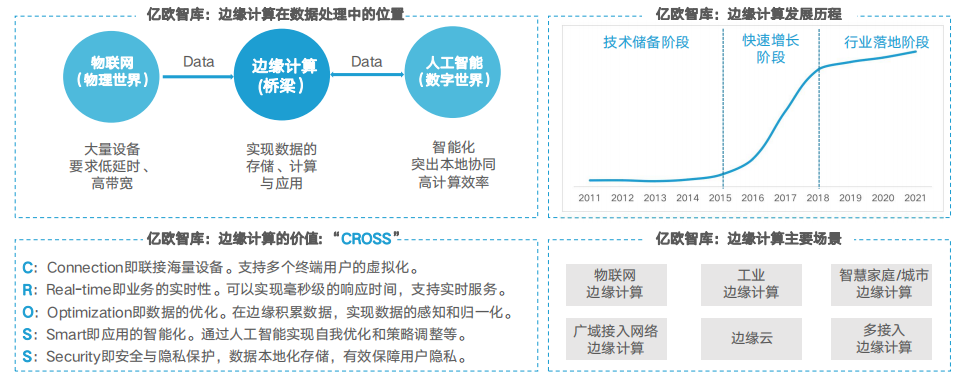

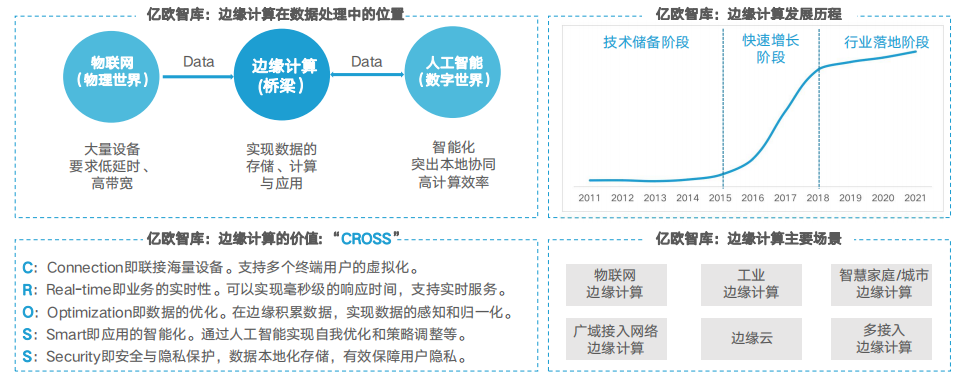

5G与物联网的发展以及各行业的智能化转型升级,带来了爆发式的数据增长。海量的数据将在边缘侧积累,建立在边缘的数据分析与处理将 大幅度的提高效率、降低成本。

随着大量的数据向边缘下沉,边缘计算将有更大的发展,IDC预测,未来,超过50%的数据需要在边缘侧进行储存、分析和计算,这就对边缘 侧的算力提出了更高的要求。芯片作为实现计算能力的重要基础硬件,也将具备更多的发展。ABI Research预测,2025年,边缘AI芯片市场 将超过云端AI芯片。在人工智能算法的驱动下,边缘AI芯不但可以自主进行逻辑分析与计算,而且可以动态实时地自我优化,调整策略,典型的应用如黑灯工厂等。终端设备:终端产品类型逐渐多样,出货量增加催生大量芯片需求

根据亿欧数据测算,中国自动驾驶行业规模增速在2022年将达到24%;智能摄像头产品出货量增速超15%;手机、平板、VR/AR眼镜等智能 产品出货量也均有较大增速,催生出大量的智能芯片需求。

同时,智能终端产品种类也逐渐多样,智能音响、服务/商用机器人等消费硬件、工业/数控设备等工业产品以及通信产品等日渐丰富,不同产 品类型也对芯片性能与成本提出更多的要求。更多人工智能芯片行业洞察内容,请下载“中国人工智能芯片行业研究报告(2022)”。下载链接:

中国人工智能芯片行业研究报告(2022)

2022年国产服务器CPU研究框架

2021-2022年中国人工智能产业创业与投资报告

专用数据处理器 (DPU)技术白皮书

中国数据处理器行业概览(2021)

DPU在数据中心和边缘云上的应用

英伟达DPU集数据中心于芯片

2021中国DPU行业发展白皮书

CCIX缓存一致性互联技术概述

ARM CPU处理器资料汇总(1)

ARM CPU处理器资料汇总(2)

ARM系列处理器应用技术完全手册

本号资料全部上传至知识星球,更多内容请登录智能计算芯知识(知识星球)星球下载全部资料。

免责申明:本号聚焦相关技术分享,内容观点不代表本号立场,可追溯内容均注明来源,发布文章若存在版权等问题,请留言联系删除,谢谢。获取方式:点击“阅读原文”即可查看182页 PPT可编辑版本和PDF阅读版本详情。请搜索“AI_Architect”或“扫码”关注公众号实时掌握深度技术分享,点击“阅读原文”获取更多原创技术干货。