人类的体验欲望不止,从而促成了视频的发展史。

当前,整个社会进入视频化时代,视频被广泛地应用于社会生活的各个领域,相比图文,视频拥有更大的信息密度。

视频实际上并不是一个简单的技术,是交叉学科创造的技术领域,如:云计算,网络,编解码,人工智能等。

阿里云视频云围绕着视频的全链路生命周期,提供云边端一体的数智化音视频能力和全链路的解决方案。

视频全链路,是指从视频的采集、生产、处理、传输、分发到消费(播放),它的底座一定是基于云的,不管是云边一体,软硬一体,还是云端一体。

经过长年的技术积累和应用实践,视频云构建了从内容生产到内容消费的端到端技术架构和服务能力,为用户提供更低延时、更高清、更高效、更沉浸的体验。

体验的无极限演进,让编解码与超高清、与数据量、与算力的三大矛盾涌现。

需求的演进,让两大视频技术趋势不可忽略,一是超高清技术,二是视频超低时延技术。

视频清晰度从SD,或者说480P,到Full HD,也就是所谓的1080P,两者之间信息量扩大了将近7倍,然后又发展到4K,8K,每一次的升级实际上都是视频数据量爆发式的增长。

沉浸体验要求高分辨率,高帧率,宽色域

沉浸体验要求高分辨率,高帧率,宽色域

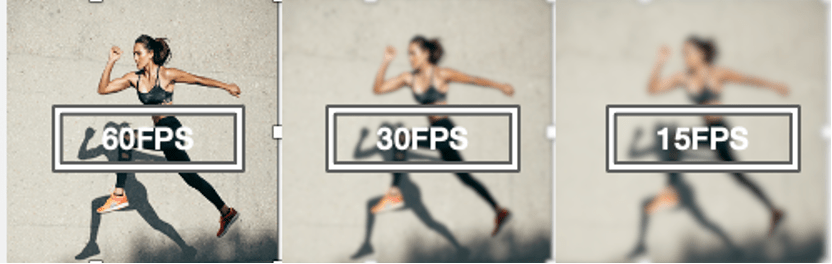

目前,视频帧率使用较多的是24帧、30帧,但VR视频需要60帧甚至120帧才能带来沉浸式的体验。

清晰度的提升,帧率的提高,会带来更好的高运动场景体验。

然而,沉浸体验的AR、VR,所需的信息量大概是7000x7000分辨率,比我们现在使用的8K还要大。

可以想象,未来视频场景带来的将是信息量的急剧增长。

视频高帧率的发展趋势

视频高帧率的发展趋势

这中间,会导致三大矛盾的激增:

❖ 编码升级周期 VS 超高清需求的矛盾

如此海量的视频数据需要压缩,但是视频编码平均十年才升级一代。超高清的需求可能十年已经升级了四五代,但是编码器才升级一代。

❖ 编码压缩率 VS 数据量增长的矛盾

每一代新的编码器性能大概提升50%,相当于压缩力多一倍,但是从Full HD到8K,再从30帧到60帧,是72倍的信息量增长。编解码的升级远远达不到视频信息量升级的要求。

❖ 编码复杂度 VS 算力增长的矛盾

每一代编码的升级复杂度大概要提高100倍,但随着摩尔定律的逐步失效,算力的增长很难做到18个月就升级一代。

只有把更多的算力,不管是边上的算力,端上的算力,还是云上的算力集中起来,才能够满足用户极致体验的需求。

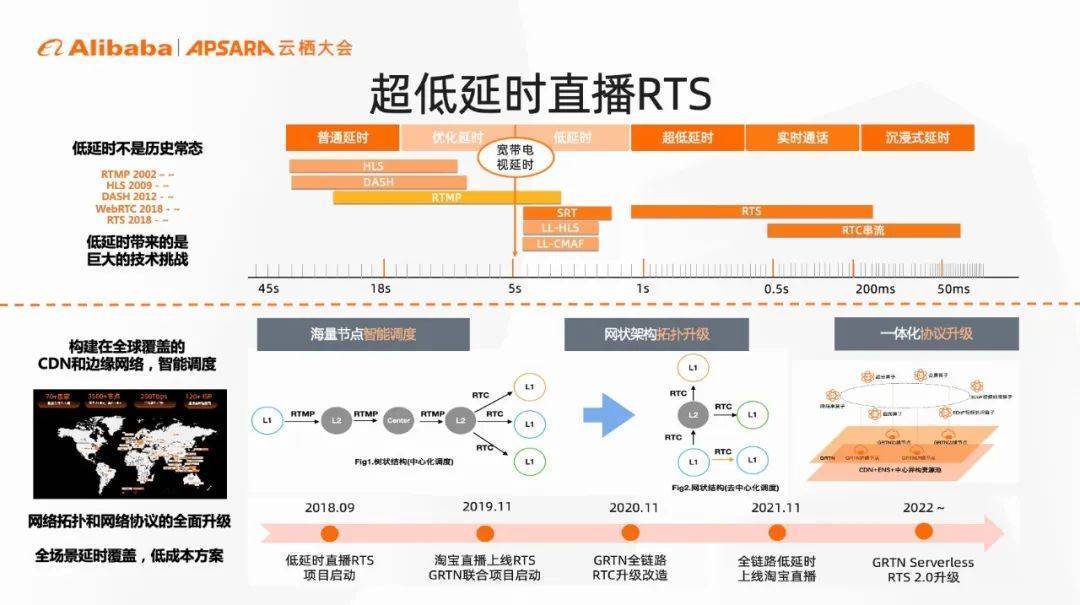

视频的发展历史,就是延时发展的历史。

从最早的PC直播,到长视频网站的出现,再到淘宝直播的风靡,整个视频的趋势实际上是视频延时降低的趋势。

视频从30秒延时的可传播,逐渐发展到到可广播、可互动、可沟通、可操作、可沉浸。可以说,每一次的升级都是视频延时的不断降低。

而且,我们可以越来越清晰地看到,视频延时是在急速下降的。延时从30秒到10秒可能经历了很长时间,但目前已经到达了百毫秒以内,准确来说是五六十毫秒的水平。

云边端协同,构成了更低延时的极限突破,让真正的沉浸成为可能。

视频的每一次升级,对于基础网络和算法之上的整个基础设施,都是一个巨大的挑战。视频技术天然是一个云原生的技术,只有基于云原生,才能让视频技术的规模做大,而用户强体验、低延时的需求带来的成本问题也需要基于云边端协同解决。

云最大的作用就是带来弹性。

任何的资源,任何的直播,流量都是会变化的,所以这种弹性的能力,不管是在边缘云还是中心云上面,对于视频来说都至关重要。

视频永远在追求低成本、高效能、高质量,而边缘云则为视频技术的发展提供了一个非常好的平台。

基于2800多节点的就近分布,边缘云缩短了第一公里和最后一公里,能够降低传输的延时,同时它带有算力,能够降低算力的延时,最终推动着用户的体验不断升级。

运用边缘云、中心云,再结合端,例如手机,可以作为天然的算力分布的设备,阿里云视频云搭建了云边端一体的视频云技术框架,提供一个服务化的平台,以PaaS,SaaS,SDK等各种形式更好地服务客户。

从最早的数据跟着算力走,到现在算力跟着数据走。只要有数据的地方,就有算力。

边缘云不但可以缩短物理的接入,同时能够满足算力的需求。

视频云超低延时直播RTS,已全面应用于手淘双十一,从单边直播到RTC技术,再到超低延时直播技术,极大帮助手淘提升自身业务价值。

目前RTS 2.0平均延时达到200毫秒,基本上跟普通视频通话的时延持平,但在成本上会大幅降低。未来低延时直播也会应用于更多场景,让用户获得更好的体验。

延时可不可以更低呢?是可以的。

云渲染技术,利用「串流」的技术,实现50-60毫秒的延时。不管是云游戏,云渲染,虚拟世界都是通过视频流化带给大家沉浸体验,即需要使用「串流」技术。

串流技术比较复杂,虽然五六十毫秒的延时是非常低的,但仍然可以将延时分为物理的延时,编解码的延时等等。

实际上需要在视频的每一个环节中,编码、网络QOS、云端处理、传输等都要做大量的技术创新和突破,才能够真正做到五六十毫秒延时的水平。

今年六月,央视三星堆奇幻之旅使用了阿里云视频云的串流技术,以普惠方式让每个人都能物理“穿越”至考古现场。云渲染与串流技术一定会不断演进,未来的应用场景也会越来越广。

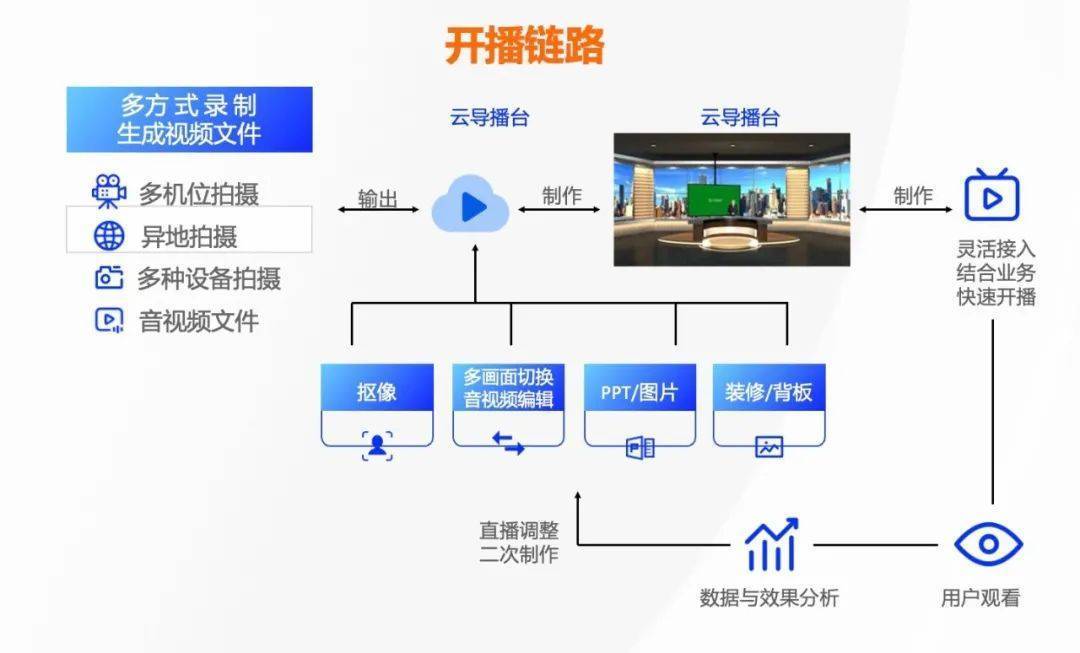

有了网络和算力的支持,越来越多专业化的内容,也能够进入到普通直播。视频云基于深度学习算法的实时、实景抠像技术,支持了东京奥运会、北京冬奥会的直播需求,在不能物理碰面的情况下,通过导播台多机位、实时连麦、异地开播能力,实现主播与多层虚拟背景完美融合。

利用云端的算力与网络能力,仅需两部手机和一台电脑,视频云就可以把以往需要专业制作能力的视频,直接搬到我们的现实生活中。

同样,我们也可以在云端进行各种各样的剪辑。通过云剪辑技术,实现多端统一、端云一致的视频播放效果。

即使是在最传统的多图片场景下,我们也可以应用模板工厂,通过一些简单的AI算法,实现类视频化及批量化生产。

视频的世界不是一蹴而就的,而是一步一步发展而来。可以看到,视频技术在生活生产的各个方面都发挥着巨大作用。

智能媒资基于边缘云技术,对视频进行理解、搜索、打标,将视频作为一种资产来管理。

在企业IT数字化的背景下,智能媒资让视频可以像文字、图片等信息一样被检索。

结合边缘云的算力、网力、存储等,智能媒资利用了大量的AI技术,把媒资体系带到离业务更近的地方,实现云+边泛媒体资源池的高效组织与智能管理。

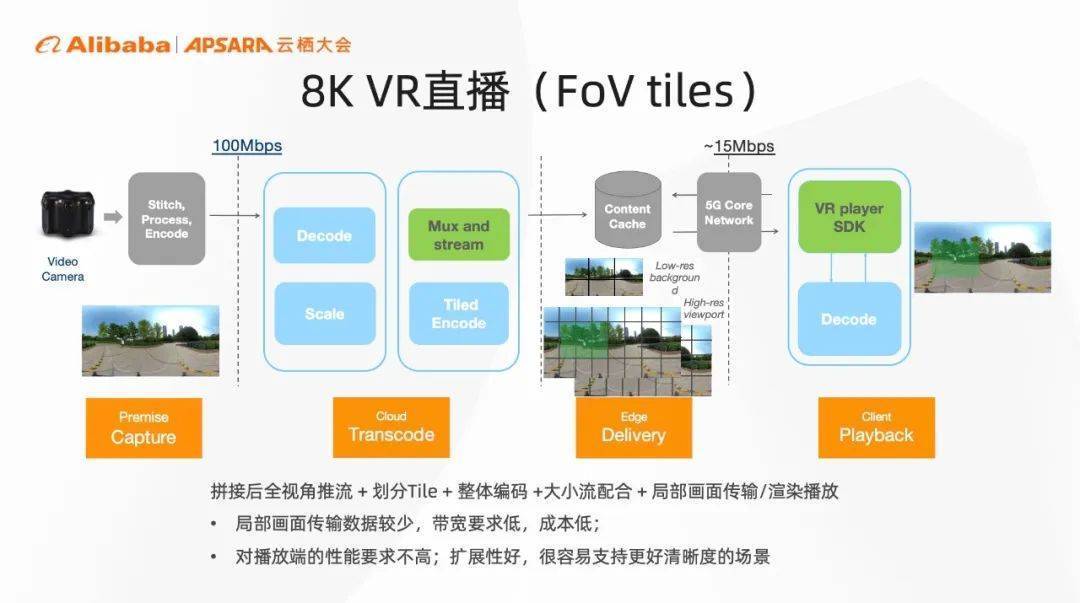

在 VR 领域,不管是国外已经超过1000万台销售量的Quest 2,还是国内Pico这样的设备,实际上面临着更大量的数据处理,因为它们至少是8K清晰度,这对编码技术和播放器技术是非常大的挑战,例如全视角推流,划分tile,编码大小流配合,视角的预测等。

阿里云“云边端一体化”的视频云技术,对带宽的要求低,降低了成本,同时扩展性好,支持更高清晰度的场景,能够达到用户更极致的体验要求。

万物互联时代,视频已经到了一个真正可以为用户体验升级带来爆发的阶段。

未来,更多的业务与场景将会融合,更为专业的制播能力将全面云化,视频将朝着实时化,互动化持续加速,为用户带来更低成本、更高质量、超沉浸式体验。