近年来,许多行业和领域已经开始利用人工智能(AI)的力量来推动人类研究的便捷,数据压缩和重建也在其中之内,人工智能的应用可以用来构建更强大的系统。

在本文中,将研究一个非常典型的AI用例,以压缩数据并使用自编码器重建压缩后的数据。

自编码器应用

请输入

自编码器(autoencoder, AE)已在机器学习和人工神经网络引起了许多人的关注,事实上,自编码器已在医疗医药、图像去噪、神经机器翻译等领域产生了很可观的成绩。

自编码器的组成

请输入

与大多数神经网络一样,自编码器通过向后传播梯度以优化一组数据的权重进行学习,但自编码器的体系结构与大多数神经网络间最显着差异在于瓶颈层[编者注:bottleneck,简单翻译就是瓶颈层,一般在深度较高的网络(如resnet101)中使用]。自编码器的瓶颈层是将数据压缩为小尺寸表示的一种方法。

而自编码器的另外两个重要部分是编码器和解码器。这三个组件融合在一起,便可形成“原始”自编码器,当然更复杂的自编码器可能还具有一些其他组件。

接下来,让我们单独看一下这些组件。

1、编码器

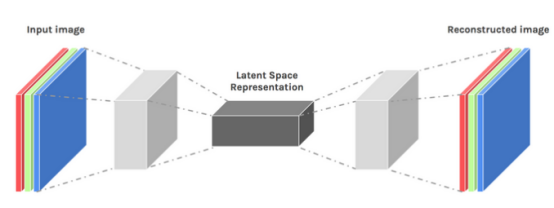

是将数据压缩和重建的第一阶段,编码器负责了数据压缩阶段。编码器是一个前馈神经网络,它将接收数据特征(例如在图像压缩的情况下为像素),并输出小于数据特征大小的潜向量。

图片由James Loy提供

为了使数据重建更强有力,编码器在训练过程中优化了权重,以保证将输入数据最重要的特征压缩到小尺寸的潜在向量中。这确保了解码器具足够的输入数据的相关信息,可以在最小的损失下重建数据。

2、潜在向量(瓶颈层)

自编码器的潜在向量组件(瓶颈层)是最关键的部分,当需要选择潜在向量的大小时,它就会变得更加关键。

编码器的输出为我们提供了潜在向量,而这个向量则是输入数据最重要的特征,最终将被解码器解码,并将有效信息传播到解码器以进行重建。

选择较小的潜在向量意味着可以用较少的数据数据信息来表示数据特征,选择较大的潜在向量则与自编码器压缩的思路相违背,还会增加计算成本。

3、解码器

总结一下数据压缩和重建的过程,就如同编码器一样,这个组件也是前馈神经网络,但在结构上和编码器略有不同。差异主要来自于解码器会将比解码器输出小的潜在向量作为输入。

解码器的功能是从潜在向量生成一个非常接近输入的输出。

图片由关志文提供

训练自编码器

请输入

在训练自编码器时,通常会将组件组合在一起,并不是单独构建的,最终使用诸如梯度下降或ADAM优化器之类的优化算法对它们进行端到端训练。

1、损失函数

自编码器训练过程中最值得讨论的一部分就是损失函数。数据重构是一项生成数据的任务,与其他机器学习任务不同(目标是最大程度预测正确类别的可能性),这会驱动网络产生接近输入的输出。

可通过几个损失函数(例如l1、l2、均方误差等)来实现该目标,这些损失函数的共同之处在于可以测量输入和输出之间的差异,因此使用任何一个函数都是可以的。

2、自编码器网络

一直以来,大都使用多层感知器来设计编码器和解码器,但事实证明,仍然还有更加专业的框架,例如卷积神经网络(CNN)来捕获有关输入数据的更多空间信息来进行图像数据压缩。

令人惊讶的是,研究表明,用作文本数据的自编码器的递归网络效果非常好,但这并不在本文的范围内,不再一一赘述。多层感知器中使用的编码器的潜在向量解码器的概念仍然适用于卷积自编码器。唯一的区别就是卷积层需要设计专用的解码器和编码器。

所有这些自编码器网络都可以很好地完成压缩任务,但是存在一个问题,就是这些网络的并不具备什么创造力。这里所指的创造力是这些自编码器只能产生见过或训练过的东西。

不过,通过稍微调整一下整体架构的设计,就可以引出一定水平的创造力,这种调整过的东西被称之为可变自编码器。

图片由Dawid Kopczyk提供

可变自编码器

请输入

可变自编码器引入了两个主要的设计更改:

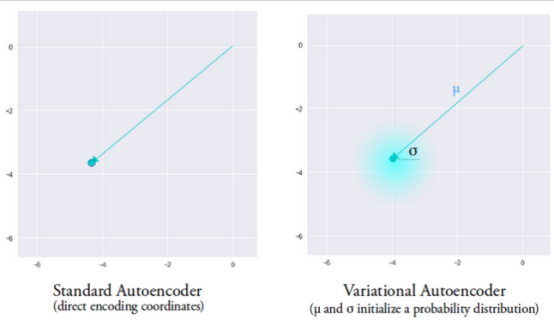

1、不再将输入转换为潜在向量,而是输出两个向量参数:均值和方差。

2、KL散度损失的附加损失项会添加到初始损失函数中。

可变自编码器背后的思想是,希望解码器使用由编码器生成的均值向量和方差向量两个参数化的分布中,采样出潜在向量来重构数据。

这种采样特征,赋予了编码器一个受控空间。而当可变自编码器被训练后,每当对输入数据执行前向传递时,编码器都会生成均值和方差向量,该均值和方差向量负责确定从中采样潜在向量的分布。

均值向量确定了输入数据编码的中心位置,方差向量确定了要从中选择编码以生成真实输出的径向空间或圆。这意味着,对于具有相同输入数据的前向传递,可变自编码器可以生成以均值向量为中心,以方差向量空间内为中心的输出的不同变体。

为了进行比较,在查看标准自编码器时,当尝试生成尚未经过网络训练的输出时,由于编码器产生的潜在向量空间的不连续性,它会生成一些并不真实的输出。

图片由Irhum Shafkat提供

现在我们对可变自编码器有了直观的了解,让我们看看如何在TensorFlow中构建一个。

可变自编码器的TensorFlow代码

请输入

为了简单起见,以下将使用MNIST数据集。

(train_images, _), (test_images, _) = tf.keras.datasets.mnist.load_data()train_images = train_images.reshape(train_images.shape[0], 28, 28, 1).astype('float32')test_images = test_images.reshape(test_images.shape[0], 28, 28, 1).astype('float32')# Normalizing the images to the range of [0., 1.]train_images /= 255.test_images /= 255.# Binarizationtrain_images[train_images >= .5] = 1.train_images[train_images < .5] = 0.test_images[test_images >= .5] = 1.test_images[test_images < .5] = 0.TRAIN_BUF = 60000BATCH_SIZE = 100TEST_BUF = 10000train_dataset = tf.data.Dataset.from_tensor_slices(train_images).shuffle(TRAIN_BUF).batch(BATCH_SIZE)test_dataset = tf.data.Dataset.from_tensor_slices(test_images).shuffle(TEST_BUF).batch(BATCH_SIZE)Obtain dataset and prepare it for the task.class CVAE(tf.keras.Model):def __init__(self, latent_dim):super(CVAE, self).__init__()self.latent_dim = latent_dimself.inference_net = tf.keras.Sequential([tf.keras.layers.InputLayer(input_shape=(28, 28, 1)),tf.keras.layers.Conv2D(filters=32, kernel_size=3, strides=(2, 2), activation='relu'),tf.keras.layers.Conv2D(filters=64, kernel_size=3, strides=(2, 2), activation='relu'),tf.keras.layers.Flatten(),# No activationtf.keras.layers.Dense(latent_dim + latent_dim),])self.generative_net = tf.keras.Sequential([tf.keras.layers.InputLayer(input_shape=(latent_dim,)),tf.keras.layers.Dense(units=7*7*32, activation=tf.nn.relu),tf.keras.layers.Reshape(target_shape=(7, 7, 32)),tf.keras.layers.Conv2DTranspose(filters=64,kernel_size=3,strides=(2, 2),padding="SAME",activation='relu'),tf.keras.layers.Conv2DTranspose(filters=32,kernel_size=3,strides=(2, 2),padding="SAME",activation='relu'),# No activationtf.keras.layers.Conv2DTranspose(filters=1, kernel_size=3, strides=(1, 1), padding="SAME"),])@tf.functiondef sample(self, eps=None):if eps is None:eps = tf.random.normal(shape=(100, self.latent_dim))return self.decode(eps, apply_sigmoid=True)def encode(self, x):mean, logvar = tf.split(self.inference_net(x), num_or_size_splits=2, axis=1)return mean, logvardef reparameterize(self, mean, logvar):eps = tf.random.normal(shape=mean.shape)return eps * tf.exp(logvar * .5) + meandef decode(self, z, apply_sigmoid=False):logits = self.generative_net(z)if apply_sigmoid:probs = tf.sigmoid(logits)return probsreturn logits

这两段代码段准备了数据集并建立了可变自编码器模型。在模型代码片段中,有几个辅助函数可以执行编码、采样和解码。

计算梯度的重新参数化

请输入

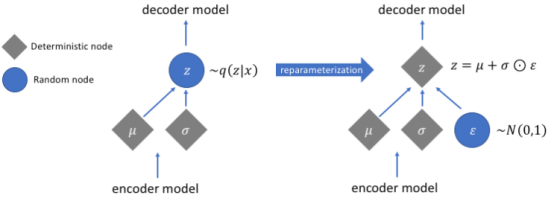

在上面的过程中,我们并未提及重参数化功能,但是它解决了可变自编码器中一个非常关键的问题。

回想一下,在解码阶段,由编码器生成的均值和方差向量控制的分布采样潜在向量编码,当通过的网络前向数据传播时,这不会产生任何问题,但是假若解码器到编码器反向传播时,由于采样操作是不可逆的,会引起很大的问题。

简而言之,就是无法通过采样操作来计算梯度。

应用重参数化技巧是解决这个问题的一个不错的方法,首先通过生成均值0和方差1的标准高斯分布,再使用编码器生成的均值和方差对该分布执行微分加法和乘法运算,就可完成这项工作。

注意,在将方差转换为代码中的对数空间,是为了确保数值的稳定性。引入额外的损失项,即Kullback-Leibler散度损失,以确保生成的分布尽可能接近均值0和方差1的标准高斯分布。

将分布的均值驱动为0,可以确保生成的分布彼此非常接近,防止分布之间的不连续性。接近1的方差意味着我们有一个更适度(既不是很大也不是很小)的空间来生成编码。

图片由Jeremy Jordan提供

在执行重参数化之后,通过将方差向量与标准高斯分布相乘,并将结果添加到均值向量而获得的分布,与由均值和方差向量立即控制的分布非常相似。

构建可变自编码器的简单步骤

请输入

最后,进行一下技术总结:

1、建立编码器和解码器网络。

2、在编码器和解码器之间应用重参数化技巧,以允许反向传播。

3、端到端训练两个网络。

上文所使用的的完整代码可在TensorFlow官方网站上找到。

作者:Henry Ansah Fordjour

编译:付斌

来源:AllAboutCircuits