(报告出品方/作者:国盛证券,宋嘉吉)

通信板块在经历了 5G 建设周期后,投资者始终在问三个问题:1、5G 的杀手级应用是什么?2、5G 驱动的硬件升级还有哪些?是否会在架构上有所创新?3、5G 之后通信看什么?

总所周知,每一轮的 ICT 创新革命,均是“通信+计算+存储”三位一体同步升级,5G 作 为数据传输的“超级高速公路”,必然将匹配更快的“跑车”,当我们将视野从短视频等 拓展到 AR、VR 乃至元宇宙时,其对计算、渲染、AI 的需求将剧增,同时计算能力将从 云端向“云—边—端”延伸,多元算力时代即将到来。我国在 5G 网络建设上取得了领先 地位,未来算力资源将成为全球科技领域的新高地,8 月 31 日美国芯片设计公司英伟达 称被美国政府要求限制向中国出口两款被用于加速人工智能任务的最新两代旗舰 GPU 计算芯片 A100 和 H100,似乎也佐证了算力在未来全球科技竞赛中的地位。

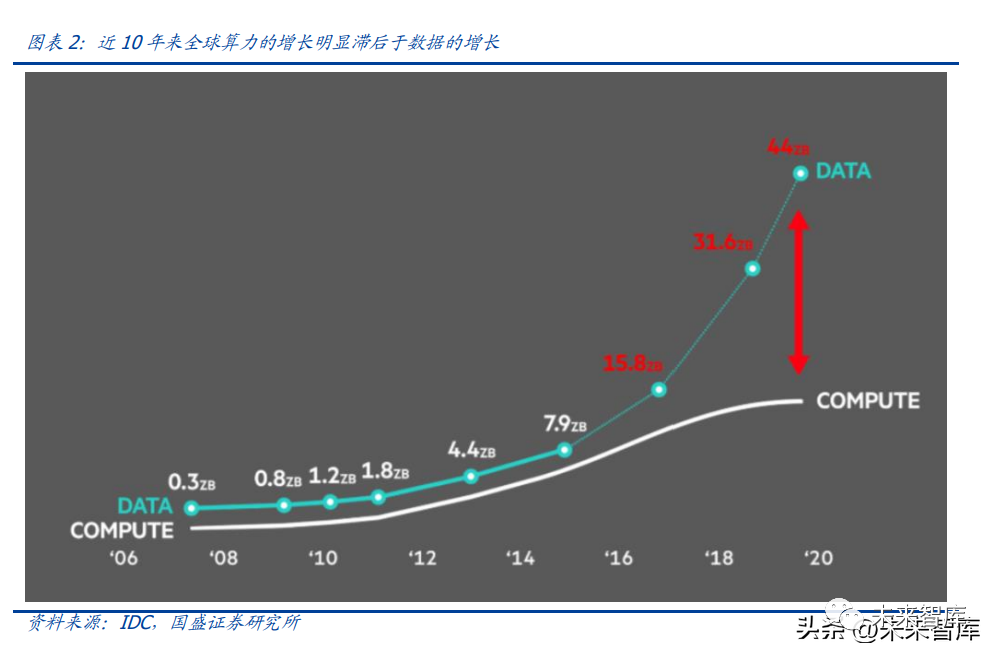

从终端市场需求来看,在国内外数据流量迅速增长以及公有云蓬勃发展的背景下,近 10 年来全球算力的增长明显滞后于数据的增长。同时,伴随智能汽车、人工智能、机器学 习催生的大量数据需求,算力缺口持续显现。5G 网络的不断建设和完善,带动万物互联加速推进,同时更大带宽和更低延时的多场景 显现,海量数据持续涌现,数据结构从单一模式变为多模式,非结构化数据日益增加, 对海量复杂数据的实时处理要求更高。在未来 5-10 年将是数据量指数级增长的井喷临 界点,算力供给需要持续扩张。

未来在自动驾驶、机器人等多个方向,对于算力的消耗会呈指数级增长,深度学习、机 器学习的场景越来越丰富,通用芯片和专用芯片的关系会发生动态变化。各大巨头纷纷 转向以 ARM、FPGA、ASIC 等为核心的低功耗计算架构,避免对单一架构的过度依赖。同时,传统以计算为中心的冯氏架构下,在 CPU 存储之间以及存储和存储间的数据搬运 带来了延迟功耗,通过把部分算力下通到存储,在拥有足够好性能器件支撑的前提下, 就能减少功耗和延迟,提升芯片的算力。

作为支持数字经济以及智能化的核心基座,以数字新基建为代表的算力革命,正在催生出前所未有的新机遇。国内也在着手搭建算力网络,包括东数西算、全光网等。已解决 当前网络实时性缺乏保障、宽带不足、能源供给不匹配等问题。同时,在操作系统、服 务器高端芯片、算力数据库等领域,依旧较多受外部因素制约,实现国内算力网络资源 的自主可控仍然任重道远。

近年来,“算力”两字,随着社会智能化的程度提升,越来越多的被提及。其实“算力” 一词并非新鲜事物,从中国古代的算盘到如今的超级计算机,算力作为人类认知能力的 延伸,是见证与辅助人类社会实现跨越式发展的重要生产力。面向未来,随着当下智能 驾驶、AI 等场景下爆发的百倍算力需求。我们认为,当前以传统计算集群为主的算力发 展模式已经不能满足未来需要,一场“由集中到泛在”,“以能源消耗为边界”,“云、边、 端一体化”的算力革命已经迫在眉睫。

2.1.算力的发展

2018 年诺贝尔经济学奖获得者威廉·诺德豪斯将算力定义为“设备根据内部状态的改变, 每秒可处理的信息数据量”。目前行业中普遍用“FLOPS”,即每秒所执行的浮点运算次 数,来衡量算力大小。从最原始的算盘到当今的超级计算机,人类社会的算力发展经过了诸多阶段,根据华为 算力报告,这些阶段可以划分为人力化、机械化、电气化、集成电路化和当下所展现的 移动化。

2.2.算力对全球经济的促进作用

算力以及其背后代表的设备链条,是具有高附加值的高科技产业。算力作为一种新技术 进步因素脱颖而出,成为挖掘数据要素价值,推动数字经济发展的核心支撑力和驱动力。对于“算力”设备的投资,可以为社会带来从直接到间接的丰厚经济收益。根据《2021- 2022 全球计算力指数评估报告》的结论,算力资本可与传统物质资本形成互补效应和协 同效应;算力资本增长会产生正网络外部性效应和溢出效应;算力资本对经济发展具有 倍增效应。

在华为的《泛在算力》报告中,对算力产生的经济效益做了更加明确的划分,一是直接 受益,二是行业杠杆收益,三是国家整体竞争力收益。直接收益,以公有云投资为例,在选取戴尔 PowerEDGER940 服务器的条件下,以服务 器的出厂价 25,100 美元,云服务器的使用周期为 5 年,云服务器实现 75% 利用率, 服务器的租金收入 118,586 美元计算,1 美元的投入,可以带来 4.7 美元的产出。除上述以租金收入计算的直接收入外,随着算力加速部署,各行各业的智能化程度加深, 将会为社会带来更加显示显著的额外收益。根据美国劳工部数据,随着智能机器人等基 于高算力的智能设备加速应用,未来讲给美国智能制造业带来 1700 亿美元的额外经济 产值提升。同时,根据华为《泛在算力》报告数据,智能化程度提升,将会为包括制造 业。交通业、农业等多个业态带来数倍回报。

根据 IDC 于 2021 年发布的结论,十五个重点国家的计算力指数平均每提高 1 点,国家 的数字经济和 GDP 将分别增长 3.5‰和 1.8‰,预计该趋势在 2021-2025 年将继续保持。同时,通过针对不同梯队国家的计算力指数和 GDP 进行进一步的回归分析后,研究发现:当一个国家的计算力指数达到 40 分以上时,国家的计算力指数每提升 1 点,其对于 GDP 增长的推动力将增加到 1.5 倍,而当计算力指数达到 60 分以上时,国家的计算指数每提 升 1 点,其对于 GDP 增长的推动力将提高到 3.0 倍,对经济的拉动作用变得更加显著。

2.3.算力革命正在发生的原因:供需错配

当下,国内投资者对于算力的认识尚处于较为初级的阶段,目光局限于“IDC”+“服务 器”两大产业链中,短期由于国内互联网产业“过冬”,2020 年 IDC 行业扩建等影响, 国内投资者对于“算力”过剩的担忧影响了对于“算力革命”迫切性的认识。我们认为, 一来算力并不能仅用大型 IDC 需求表征,其只代表集中式算力的规模;二来随着自动驾 驶,智能机器人,人工智能等新需求的快速成熟,边缘侧与终端侧算力需求涌现,全球 现有算力将快速进入“供不应求”的局面,算力革命已经迫在眉睫。究其根本,“算力革命”爆发的根本原因在于“供需失衡”,供给方面主要受到 CPU 发展 极限、流量成本、碳排放等因素制约,集中式算力的边际性价比正在减弱。需求方面, 受到车联网、AI 等同时需要“海量数据处理”+“低延时”的行业带动,算力需求将在 未来呈现指数型爆发式增长。

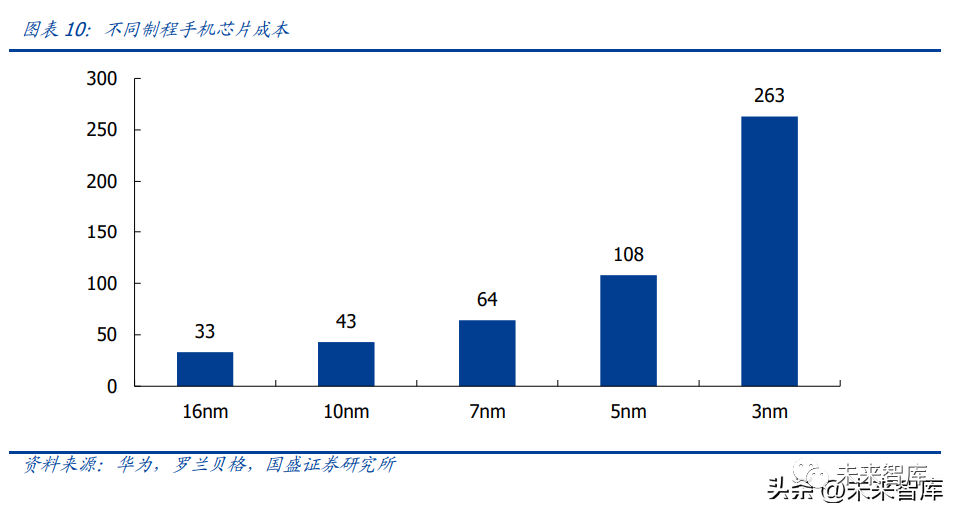

供给端 1:受到量子隧穿效应影响和商业化成本影响,硅基单核芯片制程将在 3nm 达 到极限。硅基芯片晶体管的栅长在低于 3 纳米时极易发生量子隧穿效应(其原理为,当 栅长缩小到一定程度的时候,即使没有加电压,源极和漏极都接近互通,晶体管便失去 了开关的作用,因而无法实现逻辑电路)。因此,通过更加先进的纳米制程工艺提升单核 芯片性能将面临技术上的严峻挑战。由于量子隧穿效应的存在,3 纳米后,单芯片成本将会急剧上升,根据华为与罗兰贝格 数据显示,3 纳米制程手机端旗舰级 SoC 单芯片(以高通骁龙 855 为例)成本较 7 纳 米显著增加约 200 美元,高昂的成本将会极大程度制约终端客户需求,最终降低算力供 给的增加。

即使在能够接受较高成本的大型数据中心等用户中,处理器性能的提升依旧受到制约, 受存储、系统、软件限制(性能)和单位算力功耗显著上升(功耗)两大因素影响,芯 片核心数量将在 128 核达到上限。根据罗兰贝格数据,现有的冯·诺依曼架构下,通 过拟合不同核心数量的芯片计算能力样本数据,我们发现多核处理器随核数增长,算力 增长的倍数快速下滑:从 2 核增至 4 核时,总算力可提升 1.74 倍,而当核数由 128 核增至 256 核时,总算力水平仅能提升已跌破 1.2 倍(1.16X),已显著丧失经济性。

供给端 2:算力爆发的背景下,网络性能限制和成本将会导致数据中心的算力难以满足 复杂场景下的需求。网络带宽及网络时延共同决定了网络信道的传输质量,影响到网络 算力的发挥。具体而言,“网络化”算力的使用需要经历终端与云端的数据双向传输过程, 这段过程是通过网关、基站、数据中心等不同网节点之间的信道所实现的,其中信道的 容量决定了传输的速率(带宽),信道的长度与材质决定了数据传输的时延,两者共同影响了数据传输的效率。

供给端 3:算力高能耗与全球双碳目标之间的矛盾 。随着芯片制成逐渐接近量子隧穿效应发生的制程,当前主流芯片的能效比正在逐渐接近 极限。单位算力功耗在过去 10 多年间经历了显著下降,但随着硅基芯片工艺制程提升 的难度凸显,其进一步下探幅度有限,这意味着,等量算力的提升,即将对应等量能耗 需求的提升。面对未来百倍的算力需求,高能耗问题将成为人类算力发展过程中的重要 瓶颈。同时,随着我国双碳目标的提出,对于数据中心的耗电量,PUE 值都提出了更严格的要 求,截至 2020 年底,中国数据中心耗电量已经突破 2000 亿千瓦时,能耗占全国总用电 量的 2.7%,随着数据中心进一步扩容,算力需求进一步提升,解决数据中心能耗问题的 需求也愈发迫切。在可见的未来,具备低时延特性的核心城市 IDC 供给将进一步被压 缩,如何通过有效的边缘侧处理手段,使得有限的核心城市算力资源得到充分利用,也 是本轮“算力革命”急需解决的难题。

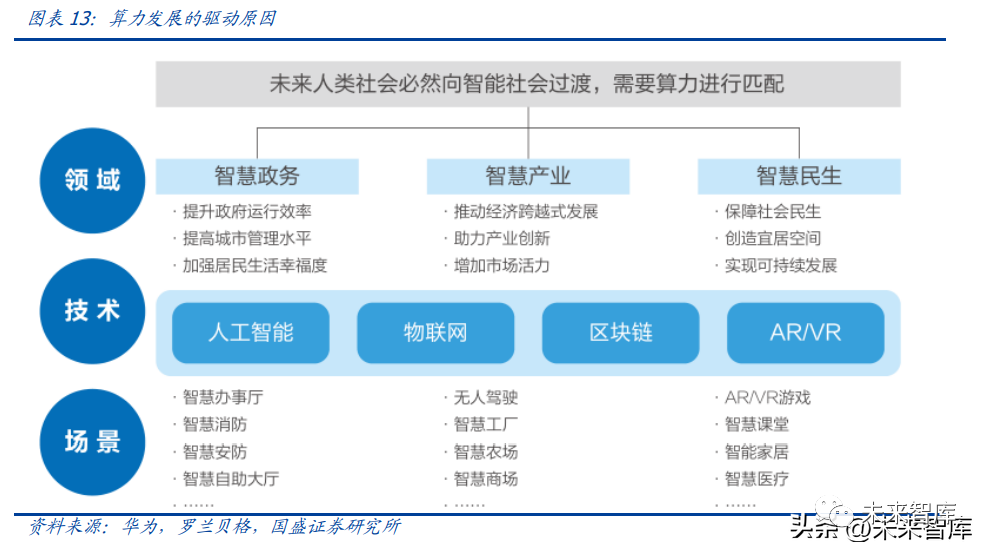

根据华为《泛在算力报告》,在人工智能、物联网、区块链、AR/VR 四大领域,到 2030 年,相比 2018 年,都将出现百倍到千倍的算力需求增长,同时对于网络的延迟也提出了 更高的要求。

从算力需求看,人工智能技术对于算力的核心拉动点在于未来各应用场景内单设备芯片 算力的增长和人工智能技术的行业渗透率的进一步提升,物联网主要通过低算力物联网 设备的普及、配套云端计算中心和边缘端计算单元的增加共同拉动算力增长,区块链因 安全问题要求的算力持续增长和应用场景的快速普及将带动以云服务器为主的算力增长, VR/AR 设备的普及和普及需要的云计算中心和边缘计算设备算力配套将共同推动整体算 力的增长。从时延要求看,L3 级别的自动驾驶对于传输时延的要求在 10-20 毫秒,在进入 L4&L5 级 别后,对于传输时延的要求进一步提高到 10 毫秒以下;使用物联网建设智慧工厂对车间 内部的局域网络带宽需要达到 Gbps 级别,最高时延须控制在 5ms-10ms 以内;在 VR/AR 游戏中,端到端的时延至少需要小于 20 毫秒,才能保证在使用过程中避免感知到明显的 图像滞后而导致的眩晕。随着人类对于 AI、智能价值、虚拟现实等超大算力、超低时延需求场景和应用的探索愈 发深入,当先算力的需求端将会出现指数型爆发,我们将在第五章更加深入的展开讨论 这些面向未来的场景需求和他们当下的发展情况。

2.4.算力革命关键词:“泛在”、“绿色”与“生态”

基于以上供需矛盾,我们提出了“算力革命”的三大关键词,“泛在”、“绿色”与“生态”。

算力革命核心词 1:泛在

前文提到,在算力需求百倍增长下,由于处理器单核性能与多核提升边际递减存在,大 型数据中心的算力提升有限。同时,由于网络性能,带宽成本等制约,对于分布式需求 愈发明显。因此,将运算能力进行“泛在”,在边缘侧或者设备本身直接进行,将有效的 降低集中式数据中心的负载,同时也能够极大的提升网络的传输能力。算力泛在,我们认为,就是实现“云、边、端”算力的融合,纵观当今算力发展,进入 集成电路时代以来,经历了单核,多核,网络化三个阶段,单核受限于芯片性能与成本、 多核受限于核心效应边界与功耗,网络化受限于时延与成本。因此,算力泛在,即实现 三者的“融合”。

算力革命核心词 2:绿色

前文提到,制约算力供给端的因素之一,是全球双碳趋势下,数据中心高能耗与全球碳 中和之前的矛盾,因此我们认为,算力革命的第二个关键词是“绿色”,我们通过芯片和 算法实现了如下的等式:

能源+算力——>价值+热量

目前,以 GSMA 为首的全球移动通信系统协会已开始在此方面积极践行,其在《巴黎协 定》中制定了移动产业气候行动路线图倡议,提出在 2050 年之前实现温室气体净零排 放目标。此后,GSMA 下逾 50 家成员单位(包括沃达丰、西班牙电信等)加入倡议, 已陆续开始公布年度能源消耗情况,制定每年的能源消耗削减目标及策略计划,从而实 现对其数据中心的能源消耗控制。算力革命中的“绿色”,我们认为应从两方面入手,第一方面,通过更加高效的机房散热 设备,探索液冷、海底数据中心等新型散热形式,降低数据中心的 PUE 水平,实现能源 的高效利用。另一方面,要积极提高绿色能源在机房用电中的占比,实现数据中心真正 意义上的“碳中和”。我们将在第四章,更加详细的讨论“绿色”这一算力革命方向带来 的投资机会。

算力革命核心词 3:生态

算力并非孤立的存在,而是与通信、存储能力并存,服务于各类应用的一体化 IT 能力。以常见的物联网模组为例,市场认为模组仅是提供单一的无线通信能力,而当下游需求 丰富起来之后,模组还需支持操作系统、多媒体、本地算力等应用,且在智能家居、智 能汽车、无人机、VR 元宇宙等领域的需求各不相同。当然,就算力硬件本身而言,除了 芯片外,也需要编程语言、API、各类常用库(如 NVIDIA CUDA)、集群管理等,皆是多年与行业应用共同发展的结果。

IDC 统计数据显示,预计到 2025 年,创建的数据会达到 175ZB,相当于 2022 年的两倍 的的数据量,其中视频为主的非结构化数据将占到 80%以上。而其中数据的创建正在更 多的趋向于边缘,同样的数据的存储也会向中心和边缘转变,终端的占比会下降。但是 数据的处理一直在中心,数据的使用和消费在端侧,就出现了算力错位。算力错位会导 致产生大量的算力搬运成本。云计算是现在计算的一个主流,开创了云端算力的模式,把云端算力投射到终端上,当 下云计算基于中心的超大规模 IDC,计算集中在核心节点,中心化的布局在算力需求进 一步大幅提升的背景下可能将遇到瓶颈,需要进一步的发展,所以就产生了下沉的需求。近二十年,以数据为基础、以网络为媒介、以计算为核心的科技以迅雷不及掩耳的速度 急速发展,全球进入移动互联网时代,产生的数据量相当于过去数世纪的数据量总和, 并持续以指数级的数量增加。2006 年亚马逊正式推出 EC2 服务标志着人类进入了云时 代,经过十多年的发展,云服务已经影响到企业和个人生活的方方面面。随着全球范围 5G 的加速落地、物联网高速的发展以及以云为基础的数字化升级大趋势下,IDC 作为核 心信息基础设施在需求侧和供给侧均发生边际变化,其作用和价值正在不断凸显。

3.1.国内 IDC:行业底部出清,需求曙光初现,反转只欠东风

从短期来看,当下受到国内互联网大厂业务收缩,2020 年 IDC 行业建设浪潮影响,近年 来,供需格局较弱。不过随着相关平台经济扶持政策出台,以及 IDC 行业底层并购出清 加速,我们认为国内 IDC 行业正在走出短期困境。

从长期来看,随着国内 5G 网络全面建成,我国 DOU 长期增长的趋势不会变,随着在 4G 向 5G 升级的过程中,长短视频成为新的风口,抖音、火山小视频、快手、B 站为首的短 视频,以及爱奇艺、腾讯视频为主的长视频逐渐成为新潮流。而直播也发展出了更多形 式,以淘宝、拼多多为主的电商逐渐进入直播带货时代,抖音、快手也凭借其在短视频 的流量优势涉足电商领域。用户的习惯开始转向以视频和直播为主的应用和媒介,而视 频直播又意味着流量相较过去有了数十倍的爆发。

3.2.全球 IDC 市场:需求持续强劲,景气度存在预期差

今年以来,国内投资者对于北美数通产业链景气度预期进行了明显的下修,以光模块为 代表的数通产业链标的估值创出历史新低。我们认为,从 Q2 云厂商资本支出、后续资 本支出展望、以及数通产业链各家中报业绩来看,市场对于北美数通的预期存在过分悲 观的情况。在宏观不确定性下,龙头大厂依旧逆势加码云基建,说明数字化,云化依旧 是当下最具潜力的行业赛道。我们认为,从中短期来看,北美数据中心的需求仍然非常旺盛。从云计算业务来看,北 美三大云厂商 AWS、Google Cloud、Azure Q2 依旧保持了良好的高速增长。AWS 营收同比增长 33%、Google cloud 营收同比增长 36%,Azure 营收同比增长 40%。

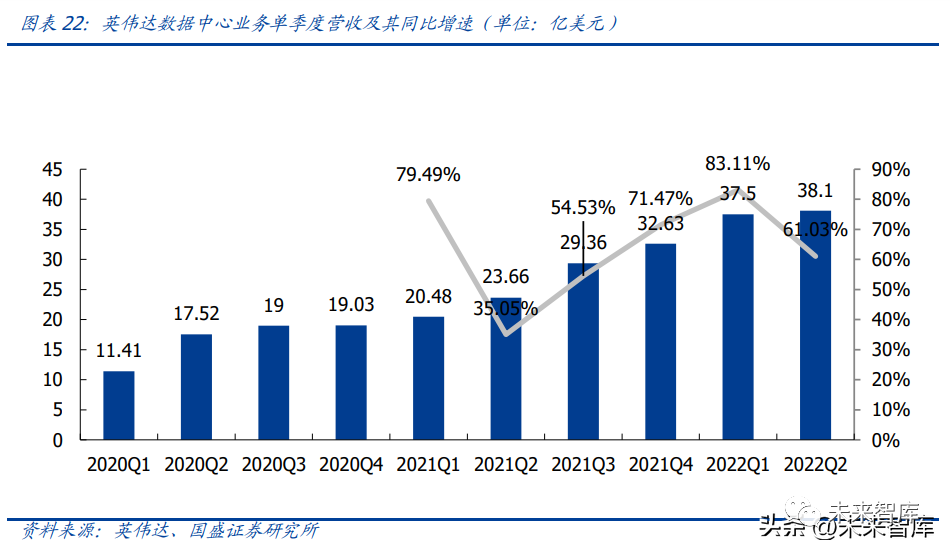

从设备商角度,尽管英伟达、AMD 等公司 Q2 业绩表现出现了一定程度下滑,但主要原 因来自于全球 PC 需求下降与加密货币市场寒冬。两者的数据中心业务依旧维持了较高 的景气度。英伟达数据中心业务 Q2 营收 38.1 亿美元,同比增长 63.1%,环比增长 1%, 连续 11个季度创历史新高,成为公司第一大业务,从趋势上看将逐渐拉开与游戏业务距 离。

AMD 在 Q2 实现营收 65.5 亿美元,同比增长 70%,公司于 Q2 首次公布了数据中心部 门的营收,2022Q2 数据中心部门营收为 15 亿美元,同比增长 83%,是公司营收增长最 快的部门。根据公司公开交流,公司本季度 EPYC 处理器需求强劲,云计算和企业客户 均同比显著增长。在云计算方面,AWS、百度、谷歌、微软 Azure 和甲骨文在本季度推 出了 60 多个基于第三代 EPYC 处理器的新实例。

我们通过以上三家具有代表性的科技公司近期业绩可以大致看到,数据中心市场景气度 依旧保持高位,且根据指引预期来看,未来还将继续保持高景气增长。结合北美头部云 厂商一季度增速及云厂商全年资本开支指引,即便下半年面临短期波动,中期北美数据 中心产业景气度可见。从长期来看,作为全球云计算的领先市场,同时伴随 Meta、苹果等巨头在元宇宙、AR/VR 领域的加速探索,北美流量长期增长的态势不会改变,数据中心在作为算力发展的核心 支撑,将在全球智能化过程中继续扮演举足轻重的作用。纵观 IDC 产业投资机会,我们认为当前主要集中在两方面,第一是底部出清的国内优质 IDC 龙头公司,第二是存在预期差的北美 IDC 产业链,第三是国产算力芯片、设备厂商。国内优质 IDC 龙头公司目前已经底部出清,从 2020 年开始纷纷进行资本运作与产能扩 张。同时,随着国内互联网企业基本面出回暖迹象,因此国内 IDC 的需求端情况有望逐 渐改善。

目前市场对北美宏观经济情况持谨慎态度,从而影响到 2022 年中期的北美 IDC 市场需 求。不过,从北美 IDC 下游主要厂商自 2018 年以来逐渐爬升的资本开支情况来看,尽 管市场担心 22H2 在美国加息周期中,大厂投资会存在波动,但我们仍对此中长期市场 需求持较乐观的态度,一旦加息预期出现拐点(加息周期影响云厂商业务收入,同时不 利于中长期加杠杆),北美市场的 IDC 中下游企业将存在一定的预期差。

3.3 边缘计算:方兴未艾,未来可期

前文提到,由于未来社会算力爆发下产生的海量数据传输需求,完全依靠 IDC 提供中心 化算力支撑乃是效率较低的选择,无论是智能驾驶对于时延的要求,亦或是传输高清视 频图像等带来的大额带宽成本,都将进一步加剧“集中式”与“分布式”需求的错配。

在此背景下,边缘计算便成为了传统云端算力的很好补充,云计算聚焦非实时,长周期 数据的大数据分析,能够在周期性维护,业务决策支撑等领域发挥特长。边缘计算聚焦 实时、短周期数据的分析,能更好的支撑本地业务的实时智能化处理与执行。算力“泛 在”的模式也将随着边缘计算的加入得到完善。当前时点,边缘计算产业正处于起步前期,部分行业应用开始涌现并走向成熟,本段将 从边缘计算的定义、优势、行业空间、应用案例、产业链玩家、A 股相关标的来剖析边 缘计算的当前现状与未来机会、

边缘计算的定义

根据边缘计算产业联盟的定义,边缘计算是在靠近物或者数据源头得到网络边缘侧,融 合网络、计算、存储、应用核心能力的开放平台,就近提供边缘智能服务,满足行业数 字化在敏捷联接,实时业务、数据优化、应用智能、安全与隐私保护封方面的关键需求。

在相关理论加速成熟的同时,行业联盟也在加速建立,目前主流的边缘计算联盟包括了 思科、ARM、英特尔、戴尔、微软、普林斯顿大学等 6 家机构成立的开放雾计算联盟、 华为、沈自所、信通院、因特尔、ARM、软通动力等 6 家机构联合发起成立了边缘计算 产业联盟、IEC/ISO JTC1 SC41 成立的边缘计算研究组、IIC 成立边缘计算技术工作组和 IEEE 成立的雾计算网络架构工作组等。

从功能由简到繁来分析,边缘计算的发展总体可以分为三个结算,即联接、智能、自治。联接阶段,边缘计算主要解决终端及设备的海量、异构与实时连接,网络自动部署与运 维,并保证联接的安全、可靠与互操作性。这一阶段的典型应用包括了自动抄表等 智能阶段,在该阶段,边缘侧将会引入数据分析与业务自动处理能力,智能化执行蹦迪 业务逻辑,大幅提升效率,降低成本。这一阶段的典型应用包括了各种设备的自我状态 监测等。自治阶段,在该阶段,随着 AI 等技术引入,边缘侧不仅可以自主进行业务逻辑分析与计 算,还能够动态实时的自我优化,调整和执行策略,该阶段的典型应用是各类无人工厂 和智能化设备。

边缘计算的优势

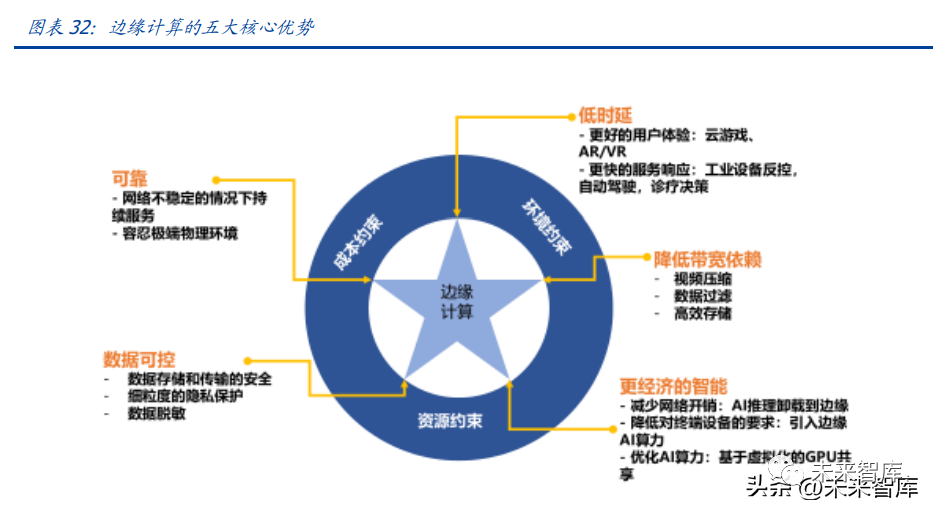

我们认为,在 5G,AI、物联网等技术与环境的加持下,边缘计算体现出了 5 大应用价值, 分别是低延时、低带宽、更经济的智能、数据可控、高可靠。低时延:低时延是提高用户体验甚至是使得某些应用能够工作的重要因素。一方面,边 缘计算通过在网络边缘进行数据处理,降低了因数据在终端和云端之间多跳传输产生的 时延。另一方面,利用优化的边缘算力进行数据处理,也比利用有限的终端算力进行数 据。低带宽:物联网设备产生的数据具有体量大、价值密度较小的特性。如果把原始数据直 接传输到云端进行处理,很大程度上造成网络拥塞,为了保证带宽所需的成本代价也极 高。边缘计算对海量原始数据进行预处理和分析挖掘,将产生的高价值洞察传送到云端, 极大程度降低了对带宽的依赖。更经济的智能:视频监控、语音识别、图像分析等人工智能应用越来越广泛地被应用于 满足行业的业务需求。AI 模型的训练需要非常强大算力的支持,不可避免地要在云端进 行。但基于实时数据进行模型推理如果也在云端进行,网络成本会非常高。同时,普通 的终端设备无论从算力还是能耗角度都无法支持模型的推理。边缘计算将 AI 模型推理 卸载到边缘节点,在边缘节点上通过 GPU、加速硬件虚拟化等机制提高模型推理的并发 能力,以一种经济有效的方式实现应用智能。

数据可控:企业往往对将自己的生产数据传输到云端进行处理有很大顾虑。边缘计算能 实现敏感数据不出工厂,不出园区,直接在本地对数据进行清洗、预处理、聚合、筛选, 避免了数据传输过程中可能的泄露、遗失、篡改等风险。此外,云计算数据中心对数据 的安全控制力度并不是十分理想,API 访问权限控制以及密钥生成、存储和管理方面的 不足都可能造成数据泄漏,并且还可能缺乏必要的数据销毁政策。边缘计算可以实现更 可控的本地数据存储和管理,降低数据风险。高可靠:靠近数据生产或者使用的场所往往物理环境复杂、网络条件不稳定、潜在的攻 击窗口众多。边缘计算硬件专为严苛的物理环境设计,具有紧凑、坚固、抗高温高湿等 物理特性。边缘计算软件平台通过云边协同来保障端到端的 SLA,边缘节点在断网期间 能实现自治,继续支撑其上应用的运行,在网络恢复之后,还能自动与云端更新数据、 状态。边缘计算软件平台还支持应用跨节点部署及多实例运行等能力,当某个节点发生 故障时,可快速实现负载迁移,避免对业务的影响。

边缘计算与 5G

随着 5G 时代的到来,5G 的广连接、低时延、高带宽三大特性完美契合了边缘计算设备 需要的网络指标。根据 5GPPP 发布的白皮书《5G empowering vertical industries》5G 通过边缘计算技术将应用部署到数据侧,而不是将所有数据发送到集中的数据中心,满 足应用的实时性。白皮书认为,智慧工厂、智能电网、智能驾驶、健康医疗、娱乐和数 字媒体是未来最具商业规模且排名靠前的边缘计算需求场景,极具典型性,并且运营商 也在这些领域与行业客户紧密合作,基于用户需求,共同推动边缘计算的发展,为用户 提供安全可靠的边缘计算业务。我们认为,5G 对于边缘计算的推动主要在于两方面,一是网络架构的升级,推动边缘计 算快速成熟。5G 网络将原先 4G 核心网经云化拆分成 5G 核心控制层面和核心用户层面, 实现了用户面与 MEC 同时下沉,有利于边缘侧的融合。二是 5G 后期以小基站为主的部 署形式,有望在物理层面加速边缘计算网络的拓展。

当前,5G 网络下的边缘计算主要分为两类,第一是广域 MEC,第二类是局域 MEC。

广域 MEC 场景

低时延业务的百公里传输引入的双向时延低于 1ms,但是基于广域 MEC 的 5G 公网,已 经能够为大量垂直行业提供 5G 服务。MEC 部署在安全可控的汇聚机房是当前运营商广 域 MEC 的主力方案,可用于权衡应用对接、运维复杂度、设备和工程成本等多种因素。

局域 MEC 场景

将 MEC 部署在园区有利于安全与隐私保护高敏感的行业,以满足数据不出园的要求。港口龙门吊的远程操控,钢铁厂的天车远程操控,以及大部分的制造、石化、教育、医 疗等园区 / 厂区都是局域 MEC 的典型场景。局域 MEC 部署场景可以满足 URLLC 超低 时延业务,同时支持企业业务数据本地流量卸载(LBO),为园区客户提供本地网络管道。通过增强隔离和认证能力,防止公网非法访问企业内网,构建企业 5G 私网。

边缘计算的行业规模

根据 IDC 数据统计,到 2020 年,全球有超过 500 亿的终端与设备联网,未来超过 50% 的数据需要在网络边缘侧分析。处理与存储。根据思科发布的全球云指数数据,2021 年 全球产生 106ZB 的流量,其中数据中心流量仅占 21ZB,全球超过 70%的流量空间需要 边缘侧设备的支持。根据国际数据公司(IDC)发布的《全球边缘计算支出报告》,预计到 2022 年,全球在边缘 计算方面的支出将达到 1760 亿美元,比 2021 年增长 14.8%。企业和服务提供商在边缘 解决方案的硬件、软件和服务上的支出预计将持续到 2025 年,这一增长速度将达到近 2740 亿美元。从地理角度来看,美国将成为优势解决方案的最大投资者,预计到 2022 年支出将达到 765 亿美元。西欧和中国将是第二大地区,支出总额分别为 306 亿美元和 208 亿美元。在未来五年的预测中,中国将以 19.7%的复合年增长率成为支出增长最快的国家,其次 是拉美,其复合年增长率为 19.4%。

边缘计算主流应用

当下边缘计算较为成熟的应用主要集中在预测性维护、能效管理、智能制造,面向未来, 我们认为自动驾驶、AI、AR/VR 等需要高算力、低延时的场景会逐渐成长为边缘计算的 主流场景,这些场景我们会在第五节中进行展开。

预测性维护

传统的维护方式主要是事后维护和预防性维护,事后维护会导致业务中断,预防性维护 采用人工例行检修,导致维护成本大幅度上升,以梯联网为例,全球有超过 1500 万部电 梯在网运行,电梯维保和售后服务正式成为电梯行业的“新蓝海”,越来越多的电梯厂商 转向整合产业链、依靠维保服务增加企业收入,但电梯通过事后维护和预防性维护的成 本很高,且首次维护成功率低于 20%。为实现商业模式创新,电梯厂商必须通过数字化 改造提升运维效率、降低运维成本。通过引入边缘计算,可以助力电梯厂商从传统的预 防性维护升级到新一代实时预测性维护,从而实现产品向服务的价值延申。

能效管理

随着世界经济的发展,发展需求与能源制约的矛盾愈加明显,能耗水平反映了一个国家 或地区的经济发展水平和生活质量,在能源需求日趋紧张的情况下,如何实现建筑能耗 量化以及效果评估,降低建筑物(包括空调、路灯照明、办公设备等)运行过程中消耗 的能量,从而降低运行成本,同时提高用户使用满意度,满足各大企业从提供产品向提 供服务转型,成为各大企业或组织机构最为关注的问题。以路灯为例,世界 80%的路灯 厂商都准备向智能路灯转型,通过智能路灯节能减排,相关国家和国际组织也逐步在法 律中明确建设绿色节能标准,如全球气候组织呼吁十年完成全球路灯智能化改造、实现 能耗减半。

智能制造

随着消费者对产品需求的日益增高,产品的生命周期越来越短,小批量多批次,具有定 制化需求的产品生产模式将一定程度替代大批量生产制造模式,先前制造体系严格的分 层架构已经无法满足当前的制造需求,以某消费电子类产品的制造生产线为例,采用 PLC+POC 的模式构建,由于订单种类增加,单批次数量减少,导致平均每周的切单转产 耗时 1~2 天;新工艺升级每年至少 3 次、设备更替每年近百次,导致的控制逻辑/工序 操作重置、接口配置耗时约 5~12 周,严重影响了新产品上线效率。另外制造智能化也 是中国,美国,德国等世界主要制造大国未来 10 年的发展方向,以中国为例,到 2025 年,制造业重点领域全面实现智能化,试点示范项目运营成本降低 50%,产品生产周期 缩短 50%,不良品率降低 50%,制造智能化首先需要加强制造业 ICT 系统和 OT 系统之 间的灵活交互,显然先前的制造体系也无法支撑全面智能化。

边缘计算能够推动智能制造的实现。边缘计算在工业系统中的具体表现形式是工业 CPS 系统,该系统在底层通过工业服务适配器,将现场设备封装成 web 服务;在基础设施层, 通过工业无线和工业 SDN 网络将现场设备以扁平互联网的方式联接到工业数据平台中;在数据平台中,根据产线的工艺和工序模型,通过服务组合对现场设备进行动态管理和 组合,并与 MES 等系统对接。工业 CPS 系统能够支撑生产计划灵活适应产线资源的变 化,旧的制造设备快速替换与新设备上线。

算力发展高速发展过程中将不得不面临能耗问题,云端、边缘、终端以及网络传输要求 的持续提升,势必带来能耗激增的问题,硅基芯片工艺制程提升的难度凸显,单位算力功耗进一步下探幅度有限,能耗的增长将挑战数字智能时代社会的可持续发展,在双碳 大背景下,构建绿色算力网络生态逐渐成为新的挑战和机遇。

4.1. 算力需求指数及增长,数据中心能耗要求越发严格

算力规模持续大规模增长,单位算力功耗逼近极限。功耗是影响算力水平发展的重要因 素之一,在单位算力功耗呈现出逐年递减,且正向着极限逼近的态势下,算力的整体量 级却仍然随着其广泛的应用而持续大规模增长。一方面必须依托算力的大规模使用以实 现智能社会的演进,而另一方面这一进程又必将伴随着碳排放的提升而导致全球气候的 不可预测性显著增加,这一双手互博式的矛盾综合体正在引起越来越高的关注。

硅基芯片工艺制程提升的难度凸显,单位算力功耗进一步下探幅度有限。随着工艺制程 的进步,输出单位算力所需要的功耗水平( W/GFLOPS )从 90 纳米制程开始呈现出了指 数级下降的趋势,发展到当下 7 纳米制程的先进处理器芯片时已开始趋近于О WIGFLOPS,下探难度愈发增大。从原理来看,由于功耗水平下降的核心驱动力来自于芯 片制造工艺的低制程化,而这一趋势正受到硅基芯片上晶体管栅长缩减引发的量子隧穿 效应挑战,一旦到达临界制程可能将造成晶体管闭合功能的全面无效化。因此在没有新 型材料替代的条件下,单位算力功耗难以进一步下降。

数据中心用电量占比持续提升,制冷及 IT 设备占比达 80%。在芯片单位算力功耗下降 幅度有限的背景下,智能社会应用的广泛普及无可避免,势必导致算力功耗总量的进一 步提升。根据工信部数据,随着人工智能、物联网、区块链等技术的发展,我国数据中 心总用电量为 1609 亿千瓦时,占中国全社会用电量的 2.35%,已经显著超过上海市 2018 年全社会用电量。面问未来,数据中心算力将在信息技术产业的大力发展下继续增长, 2023 年将较 2019 年增长 66%,年均增长率将达到 10.64%。从数据中心内部来看,我 国数据中心电力成本占运营成本的 60%以上,数据中心耗能部分主要包括制冷系统、IT 设备、供电系统和照明系统,其中制冷系统和 IT 设备合计占总能耗的 80%。

超大型数据中心符合绿色趋势。数据中心 PUE 优化的一大核心方向在于建立更多超大型 (>10000 个标准机架可共置至少 100000 台服务器)和大型数据中心(>3000 个标准机架 可共置放至少 30000 台服务器),从而带动整体数据中心 PUE 值优化。超大型/大型数据 中心会更加系统地从基础设施和管理系统层面来进行优化,降低功耗,且通常会采用能 耗比更加优秀的服务器、数通设备、节能型供电和冷却配套硬件解决方案。

4.2. 大型化、智能化和散热技术创新是绿色数据中心关键点

以百度云计算(阳泉)中心为例,其设计容纳 16 万台服务器,采用了先进的整机柜服务 器,以模块化设计将供电、散热系统与服务器置于同一机柜内,针对每个机柜服务器的 实际运行及功耗进行个体化调节,同时辅以高压直流+市电直供的供电模式,实现传极 高的能源效率。在数据中心运营管理软件层面,大型数据中心会采用基于 Al 的智能化管理系统对供电、 冷却系统的运营状态进行自适应的动态化调整。如华为廊坊数据中心所采用的 iCooling 数据中心能效解决方案,通过 AI 对历史运营数据分析,寻找供电、通风、冷却等影响能 耗的不同关键因素,建立预测模型并对相应系统进行动态调整,降低 PUE,实现能耗优 化。

除散热创新外,UDC 是数据中心的未来新方向。海底数据中心(简称 UDC)由岸站、海 底光电复合缆、海底分电站及海底数据舱组成,主体结构为罐体结构,电气设备、冷却 系统均布置在罐体内部,罐体顶部为海水冷却系统。通过庞大的海水流冷却数据舱,有 效降低能耗,单舱 PUE 可低于 1.1,是高效利用海洋资源(海上风能,波浪能、潮汐能) 的成功典范,海底 IDC 解决方案需求将与日俱增,尤其在华南沿海城市,市场潜力无穷。UDC 优势主要体现在降低成本上。UDC 使用海水冷却,无压缩机运行,能够有效降低能 耗,在 25MW 典型规模情况下,UDC 综合成本降低 29%,运维成本降低 22%,且岸站 占地少,只有 1/3,不需要冷却塔,罐体内为惰性气体,故障率低,单机柜 15-35KW, 算力密度高,模块化生产,部署效率高,90 天内完成从工厂安装、调试到实际运行。

4.3. 芯片功耗提升空间有限,低功耗和云边端一体是主旋律

芯片领域,ARM 和 X86 架构正在碰撞出更多火花。ARM 与 x86 的竞争本质上是两种不 同思路的指令集系统的竞争。指令集系统在发展过程中,分化出复杂指令系统计算 (Complex instruction set computing, CISC)和精简指令系统计算(Reduced instruction set computing, RISC),后者被使用在 ARM 上。RISC 是相对于 CISC 而言的,其通过精 简指令集来减少硬件设计的复杂程度,同时每条指令集长度均相等,因此可以提升指令 集执行效率,所以相同计算量下,效率往往比 CISC 更高。事实上,Intel、AMD 的新款 x86 产品也在向精简指令迈进,仅底层运行 CISC 指令。

功耗压力大,ARM 在服务器领域正在兴起。CISC 的复杂性决定 x86 架构的 CPU 需要更 高的单核主频、更多的线程才能有更强性能,在摩尔定律逐渐接近瓶颈的现代,x86 的 芯片设计、制程要求变得苛刻,因此生态变得极为封闭,目前市场仅剩 Intel、AMD 两位 玩家。ARM 走“众人拾柴火焰高”的路线,2021 年已授权 530 家合作伙伴,授权数 量达到 1910 件。ARM 赛道玩家众多,在商用服务器 CPU 领域,华为海思、凯为半导 体、高通、安培和飞腾均有代表性产品。

ARM 入局服务器领域并非制程工艺、主频&核心数竞赛的结果,而是下游需求转变促使 ARM 芯片能够在服务器中发光发热。ARM 得到云计算大厂青睐,主要有以下几个原因:1)边缘计算及微型 IDC 需求增加,ARM 依靠低成本占据优势。受国际形势及各国加 强数据主权的影响,各大云计算厂商都在积极向市场投放微型数据中心,微型数据中心 体积相对较小,对能源的需求较低,以便帮助集中式数据中心完成一部分边缘计算任务, 同时,边缘计算往往数据多元化、计算负载变化大,因此 ARM 架构 CPU 是部署微型数 据中心建立分布式业务的更好选择。例如,同代的 ARM Cortex-A72 与 x86 Broadwell 对 比单核物理面积,前者仅 1.15mm2,是后者的约七分之一。

2)ARM 架构的“众核”、单线程架构保证了更高的效率。以 Oracle 公司 OCI 云服务的 AmpereA1 CPU 为例,相比于同代、相似性能 x86 架构的 IntelXeon Optimized 3, AmpereA1 在执行 H.264 视频处理计算任务时花费 1 美元处理的帧数提升了 98%,相比 AMDEPYCE4 提升了 22%。ARM 架构 CPU 拥有更低的单位成本,一是因为 ARM 的专用 计算单元与异构计算技术结合,处理速度更快,二是因为 x86 架构 CPU 单核主频高、线 程多,处理任务时功耗较高,而 x86 的多核优化往往难以在不同计算任务中都得到保证。

3)异构计算时代到来,ARM 的可定制特性获得青睐。在没有云服务的时代,x86 这种 通用性、兼容性强的架构可以满足绝大部分计算需求,同时,摩尔定律在过去可以持续 生效,提升主频频率、增加核心数便可以使芯片性能突飞猛进;而如今硬件虚拟化、云 计算兴起,同时芯片制程迎来瓶颈,让计算机引入特定计算单元变成必然趋势,异构计 算成为串/并联特定种类的计算机的混合系统,因此以定制化见长的 ARM 架构便有了用 武之地。

4)云端一体化趋势已现,打通生态 ARM 前景可期。2020 年,苹果公司首次发布基于 ARM 的 M1 芯片取代 Macbook 系列 intel X86 芯片, M1 芯片提升专用计算性能(如 macOS 擅长的视频剪辑、图像处理)仅是苹果自研 ARM 芯片的其中一个小目标,其最 重要的目标在于统一不同设备的芯片架构,创造出设备从底至顶的完全互联互通, M1 芯片的 macOS 设备现在可以运行一部分 iOS、iPadOS 的 App,未来后两者也有望运行 macOS 原先专有的 App。无独有偶,在移动端和物联网领域,ARM 生态市占率明显领 先,手机、物联网终端设备、电动车智能座舱等越来越多领域使用高通或其他 ARM 架构 芯片,云端一体化趋势下,ARM 生态前景值得期待。

目前我们使用 x86 和 ARM 服务器时不存在特别的感受,是因为厂商在研发时已经尽可 能地将其封装成黑盒产品,以避免兼容性问题;但是未来随着大部分算力都有望搬上云 端,x86 厂商则必须重新审视云端与终端的异构兼容效率。从各厂商的研发动向来看, Nvidia 发布了基于 ARM 的 AI 计算 CPU,大幅突破了云端深度学习与终端 Nvidia GPU 的 数据传输瓶颈;微软正在自研 ARM 处理器,将率先使用在自家 Azure 上;Intel 进军与 ARM 同源的 RISC-V,从另一个方向入局精简指令集生态。我们认为,ARM 架构的芯片 有望逐渐成为主流服务器芯片之一,从底层硬件的层面解决云端与终端的生态壁垒问题。

4.4. 提升光传输密度是降低器件功耗的主攻方向

在基站设备及数据中心内部,芯片/Serdes/光电转换模块等关键器件的功耗在整机功 耗占比达 60%-80%。通过提高光模块速率,或者芯片出光、光交换,实现设备能效显 著提升。光模块速率提升单位功耗明显降低,而共封装光学( CPO)把光收发器与设备芯 片集成在一个 CMOS 衬底上,省去 CDR、DFE/CTLE/FFE 等功能,有望提升 80%的 Serdes 能效。光模块速率提升单位功耗明显降低,高速率大势所趋。传输速率是光模块重要的技术指 标,随着光通信行业的不断发展,高速率产品是光通信行业的发展趋势,高速率产品在 单位能耗上也更具优势,符合绿色化大趋势。目前,针对数据中心&以太网的产品方案包 括 10G、25G、40G、100G、200G、400G、800G 光通信模块。以中际旭创产品为例:10G 光通信模块能耗小于 1.8W;25G 光通信模块能耗在 1W~1.5W 区间。40G 光通信模 块能耗为 1.5W~3.5W。100G 光通信模块能耗在 2.5W~4.5W 区间。200G 光通信模块:能耗为 5.5W~6.5W。400G 光通信模块:能耗在 12W。800G 光通信模块:能耗在 16W。数据中心使用光模块单 Gbit/s 的能耗呈现向不断减小的趋势发展。

CPO 方案有望大幅降低能耗。传统交换机的光模块在前端面板,距离交换机 ASIC 较远, 由此产生的物理效率损耗逐渐成为交换机速率进一步提升的瓶颈,传统交换机速率达到 51.2T 以上时将迎来功耗墙。共同封装光组件(CPO)交换机将交换机芯片(或 XPU) ASIC 和光引擎共同封装在同一基板上,光引擎的位置尽量靠近 ASIC,以最大程度地减 少高速电通道损耗和阻抗不连续性,从而可以使用速度更快、功耗更低的片外 I/O 驱动 器,功耗墙问题迎刃而解。CPO 已经成为业界的替代封装方案。

4.5. 结合使用绿色能源是算力可持续发展之路

我国绿色能源资源丰富。降低数据中心 PUE 的手段除了在制冷散热上,还可提高运营中 可再生能源的覆盖率,通过减少传统化石燃料消耗,以达到减排目的。我国可再生资源 丰富,太阳能、风能、水能等可再生能源使用将显著降低碳排放,瞄准可再生能源是算 力可持续发展的必经之路。

SAI 是一家横向整合算力、热力和电力行业的全球算能运营商和清洁能源科技公司。不 少公司近年来在算力余热综合应用领域进行探索,例如 SAI 采用独家的液冷和余热回收 技术,循环利用芯片余热为潜在客户提供清洁热力服务,同时降低数字资产算力基础设 施的运营成本。目前大多数比特币采矿中心仍然由煤电厂提供电力,而可再生能源的使 用在带来新的机遇同时也使电网运营商面临着一个棘手的问题:人们无法控制太阳能发 电和风力发电所产生的电力数额。当产生的电力过少时,运营商可以通过启动水力或化 石燃料发电机来进行补偿。但处理过多的能源则是一个复杂的挑战。而 SAI 作为一家提 供清洁算力服务的企业,通过将算力整合到能源领域,着手致力于解决类似的困境。

从清洁计算业务的角度来看,SAI 有四个主要技术领域。SAIHEAT(芯片余热利用)、 SAIWATT(清洁能源消耗)、SAIBYTE(计算云网络系统)和 SAICHIP(新型计算芯片)。SAIHEAT 通过提供 "液体冷却+余热利用"的一体化解决方案,将计算过程中产生的余热 收集起来,进行再利用,在用清洁能源替代传统热源的同时,帮助大幅度降低电费。SAIWATT 利用水电、风电、废气发电等闲置能源进行计算发电,实现闲置能源消耗和削 峰填谷,并为能源所有者和作为运营商的 SAI 降低成本。SAI 还提供计算能力云服务和 新型芯片材料,共同降低计算行业的成本。通过前沿的基于清洁能源的计算和能源中心, 以及余热利用技术和功耗技术,SAI 可以在计算过程中减少高达 30%的能源消耗成本, 同时减少基础设施投资,从而为公司及其合作伙伴带来高利润率。

奥飞数据是国内首家严格按照国内外碳排放核算情况下自运营开始就提供零碳绿色的数 据中心的 IDC 公司。公司拟采用的节能减排措施包括采用磁悬浮制冷设备等新型节能技 术、加装自动调节压缩机启动等节能装置、选用低功耗变频设备、搭配使用太阳能光伏 发电系统等,务求逐步降低公司数据中心的 PUE 值。公司低碳策略一直走在行业前列, 今年 7 月制定《广东奥飞数据科技股份有限公司数据中心碳中和及新能源战略规划》,强 调公司日后要加大研发投入,健全核查标准建立,扩张光伏发电,以巩固、放大目前“绿 色”优势,加快主营业务收入增长率。

4.6. 构建全光智能算力网络,“东数西算”实现资源最优解

在算力未来需求持续增加的情况下,网络带宽和时延限制(性能)和网络带宽成本限制 (成本)导致的算力需求错配问题将进一步突出,运营商作为算力网络的底层构建者,将 承担越来越重要的责任,构建全光智能算力网络,通过资源调配如东数西算实现资源最 优解,不仅有助于降低能耗,更是有助于实现对网络、算力资源、需求等综合的最优解。在“网络化”算力有效补充了单设备无法满足的大部分算力需求后,仍然有部分算力需 求受不同类型网络带宽及时延限制,仍然无法满足低时延、大带宽、低传输成本的算力 需求场景,如智慧安防网络、CDN 加速等,算力需求与算力输出由于网络因素影响导致 错配,造成算力潮汐效应。全光底座的建设首次提出于第 28 届中国国际信息通信展览会的“中国之光高峰论坛”上, 中国移动通信集团广东有限公司规划技术部总经理蔡伟文提出建设全光底座,打造粤港 澳大湾区的全光网城市群。全光网的特点是全光接入、全光互联、全光交换,又可以分 为全光底座、全光业务和光网大脑三个部分。用个简单的比喻,全光底座相当于高速铁 路,是全光网的物理基础,具备架构极简、链路超宽以及经济节能的特点;全光业务则 相当于高铁列车,是全光网的业务载体,提供超清视频、精品专线、5G 等全业务的极致 承载体验;光网大脑相当于高铁的调度中心,是全光网的智能支撑,提供全光底座及全 光业务的智慧运营。”

根据中国联通研究院与华为技术有限公司联合发布的《云时代的全光底座白皮书》,要打 造面向品质业务和云化转型的坚实全光底座,那么全光底座应该具备如下关键能力:① 架构稳定,极简,大宽带,可扩展:全光组网,一跳直达,稳定低时延。传输容量持 续演进,组网能力持续提升,灵活扩展,确保全光底座架构稳定。② 全光锚点,全业务接入:支持 ETH/SDH/PON/OTN/WDM 等多种接入技术,兼容现 网,平滑演讲。③ 广电协调,确定性承载,安全隔离:基于 L0/L1 的硬管道技术,按需灵活协同调度, 满足高品质业务的确定性承载及高安全业务的物理隔离需求。④ 端到端切片,一网多业务差异化 SLA 服务:通过端到端切片,为家宽、移动、专线 等不同品质需求的业务,提供不同 SLA 等级的承载服务。⑤ 云光协调,业务灵活如云:通过与云网关的业务和保护层面对接,实现新型云化业务 的云网协同部署和运维,品质成本双优。

当前社会发展已经全面进入数字智能时代,伴随科技创新浪潮的推进,不断涌现出算力 的新应用场景,且需求量持续激增,在 AI 和深度学习的深度赋能下,包括智能汽车、 自动驾驶、元宇宙、AI 机器人等场景正在持续迭代升级,都将对算力提出新的需求,多 场景共荣算力生态正在成型。

我们参考华为对科技创新浪潮下算力的定义:未来人工智能、物联网、区块链、AR/VR 技术发展将带来对算力随时、随地、随需、随形(Anytime、Anywhere、Any Capacity、 Any Object)的 4A 能力要求。在随时层面,未来算力发展将关注低时延与连续性,低时延要求算力对数据处理的及时 反馈,而连续性要求算力不间断的支撑。以自动驾驶汽车场景为例,面对复杂多变的路况信息,自动驾驶汽车需要确保针对行驶过程中的任何突发性状况进行实时反映。同时 在行驶的旅途中始终如一地保证算力对于路况、车况监控的的“专注度”。未来 L4&L5 级 别对网络带宽的需求将大于 100Mbps,时延要求达到 5-10 毫秒的水平。

在随地层面,高速增长的技术应用场景与终端设备使得算力需要大量应用在不同地点。因此在未来社会中,算力将因为智能应用场景的不断涌现而无处不在。无论是应用在政 务领域的人脸识别、智能安防,民生领域的智能出行、移动支付,亦或是产业领域的智 慧工厂、智慧农业,所有智慧场景都与算力密不可分。在随需层面,未来的算力应能够满足任意量级场景与终端设备的算力需求,并按照实际 需求进行自适化的调配。如自动驾驶领域的算力需能够同时满足车辆出行低峰期与高峰 期的算力需求。

5.1. 人工智能核心驱动,算力发展没有天花板

AI 近年来实现了长足的发展,算法和算力的持续发展,为下游应用创造了更多的可能。AI 依托云边端的整体架构,通过算力协同的模式下,云端云中心承担模型训练任务,端 侧的各设备进行模型推理,二者之间的边缘侧负责通用模型的转移学习,释放对带宽、 算力、存储空间的持续压力。边缘计算向算力集群异构设计发展,其异构化程度将会高 于传统的数据中心,异构设计的突破将会进一步提高端边云的整体计算效能,进而加速 AI 模型的训练与推理。

人工智能作为一项底层技术,几乎可以渗透到各个领域,本文后续还将就重点领域展开。IDC 预测到 2025 年,人工智能涉及的场景规模将达到 2081 亿美金,并在自动驾驶、智 慧金融、智慧医疗、智慧零售、文娱等领域大显身手。人工智能技术对于算力的核心拉 动点在于未来各应用场景内单设备芯片算力的增长和人工智能技术的行业渗透率的进一 步提升,带动对云计算中心、边缘设备和终端算力的巨大需求。整体预计在 2030 年,人 工智能相关领域对于算力的需求将达到 16000EFLOPS,相当于 1600 亿颗高通骁龙 855 内置的人工智能芯片所能提供的算力,依旧有数百倍的增长空间,可以说算力发展没有 天花板。

5.2. 智能网联车——自动驾驶和智能座舱,算力争霸制高点

智能网联车是汽车电动化的大趋势,众多新老车企纷纷瞄准电动车市场,瞄准完全自动 驾驶,把车打造成第二智能场所。从智能的角度看,我们可以聚焦在两个方面,分别是 实现全面自动驾驶和实现全面的智能座舱影音娱乐上,二者对算力均有强大的需求,是 智能网联车算力争霸的制高点。

首先自动驾驶场景为例,根据自动驾驶等级,对算力需求可以分为以下几个阶段:

1)在自动驾驶初级阶段如 L2 阶段,对于算力的要求较低,仅需要满足 1-3 个 720P 车 载摄像头、1-2 个雷达所产生的数据量即可,且无需对所有进行实时分析。

2)在自动驾驶的中级阶段,以目前完全达到 L3 级别的最新特斯拉汽车(搭载 Full Selfdriving Computer 系统)为例,其使用的 AI 自动驾驶芯片上的神经网络处理器(NPU) 通过提供强大算力支持,在匹配其专属的 Autopilot 3.0x 系统后,能够同时处理安装 在车头和车身上的总计 8 个高清摄像头和 10+雷达产生的数据量,使得特斯拉汽车 可以对行驶路线、车辆状态、路况安全等情况进行快速分析并持续作出反应,实现有 条件自动驾。

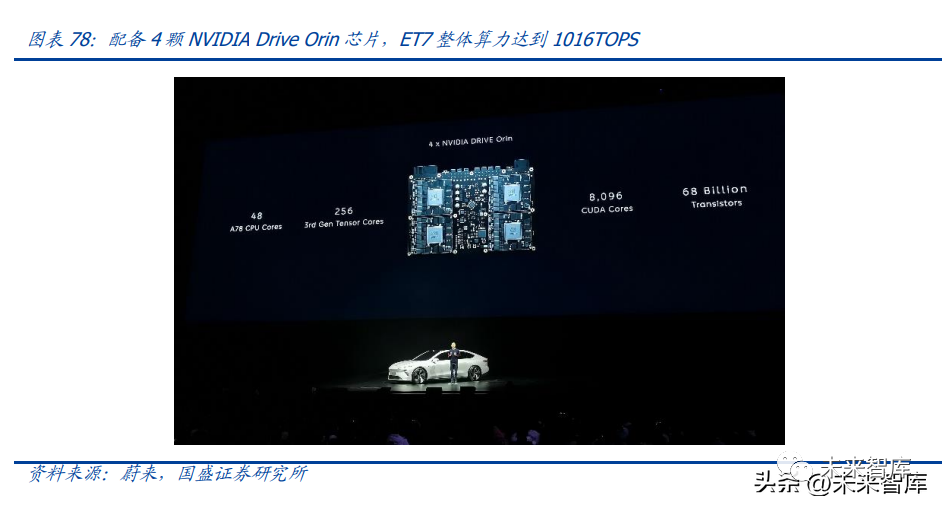

3)在自动驾驶的高级阶段,以能够满足 L4 级别自动驾驶算力需求的华为 MDC 系统 (Mobile Data Center)为例,其通过整合最新的 AscendCPU 芯片、Al 芯片、ISP 芯 片与 SSD 控制芯片在提供低时延(小于 200 毫秒的端到端延时,小于 1 毫秒的 ROS 内部延时,小于 10 微秒的内核调度延时)的背景下,能够满足 16 个摄像头、16 个 超声波雷达、8 个激光雷达、6 个毫米波雷达等车载传感器同时工作而产生的庞大数 据流量。除此之外,英伟达预测,L4 级别的自动驾驶汽车需要面临更为复杂的驾驶 条件、更冗杂的安全纠错机制、更多层级的软件框架,在无法完全靠优化算法的情况 下,对车载算力约有 50 倍的提升要求。

4)最后,在自动驾驶的终极阶段,即完全自动驾驶阶段 L5,车载芯片将会面临来自非 标准公路、山路、复杂路况下的路况苛刻识别需求,在与 L4 级别汽车的数据传输量 相似的情况下,对车载芯片的复杂数据处理能力和快速分析和决策能力提出了更高 要求,预计有约 10 倍的计算能力增长需求。

全球自动驾驶渗透率将快速提升,根据华为数据,2020 年 L1/L2 级功能渗透率将达 40%, L3 级功能也逐渐开始量产,2020 预计渗透率将达 5%,L4 级别自动驾驶汽车将在 2025 年左右实现量产。至 2040 年,所有新车都将配备不同级别的自动驾驶功能,其中 L4/L5 级别自动驾驶在新车销售中的渗透率将超越 30%。未来将有约 2 亿辆搭载具有不低于 300-500 TFLOPS 算力的自动驾驶汽车上路,驱动整体算力需求增长。同时,由于交通存 在高峰时间与低峰时间,在人们出行方式不发生巨大改变的前提下,每天不同时间的自 动驾驶车载算力巨大需求波动需要大量的云端和边缘端计算设备提供弹性的算力支持。

此外,实现自动驾驶需要大量数据进行神经网络训练,对算力的需求也十分巨大。特斯 拉在 2021 年 8 月的 AI DAY,着重介绍了在人工智能领域的软件和硬件进展,尤其是神 经网络上训练系统的 Dojo 超级计算机。它采用特斯拉自研 Dojo D1 超级计算机芯片, 用于车辆自动驾驶数据的运算和分析,能够自动地学习和识别标记道路上的行人、动物、坑洼地等数据,将海量的数据汇聚于 Dojo,然后通过自动化深度神经网络训练,以此不 断加强算法进化,最终实现以纯视觉为基础的完全自动驾驶(FSD)。

英伟达作为人工智能领域的领跑者,深度参与了自动驾驶,具备从芯片到软件到训练框 架全栈的平台能力。根据英伟达 2022 年投资者大会的信息,到 2030 年,整个乘用车和 商用车将超过 10 亿辆,电动车渗透率将达到 50%以上,L2 和 L3 的车辆渗透率将从 10% 提升到 50%,单车 FSD 价值量将持续高速增长到 1.2 万美元量级,图像处理需求将增长 10 倍以上,整个自动驾驶市场空间将达到 3000 亿美金以上。英伟达全面赋能助力自动驾驶革命。当前各车企大多选择将自动驾驶当做核心竞争力, 选择自研,而自动驾驶难度大,需要具备极高的研发能力。英伟达帮助企业提供端到端 的开发流程,从数据收集、数据标签处理、驱动器映射、模型开发、NCAP、自动泊车等 提供全流程。英伟达与 30 家电动车企中的 20 家,10 家电动卡车企业中的 7 家,10 家 自动出租企业的 8 家,以及为所有自动驾驶数据中心赋能,主导了自动驾驶革命。

在过去几十年中,汽车电子电气架构一直遵循着“一个功能一个盒子”的分布式架构模 式,信息娱乐系统、车身系统、车辆运动系统、动力总成系统各自独立,通过中央网关 实现连接。不同于传统汽车电子电气架构面向信号的架构,面向服务的软件架构有标准 化的服务接口,松耦合的服务机制,以及可组合拓展的服务特性,整体架构更加集中, 主要分为运动域、ADAS 域、娱乐域。

智能座舱作为整车娱乐智能核心,持续高速发展中。智能座舱作为人车交互的核心,其 智能化程度代表了整车的智能化,也是当前车企竞争的核心领域。当前智能座舱大多采 用可插拔式模块设计,放置在中控屏下方,可根据客户需求及产品迭代持续升级,智能 座舱逐渐向一芯多屏、多屏联动,分布式外设、AR 实景、5G 实时在线和高清娱乐升级, 语音、触控、视觉、3D camera 等多种交互方式,对算力、存储的要求也越来越高,当 前 20 万以上的车型大多配备新型智能座舱。对投资者而言,此前大家预期中的车用物联网模组主要实现车车通信、车路协同的功能, 而今随着智能座舱功能的复杂化,5G 将搭载各类应用在车内呈现,对着算力的需求陡增, 车用物联网模组已从“功能机”时代进化到“智能机”时代,预计随着明年更多中高端 车型的面世,车用智能化模组将迎来爆发。

高通发力智能座舱,占据半壁江山。高通在车领域有着领先的布局,在通信领域有着深 刻积累,凭借在移动端的广泛成功经验,高通将骁龙系列芯片拓展至汽车座舱领域。当 前除特斯拉具备极强的供应链管理和自研能力选择定制化方案,大多数车企在智能座舱 领域选择了高通平台,包括新势力车企蔚小理在内的众多车企选择了高通 8155 方案打 造智能座舱。考虑到智能座舱主要负责影音娱乐,需要联网与外界实现通信,而高通本 身在移动通信端拥有深刻积累,其 soc 往往具备基带通信能力,能够为车企提供完整的 解决方案或者丰富的选择。我们以 8155 为例,其具备 CPU、GPU、NPU,并且可选配通 信基带、GNSS、蓝牙 WIFI,能够帮助车企快速打造智能座舱。

5.3. 元宇宙:算力即权力

算力是构建元宇宙最重要的基础设施,元宇宙内容与交互方式的发展都离不开算力的提 升。元宇宙并不是网络游戏,但与游戏类似的是,元宇宙是一个承载活动的虚拟世界。相较于游戏所看重的娱乐性,元宇宙的重点更在于这个虚拟时空的体验,和人们在其中 的社交与活动。但与游戏类似的是,元宇宙也需要图形显示、成熟的显示技术作为支撑。

算力支撑着元宇宙虚拟内容的创作与体验,更加真实的建模与交互需要更强的算力作为 前提。游戏创作与显卡发展的飞轮效应,为元宇宙构成了软硬件基础。游戏产业每一次 重大的飞跃,都源于计算能力和视频处理技术的更新与进步。游戏 3A 大作往往以高质 量的画面作为核心卖点,充分利用甚至压榨显卡的性能,形成“显卡危机”的游戏高质 量画面。游戏消费者在追求高画质高体验的同时,也会追求强算力的设备,从而形成游 戏与显卡发展的飞轮效应,这在极品飞车等大作中已有出现。

元宇宙应用所需要的 VR 交互,对于算力要求达到了新的高度。根据华为预测,预计到 2025 年,AR/VR 涉及的场景规模将达到 596 亿美金,设备端计算能力的提升、VR/AR 设备的普及和普及需要的云计算中心和边缘计算设备算力配套将共同推动整体算力的增 长。整体预计在 2030 年,物联网技术相关领域对于算力的需求将达到 3900 EFLOPS, 相当于 21 亿台索尼顶级游戏机 PS4 所提供的算力。

AR/VR 技术对算力的核心拉动方式主要有 3 点:

1、单设备芯片算力需求提升:4K/8K 的 VR 视频设备需要更为强大的算力支持。大渲染量、高级特效、低延时要求对负 责输出 VR 视频的 GPU 算力和相配套的云端、边缘设备的算力提出了近乎苛刻的要求, 图形处理器 GPU 性能要达到>100TFLOPS,这是目前最顶级的 GPU 也做不到的。

2、VR 设备的普及将提升云/边端计算的需求:伴随以 Oculus、Hololens 为代表的高清设备和以优质应用的涌现,据 IDC 预测,2023 年终端出货量将达到 3670 万台,年均复合增长率超过 51.3%,未来 VR/AR 设备在商 业、医疗、教育、影视娱乐等行业的渗透率会急剧增长。此外,随着 5G 网络的普及,大 量高清 VR 内容将会实现像现在网络视频一样的在线点播,需要云端提供编码和渲染支 持、边缘端算力提供编码、拼接、渲染支持。

3、VR 应用对低延迟的要求更高:高质量的虚拟现实体验对于要求带宽和时延能够满足至少180Mbps带宽和20毫秒时延。为了在三维全景下达到理想的沉浸式体验效果,VR/AR 设备需要实现更高的视网膜分辨 率、更广的观察视角、更精准的位置感应等,这对带宽的需求至少 180Mbps。而为了保 证在使用过程中避免感知到明显的图像滞后而导致的眩晕,在 VR/AR 游戏中,端到端的 时延至少需要小于 20 毫秒。

英伟达云计算平台目前主要用于人工智能培训、人工智能推理、高性能计算和图形化计 算四个方向。具有按需使用且不受限的计算能力、IT 管理简化性、易更新性和定价灵活 性等特点,助力智能活动并推动科学突破。

WebGL 协议能够使开发者实现在浏览器中更复杂的图形渲染。WebGL(全写 Web Graphics Library)是一种 3D 绘图协议,这种绘图技术标准允许把 JavaScript 和 OpenGL ES 2.0 结合在一起,通过增加 OpenGL ES 2.0 的一个 JavaScript 绑定,WebGL 可以为 HTML5 Canvas 提供硬件 3D 加速渲染,这样 Web 开发人员就可以借助系统显卡来在浏 览器里更流畅地展示 3D 场景和模型了,还能创建复杂的导航和数据视觉化。显然, WebGL 技术标准免去了开发网页专用渲染插件的麻烦,可被用于创建具有复杂 3D 结构 的网站页面,甚至可以用来设计 3D 网页游戏等等。如何通过架构和通信提升云边端一体化的渲染效率?目前提升渲染效率的方法包括 AI 去重与重建、基于 FOI 渲染、以及在传输中使用 HARQ(混合自动重传请求)。通过在架 构和算法的优化,能够有效提升渲染效率,渲染效率能够达到传统方式的数十倍。

5.4. Web3 时代,算力将是重要技术支撑

NFT、Gamefi 作为 Web3 的典型应用,在追求体验的背后也离不开渲染技术的支持。渲染也被称为图像合成,是将 2D 或 3D 计算机模型转换为逼真的图像或场景。随着数字 化时代的大爆发,渲染被各行各业所需求。不仅在视频制作的特效,游戏的渲染可以增 强画面的交互式体验,制造业通过渲染将成像方式从原来的 3D 可视化转变为智能 3D 模 拟,医疗影像引入高级渲染将大大提高保真度,VR 和混合现实等人工智能场景更是需要 渲染营造身临其境的逼真感。同时 NFT、和 gamefi 方向对渲染也是必不可少,高品质的 NFT 和 gamefi 都需要大量的 3D 场景的变化,这个时候就需要大量对画质的渲染。

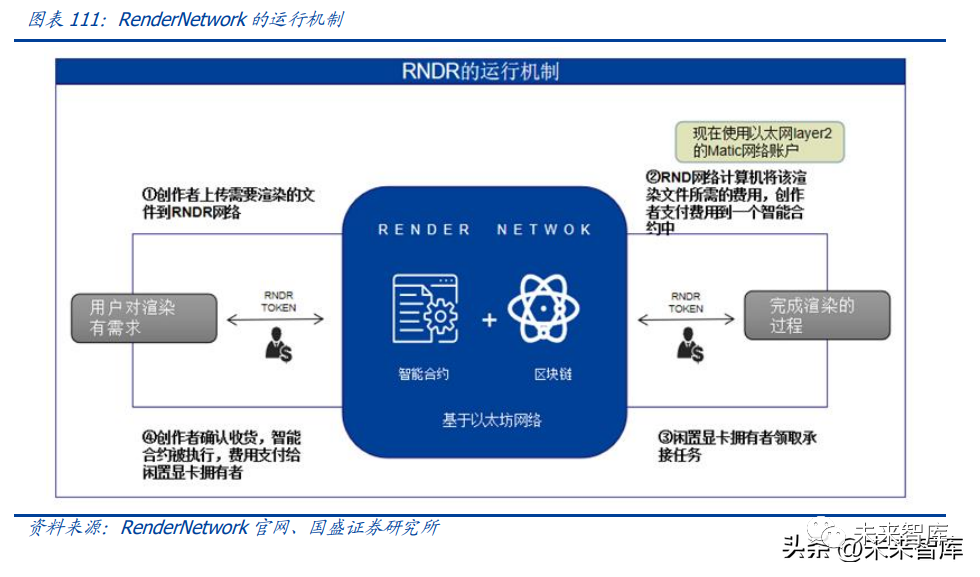

Render Network 是第一个基于区块链网络的渲染算力市场,用户通过代币可以自由 交易算力来渲染作品。不仅利用了闲置资源来使算力提供者得到了收入,也是需求算力 来渲染作品的用户,提高了质量和降低了水平。Otoy 是全球图像渲染领域的权威公司之 一,在 2017 年率先应用了区块链技术,推出了区块链项目 Render Network(渲染网络) 并发行了加密货币 RNDR。Render Network 总体是去中心化的网络,由艺术家和 GPU (图形处理单元)算力提供者组成,能够为全球用户提供渲染功能。

区块链技术与算力的融合为算力行业带来了新的商业模式,从而降低算力的使用门槛和 投入成本。RenderNetwork 面向有渲染需求的影视、游戏、工程等客户,以及愿意提供 出自己空闲算力的用户。用户在链上建立智能合约达成算力出租意向,RNDR 在链下通 过专用网络将用户空余的 GPU 资源整合,通过云计算制作出用户所需求的渲染作品。并 且所有的作品都会被加密上传进行安全的云存储,完成渲染后使用团队即可立即访问。RNDR 渲染网络的渲染成本要远低于中心化云服务,而个人闲置的算力也能够得到使用。

5.5. 万物互联:物联网高速发展,终端智能化赋能千行百业

随着 5G 的不断普及,以及需求的持续兴起,物联网正高速发展,以智慧安防、智慧物 流、智能零售、智慧工厂、智慧家具为主的众多下游行业正加速向智能化升级。根据 ZON 预测,预计到 2025 年物联网技术涉及的场景规模将达到 1580 亿美金,通过智能物联网 设备的普及、配套云端计算中心和边缘端计算单元的增加将共同拉动算力增长。整体预 计在 2030 年,物联网技术相关领域对于算力的需求将达到 8500 EFLOPS,相当于 79 亿 台当下高端边缘设备使用的 EPYC7401 芯片所提供的算力。

以智慧工厂场景为例,其包括的物联网设备有红外传感器,光电传感器,超声波传感器 等,需要以华为 Boudica 1504 为代表的物联网芯片提供算力支撑。到 2025 年,应用在 工业物联网相关领域上的智能设备将达到 137 亿台,其余物联网设备分布在家庭、电网 等多种不同类型的场景下。在智慧工厂场景下,只有具有强大算力的云端服务器和边缘侧服务器才能对工厂内制造 生产的各个环节中数十万物联网设备每天产生的数百GB数据(包括但不限于机器名称、 材料编号、编程名称、标准参数、生产统计、生产合格/不良计数、机器状态、指示灯和 告警代码信息等)进行集中分析处理。强大的算力可以为智慧工厂运营带来两大效益, 第一是通过网络实时反馈到相关屏幕上,帮助工厂管理人员掌控整体工厂运行情况,及 时处理问题。第二是作为工厂自动化的基础,为整个生产线从原材料供应、仓储、零部 件生产组装、装配到最终的商品运送环节提供基本数据及机器状态等关键数据,结合云 端数据分析与智能判断能力,实现智慧生产。

内生需求+外部技术与政策驱动,产业智能化升级空间巨大。工业企业面临的人口红利 消失、研发投入不足与产品急需升级换代、产能过剩三大难题亟需工业互联网破解,而 政策与技术的逐步落地进一步加快工业互联网发展。近年来,我国工业互联网市场规模 增长迅速。2019 年中国工业互联网规模达 6080 亿,2015-2019 年每年增速均超过 12%。据前瞻产业研究院测算,预计 2020 年规模可达 6990 亿,较 2015 年增长近一倍。此外, 2019 年我国工业互联网下游渗透率仅 2.76%,具有较大的想象空间。

云+边+AI 有机融合,大幅提升行业效率。据市场研究机构 IDC 预测,2020 年全球超 过 50%的物联网数据将在边缘处理。而边缘设备只能处理局部数据,无法形成全局认知, 因此实际应用中仍然需要借助云计算平台来实现信息的融合。现阶段大型工厂在数字化、 智能化改造的过程中面临的核心问题之一是如何规模化提升产品质量和良品率,从而降 低原材料消耗和人工成本投入。企业通过创建基于云边协同的计算平台,将 AI 和深度学 习等技术应用于工厂产品质量检测,根据英特尔的工业互联网案例显示,相较于人工操 作,云边协同能将效率提升至少 5 倍,产品缺陷类型的检测率也提升到了 100%。

5.6. 算力时代的自主可控正成为核心焦点

8 月 31 日,英伟达向 SEC 披露了一份 8K 文件,2022 年 8 月 26 日,美国政府通知 NVIDIA,对公司的 A100 和即将推出的 H100 集成电路芯片,今后向中国(包括香港) 和俄罗斯的任何出口提出了新的许可要求,立即生效。同时,许可证的要求范围还会覆 盖到未来的一些 NVIDIA 集成电路产品,只要新品的一切性能等于或高于 A100 以及包 含这些电路的任何系统,都要遵守此次许可。AMD 也称收到了相关的禁止命令。A100 是英伟达于 2020 年发布的 GPU 旗舰产品,基于 Ampere 架构,采用的是先进的台 积电 7nm 工艺,拥有 540 亿个晶体管,GPU 的最大功率达到 400W。此外还有一款 A100X, 提供比 A100 更高的性能。这款作为通用型工作负载加速器,主要应用在 AI 领域。

GPU 架构是现代异构计算的完美集合。从应用领域通用性角度看,GPU 应用场景可分为 HPC 高性能并行计算、AI 训练和推理、HDV 高速视频编解码、3D 图形和视觉计算等领 域,单一市场应用和综合市场应用主要的差别在 GPU 能力的应用上,能力融合的产品应 用领域更为广泛。英伟达的整个 GPU 领域的集大成者,技术实力最全面,而芯片的综合 能力非常重要,往往跑分和实际应用差异较大。

中国拥有全球最大 GPU 消费市场,但自主 GPU 领域存在空白。中国 GPU 市场规模和 潜力非常大,庞大的整机制造能力意味着巨量的 GPU 采购。虽然近些年,计算机整机和 智能手机产量增长都出现瓶颈,但由于这两类产品体量庞大,2019 年国内智能手机出货 量为 3.72 亿部,电子计算机整机年产量达到 3.56 亿台,GPU 的需求量大且单品价值非 常高,市场规模依然非常可观。同时,服务器 GPU 伴随着整机出货的快速成长,需求量增长也较为迅速。据统计,2018 年国内服务器出货量达到 330.4 万台,同比增长 26%,其中互联网、电信、金融和服务 业等行业的出货量增速也均超过 20%。另外国内在物联网、车联网、人工智能等新兴计 算领域,对 GPU 也存在海量的需求。但自主 GPU 领域存在极大空白,市场对国产替代 产品的需求迫切。

国产替代空间巨大,产业链正高速发展中。我国算力芯片领域近年来正在持续追赶,整 个 AI 芯片市场竞争特点呈多样性,国际巨头仍采用拿手的 GPU 板卡方案,互联网巨头 打造闭环生态,初创公司采用低端 ASIC 板卡和算法解决方案。而国产 GPU 领域也正在 冒出一批独角兽公司,包括壁仞科技、天数智芯、沐曦集成、摩尔线程等在内的国产 GPU 厂商正在持续追赶,产品切入主要以 GPGPU 为主,针对算力需求和新创领域提供国产替 代产品。

6.1 集中算力投资:“光与云的确定性”

以云端算力为代表的集中式算力产业链,即 IDC、服务器、光器件、光传输等细分赛道, 经过多年发展,已经形成了较为完整的产业体系。但这并不意味着集中侧投资机会的减 少。当前来看,集中式算力投资呈现一定的周期性,国内经历了 19/20 年的建设高峰, 近年来需求侧有所减少。但目前随着国内运营商“双千兆”工程加速启动,东数西算布 局蓝图初现,我们较为明显的看到以光纤光缆为代表的部分集中式算力领域赛道已经开 始从周期底部复苏。从海外侧来看,尽管市场对于北美经济下行预期较为担忧,但正如 前文所述,海外云大厂的云基建资本支出仍然体现出了极强的增长韧性。同时,海外较 为老旧的固网系统与疫情带来的在线工作与社交需求之间的错配愈发明显,海外固网升 级在今年也呈现了明显的由需求带动的加速态势。

6.2“边缘+绿色”,无限可能的大空间机会

如前文所述,“泛在+绿色”是当下算力革命两大关键词。当下边缘计算呈现出“方兴未 艾、百花齐放”的特点,各类新技术方案与新应用形式加速产生。我们认为,边缘侧投 资主要分为设备与解决方案两条线路。设备侧,包括了边缘计算网关、DPI 设备、物联 网模组等,解决方案侧主要是边缘计算平台,物联网平台等 PaaS、SaaS 类产品。