很长一段时间,CPU 主导了整个数据中心,虚拟化算力成为云计算的重点。

直到人工智能应用的爆发性增长,GPU 的芯片架构被发现更适合支持大规模的AI模型训练和推理,GPU 成为数据中心第二大算力芯片。

当数据中心基础设施遇到的瓶颈越来越难以克服时,新一代 DPU 出现了。

从2021年下半年开始,陆陆续续出现了很多DPU领域的初创公司。DPU可以说是当前芯片行业最火热的方向,可能没有之一,风头和声势甚至超过了AI芯片这个“前浪”。

人们发现,单纯使用CPU并不能满足AI工程师和调参者对算力的野心,而GPU特别适合这类计算。GPU上有成千上万个小型计算单元,他们可以同时计算一个难题里的不同部分,然后再把结果结合起来,也就是“并行计算”。这种人海战术比CPU的“串行计算”不知道要高到哪里去了。从此,CPU不再是数据中心里唯一的王。英伟达也成了世界上市值最高的芯片公司。

GPU的登场,只是这场大秀的序曲。把CPU的一大部分算力卸载给GPU之后,人们发现可以把很多其他功能也外包出去,于是又有了智能网卡或者SmartNIC。

这个名字听起来既不智能,也不上口,这也注定了它并不能被大多数人所认知。工程师通常不屑于营销,但不可否认的是,没有营销,再好的产品也卖不出来。

当一个人既懂技术、又懂人心,创造一个新的概念就是顺理成章的事情。

2020年10月,黄仁勋在英伟达GTC大会上将基于Mellanox的SmartNIC方案命名为数据处理单元(Data Processing Units, DPU)。

这一年,应该可以算是DPU的元年。

DPU 是以数据为中心的 IO 密集型芯片,采用软件定义技术路线支撑基础设施资源层虚拟化,可以大幅提升计算系统效率、降低整体系统的总拥有成本。DPU可以通过软件定义,延伸至存储、安全等功能,从而满足不同应用场景的具体需求。因此,DPU 也被称为继 CPU、GPU之后的“第三块主力芯片”。

DPU概念一炮而红,吸引业内众多竞争者纷至沓来。作为主力芯片新物种,DPU 市场空间正快速扩张,预计至 2025 年,全球、国内市场有望分别达到 245.3 亿美元、565.9 亿元,复合增速分别为 51.73%、170.60%。当前,DPU 正快速进入数据中心、云计算、智能驾驶、数据通信、网络安全、信创、国防军工等领域。

特别是在数据中心、云计算应用场景,需求较为迫切。在智能驾驶领域,未来,每个车机节点都可视为小型数据中心,随机将产生大量数据的处理、转发、交换和存储需求,为降低车载终端无线侧传输时延,智能驾驶平台有望配备相应 DPU 智能加速平。以 NVIDIA 为例,其智能驾驶平台 Atlan 即集成了 DPU 芯片,并预计在 2025年用于车机之上。

面向DPU巨大潜在市场,海外科技巨头加大布局力度,NVIDIA收购 Mellanox 并发布 BlueField DPU 系列产品,Intel 收购 Altera 发布 IPU 产品,Marvell 和 AMD 等公司 也积极跟进。到国内的DPU创企中科驭数、星云智联、大禹智芯、芯启源、云豹智能,每一家企业都在摩拳擦掌,跃跃欲试。

经过一波收购,在“DPU”全球市场,四天王已完成布局。

老黄总结了3个DPU的特点:卸载、加速、隔离。对应DPU的三个主要应用场景:网络、存储、安全:

卸载:数据中心网络服务,比如虚拟交换、虚拟路由;数据中心存储服务,比如RDMA、NVMe(可以把它们理解成一些远程存储技术);数据中心的安全服务,比如防火墙、加解密等等

加速:上面说的那些服务和应用通常使用软件实现,并在CPU里运行。而DPU可以使用硬件实现并运行这些应用,这样比软件运行要快好几个数量级,这也就是我们常常会听到的“硬件加速”

隔离:由于上面说的应用在DPU里运行,而用户应用在CPU里运行,这样就把二者隔离开了。这样会带来很多安全和性能上的好处

一些基本的定位分析:

独立的DPU定位在基础设施处理器,主要是硬件加速

独立的GPU主要做应用层的弹性计算加速

而CPU主要负责低计算密度高价值密度的应用层的工作

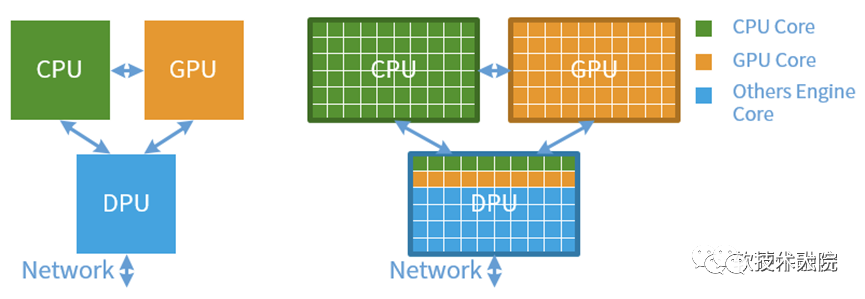

如下图所示:CPU有60个面积单位,共计60个CPU核;GPU有60个面积单位,共计60个GPU Core(差不多对应流式多核处理器SM);而DPU则由10个CPU核、10个GPU核以及40个其他加速引擎核组成。

DPU的出现是异构计算的一个阶段性标志。与GPU的发展类似,DPU是应用驱动的体系 结构设计的又一典型案例;但与GPU不同的是,DPU面向的应用更加底层。随着DPU将数据中心的基础设施操作从CPU上卸载过来,数据中心将形成DPU、GPU、CPU三位一体的状态。

DPU首先作为计算卸载的引擎,直接效果是给CPU“减负”。DPU的部分功能可以在早期的TOE(TCP/IP Offloading Engine)中看到。正如其名,TOE就是将CPU的处理TCP协议的任务“卸载”到网卡上。

传统的TCP软件处理方式虽然层次清晰,但也逐渐成为网络带宽和延迟的瓶颈。软件处理方式对CPU的占用,也影响了CPU处理其他应用的性能。TCP卸载引擎(TOE)技术,通过将TCP协议和IP协议的处理进程交由网络接口控制器进行处理,在利用硬件加 速为网络时延和带宽带来提升的同时,显著降低了 CPU 处理协议的压力。

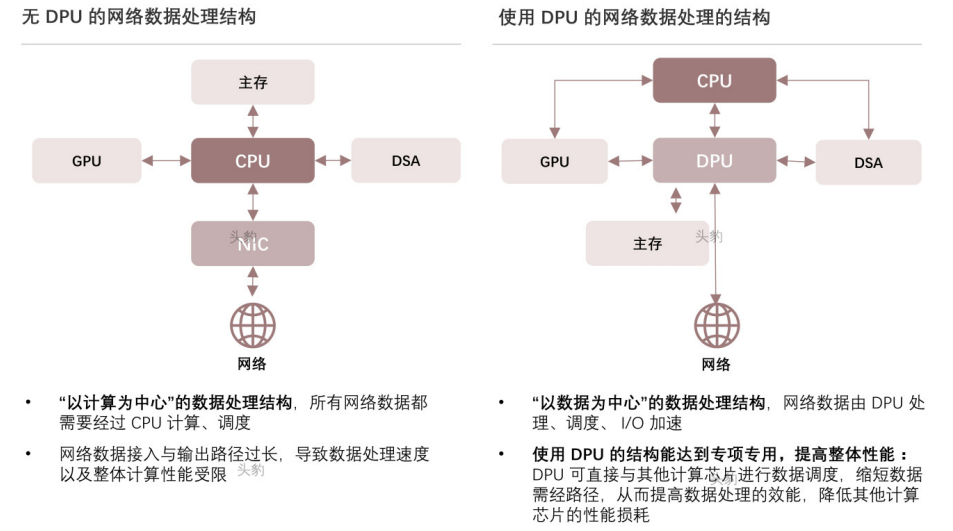

网络数据处理结构分析:

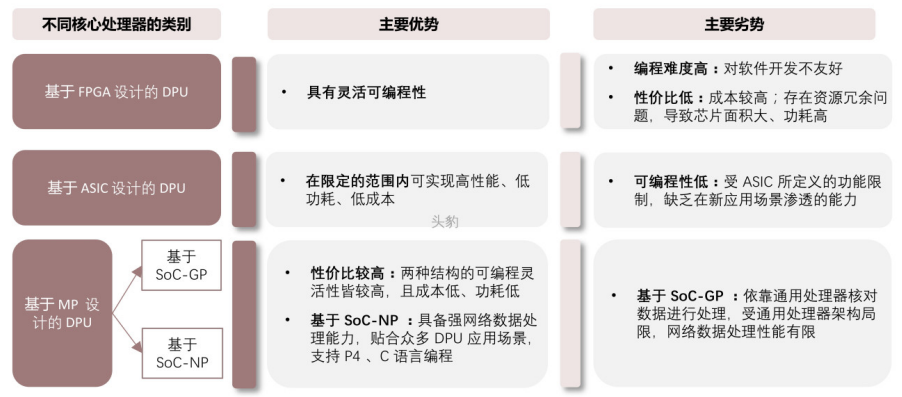

主流的DPU三种技术路线对比:

一是以通用众核处理器为基础DPU(FPGA路线),例如Broadcom的Stingray架构,以多核ARM为核心,以众取胜,可编程灵活性较好,但是应用针对性不够,对于特殊算法和应用的支持,与通用CPU相比并无太显著优势

二是以专用核为基础的异构核阵列(ASIC路线),这种架构的特点是针对性较强、性能较好,但是牺牲了部分灵活性,如IPU

三是将通用处理器的可编程灵活性与专用的加速引擎相结合(MP路线),正在成为最新的产品趋势,以NVIDIA的BlueField-3系列DPU来看,就包括16个ARM核及多个专用加速引擎,Fungible的DPU则包含6大类的专用核,和52个MIPS小型通用核

主流的DPU厂家产品对比:

DPU要解决的核心问题是基础设施的“降本增效”,即将“CPU处理效率低 下、GPU处理不了”的负载卸载到专用DPU,提升整个计算系统的效率、降低 整体系统的总体拥有成本(TCO)。DPU的出现也许是体系结构朝着专用化路线发展的又一个里程碑。

DPU最直接的作用是作为CPU的卸载引擎,接管网络虚拟化、硬件资源池化等基础设施层服务,释放CPU的算力到上层应用。

从处理网络负载和卸载 CPU 任务的智能网卡,演变成新一代数据中心算力和服务的核心,让云服务商“将基础设施和客户应用分而治之”,这个思想也指导着数据基础设施领域近年来的诸多创新。

随着单一服务器的网络端口的速度达到 200G 或以上,原来的网络、存储、虚拟化、安全等基础设施多方面任务,已经无法有效率地由 CPU 承载,而将这一类基础设施任务转移到新的计算单元 DPU 上,这也就意味着,DPU 的设计逻辑需要遵从软件定义思路,它一定是灵活且兼具可编程性的,可以支持不同客户的不同业务和私有协议。

有几个重要的研究报告强有力地证明了,这些基础设施任务的运行可以消耗大量的 CPU 性能。

一项由哈佛大学和谷歌的团队在 2015 年发表的研究报告 Profiling a warehouse-scale computer 称,该研究对谷歌数据中心业务和数以万计的服务器进行了经过三年深度分析,结果显示,跨越不同服务器的应用所产生的属于基础设施类的任务构成了“数据中心税”,消耗了服务器中约 30% 的算力资源。该报告也指出,因为谷歌数据中心服务器数量庞大,若每台服务器资源利用率能提升一点,都会带来巨大的成本效益。

另一项研究是 Meta 数据中心团队 2020 年的分析 Accelerometer: Understanding Acceleration Opportunities for Data Center Overheads at Hyperscale。该团队对运行在 Facebook 计算优化数据中心平台上的微服务进行全面描述,发现执行核心应用程序逻辑只占用 CPU 18% 的时间;剩余时间完全用于非应用程序逻辑核心的一般操作。也就是说,在 Facebook 执行核心应用时,其数据中心里的 CPU 82% 的时间都消耗在基础设施类任务,这个数字是相当惊人的。也正因如此,Facebook 团队态度更加鲜明地表示,“加速此类基础设施的通用模块,可以极大地提高数据中心的性能”。

全球云计算老大亚马逊云 AWS 最早看到数据中心算力的瓶颈和提升空间,因此 AWS 也是最早尝试自研 DPU 芯片的云服务商。AWS 的数据中心体量最为庞大,因此对于算力痛点的体会是最深刻的。其CTO Werner Vogels 就公开表示过,传统架构的数据中心已经优化到了极限。

在传统架构下,大量的资源浪费在算力、网络、存储的运营和调度管理上,这些资源没有为客户提供直接价值。

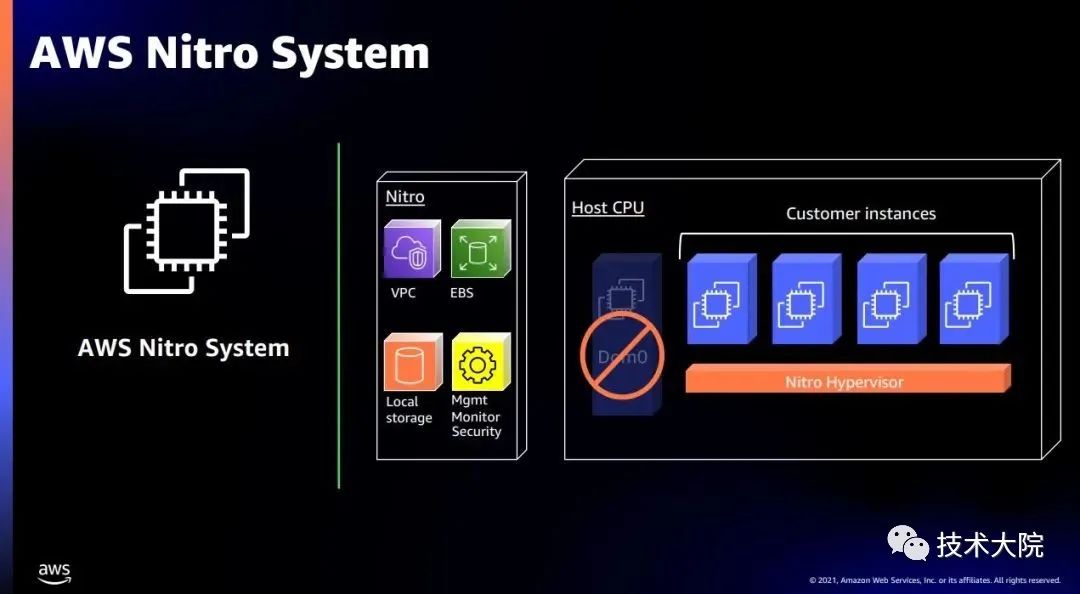

(图|AWS Nitro;来源:AWS)

对此,AWS 的提出的解决方案,就是把大部分虚拟机管理程序迁移到其自研的 DPU —— Nitro 中。

以网络协议处理为例:

要线速处理10G的网络需要的大约4个Xeon CPU的核,也就是说,单是做网络数据 包处理,就可以占去一个8核高端CPU一半的算力。如果考虑40G、100G的高速 网络,性能的 开销就 更 加 难 以 承 受 了。A m a z o n 把这些开销都称 之 为 “Datacenter Tax”,即还未运行业务程序,先接入网络数据就要占去的计算资源。AWS Nitro产品家族旨在将数据中心开销(为虚拟机提供远程资源,加密解密,故障跟踪,安全策略等服务程序)全部从CPU卸载到Nitro加速卡上,将给 上层应用释放30%的原本用于支付“Tax” 的算力!

效果是立竿见影的,Nitro 的应用成功证实了 DPU 的市场价值,管理云服务的程序从原来的 CPU 转移到 DPU 上之后:

CPU 的资源几乎可以完全用来运行客户业务负载,其 DPU 使用上不但灵活还兼具高性能

在成本上,DPU 令宝贵的 CPU 资源被充分利用,AWS 大幅提高了能售卖给云客户的算力资源

对于云客户来说,他们同样买到了更高性价比的算力

通过 DPU 达到其数据中心的算力资源利用率最大化,AWS 迎来了前所未有的最高云服务利润:2022 年第一季度,AWS 业务实现收入 184 亿美元,同比去年增长 36.6%;利润 65.1 亿美金,同比去年增长 57%,利润率 35.3% 达到了历史新高。这些数字的背后,离不开其自研的 DPU 芯片 Nitro。

随着“东数西算”在2022年2月正式启动,进一步加速了全国一体化算力网络国家枢纽节点的建设步伐。在《2021-2022全球计算力指数评估报告》显示,算力指数每提高一个点,数字经济和GDP将分别增长千分之3.3和千分之1.8。算力已经成为了数字经济时代核心生产力。

直观的理解算力网络包含两个关键部分:一是“算力”,二是“网络”。然而,“算力网络”的效力不应该是二者的简单的加和,而应该是“倍乘”,通过网络来对算力进行价值放大,承载更多的应用。缺乏算力的网络只能作为数据的传输网,而缺乏网络的算力的使用价值也将大大降低。

根据著名的梅特卡夫定律,一个网络的价值等于该网络内的节点数的平方。对于算力网络,宏观来看“节点”包括一下两部分:

各种算力中心(如数据中心、超算中心、智算中心、边缘计算节点等等)

服务的终端应用(如PC、智能手机等具有强交互性的设备,也包括摄像头、智能电表等弱交互性设备)

为了便于分析算力相关的核心基础技术,我们把算力划分为两大类:

应用层算力(Application-Domain Computing Power)

用于执行业务层应用的算力,例如视频解析,数据查询,路径规划,图像渲染等,大体对应到全系统分层架构SaaS和PaaS层

基础层算力(Infrastructure-Domain Computing Power)

用来做资源池化,数据转发,压缩存储,加密解密,文件系统,网络功能虚拟化等基础层负载的算力

预计应用算力的提升主要来自于专用服务器的采用,虽然局部来看,应用层算力一方面得益于更高性能CPU、GPU的采用,另一方面得益于计算从通用走向专用的过程中各种FPGA和ASIC的XPU的引入。虽然引入了大量专用计算单元,但宏观来看,得益于CPU的核心地位,仍然可以维持算力的通用性。

基础算力层的核心功能之一是构建算力流通的“管道”,在传统系统架构中,网络与计算是分离,计算的主体是服务器,网络的主体是网卡、路由器和交换机。

随着DPU技术的逐渐成熟,我们看到大量原本在服务器上运行的基础层负载可以被卸载到与服务器CPU直连的DPU上,保持网络特性的功能不再由服务器端的CPU来维护。DPU的存在,将本地物理资源虚拟化,也将远层访问本地化。

DPU开始承载基础算力的角色,并且是在不改变现有路由器和交换机的前提下。DPU的出现也使得网内计算(In-Network Computing)的成熟度得到进一步提升。

DPU的战鼓早已敲响,未来五年,中国DPU市场规模或超千亿。作为数据中心的“叱咤红人”,DPU势必会是各个巨头和初创公司的必争之地。自研、并购、融资各家公司拿出看家本领来抢占市场先机。

云厂商、芯片大厂、初创公司……谁执牛耳?

如果不解决数据中心资源利用率低下造成的算力供需矛盾,未来还会有更多的算力需求无法匹配上供给。罗兰·贝格 Roland Berger 公司就预测,从 2018 年到 2030 年,无人驾驶算力需求增加 390 倍,数字货币算力需求增加约 2000 倍,VR 游戏算力需求增加约 300 倍。有能力解决这个问题的 DPU 创企,一旦抓住时代机遇便可快速发展。

特别是国内数据中心产业正处于高速发展期,本身就为 DPU 的应用提供了很好的土壤。再加上国内从政府到社会层面意识到芯片产业具有经济性和战略性双重属性,对国产芯片提供前所未有的扶持,以及像东数西算这样的大工程提供了国产 DPU 充分的商用场景,必定可以培育出有世界竞争力的 DPU 芯片公司,做出一款世界级芯片。

越是高端的芯片产品,准入门槛就越高,“赢家独赢”的特点也越明显,即资本、人才、客户等行业资源会不断地集中到头部企业。

一家头部芯片企业的市占率,可能比几家非头部企业的市占率总和还要高很多倍。非头部芯片企业的生存空间会非常小,其投资者的风险也特别大。

虽然 DPU 市场目前仍是一片蓝海,但也会不可避免地走向赢家通吃的局面。

-----END-----

看更多精彩内容

「汽车电子」

自动驾驶的必经之路

自动驾驶中视觉处理技术革命

中国车规级芯片企业版图

自动驾驶的陷阱

「AI 」

AI 计算的下半场

畸形的深度学习,把自己逼进死胡同

研究表明,有影响力的数据集正在垄断机器学习研究

科学家纷纷回归学术界,AI拉开下半场大幕

「芯片」

半导体行业大地震

AI 芯片创业进入决赛圈

国产GPU创业潮:难言奇迹

AI芯片,撑得过明年吗?

寒冬里的寒武纪

AI大算力时代:存算一体迎来爆发时刻?