英伟达发布率先采用直接芯片冷却技术的数据中心PCIe GPU。

英伟达在“Computex 2022”活动中宣布,它将推出其A100显卡的液冷版本,其功耗将比风冷版本低30%。

数据中心服务商Equinix 正在验证 A10080GB PCIe 液冷 GPU 在其数据中心的应用,GPU 现已进入试用阶段,预计将于今年夏季正式发布。

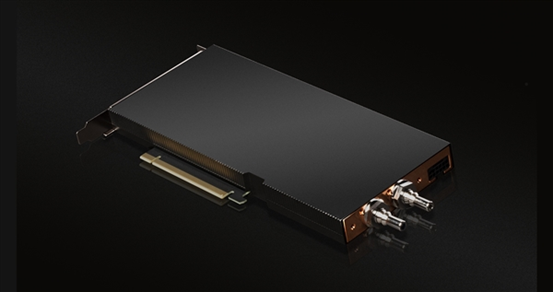

水冷散热的 PCIe GPU

水冷散热的 PCIe GPU英伟达宣布,Ampere架构的计算卡A100、桌面超算HGX A100,Hopper架构的计算卡H100、桌面超算HGXH100,将在该系列中首次引入液冷散热,从而提高散热效率、降低能耗、节省空间和成本。

英伟达表示,它们都采用了直接芯片(Direct-to-Chip)冷却技术。

HGX A100、HGXH100系统采用的都是SXM样式计算卡,在机架内直接整合液冷散热系统,取代传统的系统风冷散热,体积更加紧凑。

A100 PCIe(80GB)、H100 PCIe独立计算卡则有些类似桌面液冷显卡,整合水冷头,不过接口放置在尾部,以便对接液冷系统。

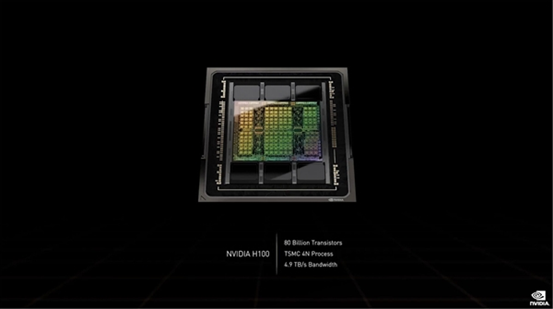

英伟达 GH100核心采用台积电4nm工艺制造、CoWoS 2.5D晶圆级封装,集成800亿个晶体管、18432个CUDA核心、576个Tensor核心、60MB二级缓存,可搭配6144-bit HBM2e/HBM3高带宽内存。

H100计算卡支持SXM、PCIe 5.0两种形态,其中后者功耗高达史无前例的700W,相比A100多了整整300W。

SXM5版本只开启15872个CUDA核心、528个Tensor核心、50MB二级缓存。

PCIe 5.0版本则只有14952个CUDA核心、456个Tensor核心。

英伟达表示相比较传统 CPU HPC 系统,目前采用风冷设计的 GPU 异构加速 HPC 系统能源效率提升了 20 倍。若将全球 AI 与 HPC 系统的纯 CPU 架构系统转换为 GPU 加速系统,一年足以省下 10 兆瓦特小时电力、足以提供 140 万个家庭一年的用电量。

而致力于碳中和的合作伙伴 Equinix 正在部署采用水冷架构的 GPU 加速卡,相较原本的风冷系统架构,在相同工作负载可省下 30% 能源,相较当前气冷技术资料中心的1.6 PEU (最佳化电源使用效率)值,液冷系统可进一步达到 1.15 PUE 值,更趋近环境永续追求的 1.0PUE 值;同时液冷散热架构仅需使用单插槽,对比双插槽的风冷设计能够提升一倍的单位空间运算力。

数据中心服务商Equinix 正在验证 A10080GB PCIe 液冷 GPU 在其数据中心的应用,GPU 现已进入试用阶段,预计将于今年夏季正式发布。

H100 技术突破

H100 技术突破

英伟达表示,H100是第一个支持PCIeGen5的GPU,也是第一个利用HBM3的GPU,可实现3TB /s的内存带宽。20 个 H100GPU 可以维持相当于整个全球的互联网流量,使客户能够提供先进的推荐系统和大型语言模型,实时运行数据推理。

多实例 GPU (MIG)允许将单个 GPU 划分为七个较小的、完全隔离的实例,以处理不同类型的作业。Hopper 架构通过在每个 GPU 实例的云环境中提供安全的多租户配置,将 MIG 功能比上一代产品扩展了多达7 倍。

此外H100是世界上第一个具有机密计算功能的加速器,可在处理AI模型和客户数据时保护它们。客户还可以将机密计算应用于隐私敏感型行业(如医疗保健和金融服务)以及共享云基础架构的联邦学习。

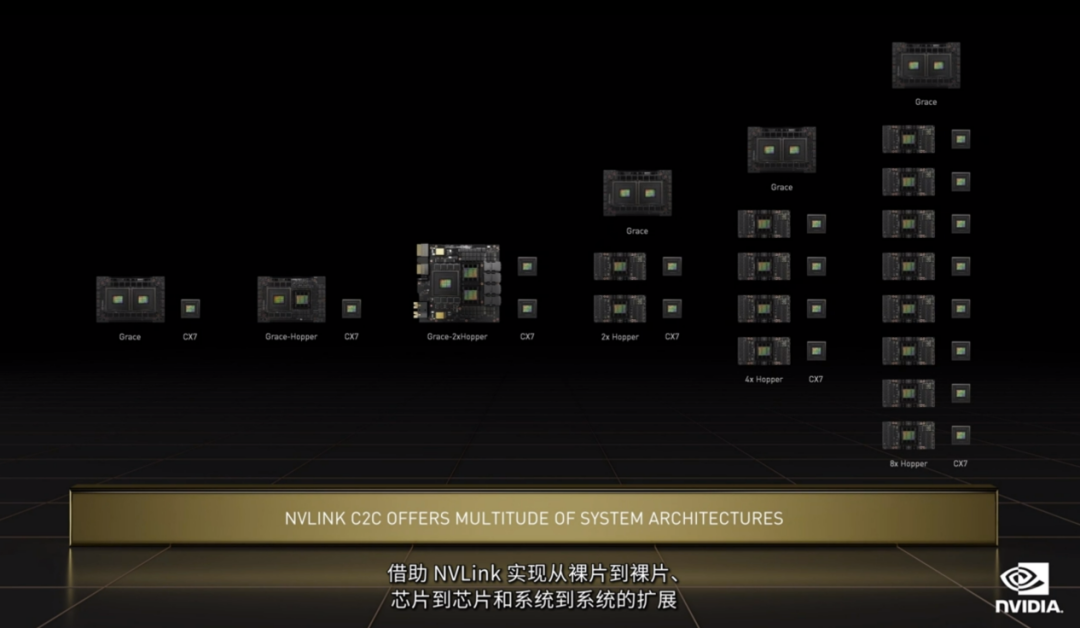

第四代英伟达 NVLink 与新的外部NVLink交换机相结合,将 NVLink 扩展为服务器之外的纵向扩展网络,与使用英伟达 HDR Quantum InfiniBand 的上一代产品相比,可连接多达 256 个 H100GPU,带宽高出 9 倍。

英伟达表示,Hopper已获得领先的云服务提供商阿里云,亚马逊网络服务(AWS),百度AI云,谷歌云,微软Azure,Oracle云和腾讯云的广泛行业支持,这些提供商计划提供基于H100的实例。

预计全球领先的系统制造商将推出各种带有H100加速器的服务器,包括Atos,BOXX Technologies,Cisco,DellTechnologies,Fujitsu,Gigabyte,H3C,HewlettPackard Enterprise,Inspur,Lenovo,Nettrix和Supermicro。

英伟达还透露,中国台湾领先的计算机制造商将发布第一波由英伟达 Grace CPU Superchip和Grace Hopper Superchip提供支持的系统,用于涵盖数字孪生,AI,高性能计算,云图形和游戏的广泛工作负载。

华硕、富士康工业互联网(FII)、技嘉、QCT、Supermicro和Wiwynn的数十款服务器型号预计将于2023年上半年开始。英伟达表示,Grace驱动的系统将加入x86和其他基于Arm的服务器,为客户提供广泛的选择,以实现其数据中心的高性能和高效率。

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系后台。