本文由半导体产业纵横编译自EETimes

随着人们对人工智能和内存计算的兴趣显著增加,电阻式随机存取存储器(ReRAM)可能是解锁其模仿人脑能力的关键。去年的IEDM汇集了许多最近的研究论文,这些论文涉及推进各种记忆类型,包括新兴和现有记忆类型。毫不奇怪,其中很大一部分致力于内存如何改善内存计算,人工智能和机器学习。

ReRAM一直是神经计算的代名词。ReRAM提供了高密度的非易失性存储和高效内存计算的潜力,而支持ReRAM的加速器可以解决冯·诺依曼瓶颈。

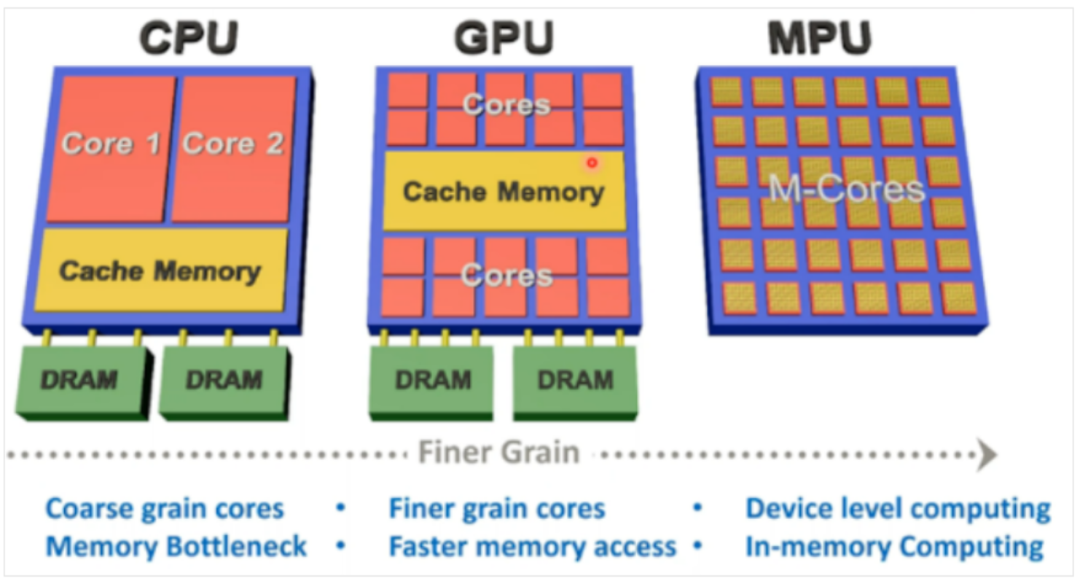

利用并行性的CPU会遇到内存瓶颈。虽然GPU可以更快访问内存,但人们需要一种新的计算架构,从根本上提高吞吐量和计算效率。内存保护单元(MPU)可以显著提高并行度,并将内存与逻辑放在一起,从而允许设备更好促进内存计算。

MPU可以显著提高并行度并将内存与逻辑放在一起,从而进行更快的内存计算。来源:密歇根大学

ReRAM在内存计算方面的潜力在于使用其作为计算结构,因为它可以本机执行学习和推理功能。ReRAM还支持双向数据流,而更大的神经网络可以使用具有平铺MPU架构的模块化系统来实现更高的吞吐量。

ReRAM应对重构挑战

ReRAM应对重构挑战

然而,ReRAM器件存在几个关键挑战。首先,基于高精度模数转换器的读出电路带来了重大挑战,而性能可能会受到器件非理想性的影响。再一个挑战是在ReRRAM器件中观察到的非线性和非对称电导更新会严重降低训练精度。

第一个问题的潜在解决方案包括多范围量化和二进制神经网络。具有架构意识的培训可以解决由设备非理想性引起的性能问题,以及使用2T2R架构实现二进制权重,这也有助于应对第二个挑战。混合精度训练通过以较低精度格式训练大型神经网络来提供显著的性能和计算提升。

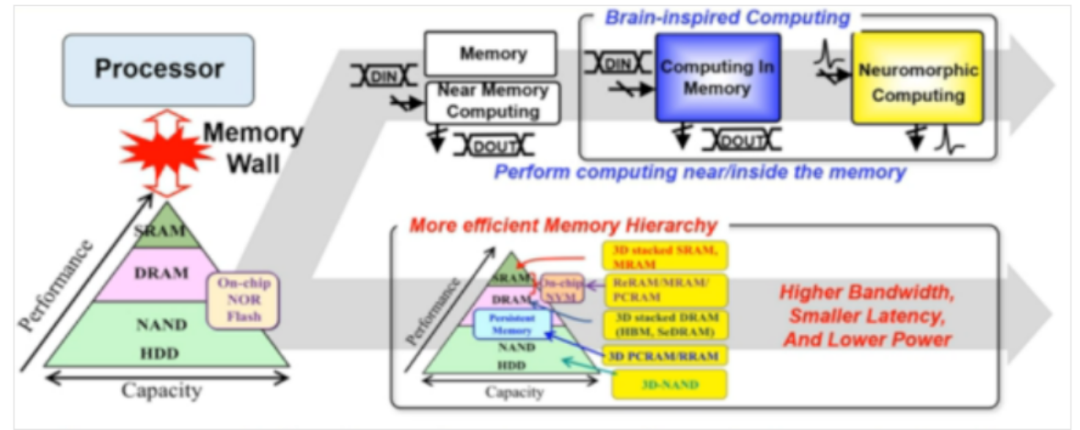

相变存储器(PCM)也是改进内存计算的候选者。IBM 欧洲研究院一直在探索使用 PCM 来解决模拟内存计算的温度敏感性问题。人工智能神经网络的蓬勃发展伴随计算效率问题。深度学习是计算密集型的,如果正在进行的"人工智能革命"是可持续的,那么拥抱颠覆性的计算机范式至关重要。

语言模型的规模呈指数级增长,涉及将大量数据从内存传输到处理统一体,这一行为非常昂贵,也不环保。模拟内存计算通过在内存本身内执行某些计算任务来模糊内存和处理之间的界限,并通过利用内存设备的物理属性来实现。PCM是内存计算的发展之一,因为它可以以非常密集的方式存储信息,并且消耗的静态功率可以忽略不计。

让计算模仿人类的大脑

让计算模仿人类的大脑另一个超越内存计算的热门研究领域是创建更符合人脑的神经网络。中国科学院微电子研究所和复旦大学的许多研究人员提出基于ReRAM的大脑启发计算(BIC),正在以前所未有的速度推动,大概每三个月翻一番。

BIC将在中长期内规避冯·诺依曼瓶颈。来源:中国科学院微电子研究所

人工智能计算的使用越来越多,使得大脑启发的硬件对于维持发展至关重要。虽然新的内存技术可以在短期内增强现有的层次结构,但BIC将在中长期内规避冯·诺依曼瓶颈。ReRAM为BIC提供了一个理想的平台,因为它具有丰富的开关动态,可以支持大规模集成,低功耗外围设备和特定于应用的架构,以构建BIC芯片和系统。

ReRAM的特性也使其成为AI的热门,其目标是模仿人脑。

英特尔在IEDM 活动发表了大量论文,涵盖了扩展的改进以及为芯片带来新功能。英特尔概述了围绕混合绑定互连的设计、工艺和组装挑战所做的努力,提出了将封装互连密度提高 10 倍以上的愿景。在此之前,英特尔在7月份宣布推出 Foveros Direct,该功能可实现低于10微米的凸起间距,从而为3D堆叠提供数量级的互连密度。

*声明:本文系原作者创作。文章内容系其个人观点,我方转载仅为分享与讨论,不代表我方赞成或认同,如有异议,请联系后台。