GTC 2022开发者大会上,NVIDIA放出两倍重磅炸弹,一个是全新CPU,一个是全新GPU。

【Hopper CPU】

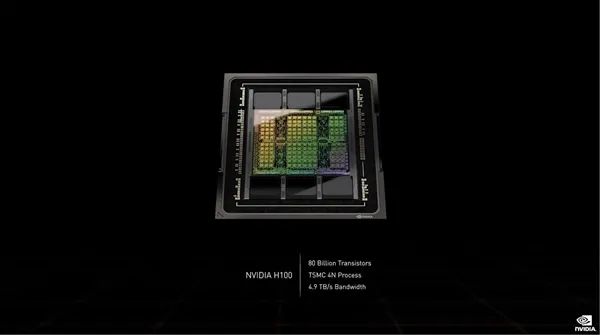

黄仁勋终于公布了NVIDIA新一代架构与核心,面向HPC高性能计算、AI人工智能的“Hopper”,核心编号“GH100”。

GH100核心采用的是台积电目前最先进的4nm工艺,而且是定制版,CoWoS 2.5D晶圆级封装,单芯片设计,集成多达800亿个晶体管,号称世界上最先进的芯片。

完整版有8组GPC(图形处理器集群)、72组TPC(纹理处理器集群)、144组SM(流式多处理器单元),而每组SM有128个FP32 CUDA核心,总计18432个。

显存支持六颗HBM3或者HBM2e,控制器是12组512-bit,总计位宽6144-bit。

Tensor张量核心来到第四代,共有576个,另有60MB二级缓存。

扩展互连支持PCIe 5.0、NVLink第四代,后者带宽提升至900GB/s,七倍于PCIe 5.0,相比A100也多了一半。整卡对外总带宽4.9TB/s。

性能方面,FP64/FP32 60TFlops(每秒60万亿次),FP16 2000TFlops(每秒2000万亿次),TF32 1000TFlops(每秒1000万亿次),都三倍于A100,FP8 4000TFlops(每秒4000万亿次),六倍于A100。

当然,大家不要期待H100的游戏性能了,因为NVIDIA这次一刀砍到底,阉割得非常厉害。

从NVIDIA的白皮书中可以确认,H100砍掉了大量GPU相关功能,不论是PCIe 5.0版还是SMX版的H100核心中,只有2组TPC单元才可以支持图形运算,包括矢量、几何及像素渲染。

2组TPC单元也就是4组SM单元,总计512个CUDA核心是可以跑游戏的,相比完整的1.8万核心来说微不足道,性能只相当于完整版H100核心的1/36,也就3%左右,97%的游戏性能没了。

NVIDIA解释说H100是专为AI、HPC及数据分析而生的,并不是为了游戏而设计的。

考虑到H100在AI、HPC等性能上的提升,NVIDIA阉割大量游戏功能以便减少设计难度也是可以理解的,毕竟加速卡也不会用来玩游戏。

针对游戏玩家的是Ada Lovelace架构,此前爆料也是最多18432个流处理器,但是它会大量阉割计算单元,保留完整的图形及光追单元,跟H100的设计理念反过来。

H100计算卡采用SXM、PCIe 5.0两种形态,其中后者功耗高达史无前例的700W,相比A100多了整整300W。

按惯例也不是满血,GPC虽然还是8组,但是SXM5版本只开启了62组TPC(魅族GPC屏蔽一组TPC)、128组SM,总计有15872个CUDA核心、528个Tensor核心、50MB二级缓存。

PCIe 5.0版本更是只有57组TPC,SM虽然还是128组,但是CUDA核心只有14952个,Tensor核心只有456个。

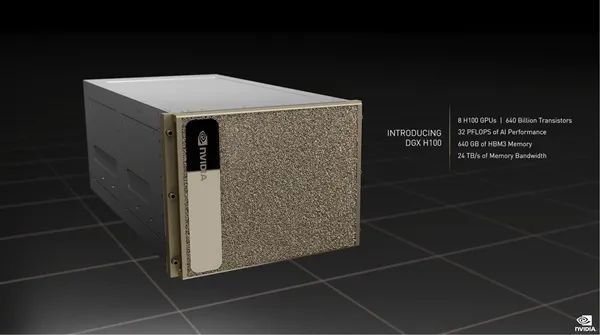

DGX H100系统集成八颗H100芯片、搭配两颗PCIe 5.0 CPU处理器(Intel Sapphire Rapids四代可扩展至器?),拥有总计6400亿个晶体管、640GB HBM3显存、24TB/s显存带宽。

性能方面,AI算力32PFlops(每秒3.2亿亿次),浮点算力FP64 480TFlops(每秒480万亿次),FP16 1.6PFlops(每秒1.6千万亿次),FP8 3.2PFlops(每秒3.2千亿次),分别是上代DGX A100的3倍、3倍、6倍,而且新增支持网络内计算,性能3.6TFlops。

DGX H100是最小的计算单元,为了扩展,这一次NVIDIA还设计了全新的VNLink Swtich互连系统,可以连接最多32个节点,也就是256颗H100芯片,称之为“DGX POD”。

这么一套系统内,还有20.5TB HBM3内存,总带宽768TB/s,AI性能高达颠覆性的1EFlops(100亿亿亿次每秒),实现百亿亿次计算。

系统合作伙伴包括Atos、思科、戴尔、富士通、技嘉、新华三、慧与、浪潮、联想、宁畅、超威。

云服务合作伙伴包括阿里云、亚马逊云、百度云、Google云、微软Azure、甲骨文云、腾讯云。

【Grace GPU】

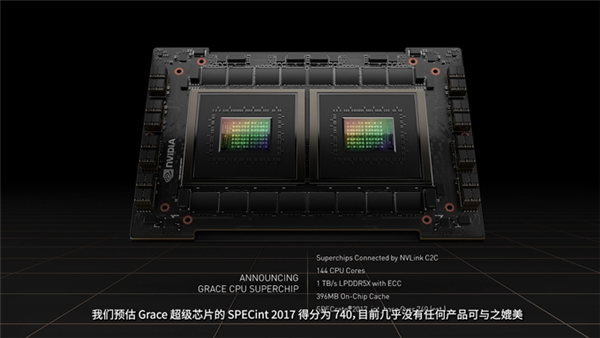

NVIDIA Grace CPU处理器专为AI及超算设计,官方表示性能上根本没有对手。

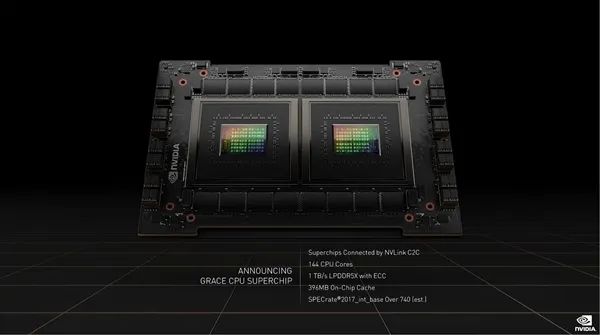

NVIDIA去年其实就发布了Grace,不过当时没有详细规格,现在公布的这叫做

“Grace CPU Superchip”,将两颗Grace整合在一块卡上。

规格自然是相当恐怖的,总计144个CPU内核(基于ARMv9指令集),缓存容量396MB,支持LPDDR5X ECC内存,带宽高达1TB/s,整体功耗仅为500W。

其他方面还有PCIe 5.0、NVLink-C2C互连。

性能方面,Grace CPU Superchip的SPECint 2017得分为740分,NVIDIA表示这个性能没有什么产品可与之媲美,无敌了。

有了Grace CPU Superchip,NVIDIA可以灵活搭配各种方案,就像是搭积木那样简单。

Grace CPU Superchip芯片会在2023年上市。

【Grace+Hopper】

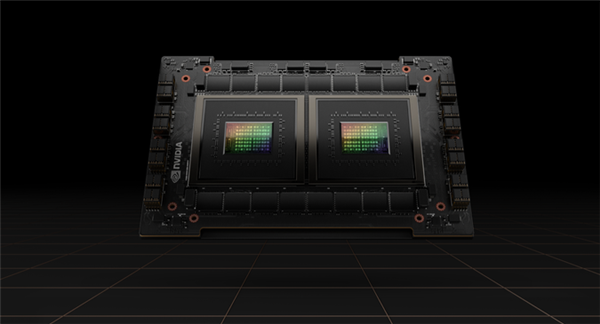

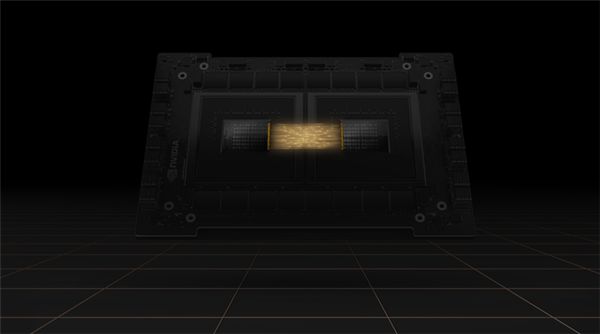

有了Hopper H100 GPU核心、Grace CPU处理器,NVIDIA还丧心病狂地把二者放在了一张卡上,命名为“Grace Hopper”,官方称之为密度最高达到加速计算系统。

两颗芯片并排放置,彼此之间通过NVLink总线进行芯片间通信,带宽达900GB/s。

具体规格暂未公布,但应该做不到同时满血,尤其是Hopper GPU。

Grace CPU基于ARMv9架构指令集设计,72个核心,集成198MB缓存,搭档LPDDR5X内存,支持ECC。

Hopper GH100 GPU 18432个CUDA核心、576个Tensor核心、60MB二级缓存、6144-bit HBM2e/HBM3显存位宽。

H100计算卡则只开启了16896个CUDA核心、528个Tensor核心、50MB二级缓存、5120-bit HBM3显存位宽,Grace Hopper卡上大概率也是这个规格。

这种合体“怪物”有啥用?显然也是做HPC、AI计算,CPU、GPU可以协调分配不同负载,达到效率最大化。

另外还有“H100 CNX”,同时集成H100 GPU、CX-7 SmartNIC网络芯片。

通过让GPU直连网络消除系统带宽,支持PCIe 5.0,最高支持7个多GPU实例并发。

另外,NVIDIA今天发布的CPU及GPU是首发支持PCIe 5.0,然而PCIe 5.0的性能已经满足不了NVIDIA的需要了,专门打造了NVLink-C2C技术,支持多种裸芯互连,包括CPU、GPU、DPU、NIC及SoC等等。

NVLink-C2C实现了高达900GB/s的连接带宽,能效更是PCIe 5.0的25倍,面积效率则是后者的90倍,可以说性能碾压的情况下功耗更低,占用的面积更小。

NVLink-C2C技术还支持ARM的ARBA集线器接口协议,NVIDIA现在跟ARM一起合作以增强AMBA协议,以便支持与其他互连芯片一致且安全的加速器连接。

除了NVLink-C2C之外,NVIDIA还支持前不久Intel、AMD等公司联合推出的UCIe芯片封装标准,虽然之前的名单中没有NVIDIA,但是现在看来他们不打算跟业界主流标准隔离开来,客户定制的NVIDIA芯片可以选择使用UCIe或者NVLink-C2C,后者在性能、延迟及能效上做了优化。

【牵手比亚迪】

意外的是,大会期间,比亚迪、NVIDIA宣布在智能驾驶技术方面达成合作。

从2023年上半年起,比亚迪将在其部分新能源汽车上搭载英伟达DRIVE Hyperion平台,实现车辆智能驾驶和智能泊车。

比亚迪是电动汽车行业的领导者,NVIDIA是人工智能领域的先行者。本次合作,双方强强联合、优势互补,将共同推动新能源汽车产业朝着智能化、信息化方面深度发展。

英伟达DRIVE Orin是全球性能最高的车规级芯片,是下一代汽车人工智能的“大脑”。NVIDIA表示,未来六年其汽车业务方面的营收约为110亿美元。

DRIVE Orin芯片算力可达254TOPS,每秒可计算254万亿次,具备高速外围接口和高内存带宽(205GB/秒),可无缝处理来自多个传感器配置的数据,以实现安全可靠的智能驾驶。

NVIDIA DRIVE Orin芯片符合 ISO 26262 ASIL-D等系统化安全标准,保证智能驾驶的安全性和先进性。

同时,NVIDIA还公布了基于Atlan芯片的新一代汽车自动驾驶技术平台“Drive Hyperion 9”,并计划于2026年量产。

相比于上一代,Hyperion 9支持感知硬件数量大幅度提升。它的架构包括:车辆外部的14个摄像头、9个雷达、3个激光雷达传感器和20个超声波传感器,以及车辆内部的3个摄像头和一个雷达。

据悉,Hyperion 9将采用Atlan芯片,在算力方面Atlan提升3倍左右,预计于2025年交付。

英伟达表示,比亚迪正基于Hyperion 9打造其下一代电动汽车。

NVIDIA汽车业务副总裁Rishi Dhall表示:“汽车行业转型的驱动力包括电动化以及由软件定义技术赋予设备的自主性。在人工智能技术和NVIDIA DRIVE平台的赋能下,比亚迪提供的电动汽车将由软件定义,在保证安全可靠的同时,也能随着时代的推进而不断革新。”

比亚迪如今已经成为中国新能源汽车领军品牌,2021年实现了新能源乘用车近60万的全球销量,第九次问鼎中国新能源乘用车销冠;新能源累计产销超过150万台。

除了比亚迪,在这次大会上,与NVIDIA达成合作的企业还有Lucid、文远知行、元戎启行、云骥智行、Outrider和悠跑科技。