嵌入式AI

原文:

https://www.jiqizhixin.com/articles/2022-03-10-6

最先进的人工智能技术,并不总意味着数块 GPU、每秒算力上 E 的超算。

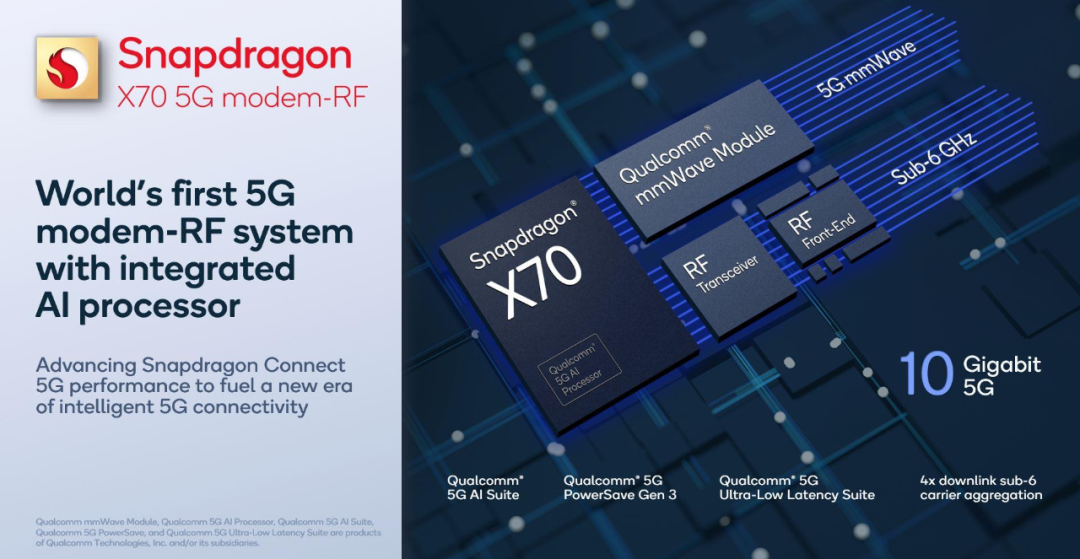

应用最广泛的移动芯片上,人们正在使用最先进的 AI 技术。最近,高通再次利用 AI 实现了「突破性的 5G 效能」。

在巴塞罗那举办的 MWC 2022 国际通信展上,高通 CEO 安蒙(Cristiano Amon)发布了全球首款搭载 AI 计算核心的 5G 通信基带骁龙 X70。

原文:

https://www.sohu.com/a/524383537_129720

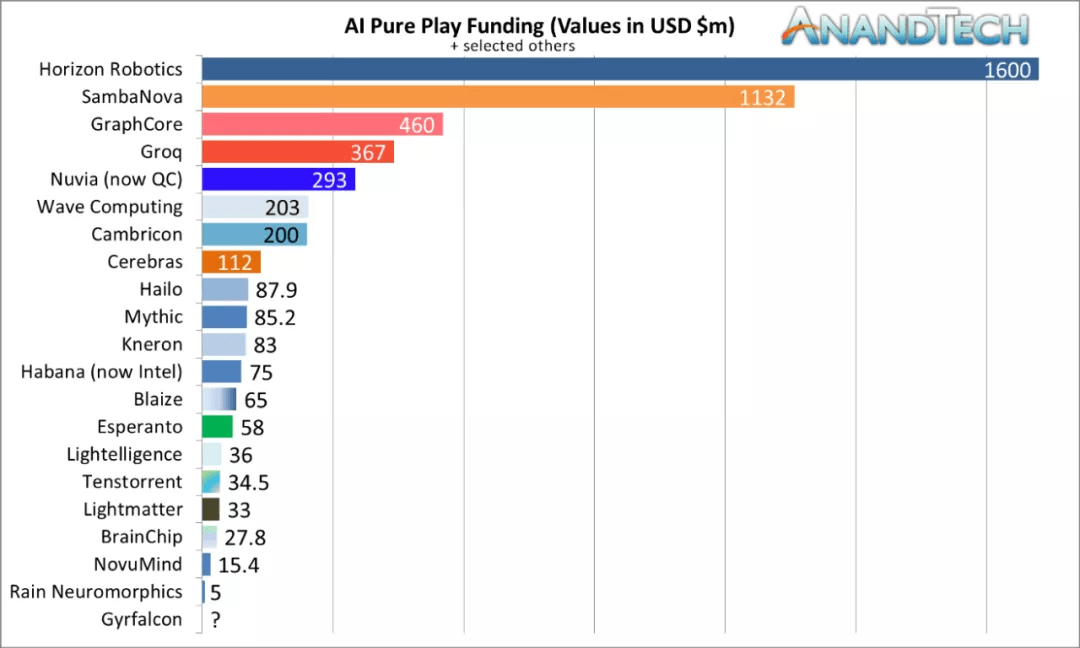

这是本系列博客的第四篇,主要介绍了 AI 加速器相关公司。全球科技行业最热门的领域之一是 AI 硬件, 本文回顾了 AI 硬件行业现状,并概述相关公司在寻找解决 AI 硬件加速问题的最佳方法时所做的不同赌注。

对于许多 AI 硬件公司来说,最近几年似乎是 AI 硬件发展的黄金时代;过去三年英伟达股价暴涨约 + 500%,超越英特尔成为全球市值最高的芯片公司。其他创业公司似乎同样火爆,在过去几年中,他们已花费数十亿美元资助 AI 硬件初创公司,以挑战英伟达的 AI 领导地位。

原文:

https://www.jiqizhixin.com/articles/2022-03-17-10

英特尔有两个目标:让 AI 算力无处不在,同时通过构建开源工具,构建更加活跃的机器学习社区。

3 月 15 日,在采访活动中,英特尔院士,大数据技术全球 CTO 戴金权和英特尔首席工程师、人工智能技术中国首席架构师夏磊向我们分享了该公司在开源社区最近的进展。

英特尔 AI 实践日是英特尔诸多开源活动的重要一环,它涵盖边缘到云端、至强平台到 Movidius VPU 的一系列人工智能实践学习课程,英特尔的工程师们从实际应用案例中精选经典的设计及优化实例作为蓝本精心制作,并担任导师。它提供全面的培训计划,延伸到学术界、协会与合作伙伴的合作,协助客户理解人工智能,也提高客户产品性能,为开发者和开发者社区带来更多支持,加速 AI 应用落地。

原文:

https://www.jiqizhixin.com/articles/2022-02-18-6

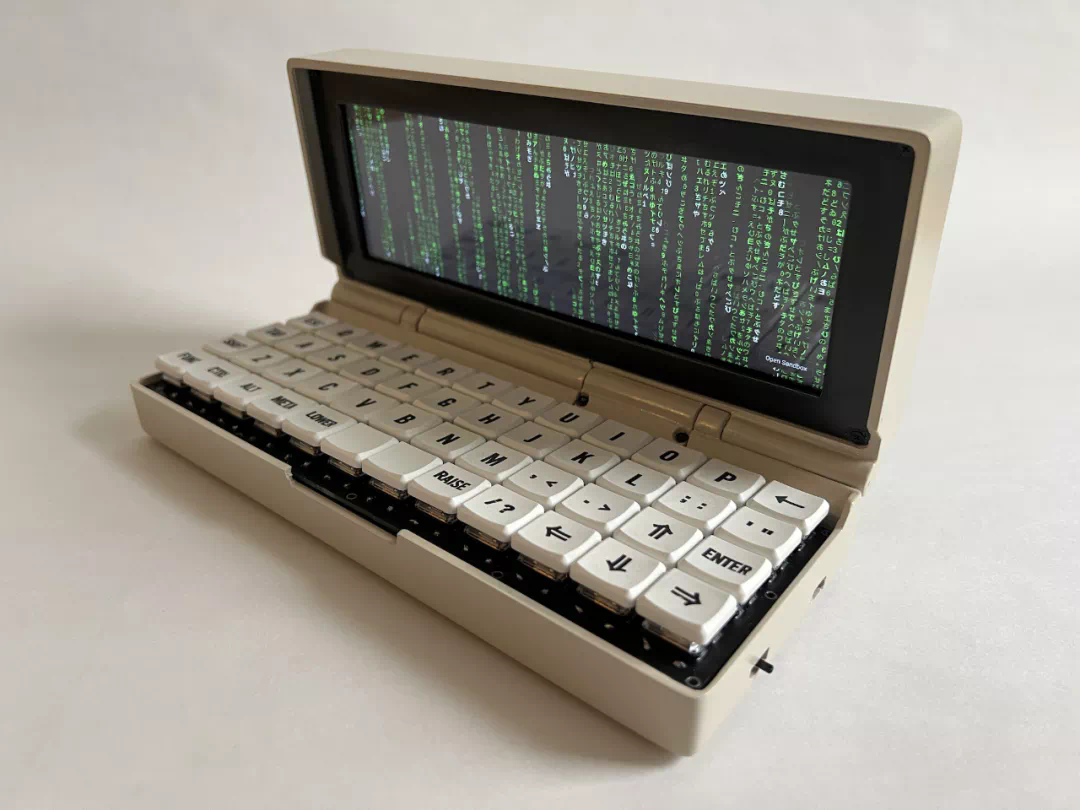

如果现在有人提到掌上电脑,那几乎可以肯定他们所指的是智能手机。但是树莓派发烧友总有办法展示其复古的一面。无需多大的技术改进,加上一些陈旧的控制台部件和真正的机械键盘,你就可以拥有一台可以放在手掌中的 DIY PC。这就是本文将要介绍的 Penkesu 项目所实现的功能。

项目作者是 Penk Chen ,该项目介绍了如何通过 Raspberry Pi Zero 2 W(树莓派 Zero 2 W)打造一台复古风格的掌上电脑,它的分辨率为 400 x 1280 、触摸屏为 7.9 英寸。此外,它还包括其他电子部件:3.7 V Li-Po 电池和用于供电的 Adafruit PowerBoost 1000C。

成品如下图所示,看起来真的很复古。

AI热点

原文:

https://www.jiqizhixin.com/articles/2022-03-14-4

从早期的学术框架 Caffe、Theano,到后来的PyTorch、TensorFlow,自 2012 年深度学习再度成为焦点以来,很多机器学习框架成为研究者和业界工作者的新宠。

2018 年底,谷歌推出了全新的JAX框架,其受欢迎程度也一直在稳步提升。很多研究者对其寄予厚望,希望它可以取代 TensorFlow 等众多深度学习框架。

不过,PyTorch 和 TensorFlow仍是ML框架领域的两大实力玩家,其他新生框架的力量暂时还无法匹敌。而PyTorch 和 TensorFlow之间则是此消彼长的关系,力量对比也在悄悄发生着变化。

原文:

https://www.jiqizhixin.com/articles/2022-03-17-8

你有多久没调过 kernel size 了?虽然常常被人忽略,但只要将其简单加大,就能给人惊喜。

当你在卷积网络(CNN)的深度、宽度、groups、输入分辨率上调参调得不可开交的时候,是否会在不经意间想起,有一个设计维度 kernel size,一直如此显而易见却又总是被忽视,总是被默认设为 3x3 或 5x5?

当你在 Transformer 上调参调得乐不思蜀的时候,是否希望有一种简单、高效、部署容易、下游任务性能又不弱于 Transformer 的模型,带给你朴素的快乐?

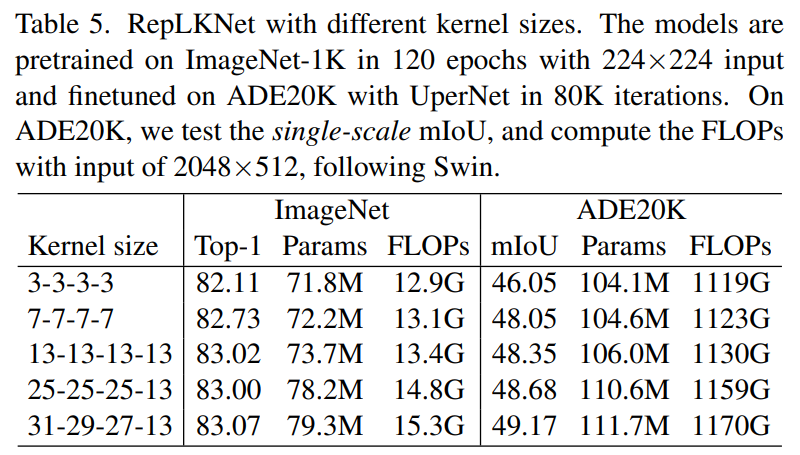

近日,清华大学、旷视科技等机构的研究者发表于 CVPR 2022 的工作表明,CNN 中的 kernel size 是一个非常重要但总是被人忽略的设计维度。在现代模型设计的加持下,卷积核越大越暴力,既涨点又高效,甚至大到 31x31 都非常 work(如下表 5 所示,左边一栏表示模型四个 stage 各自的 kernel size)!

即便在大体量下游任务上,我们提出的超大卷积核模型 RepLKNet 与 Swin 等 Transformer 相比,性能也更好或相当!

论文地址:

https://arxiv.org/abs/2203.06717

MegEngine 代码和模型:

https://github.com/megvii-research/RepLKNet

PyTorch 代码和模型:

https://github.com/DingXiaoH/RepLKNet-pytorch

原文:

https://www.jiqizhixin.com/articles/2022-03-16-3

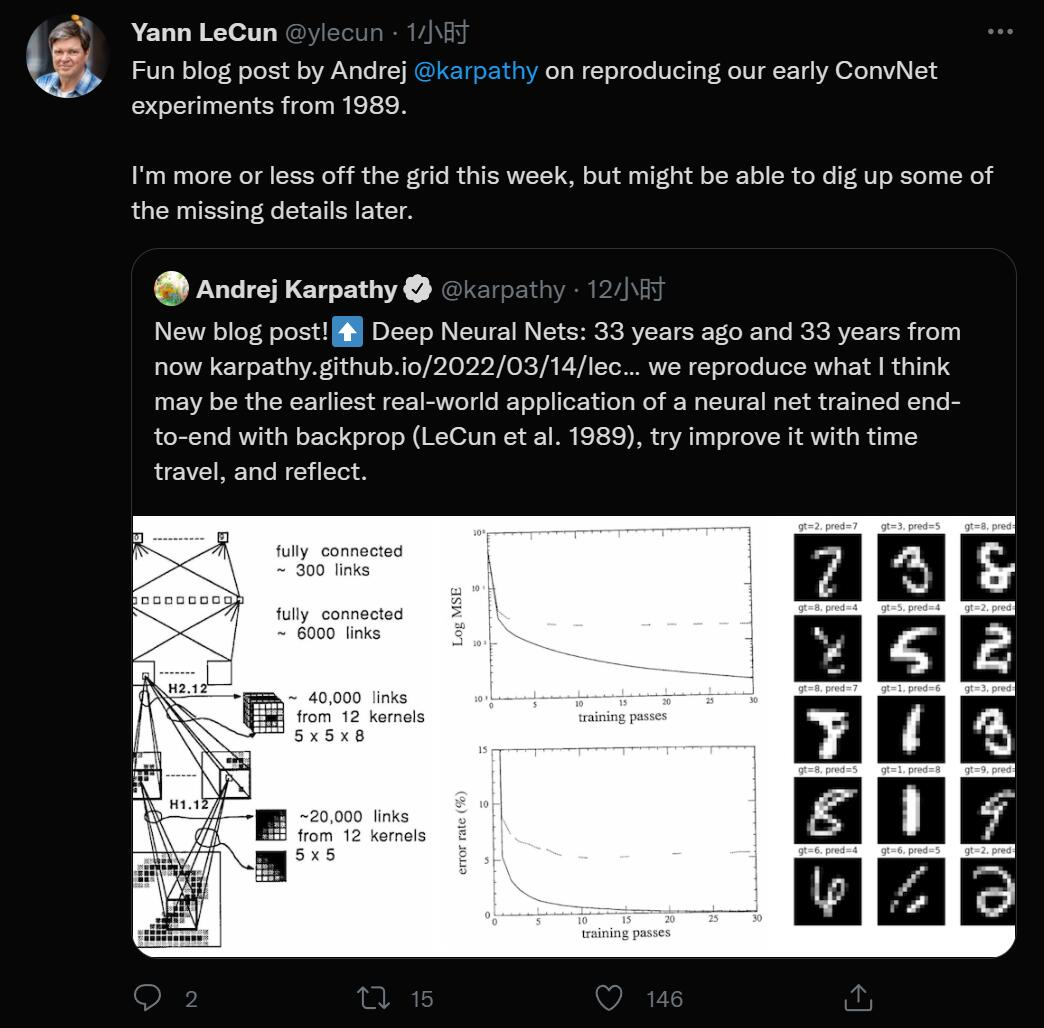

最近,特斯拉 AI 高级总监 Andrej Karpathy 做了一件很有趣的事情,他把 Yann LeCun 等人 1989 年的一篇论文复现了一遍。一是为了好玩,二是为了看看这 33 年间,深度学习领域到底发生了哪些有趣的变化,当年的 LeCun 到底被什么卡了脖子。此外,他还展望了一下 2055 年的人将如何看待今天的深度学习研究。

关注我们

可加微信号 13632716562 报名师资培训!

↓点击阅读原文进入官网

爱我就请给我在看