Mellanox Technologies前不久透露,计划通过新产品Infiniswitch IV将Infiniband技术推上新台阶;紧随其后,QLogic公司也展示了一款适配卡,与Mellanox现有的20Gbps器件一决高低。

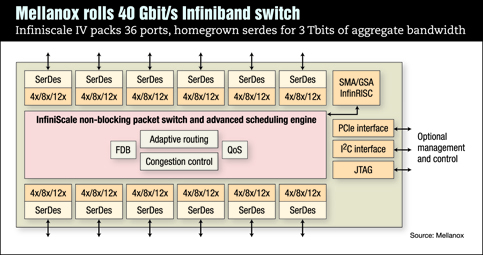

Infiniswitch最多支持36个流量为40Gbps的端口,总吞吐率惊人的达到3Tbps。“我们的芯片带宽能达到整个Foundry Networks以太网交换系统的带宽。我们对其所达到的交换性能感到骄傲。”Mellanox负责产品管理的资深主管Dan Tuchler说。

通过用90nm工艺代替130nm工艺及其它优化措施,Mellanox已将其现有的20Gbps交换机的延迟由140ns缩短到60ns。新器件将于2008年初样产。

此款交换机是Mellanox第一款采用自适应路由技术来降低瓶颈和增大吞吐率的交换机。同时,这也是第一款在Infiniband标准中实现拥塞管理技术的交换机。

IEEE已经有一个委员会开始起草具有类似特性的以太网标准,目的之一就是为了让光纤通道(FC)存储流量能够在以太网上传输。“我们并不希望对Infiniband过于狂热,而且我们也希望我们的产品能与以太网上的光通道(FCoE)顺利运作。”Tuchler表示。这暗示着IEEE新的以太网标准出台后,Mellanox可能会支持它。

市场研究公司The Linley Group的资深分析师 Bob Wheeler认为,Mellanox面临的最大挑战是如何控制功耗。

“迄今为止,Mellanox的产品价格一直都很有竞争力,因此我不认为这款芯片会比首款10G Infiniband交换机贵太多。但我对这种级别的芯片如何进行散热管理很好奇。”Wheeler说,“总的来说,生产出如此具有成本效益的高性能芯片,这说明他们做得非常出色,因此我相信他们的实力。”

在明年初芯片样产之前,Mellanox不会透露该芯片的功耗和定价情况。

期间,QLogic也将量产一些符合20Gbps Infiniband标准的服务器适配卡。他们暗示,与Mellanox所销售的同类产品相比,这些适配卡成本更低、吞吐率更高。

QLogic的适配卡能在一个x16 PCI Express Gen 1 link上提供高达1,920MBps的吞吐率。在较常规的x8 Express link上,吞吐率稍降至1,400Mbps。

QLogic声称,此款适配卡在目前计算机集群上常见的消息传输接口上能处理1,300万条消息。“这很重要,因为随着交换机向每插槽8个内核、每节点16个内核发展,需要处理的短消息量将会剧增。”QLogic负责Infiniband工程技术的一位资深主管Jeff Broughton表示。

QLogic产品的结构将许多协议处理的任务交给主CPU去处理,因为他们相信今天的多核架构具备足够的处理能力。这也帮助将器件的功耗降低到相对低的6w平均水平。而据Broughton介绍,相比而言,Mellanox则在其适配器芯片中专门嵌入了一个处理器来进行协议处理。

Broughton表示,网络向40G Infiniband的转换要到2008年秋才会真正开始,那时符合该规范的所有交换机、适配器和电缆连接产品将会相继出现。他暗示Qlogic会选择在那个时候推出其自己的40G Infiniband产品。

作者:麦利